Windows 365 continue d’évoluer et de s’adapter aux nouveaux usages. Après les éditions Business et Enterprise, Microsoft propose depuis quelque temps déjà Windows 365 Frontline, une déclinaison pensée pour les équipes en rotation ou à temps partiel. Bref, pour tous ceux qui n’ont pas besoin d’un Cloud PC huit heures par jour.

Dans cet article, je vous propose de faire le tour complet de Windows 365 Frontline, avec la création des stratégies dans Intune, le provisioning des Cloud PCs, les comportements de session, et les petits détails qu’on ne découvre qu’en le déployant soi-même.

Avant d’aller plus loin, je vous propose la lecture de plusieurs articles sur ce blog, qui parlent de Windows 365 depuis sa GA en 2021 :

- Premières armes sur Windows 365

- Debugger Windows 365

- Testez facilement Windows 365 en 2023

- Upgradez facilement votre Cloud PC Windows 365

- Bootez sur Windows 365 Cloud PC

- Windows 365 Switch

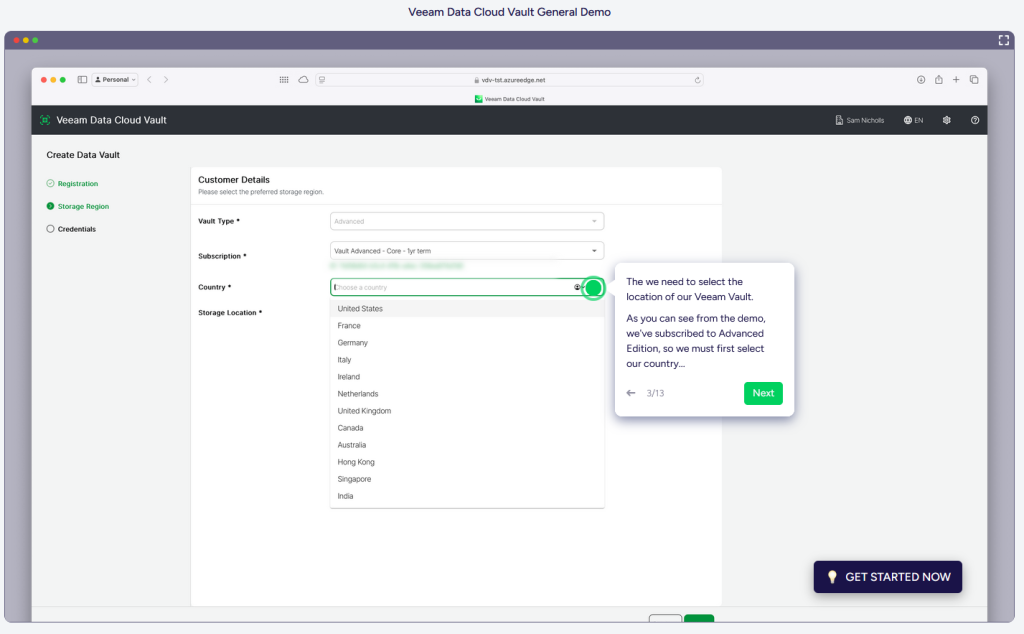

- Migrez votre Windows 365 dans une autre région Azure

- Windows 365 Move v2

- Clonez votre Windows 365

- Windows 365 Cross-region Disaster Recovery (CRDR) !

- Windows 365 – Invités

À quoi sert Windows 365 Frontline ?

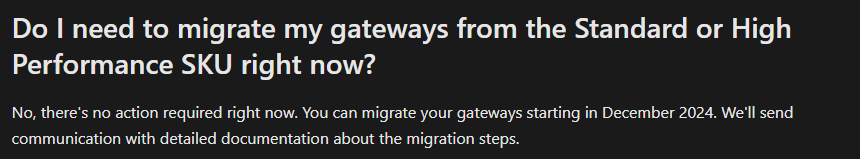

Windows 365 Frontline a été présenté pour la première fois en avril 2023 et est devenu disponible en version publique quelques mois plus tard, à l’été 2023.

Windows 365 Frontline est une déclinaison de Windows 365 pensée pour les travailleurs “de première ligne”. Il s’agit de cibler ceux qui n’utilisent pas un poste de travail huit heures par jour, tous les jours, mais travaillant sur leur poste de manière ponctuelle ou en rotation. C’est donc parfait pour les équipes en postes tournant, les centres de support, les services clients, ou les équipes sur le terrain.

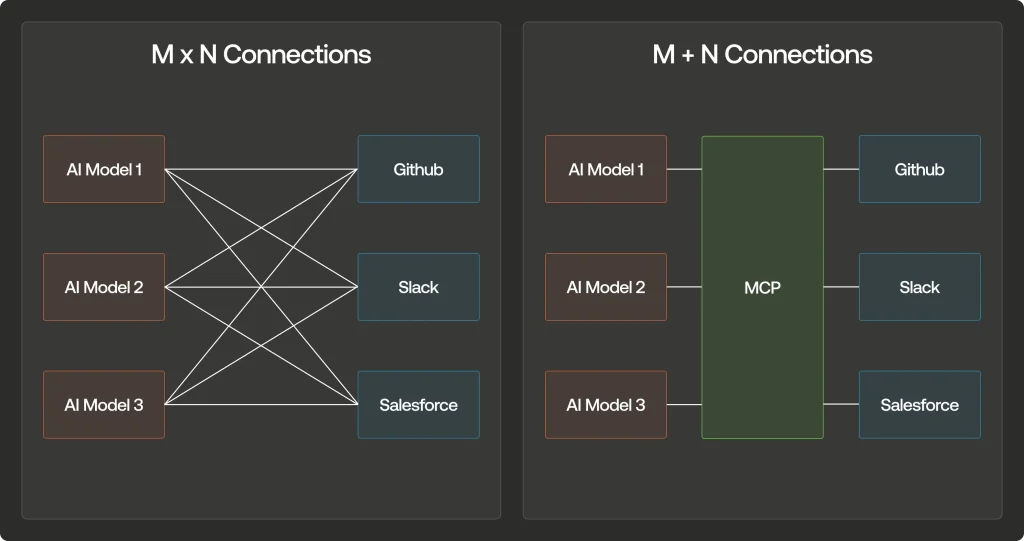

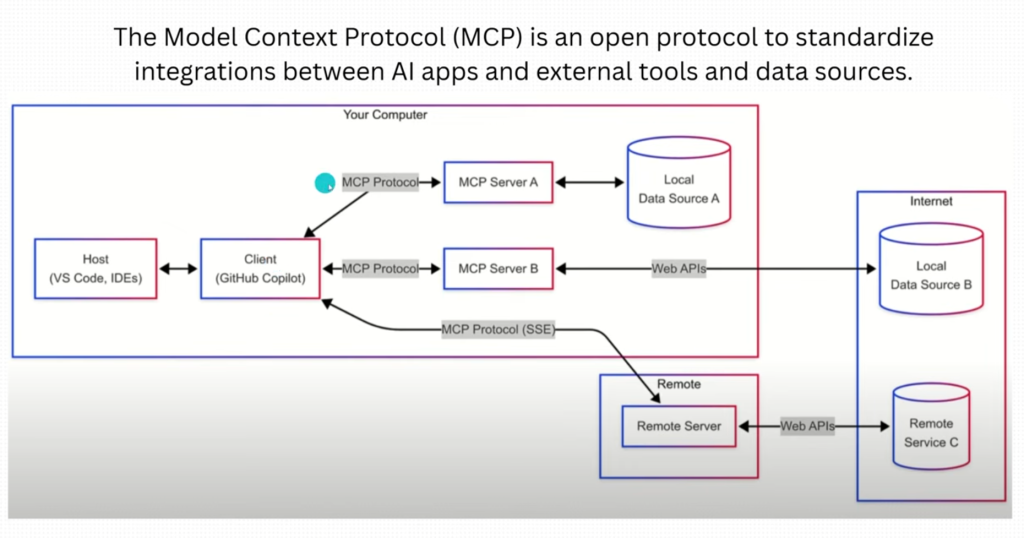

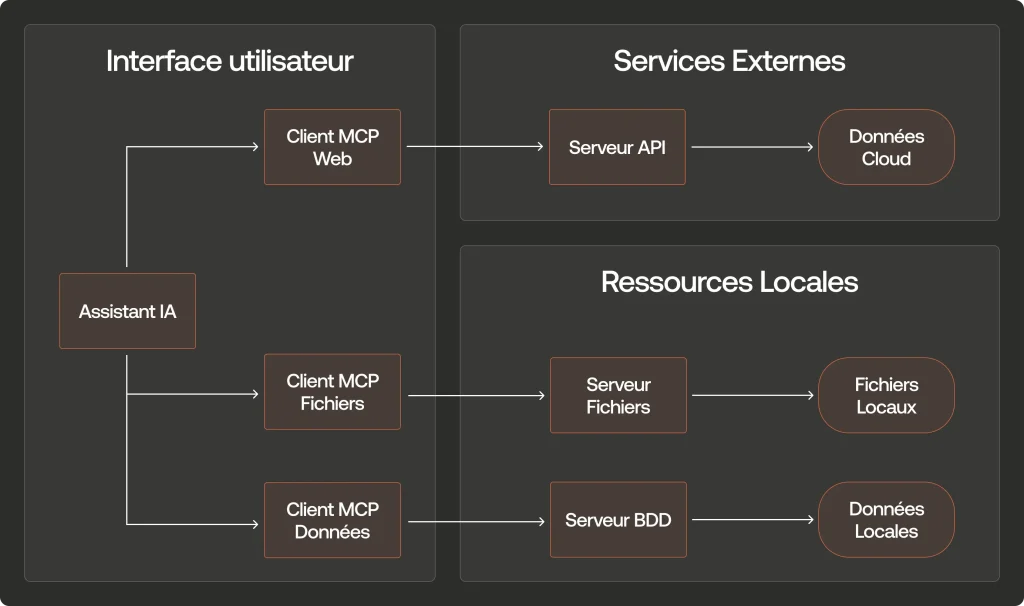

Windows 365 Frontline est une version de Windows 365 qui permet aux organisations de réduire les coûts en leur permettant de provisionner un PC cloud qui peut être utilisé par plusieurs utilisateurs avec une seule licence.

L’objectif principal est et reste de réduire le coût des licences Windows 365 tout en gardant la simplicité et la sécurité du Cloud PC.

Quelles sont les limitations de Windows 365 Frontline ?

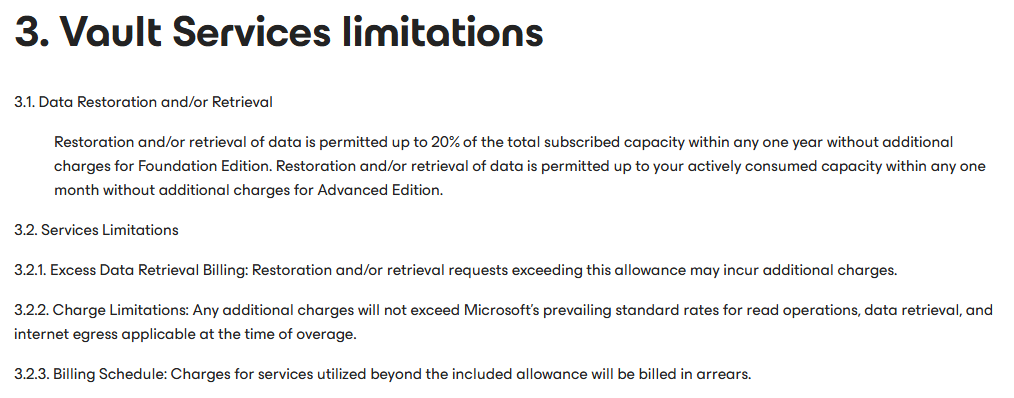

Windows 365 Frontline apporte une vraie flexibilité, mais il faut connaître ses limites techniques et opérationnelles pour bien l’intégrer dans un environnement d’entreprise :

- Un seul utilisateur peut être actif par Cloud PC à la fois : Même si la licence couvre plusieurs utilisateurs, ils ne peuvent pas se connecter simultanément.

- Pas de mise en veille prolongée : lorsqu’un utilisateur se déconnecte, la session est suspendue mais reste comptabilisée tant que la VM est “réservée”.

- Temps de démarrage à prévoir : la mise en service d’un Cloud PC Frontline peut prendre quelques minutes selon la politique de démarrage configurée.

Windows 365 Frontline Dedicated vs Shared ?

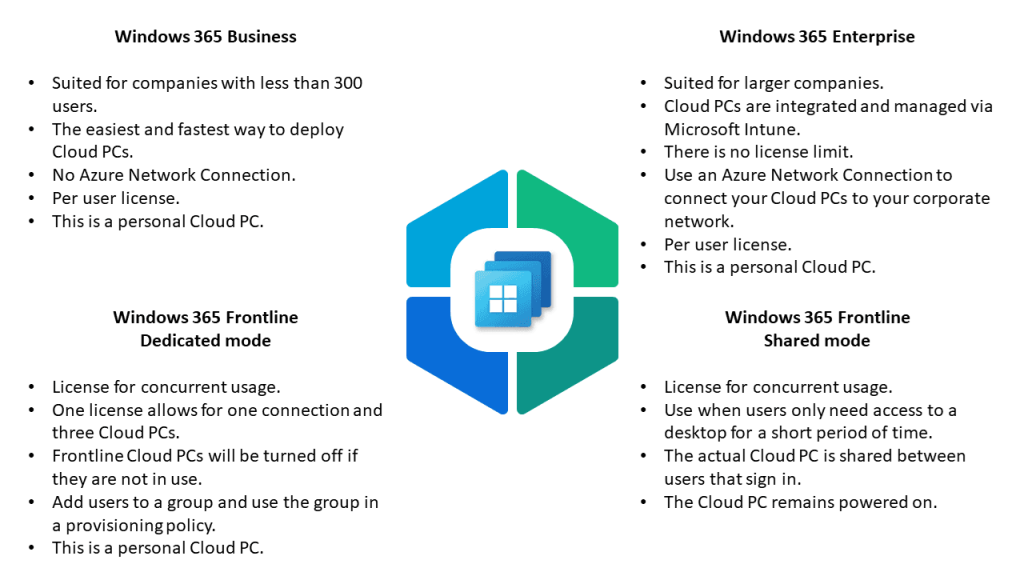

Microsoft propose aujourd’hui deux modes pour Frontline : Dedicated et Shared :

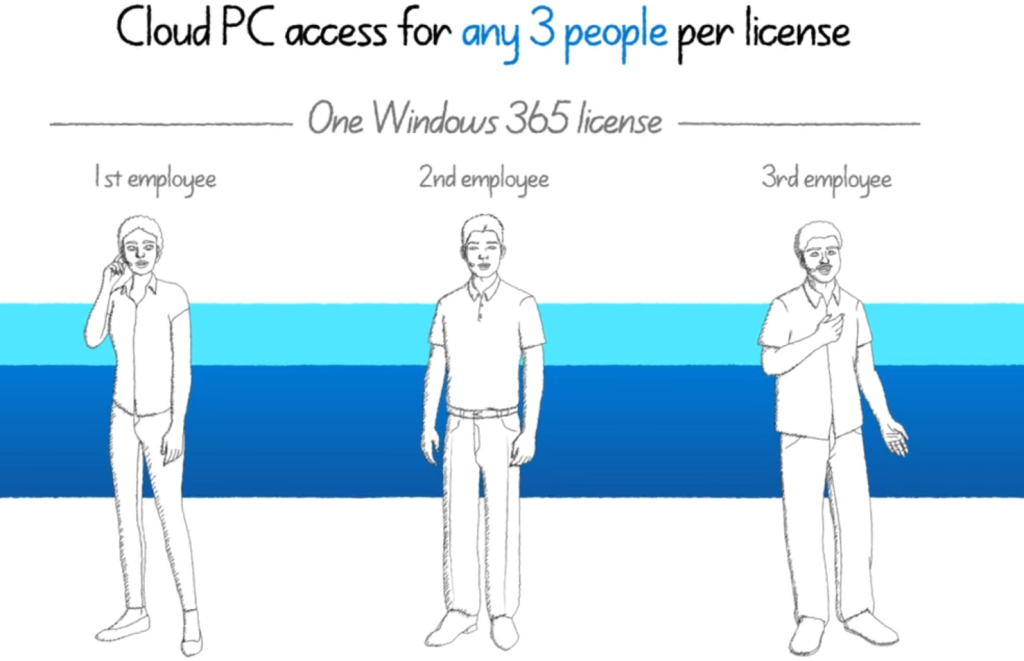

- Le mode Dedicated reste le choix recommandé pour des postes attribués en rotation (3 utilisateurs maximum).

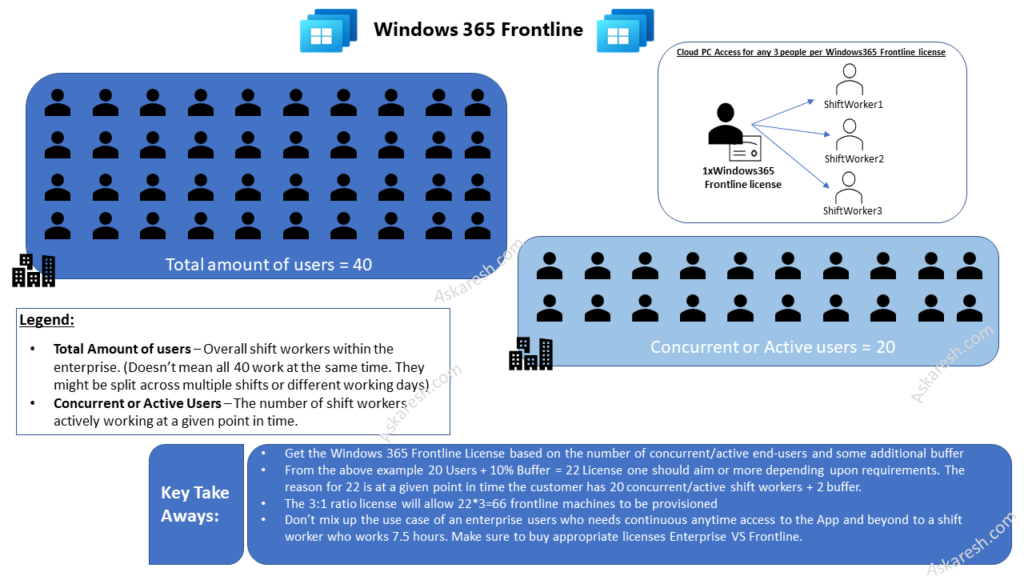

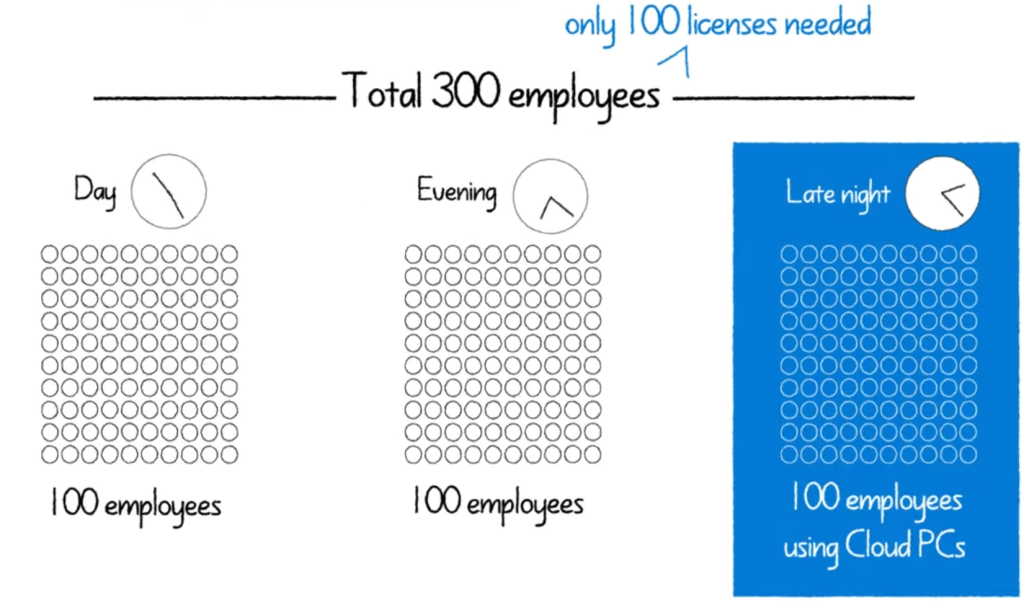

Prenons trois collaborateurs travaillant sur des shifts différents (matin, après-midi, nuit) — avec une seule licence Windows 365 Frontline, chacun dispose de son propre Cloud PC pendant son créneau de travail.

On réduit les coûts de licence tout en maintenant une expérience utilisateur complète et sécurisée pour chaque employé.

Le modèle devient particulièrement avantageux à grande échelle : pour 300 employés en rotation, il ne faudrait que 100 licences actives, soit une économie substantielle tout en maintenant une expérience et une sécurité identiques à Windows 365 Entreprise :

- Le mode Shared vise les scénarios éphémères où la persistance n’est pas nécessaire (kiosques, formation). Ce mode a été introduit par Microsoft fin 2024. Ce mode est donc conçu pour des tâches courtes et ponctuelles (ex. : formation, inventaire, accès temporaire pour prestataires).

En quelques mots, le Frontline Partagé se distingue du Frontline Dédié sur :

- Les Cloud PCs partagés sont réinitialisés après chaque session utilisateur : le profil et les données sont supprimés.

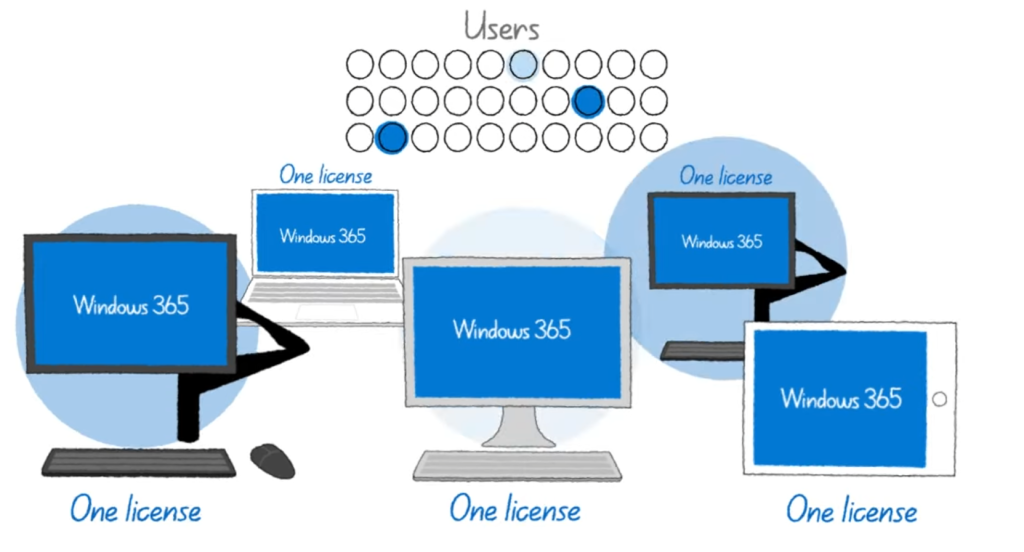

- 1 licence = 1 Cloud PC partagé : la licence est liée à la machine virtuelle, pas à un utilisateur spécifique.

- Les déconnexions automatiques après inactivité libèrent la session, permettant à d’autres utilisateurs d’accéder rapidement au poste.

Idéal pour les scénarios nécessitant un accès rapide et sécurisé à des applications ou outils sans conservation de données persistantes.

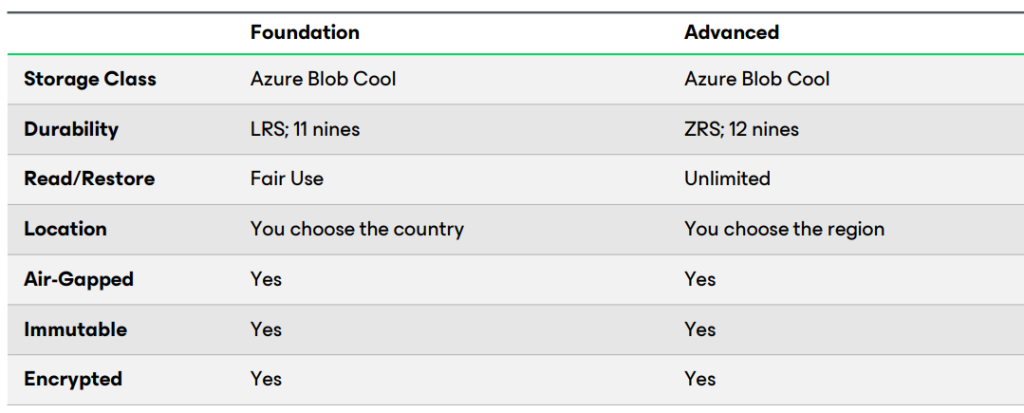

Au final, quelles sont les différentes licences Windows 365 ?

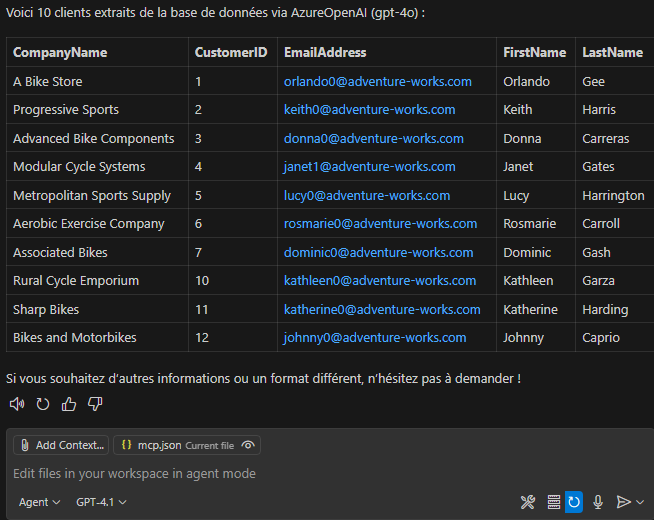

Voici un comparatif des différentes licences Windows 365 disponibles :

| Feature | Dedicated (Enterprise / Business) | Frontline Dedicated (Standard) | Frontline Shared Mode (Preview) |

|---|---|---|---|

| Cloud PC Usage | 1 Cloud PC par utilisateur | 3 Cloud PCs partagés entre 3 utilisateurs | Plusieurs Cloud PCs partagés entre de nombreux utilisateurs (1 à la fois) |

| User Profile | Persistant – sauvegardé entre les sessions | Persistant – chaque utilisateur a son propre bureau | Non persistant – profil supprimé après déconnexion |

| Concurrent Users | Un utilisateur par Cloud PC | 1 utilisateur par Cloud PC à la fois (jusqu’à 3 par licence, en rotation) | Un seul utilisateur à la fois par PC partagé |

| Session Type | Expérience Windows complète | Expérience Windows complète | Sessions pooled et réinitialisables |

| Best For | Employés à temps plein utilisant un Cloud PC quotidiennement | Travailleurs en rotation (shifts) | Accès temporaire, hot-desking, formation, kiosques |

| License Cost | Le plus cher | Plus bas (3 utilisateurs par licence) | Le plus bas – moins de licences requises |

| User Profile Storage | Conservé sur le Cloud PC | Conservé sur le Cloud PC | Supprimé à la fin de la session |

| Always-on Cloud PC | Oui | Éteint si non utilisé | Oui |

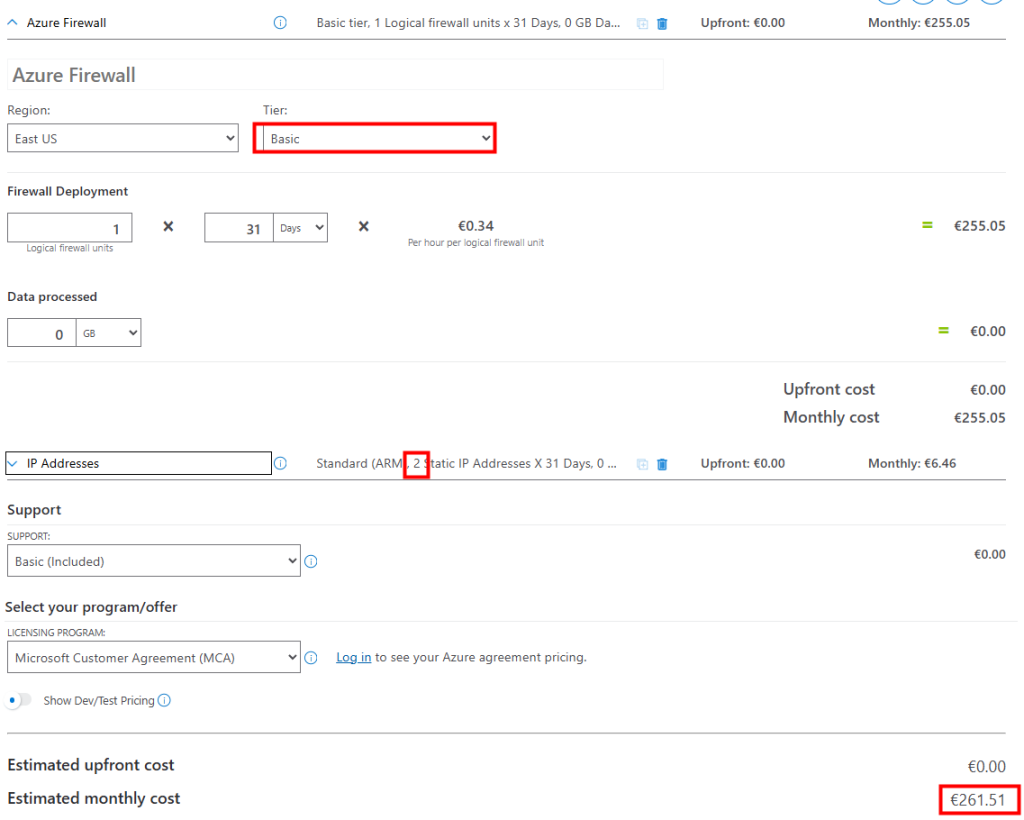

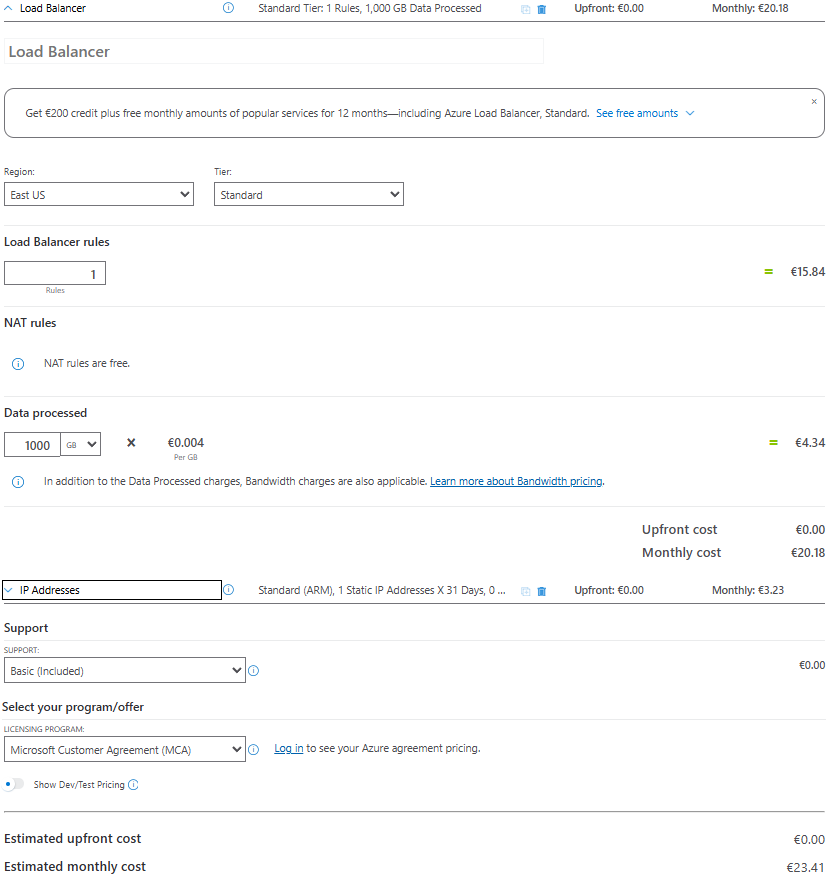

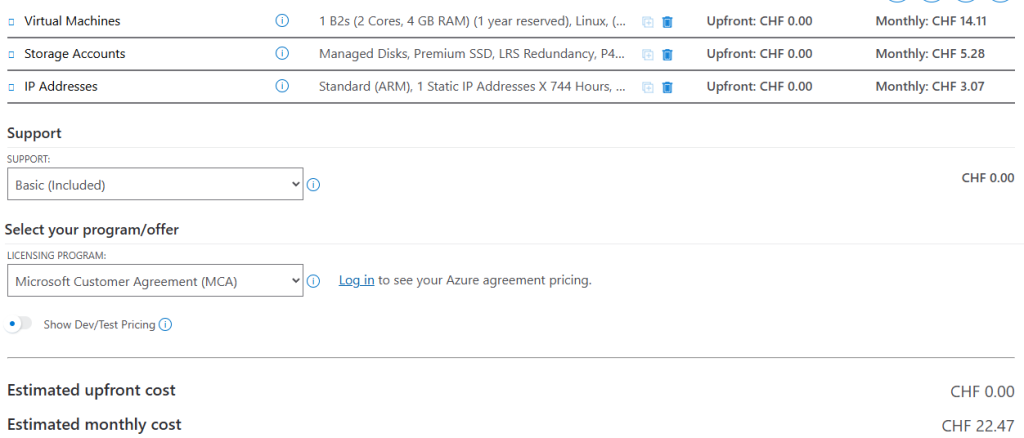

Quels sont les prix pour ces licences Windows 365 ?

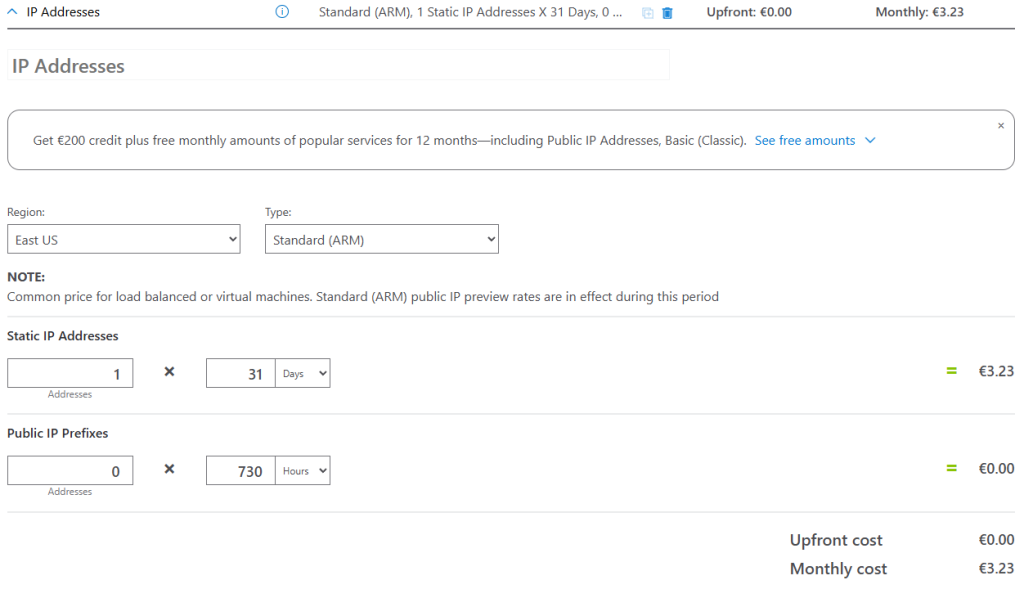

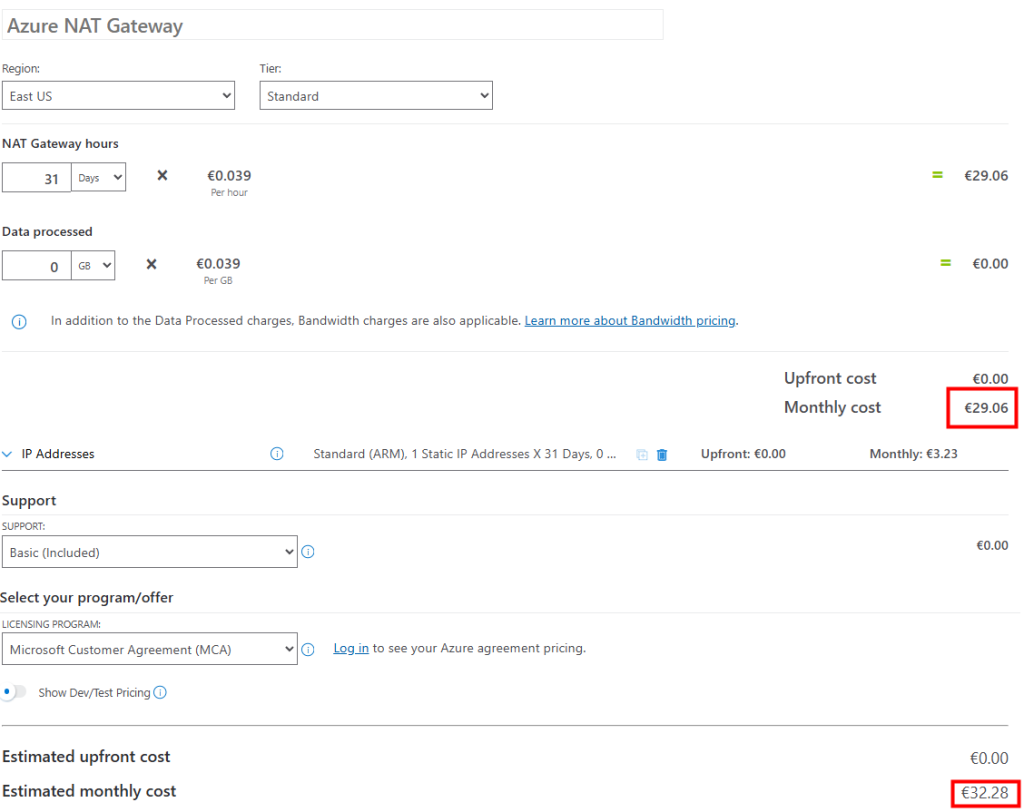

Les licences Windows 365 Frontline affichent un prix facial plus élevé que les éditions Enterprise ou Business, mais elles sont conçues pour être partagées entre plusieurs utilisateurs.

Autrement dit, il faut raisonner en coût par utilisateur actif plutôt qu’en coût par licence : une approche indispensable pour déterminer la solution la plus avantageuse financièrement selon ton modèle d’usage (rotation, shifts, postes partagés, etc.).

Voici donc un tableau comparatif indicatif (en USD) pour une machine de 4 vCPU / 16 Go RAM, selon les quatre « méthodologies » (Business / Enterprise / Frontline Dedicated / Frontline Shared) de licensing possibles pour Windows 365 :

| Méthode / SKU | Prix en €, paiement mensuel engagement annuel |

|---|---|

| Windows 365 Enterprise | ≈ 63 Euros |

| Windows 365 Business | ≈ 63 Euros, avec Windows Hybrid Benefit |

| Windows 365 Frontline Dedicated | ≈ 94.53 € (licence 3 utilisateurs) |

| Windows 365 Frontline Shared | ≈ 94.53 € par poste partagé |

Maintenant, il ne nous reste plus qu’à tester tout cela 😎

- Etape 0 – Rappel des prérequis

- Test I – Test de Windows 365 Frontline Dédié

- Test II – Test de Windows 365 Frontline Partagé

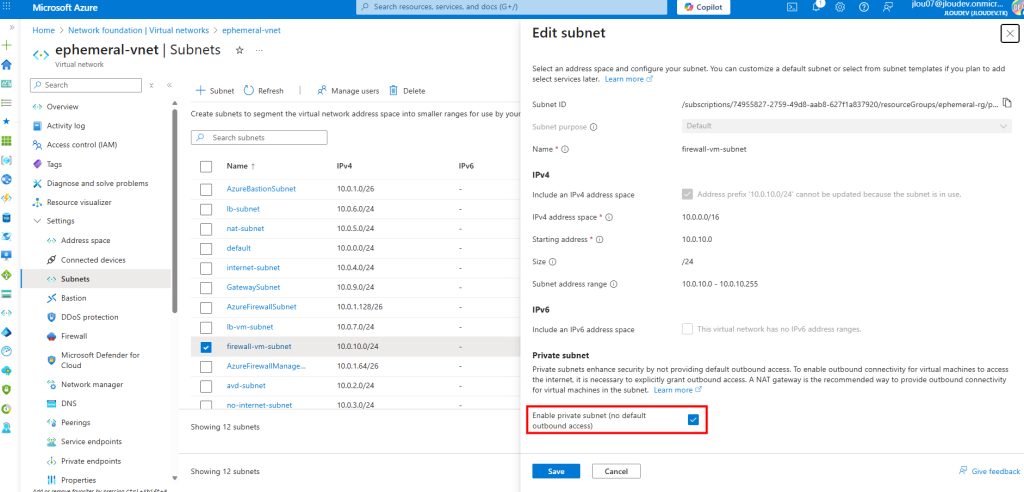

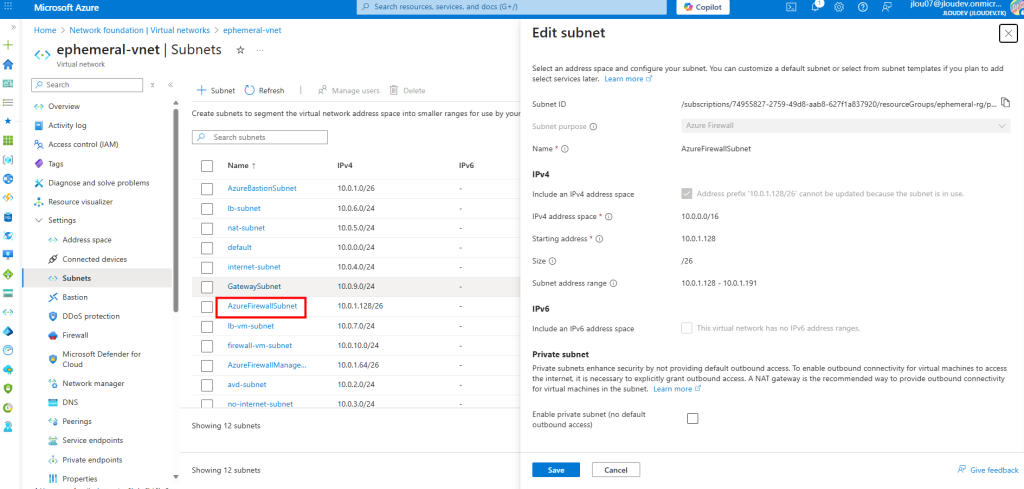

Etape 0 – Rappel des prérequis :

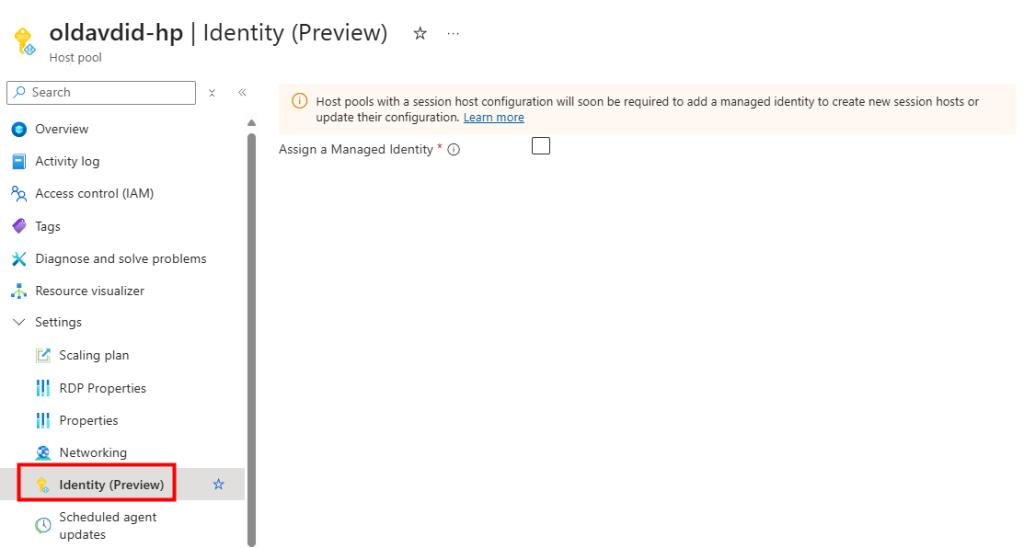

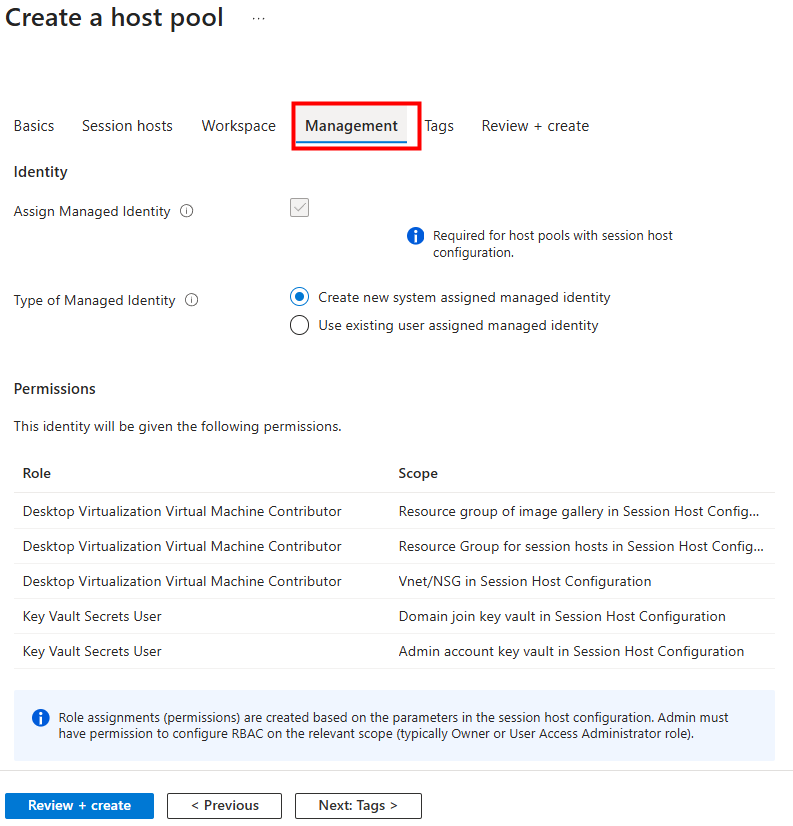

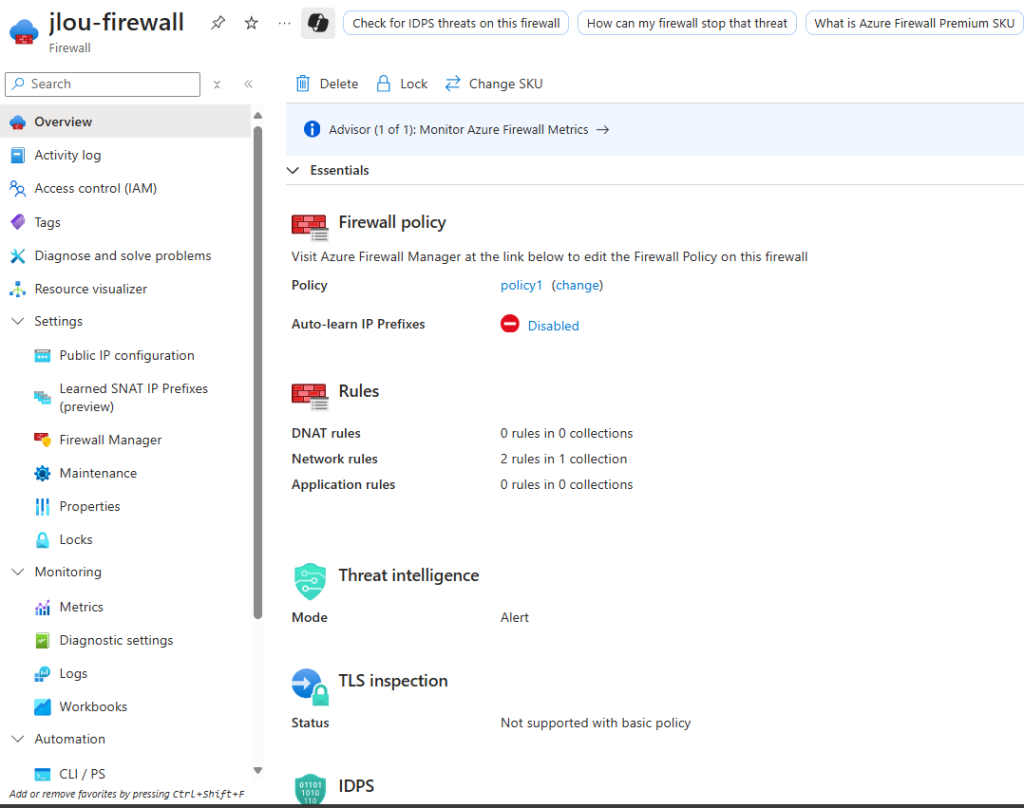

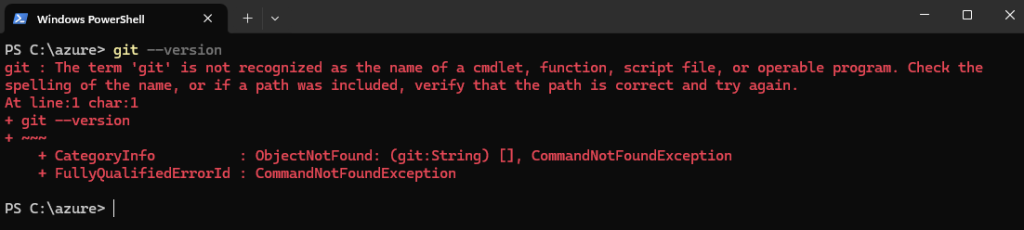

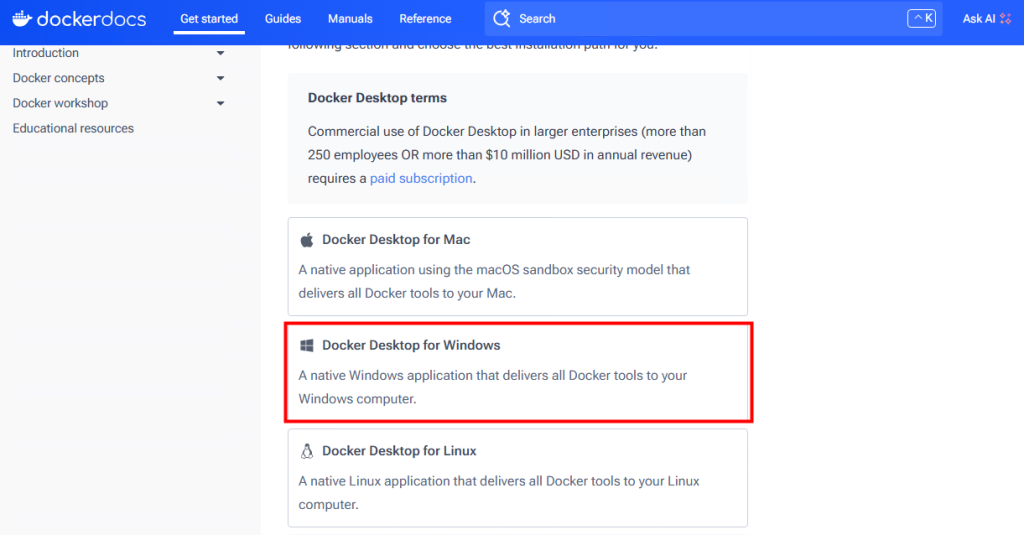

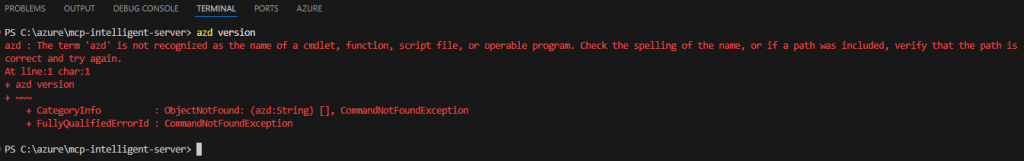

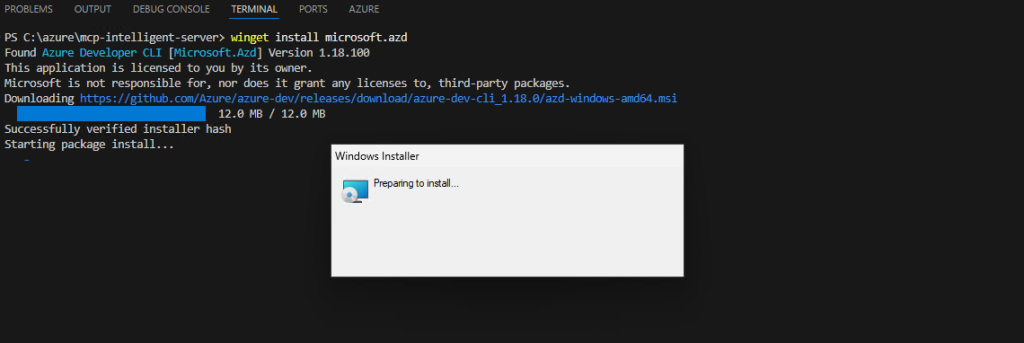

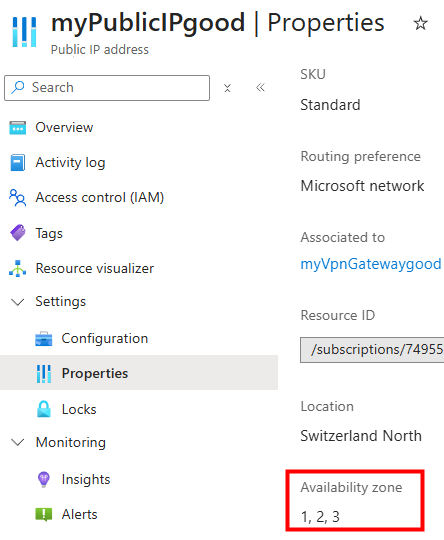

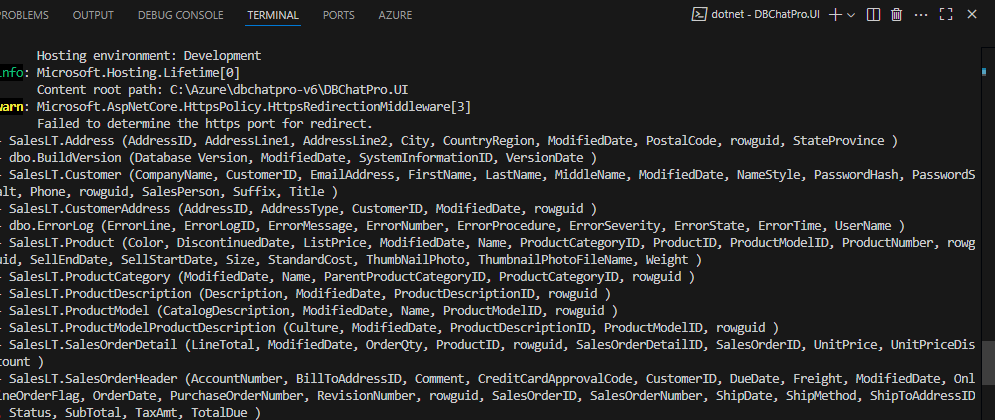

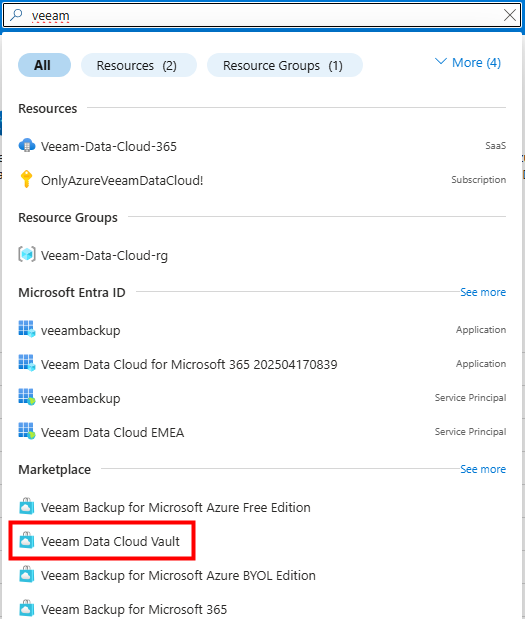

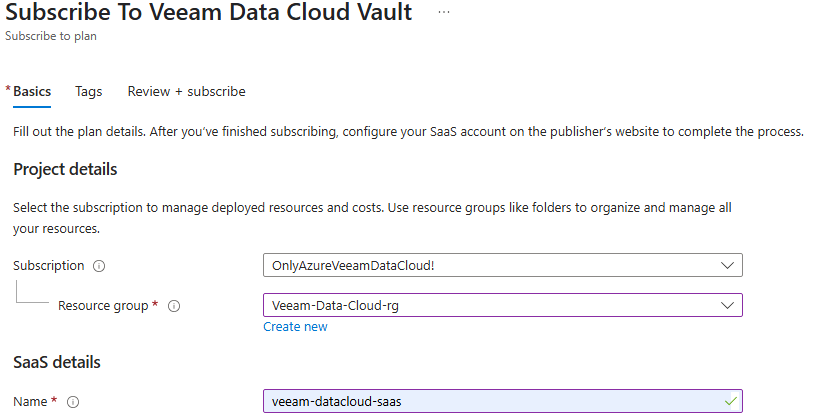

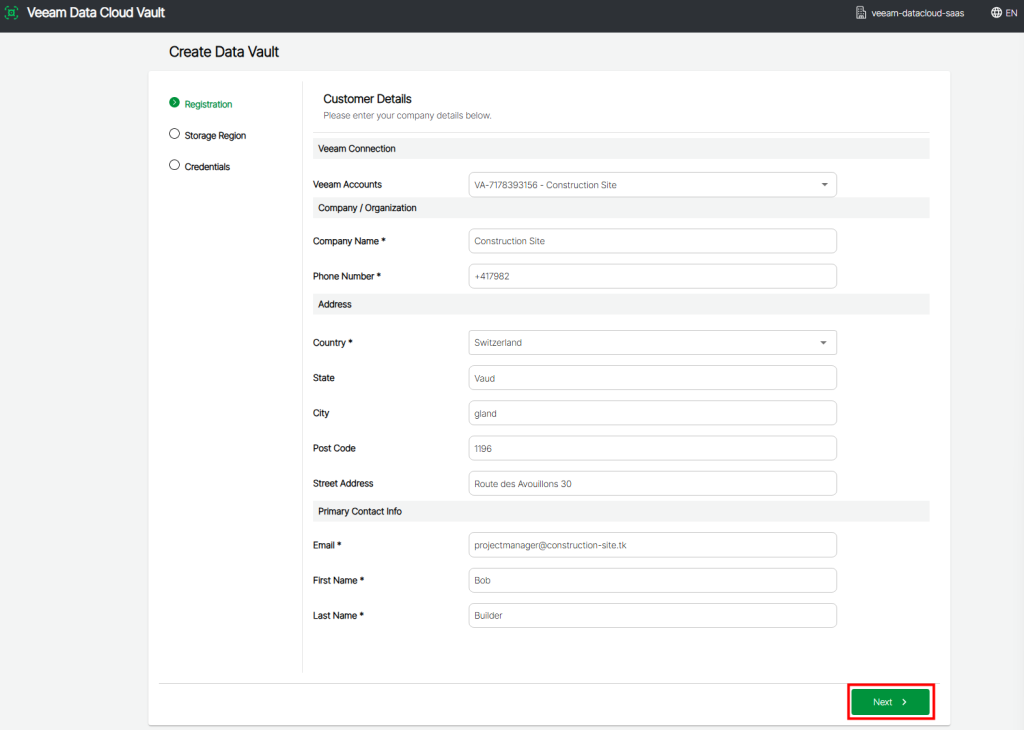

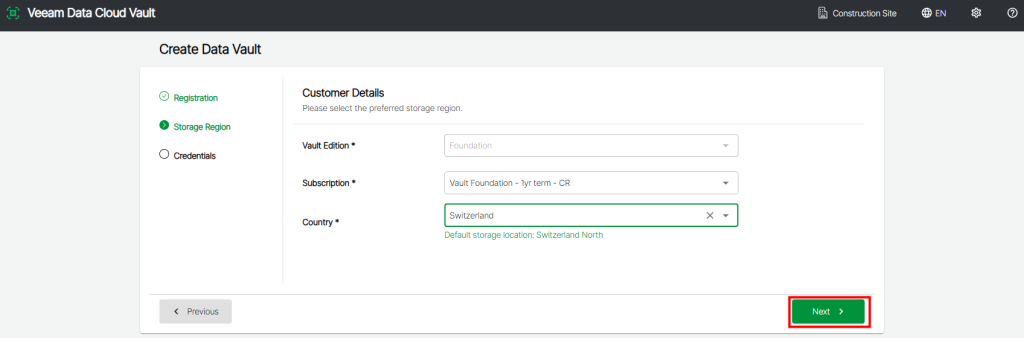

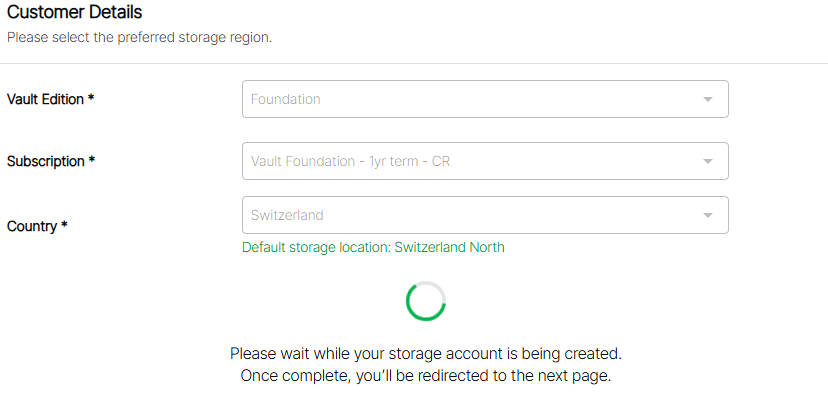

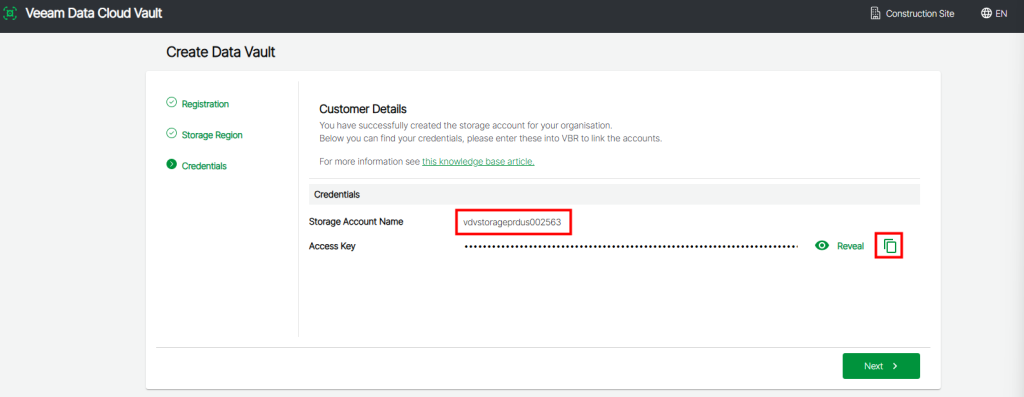

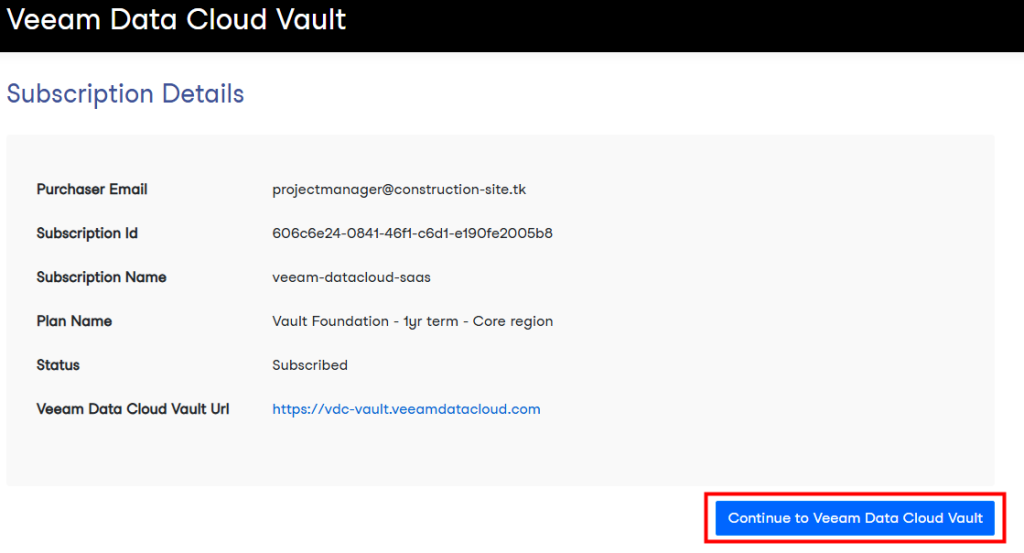

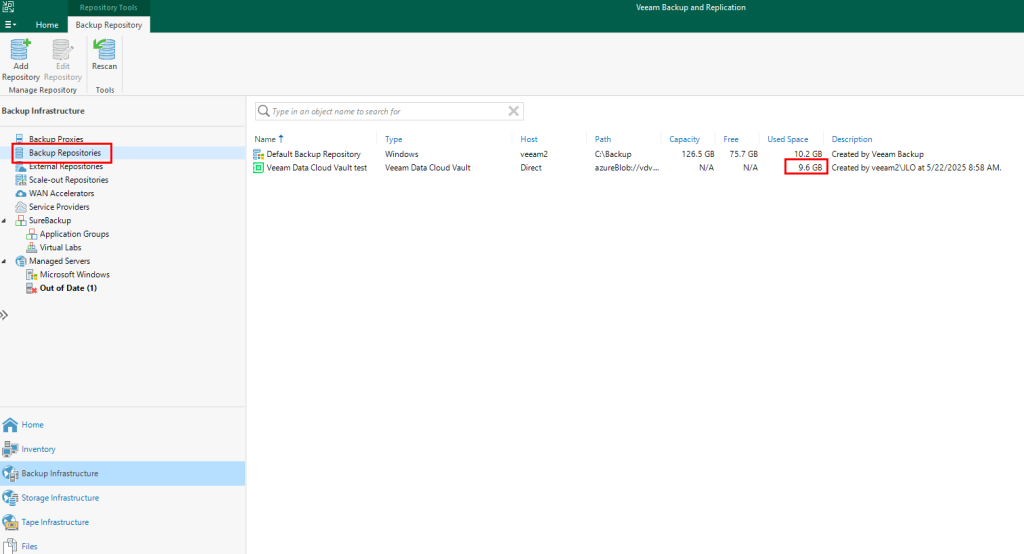

Pour réaliser cette démonstration sur les licences Windows 365 Frontline, il vous faudra disposer de :

- Un tenant Microsoft

- Une ou plusieurs licences Windows 365 Frontline

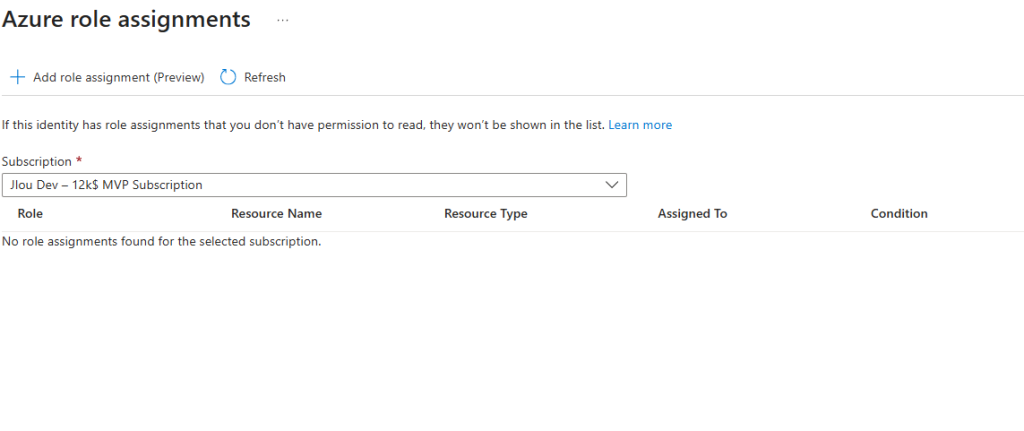

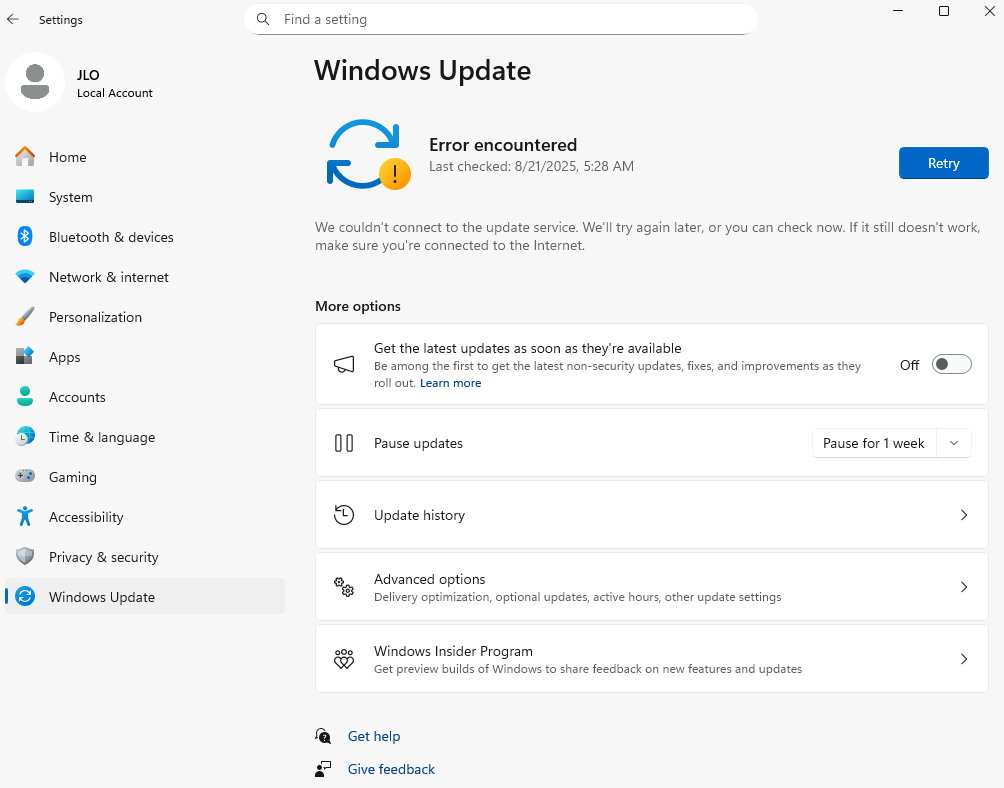

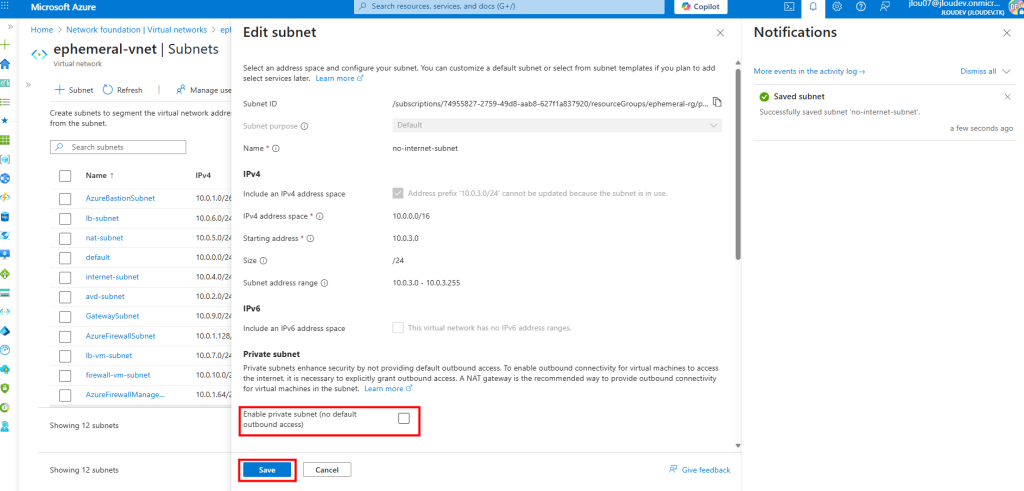

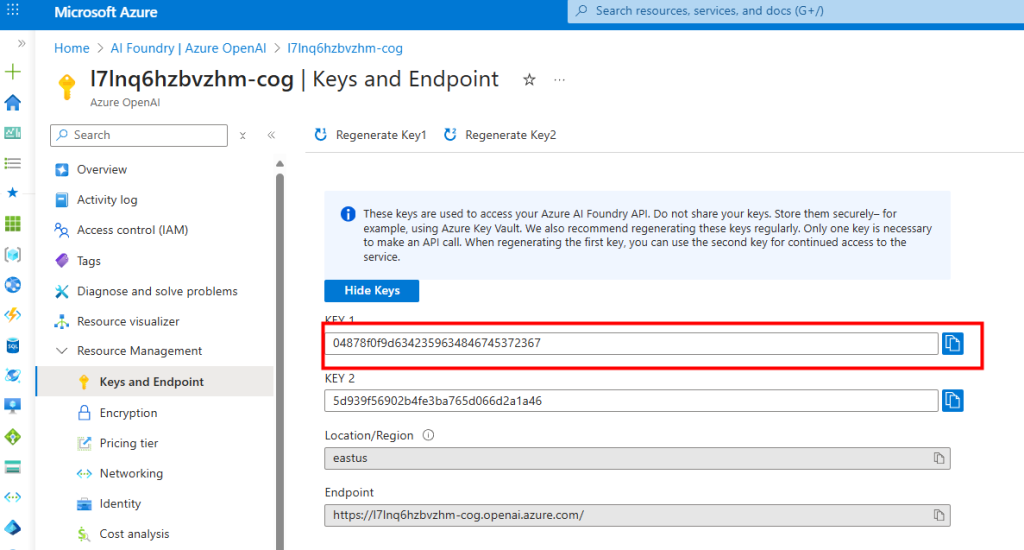

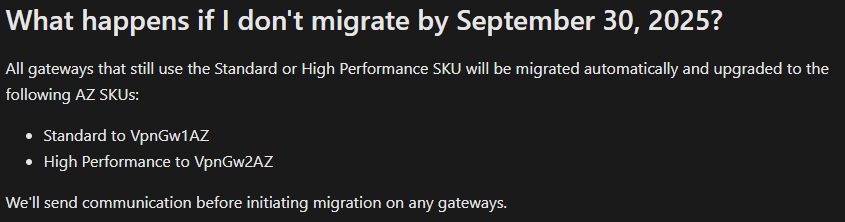

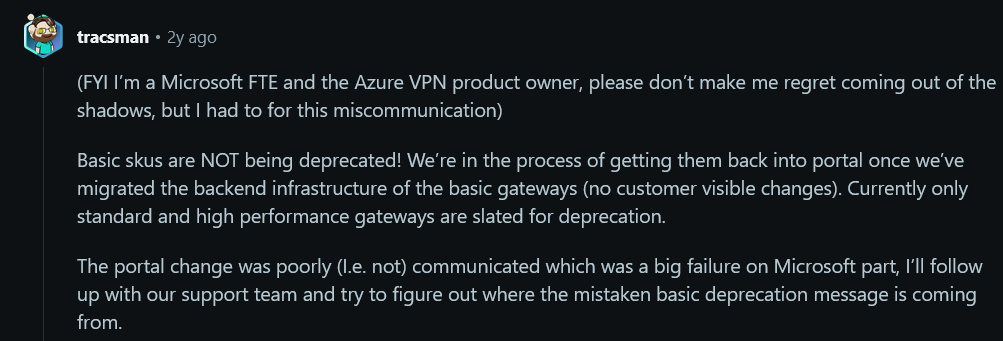

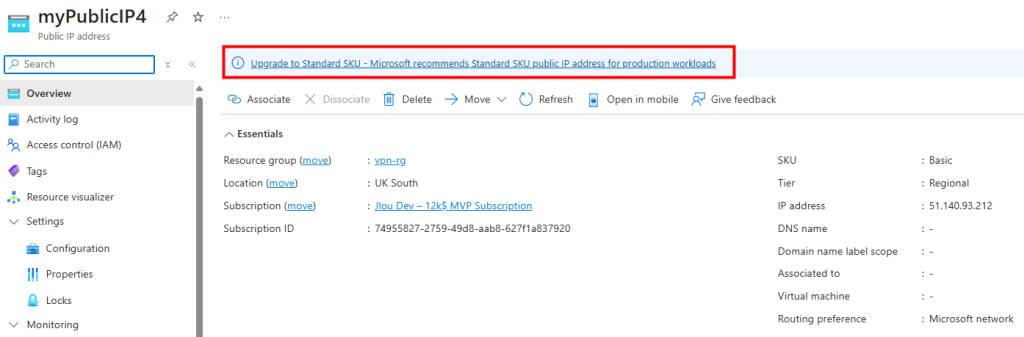

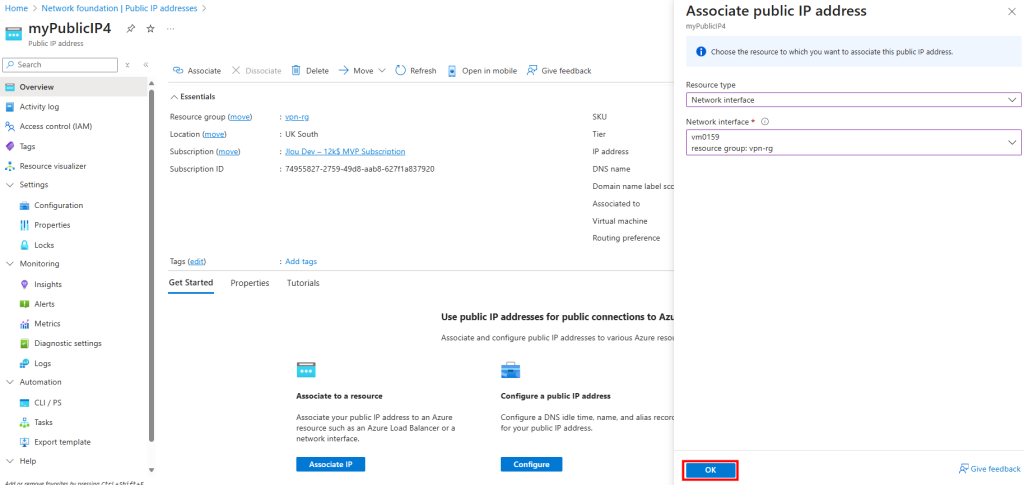

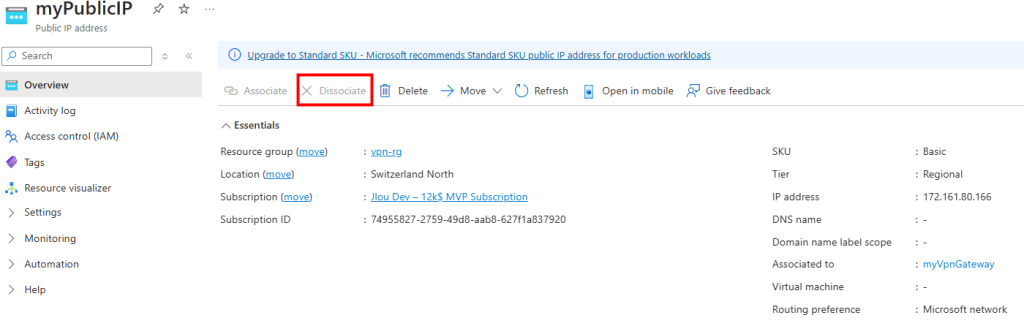

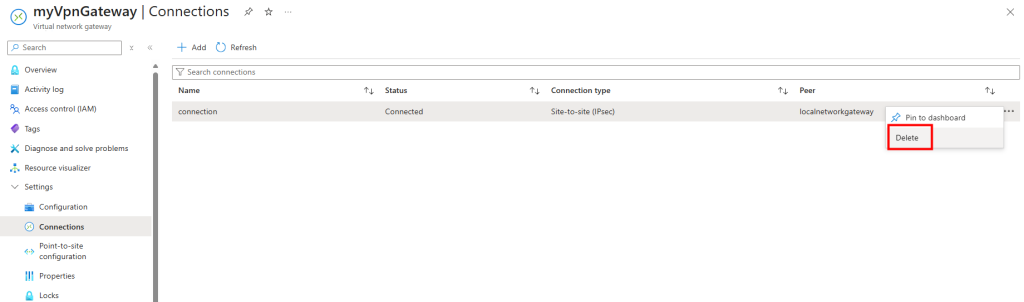

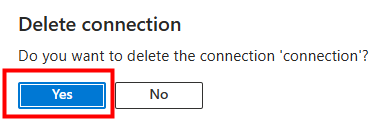

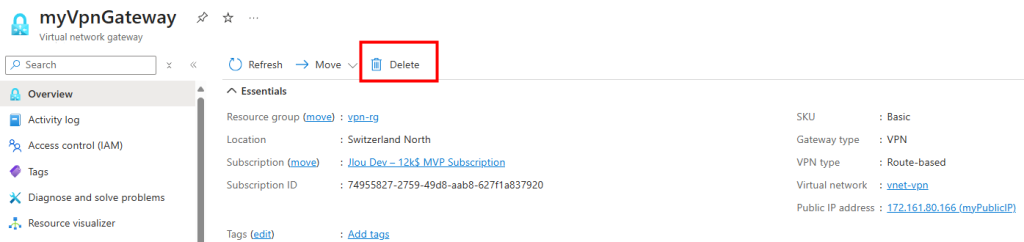

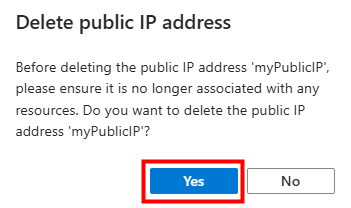

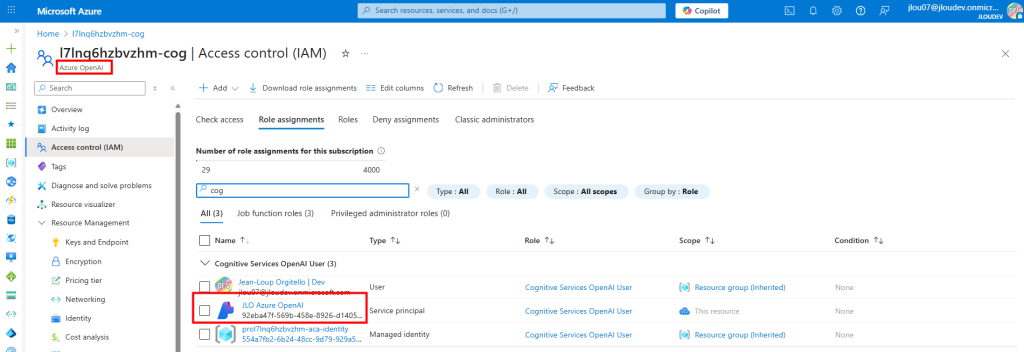

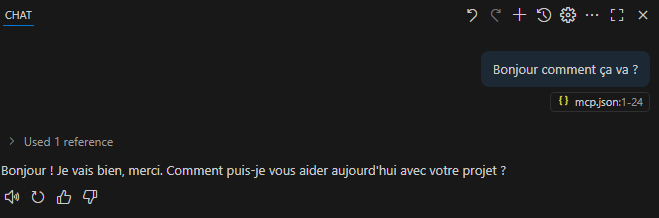

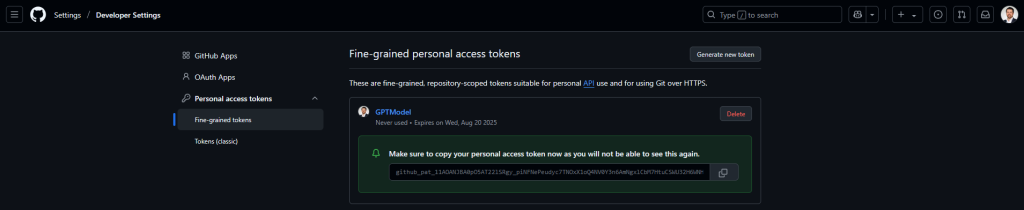

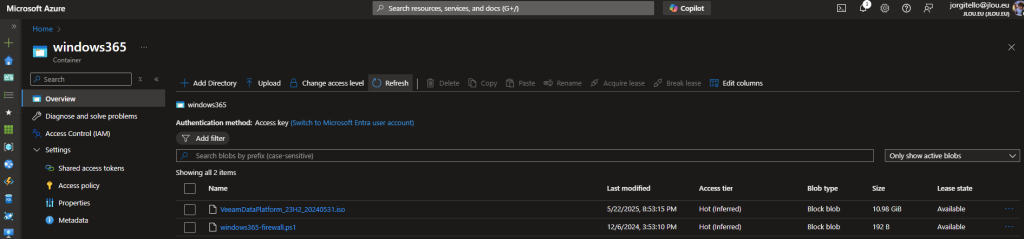

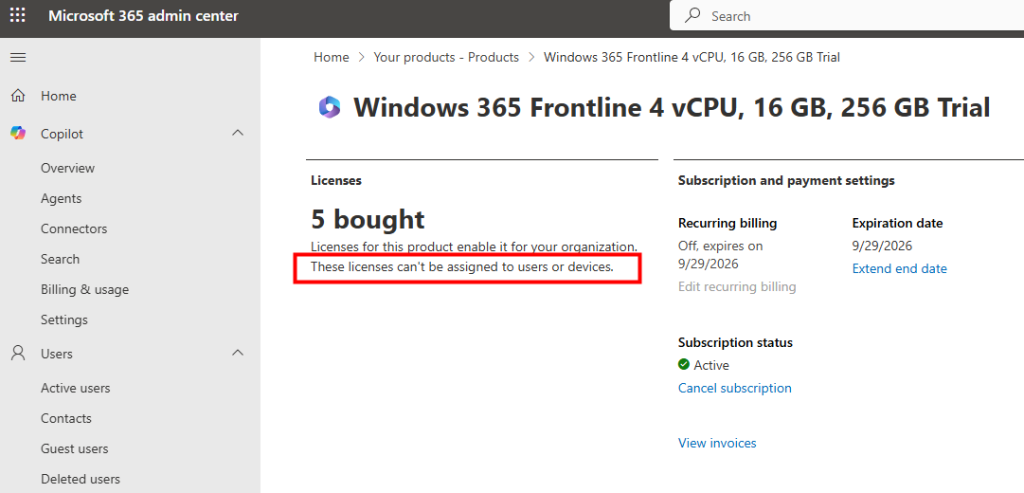

Dans le portail Microsoft 365 Admin Center, on remarque tout de suite que ces licences ne peuvent pas être attribuées directement à des utilisateurs ou à des appareils :

Toujours depuis le portail Admin Center, il n’est pas possible d’associer la licence Frontline à un utilisateur :

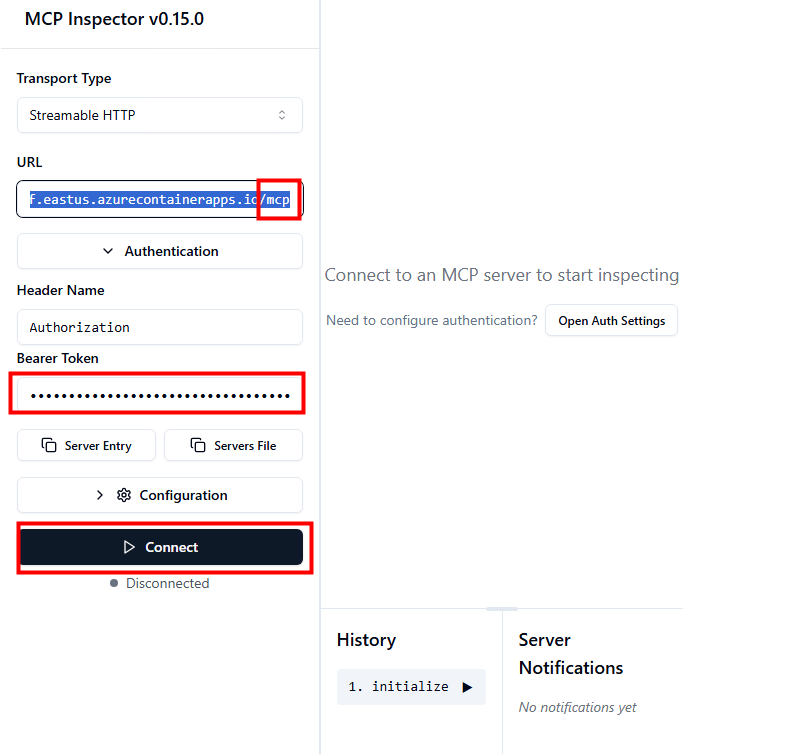

Commençons par tester les Cloud PCs Frontline dédiés à des utilisateurs spécifiques.

Test I – Test de Windows 365 Frontline Dédié :

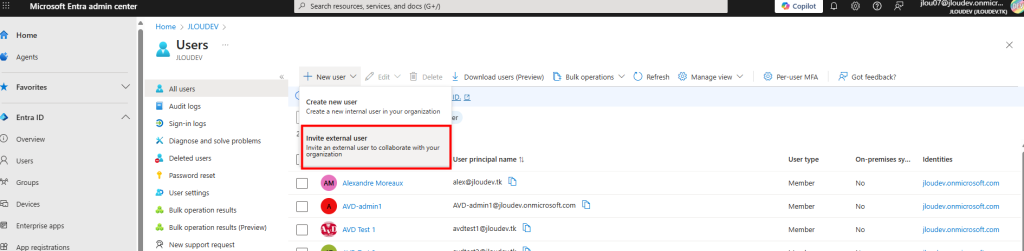

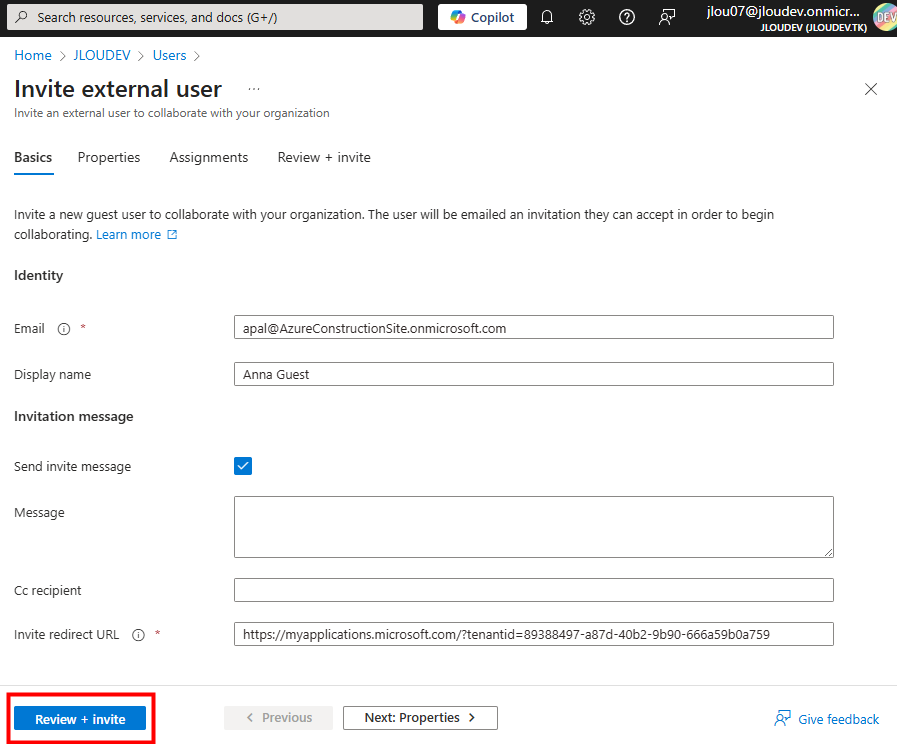

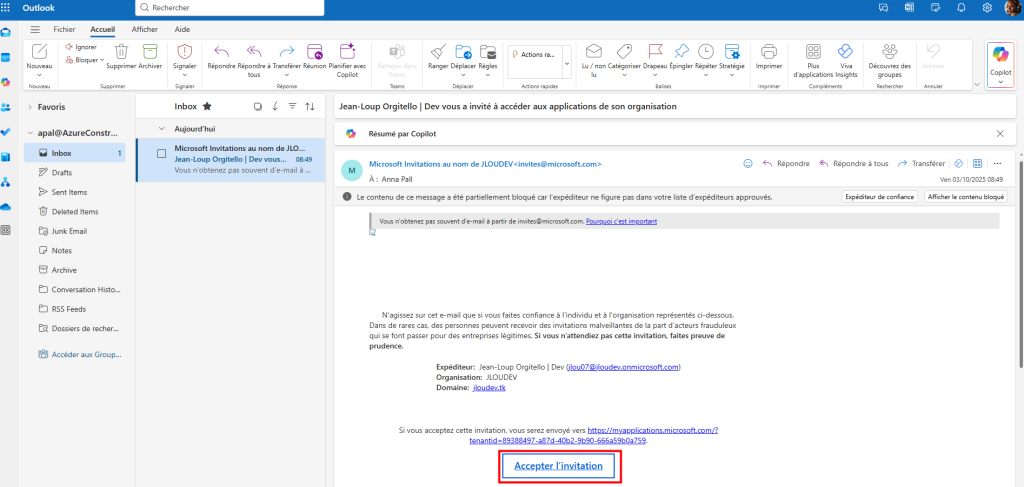

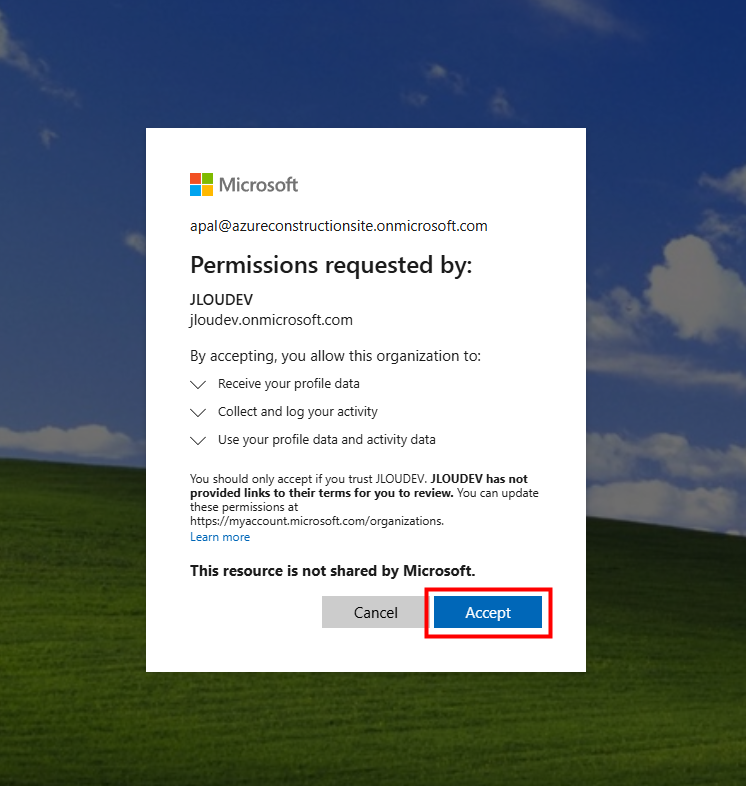

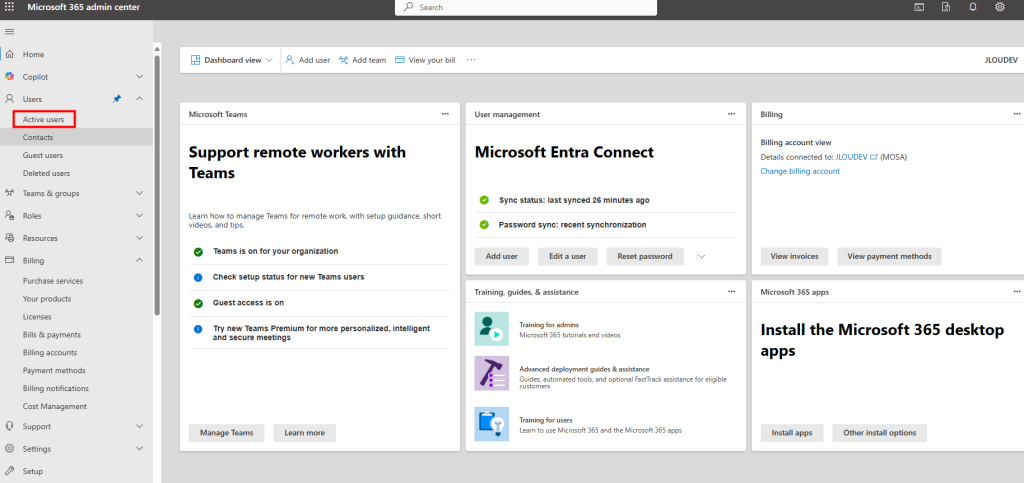

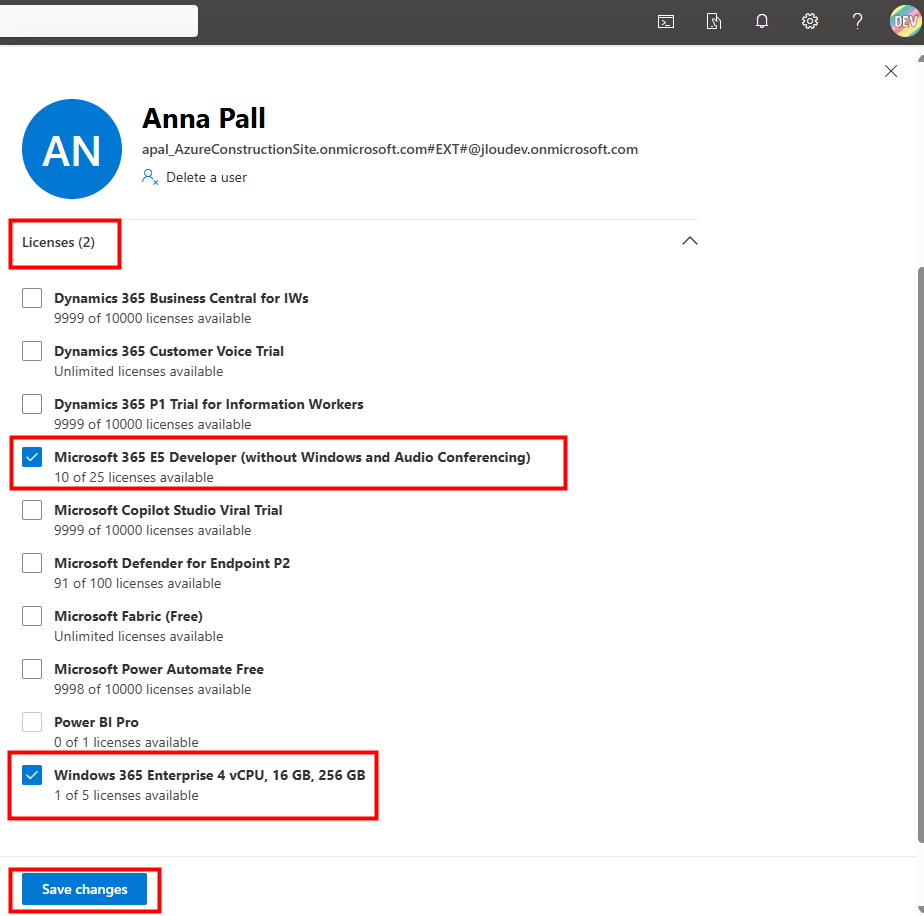

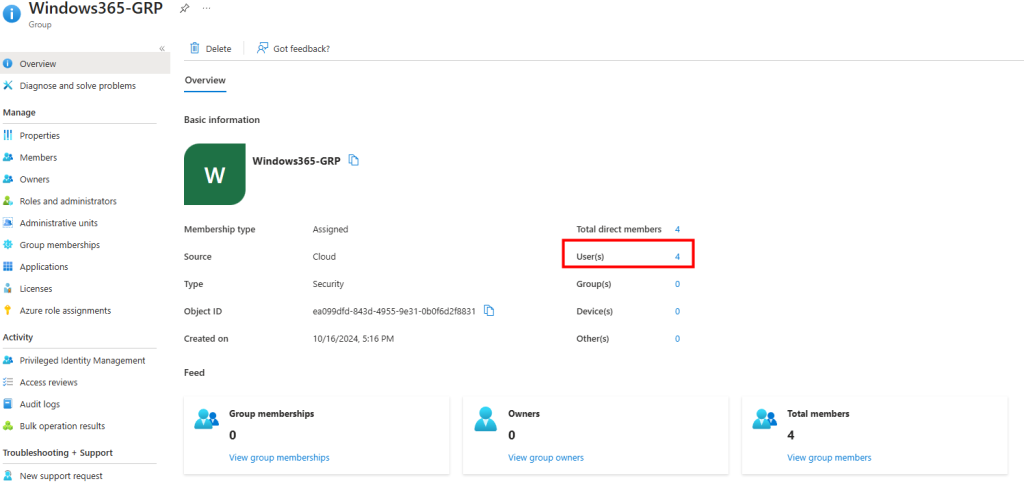

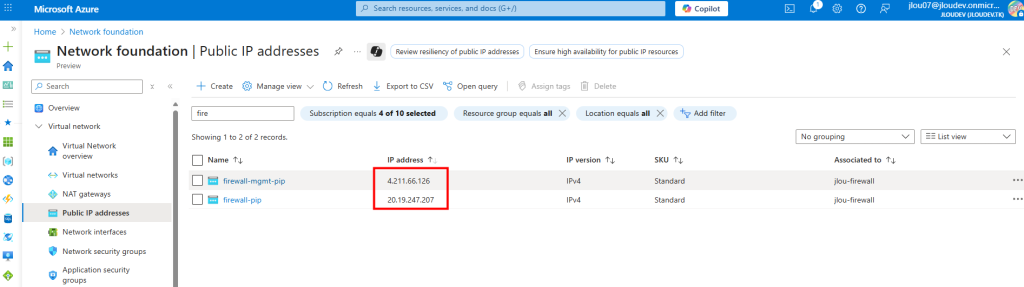

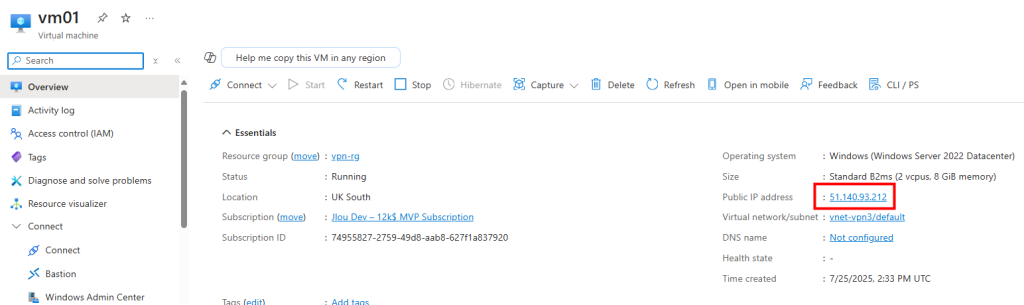

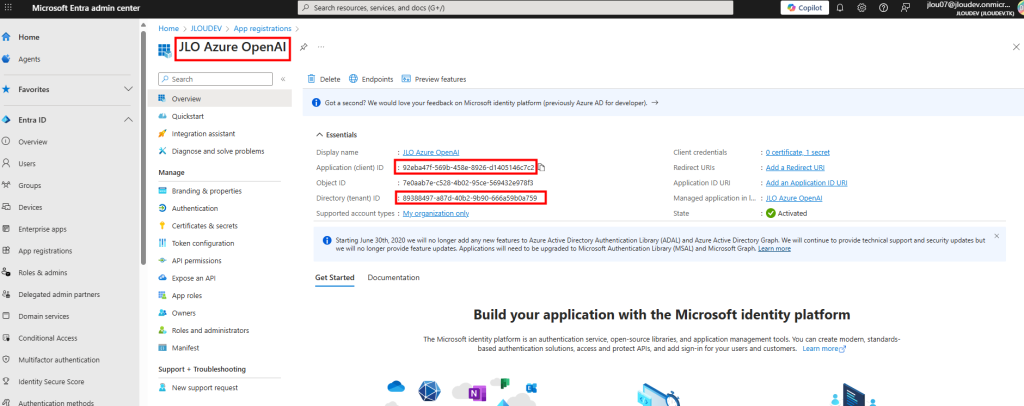

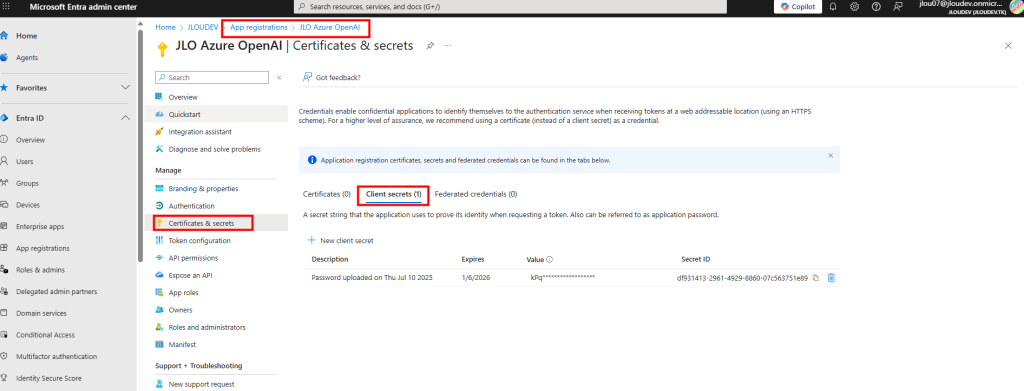

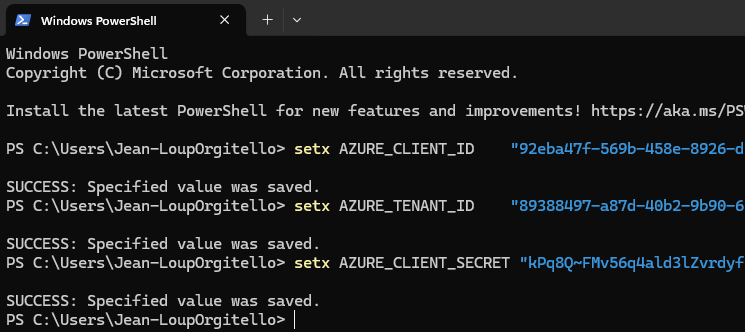

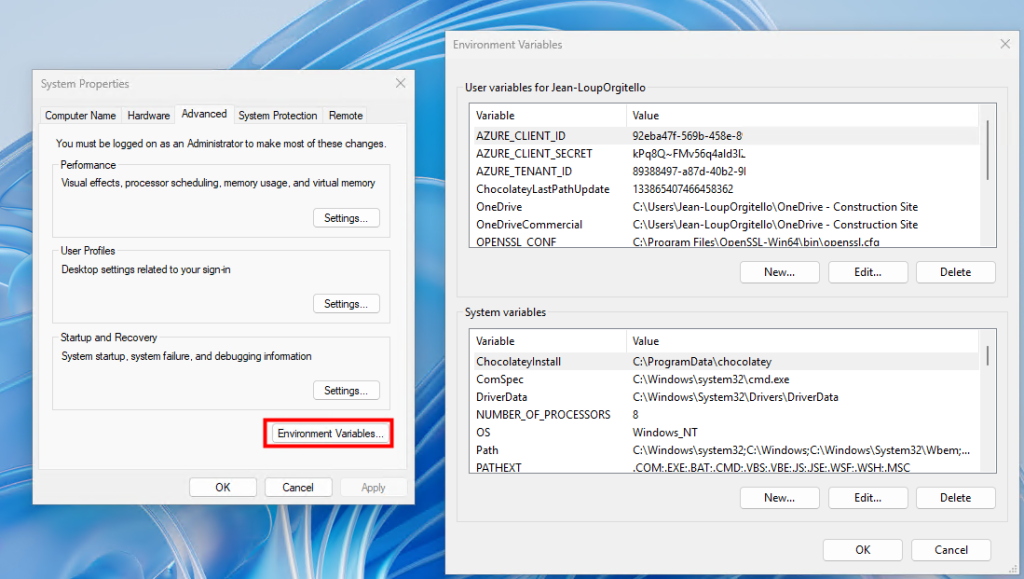

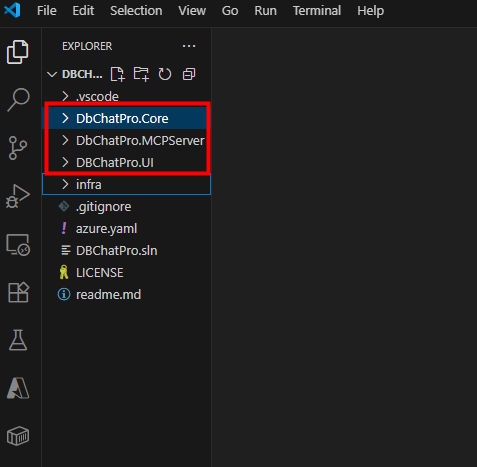

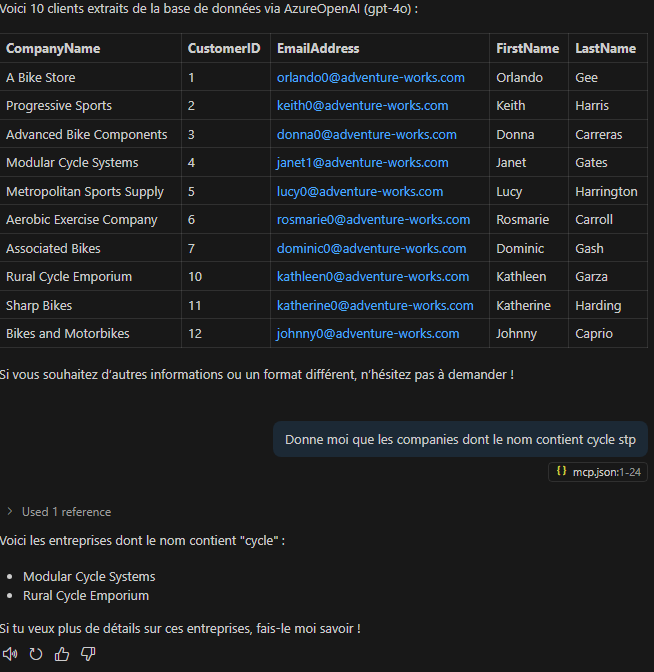

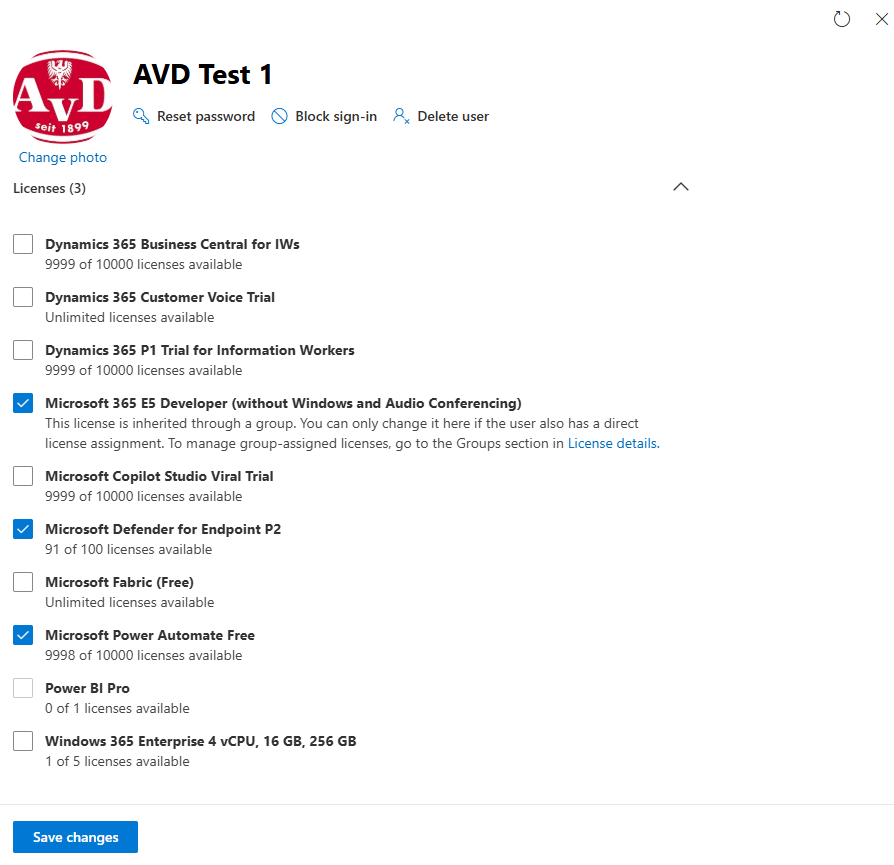

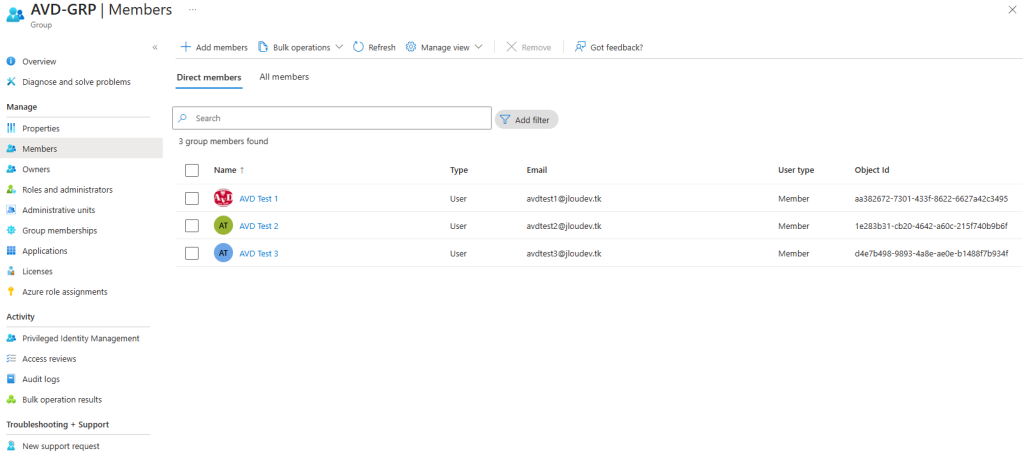

J’ai commencé par créer un groupe sur le portail Entra ID pour mes utilisateurs de test :

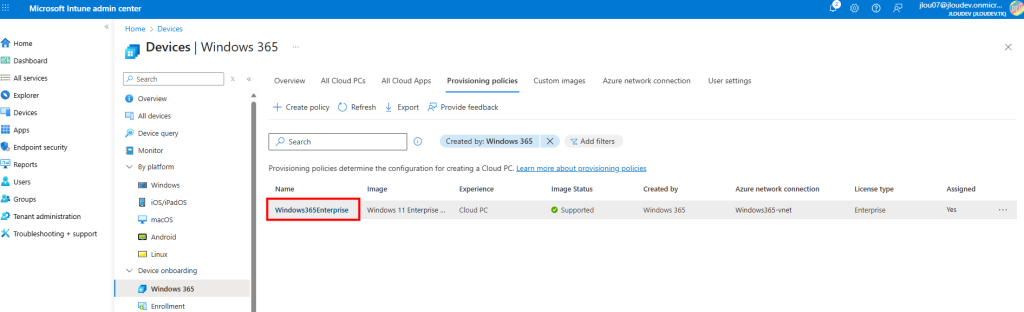

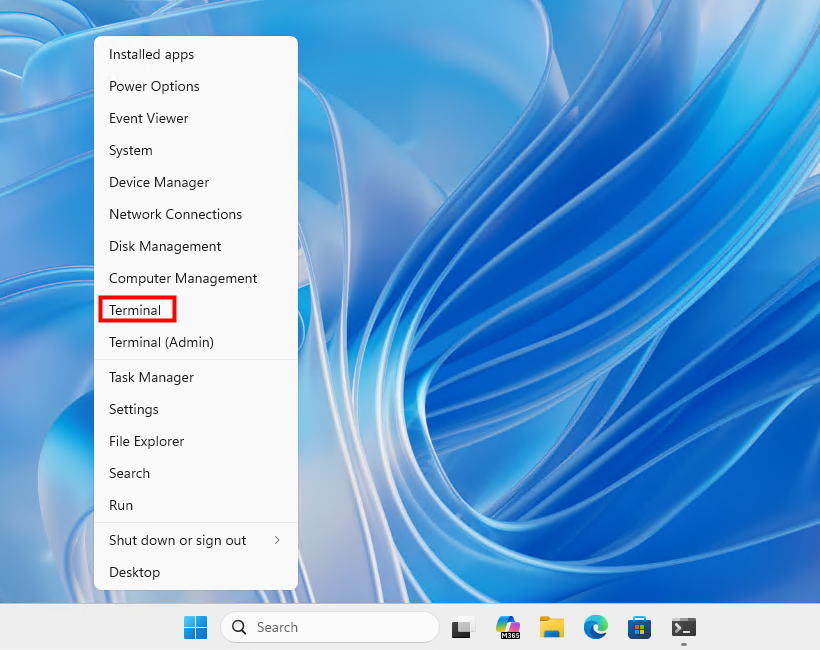

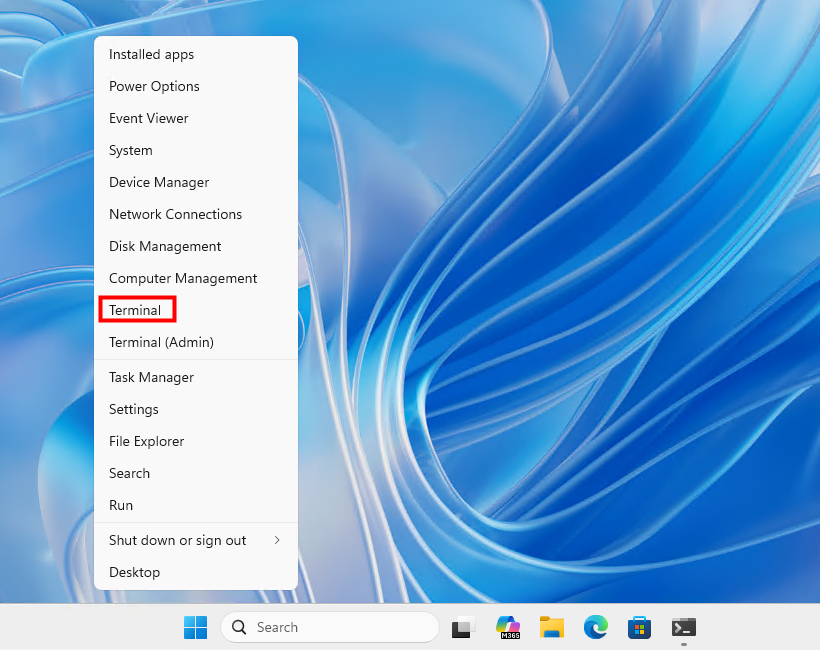

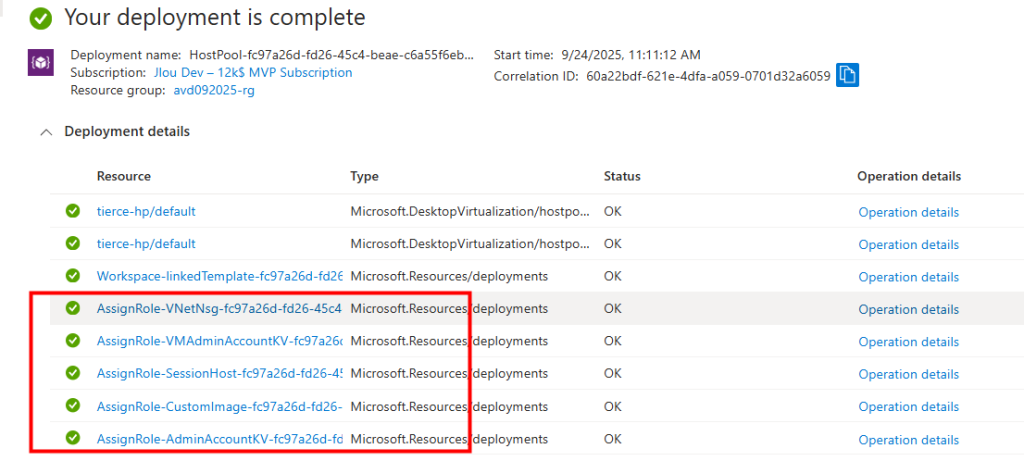

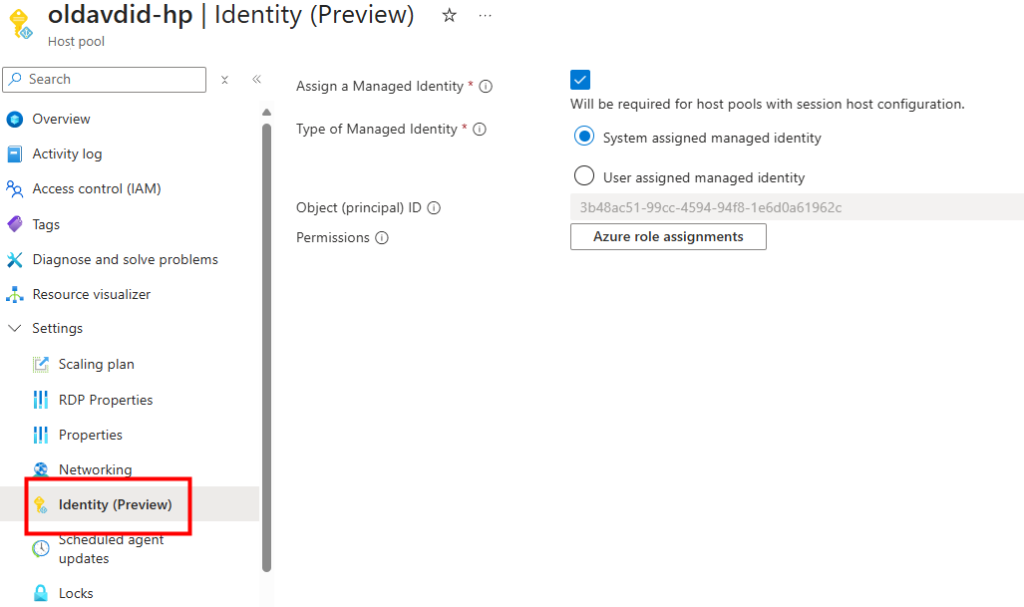

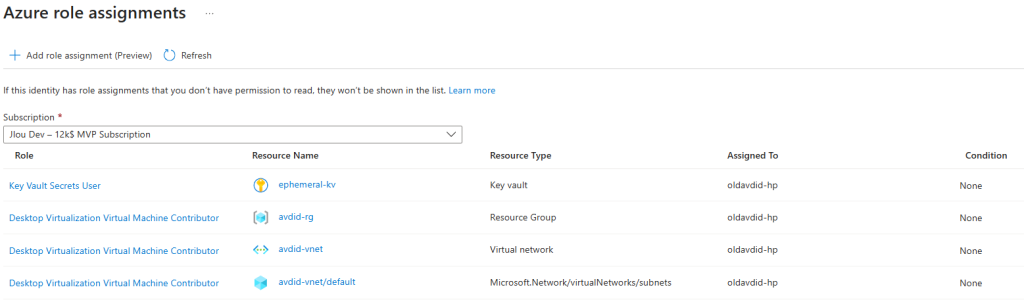

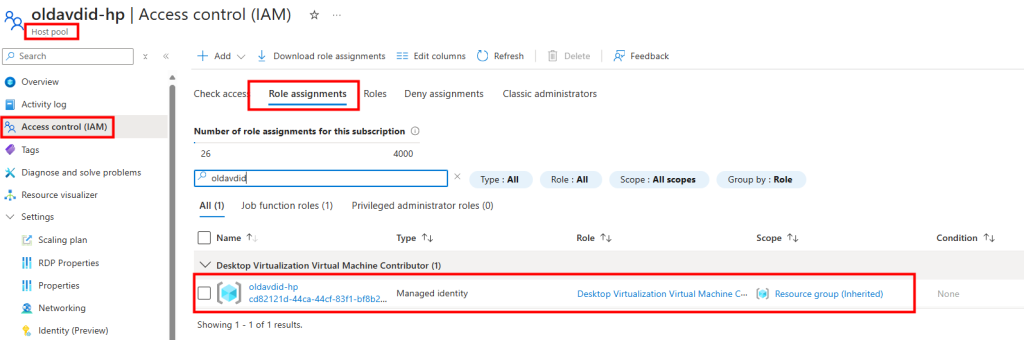

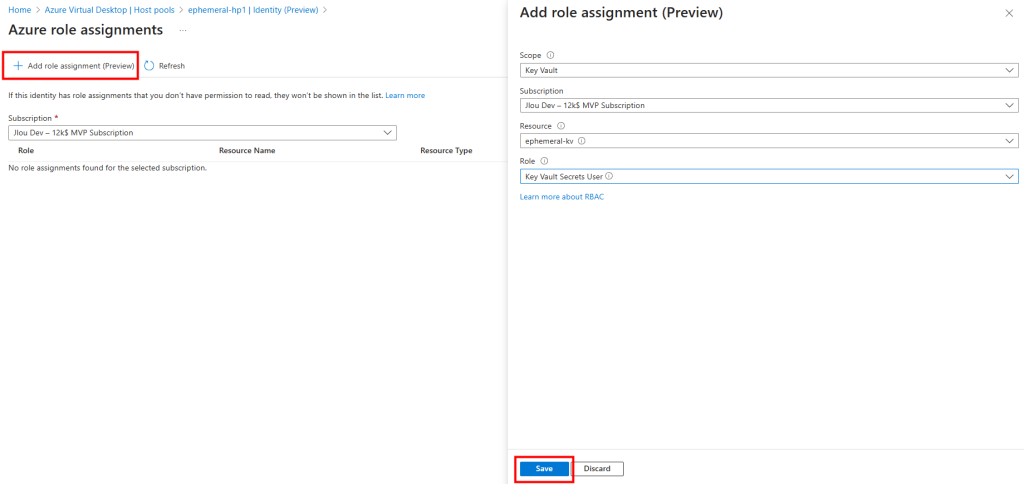

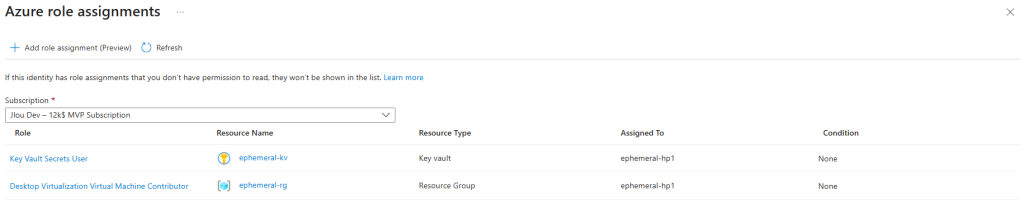

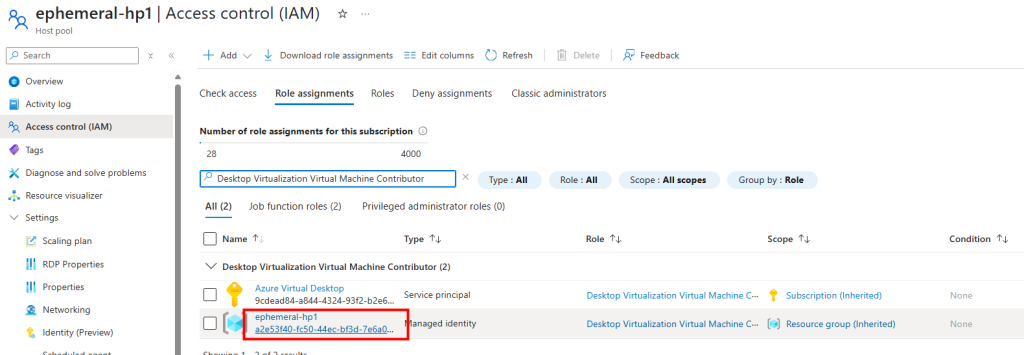

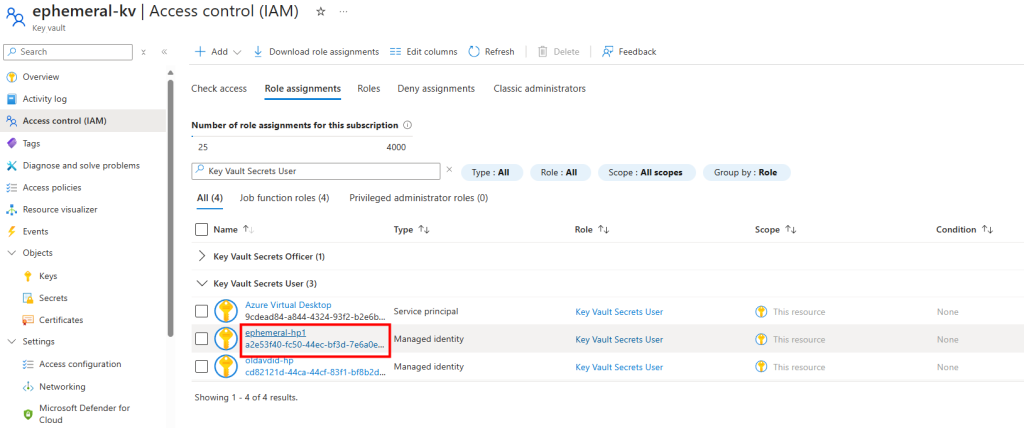

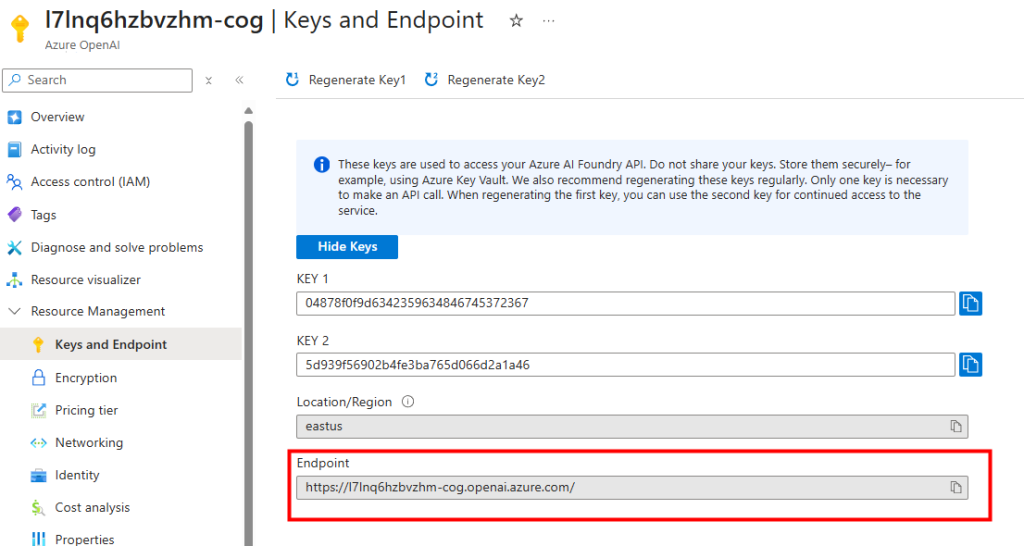

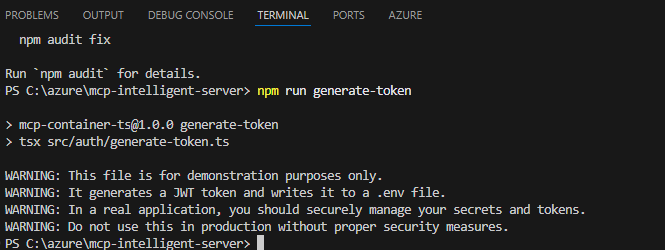

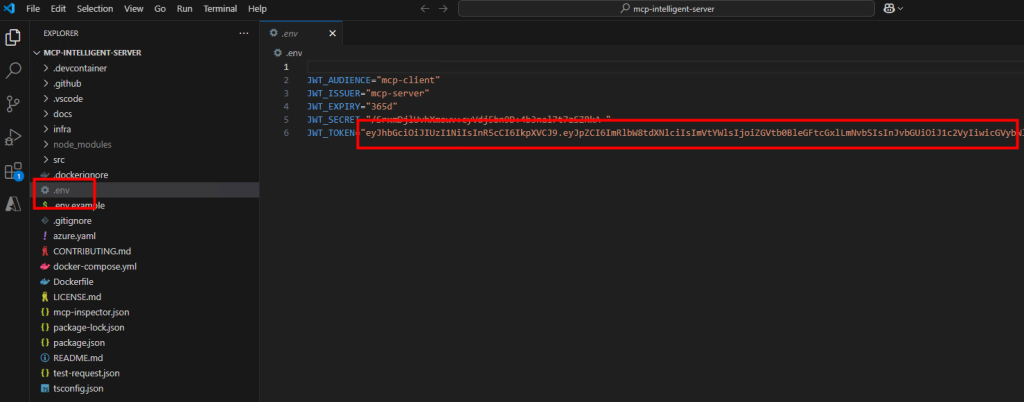

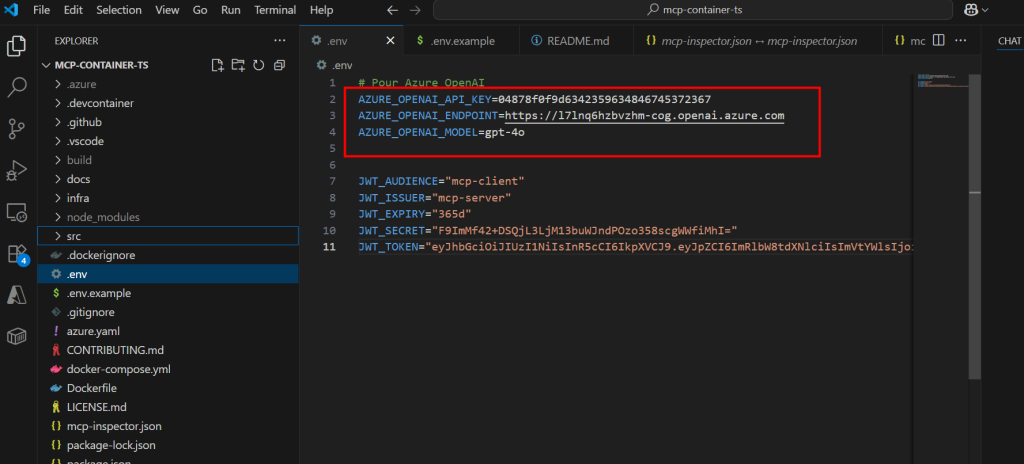

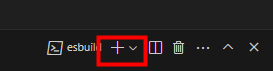

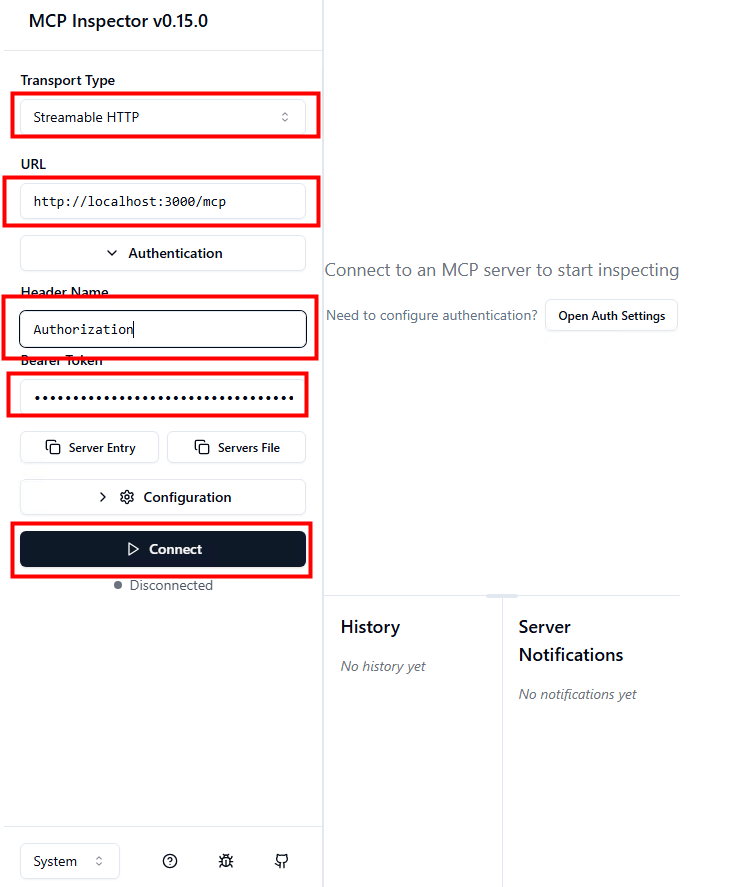

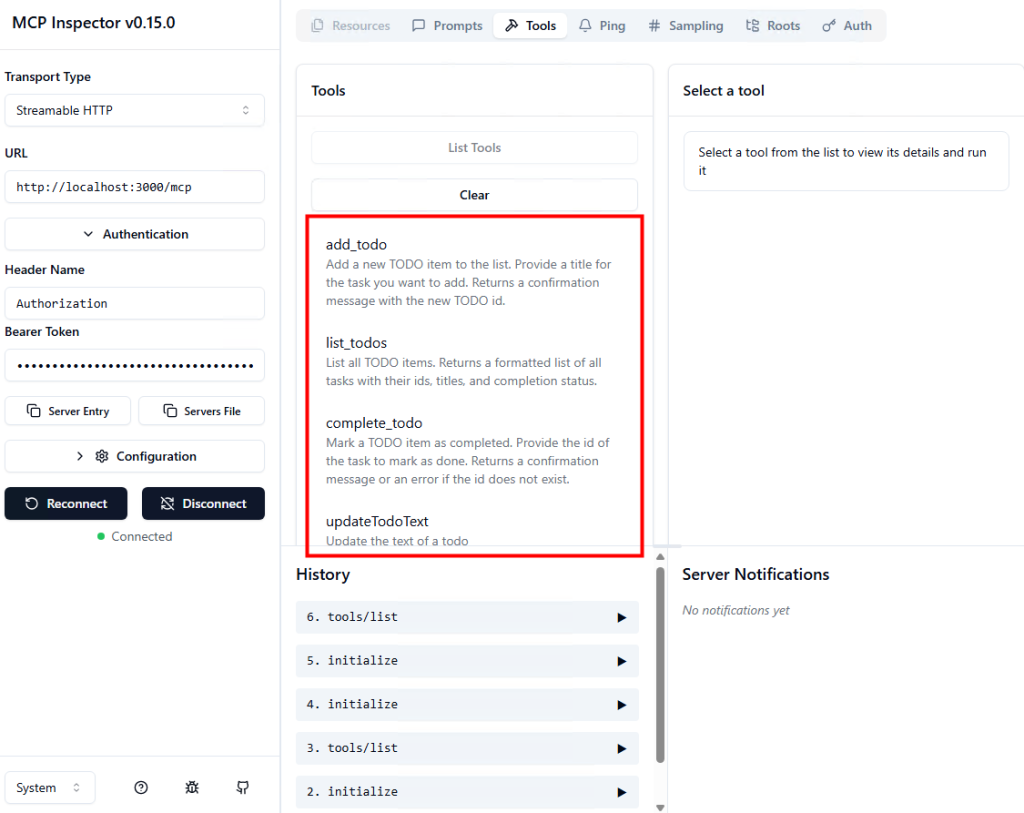

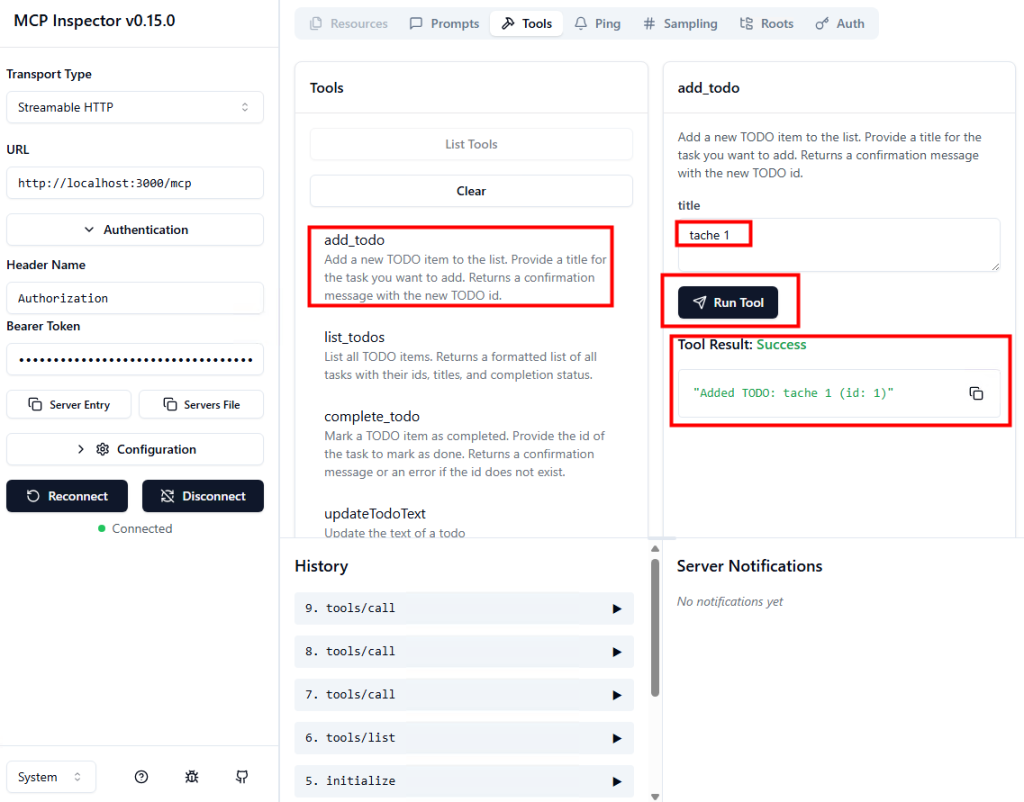

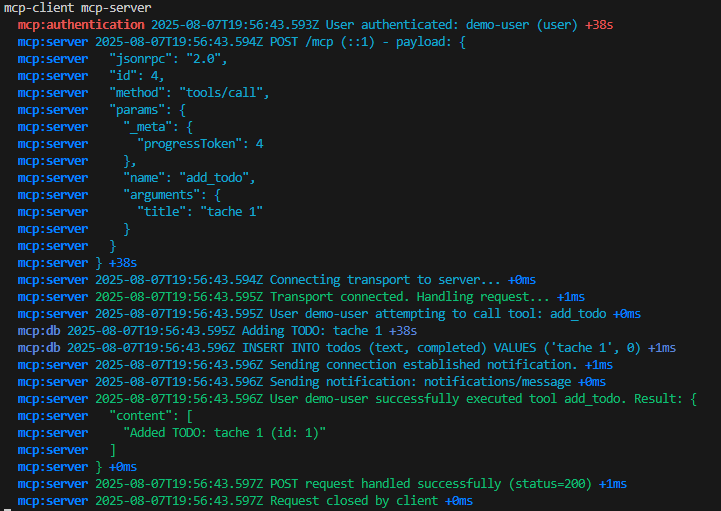

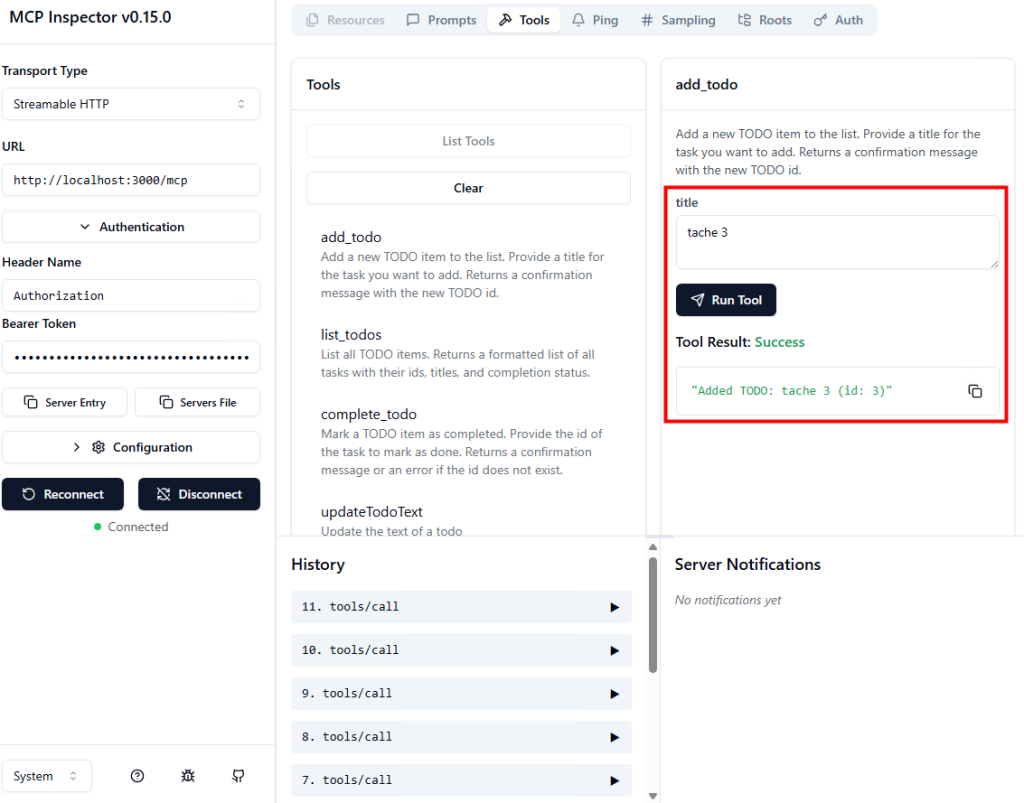

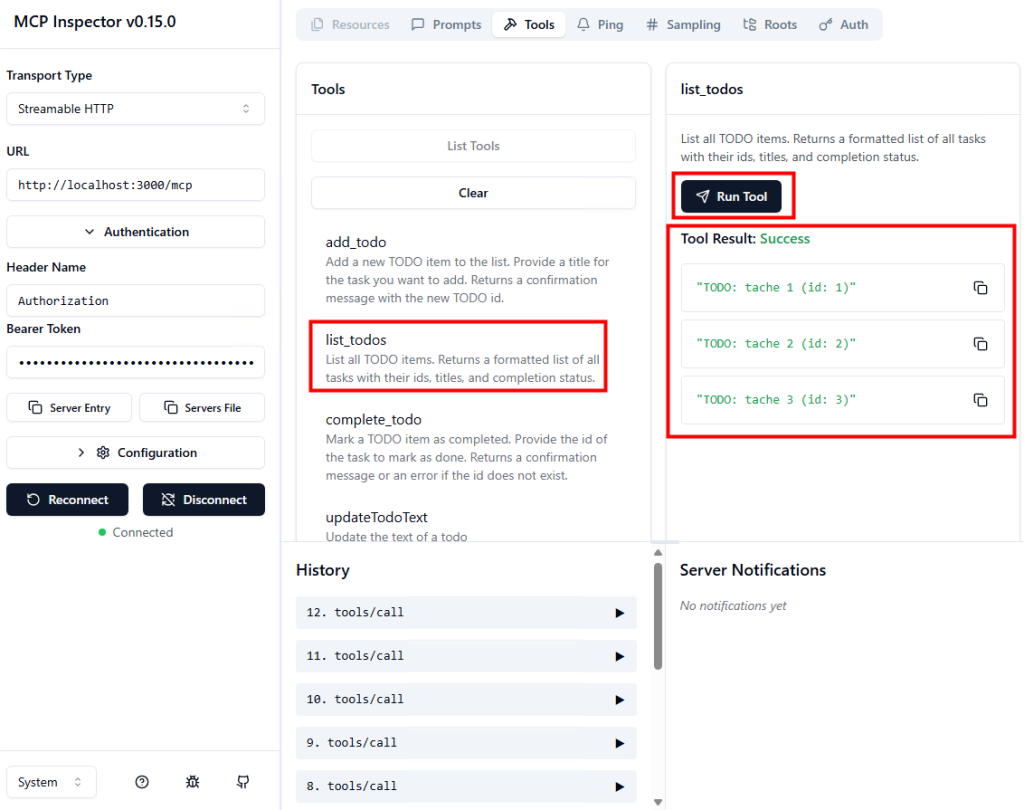

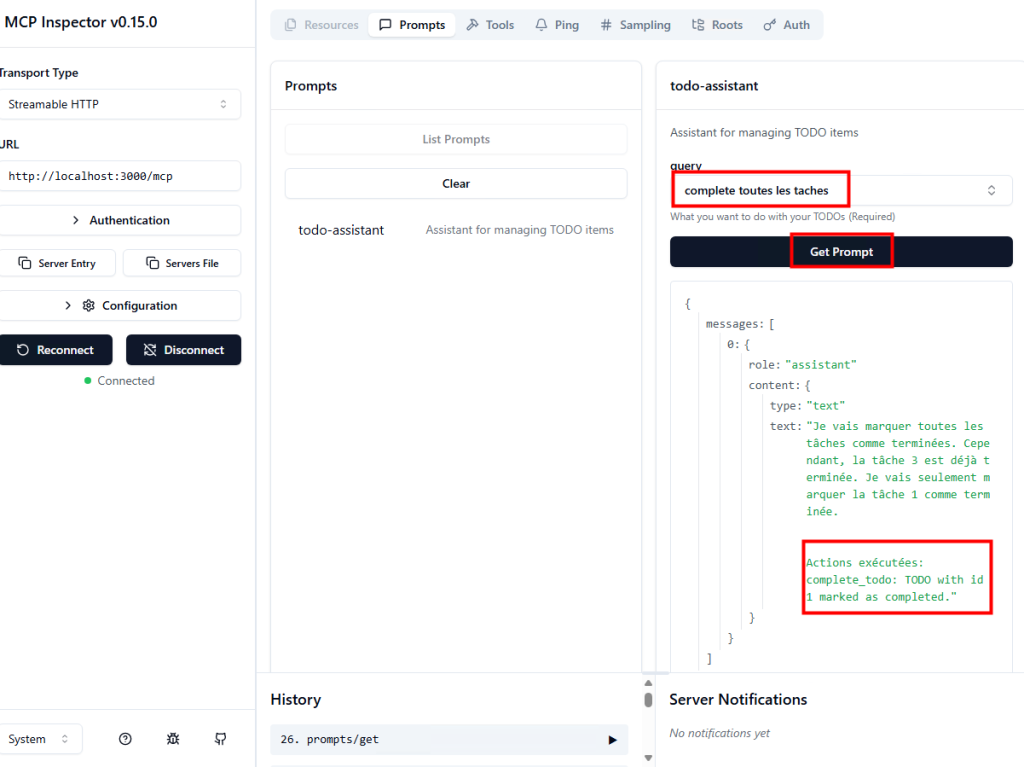

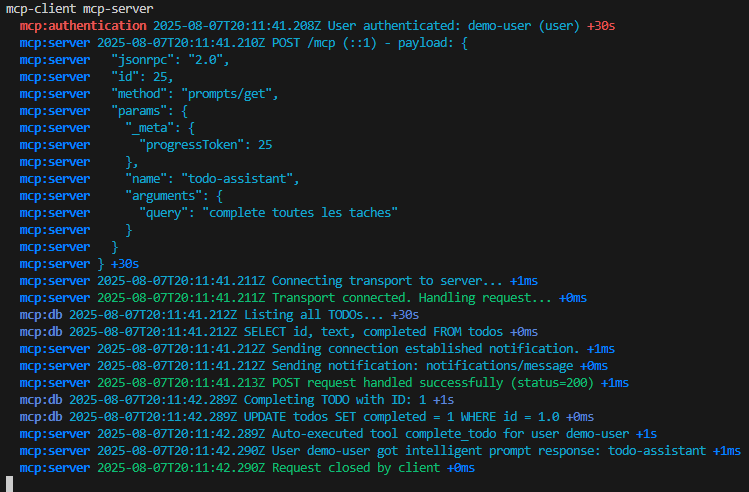

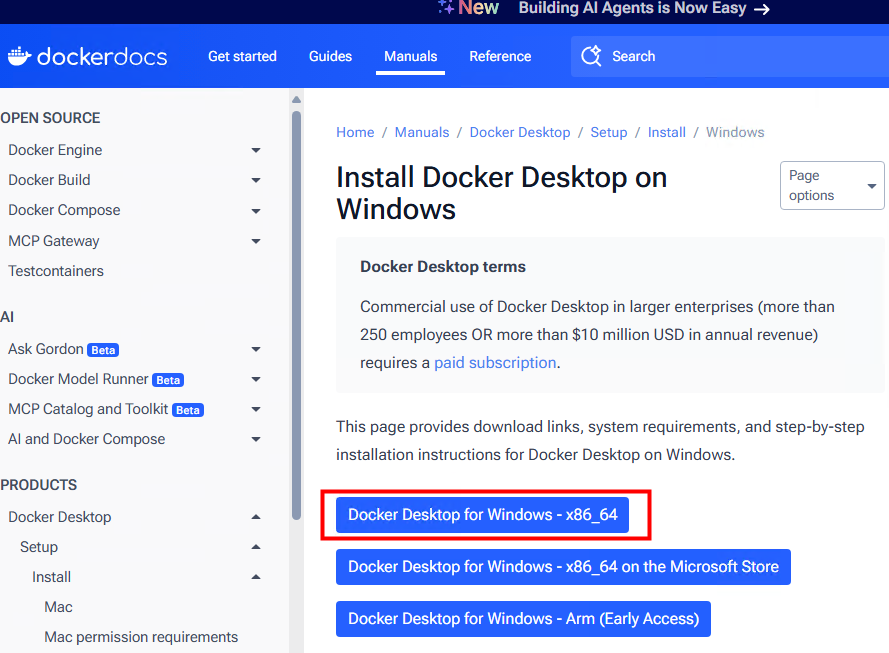

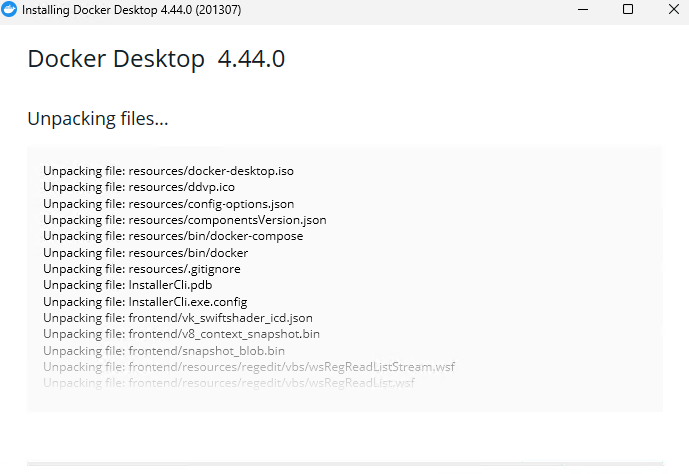

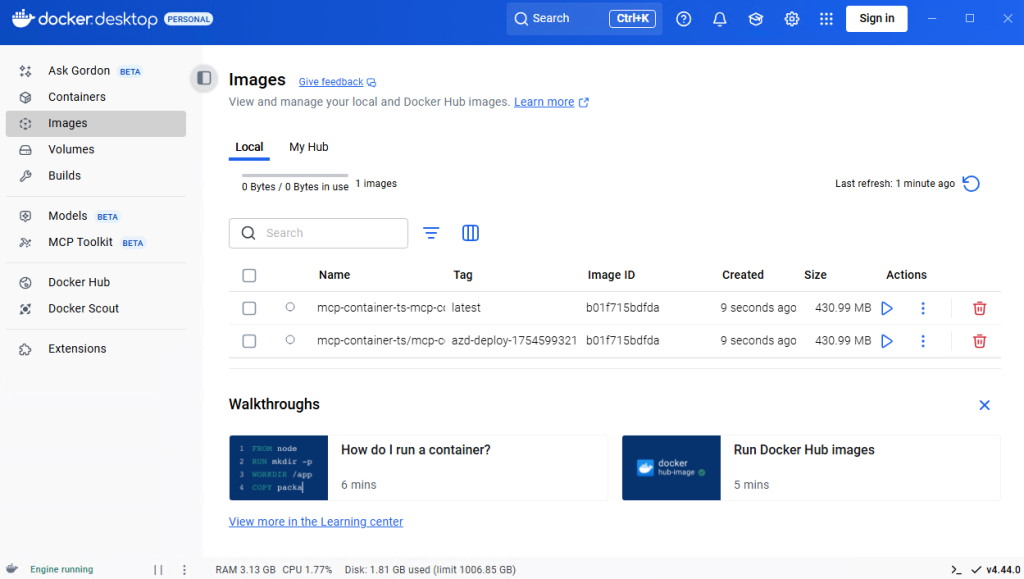

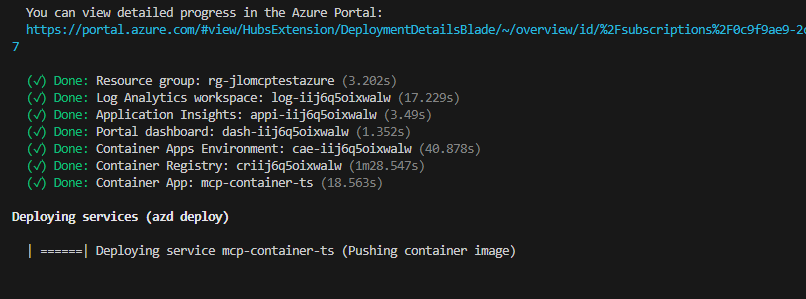

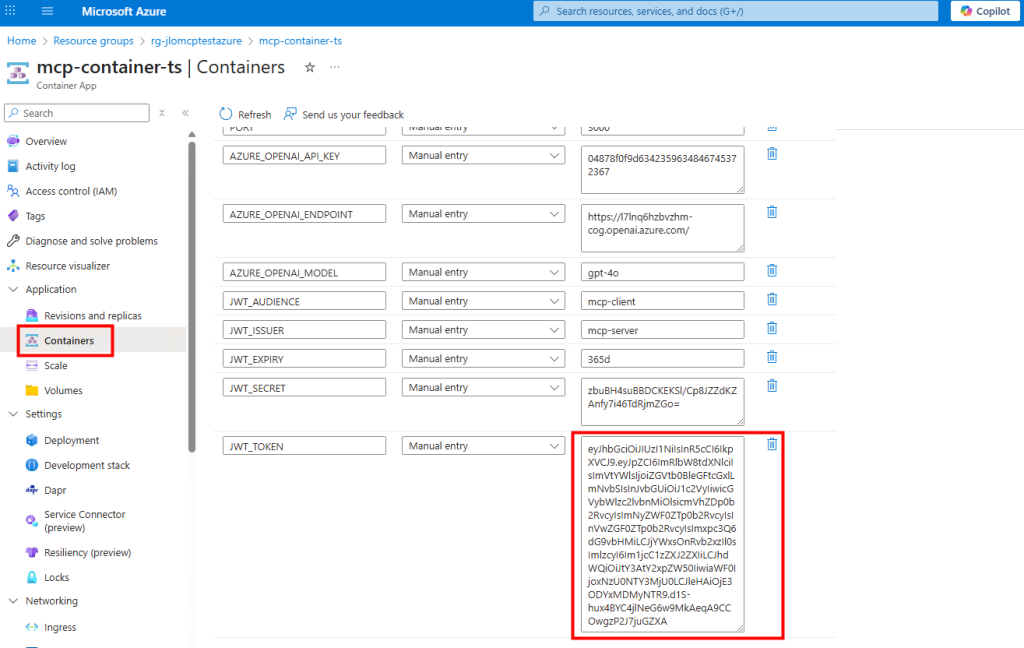

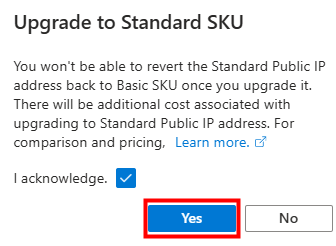

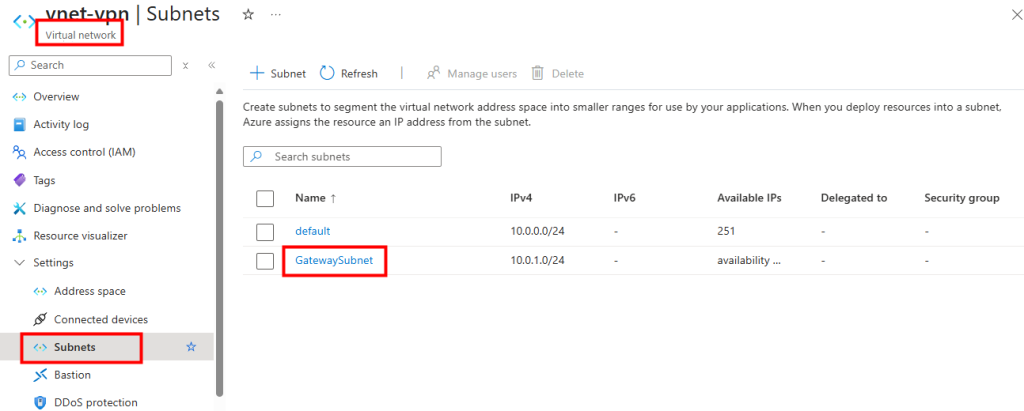

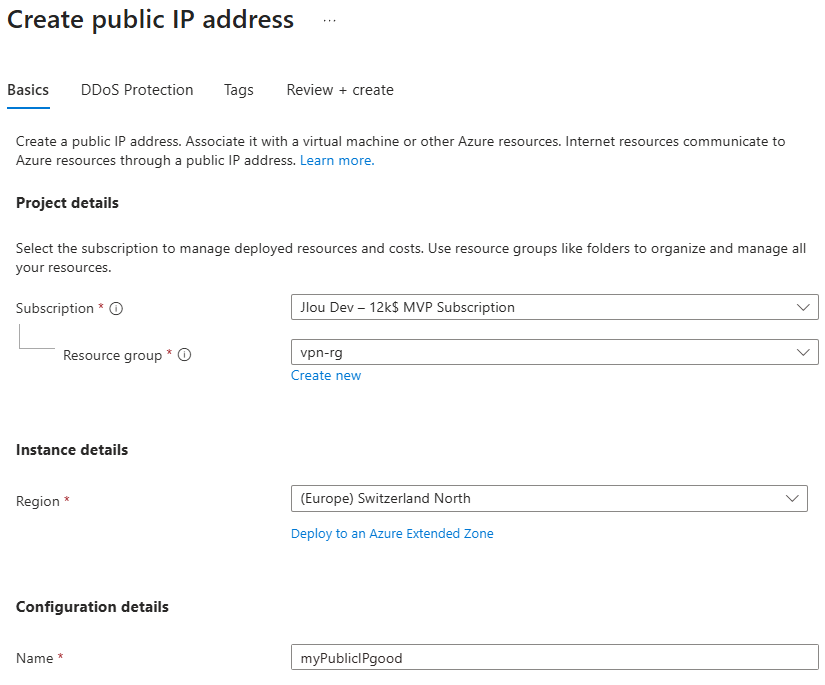

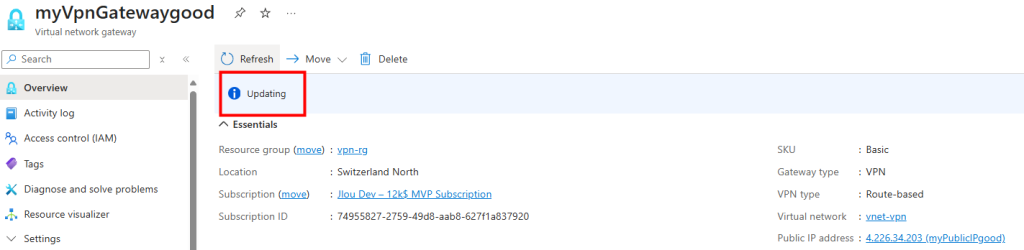

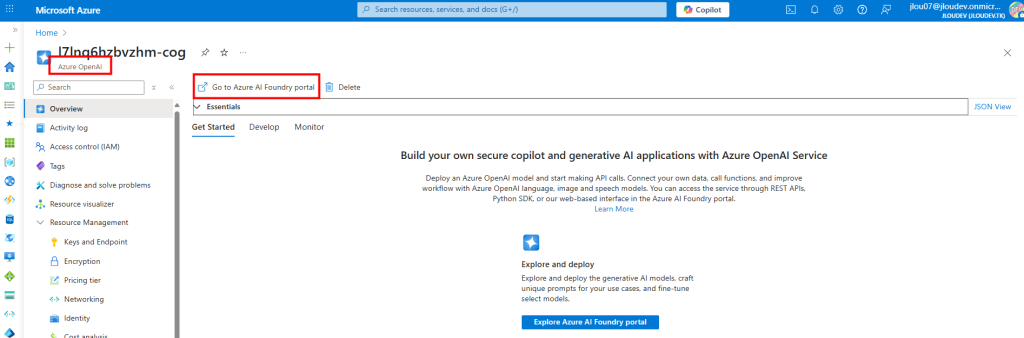

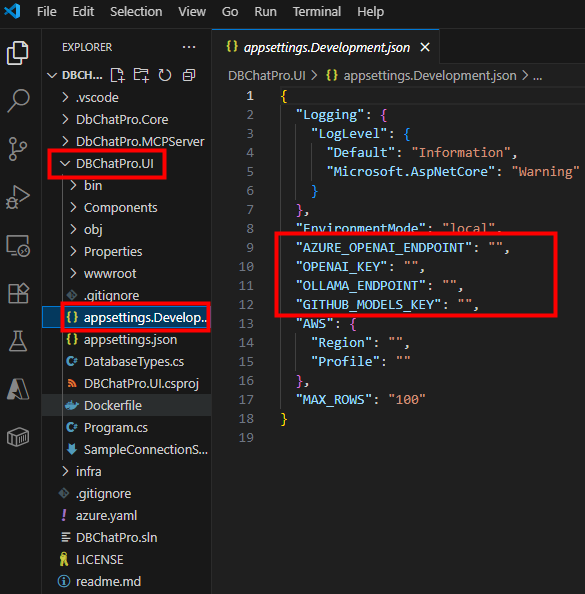

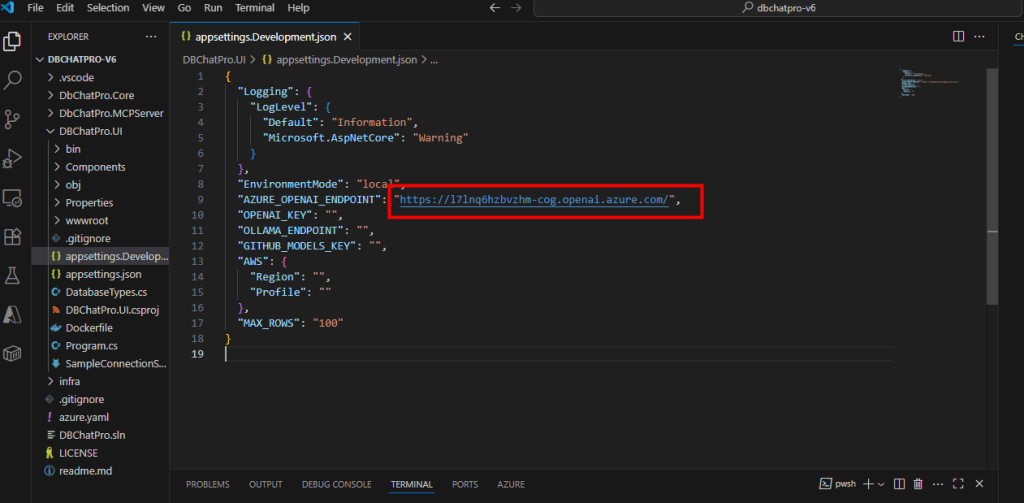

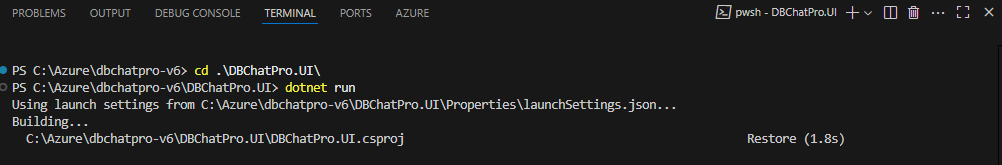

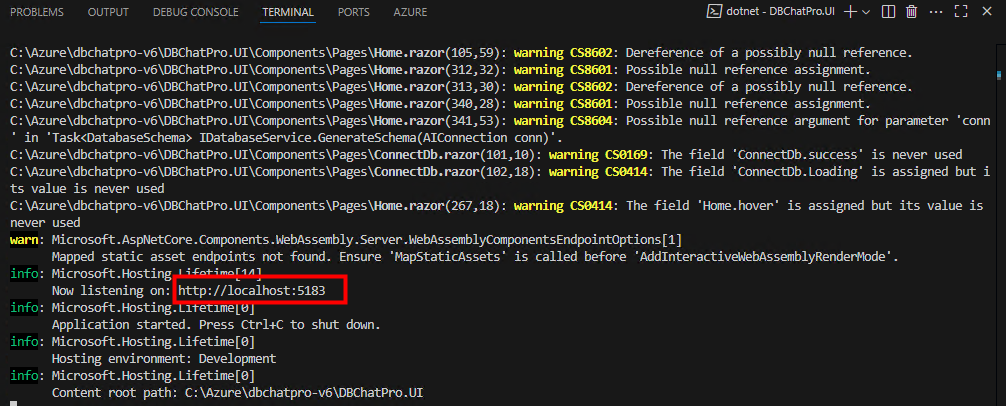

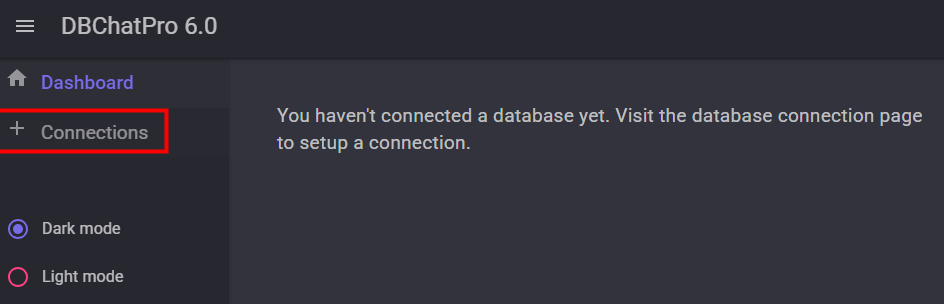

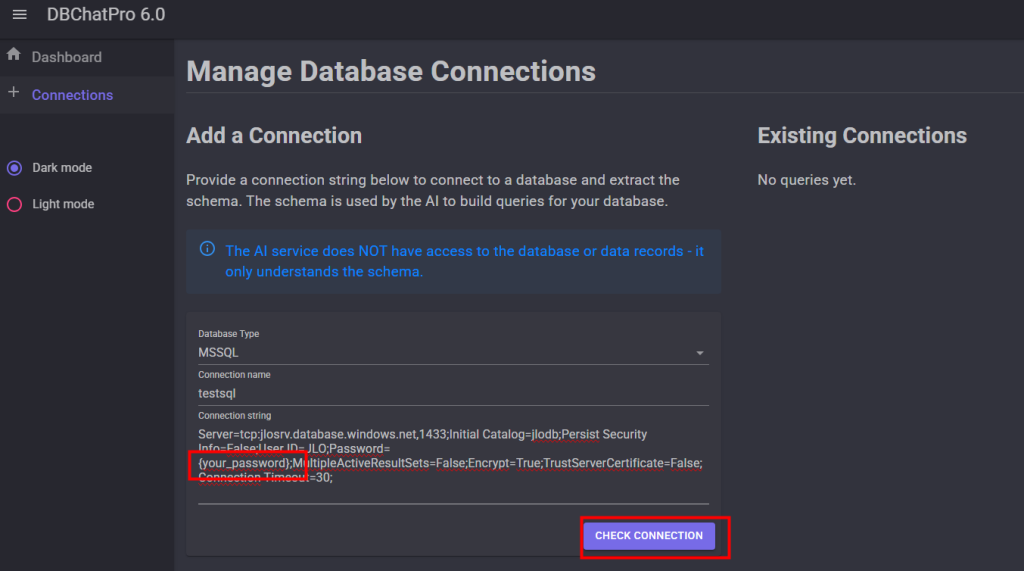

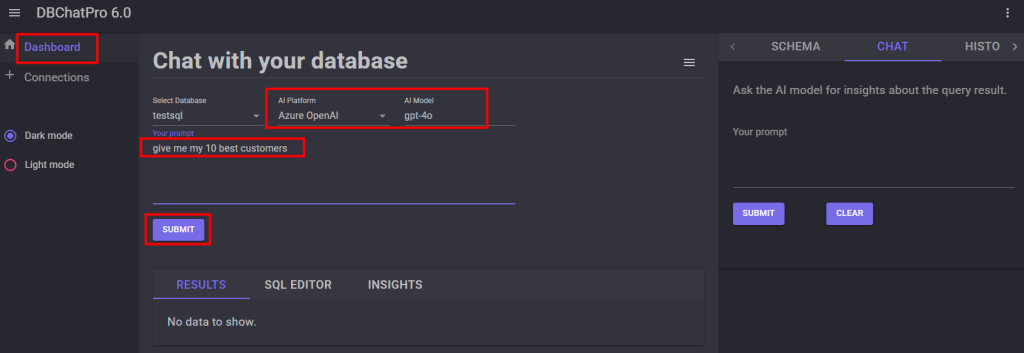

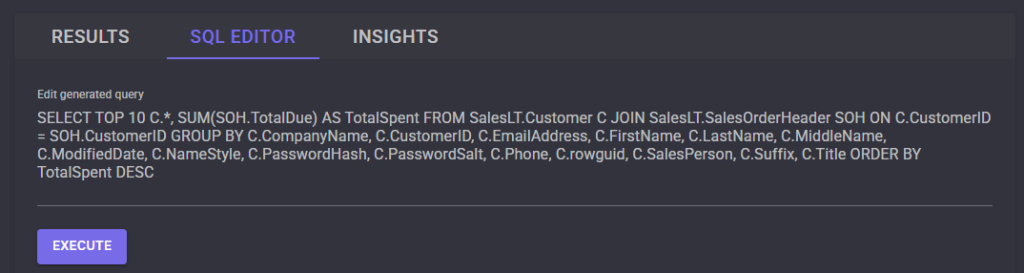

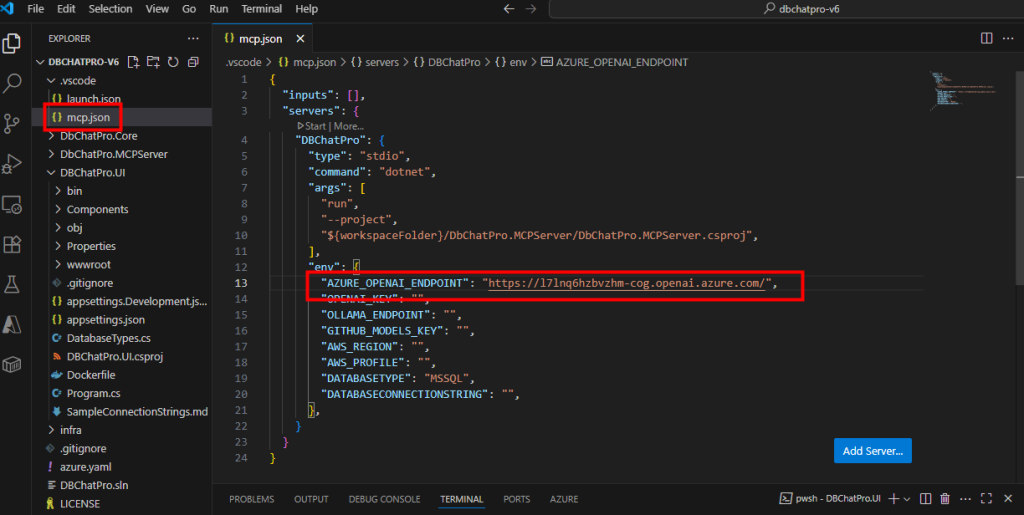

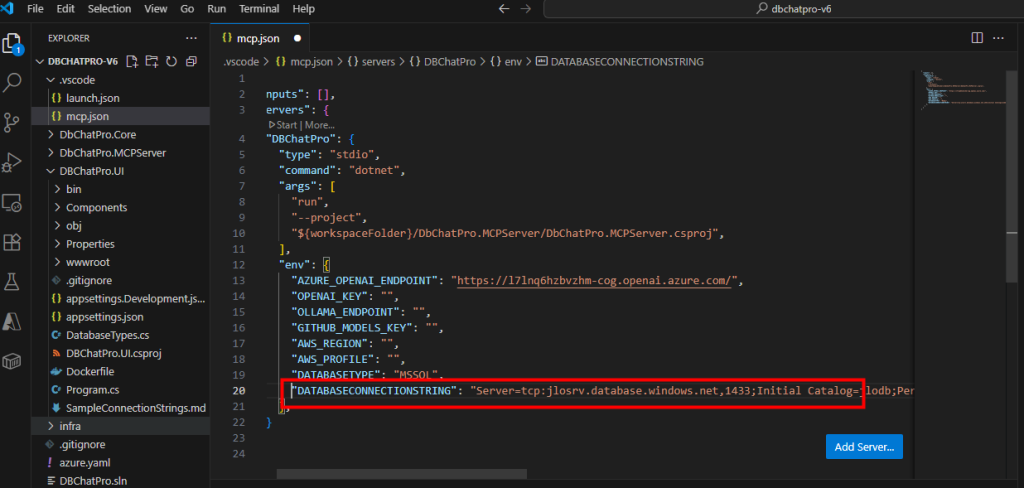

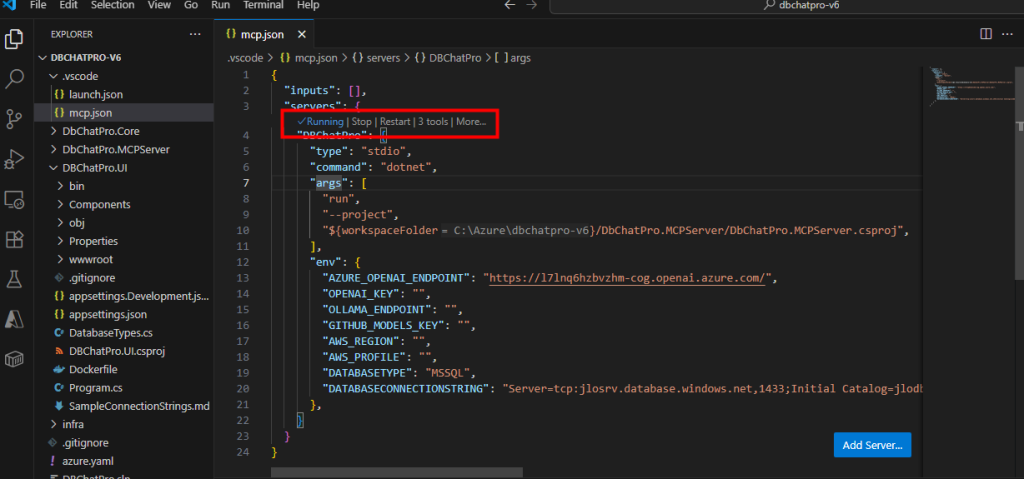

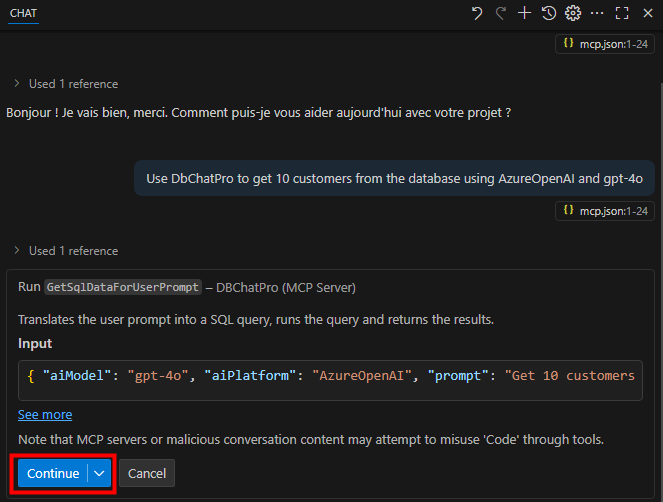

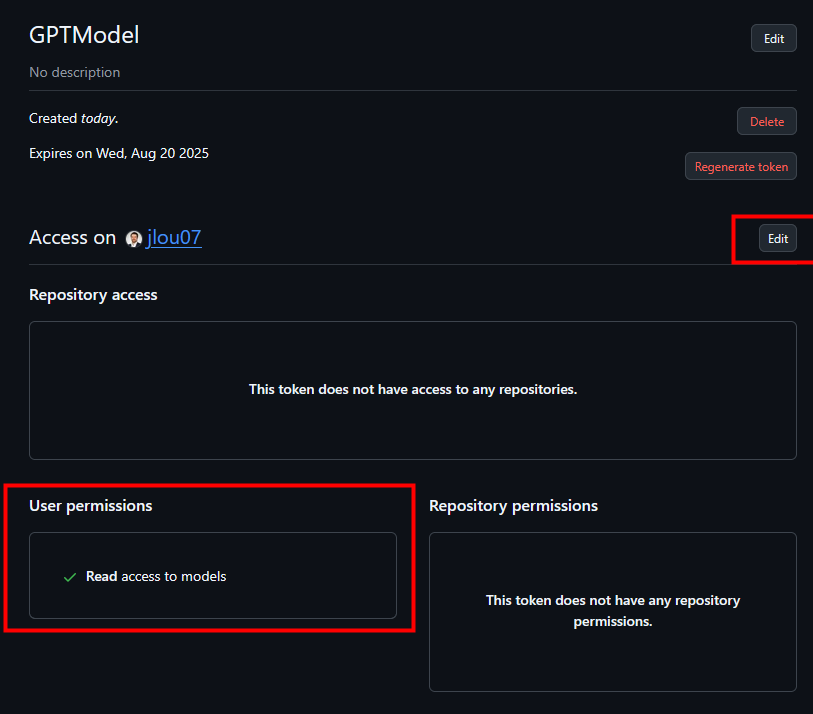

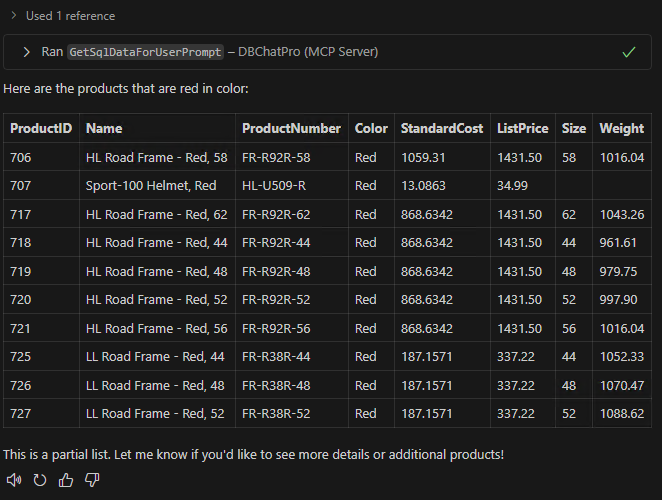

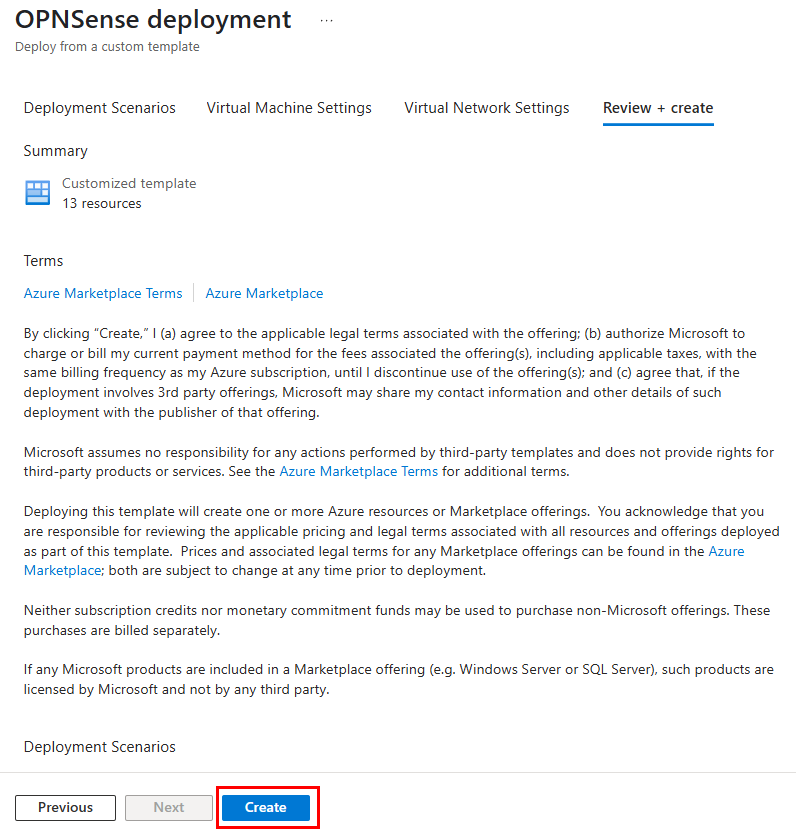

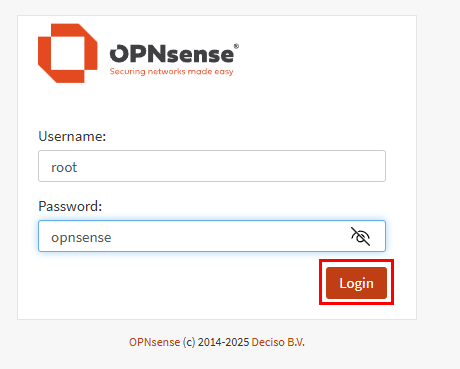

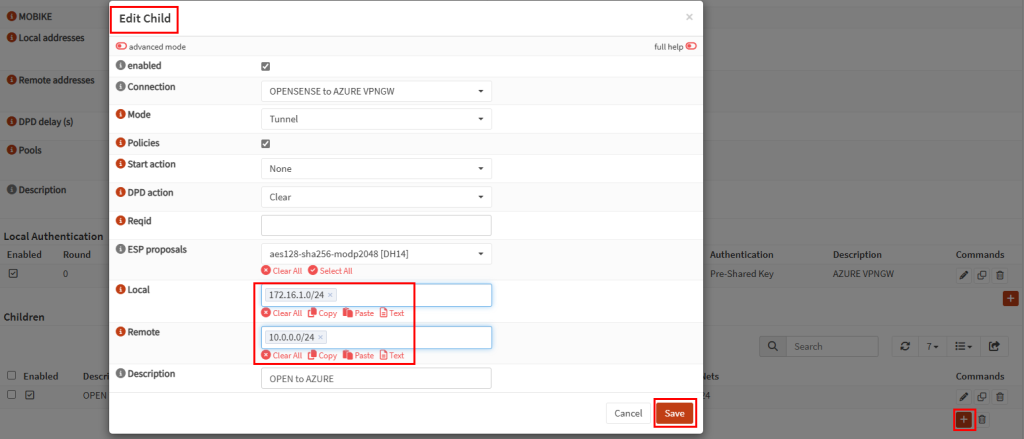

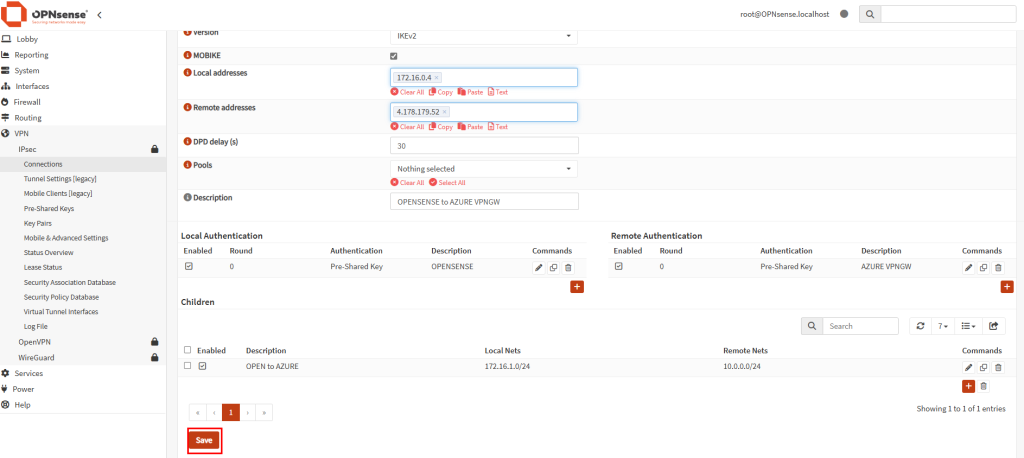

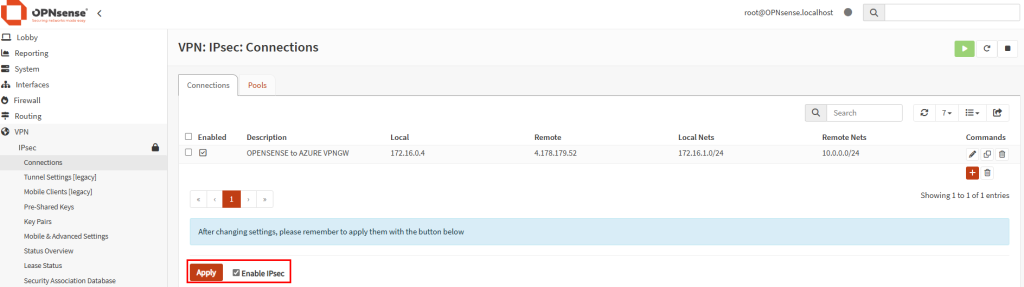

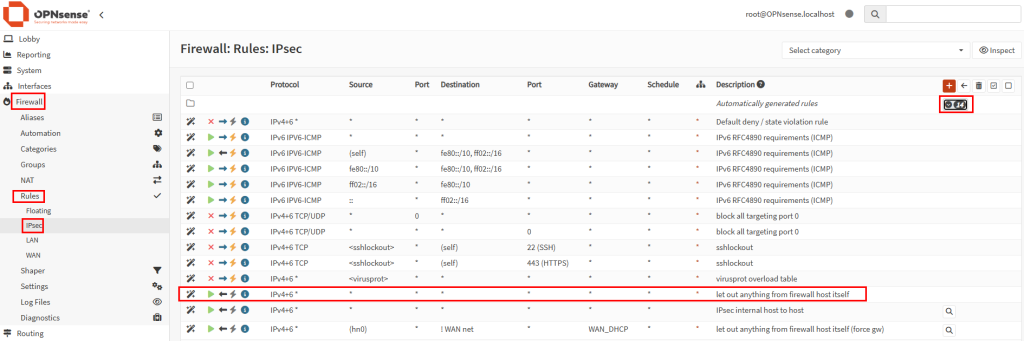

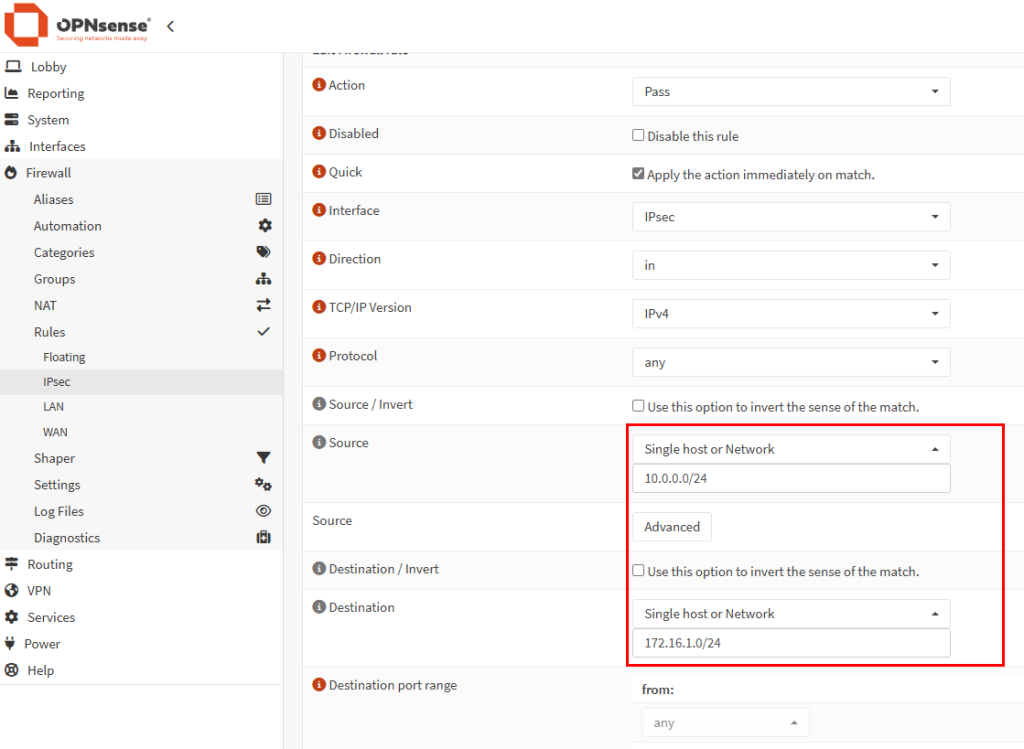

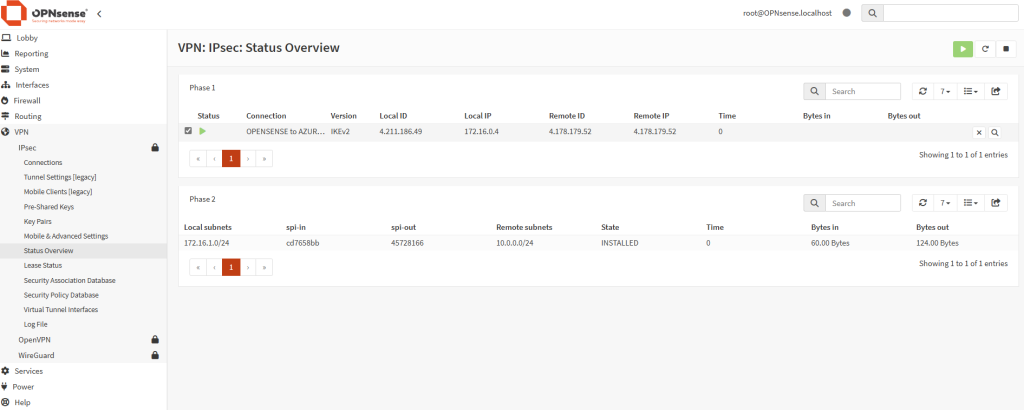

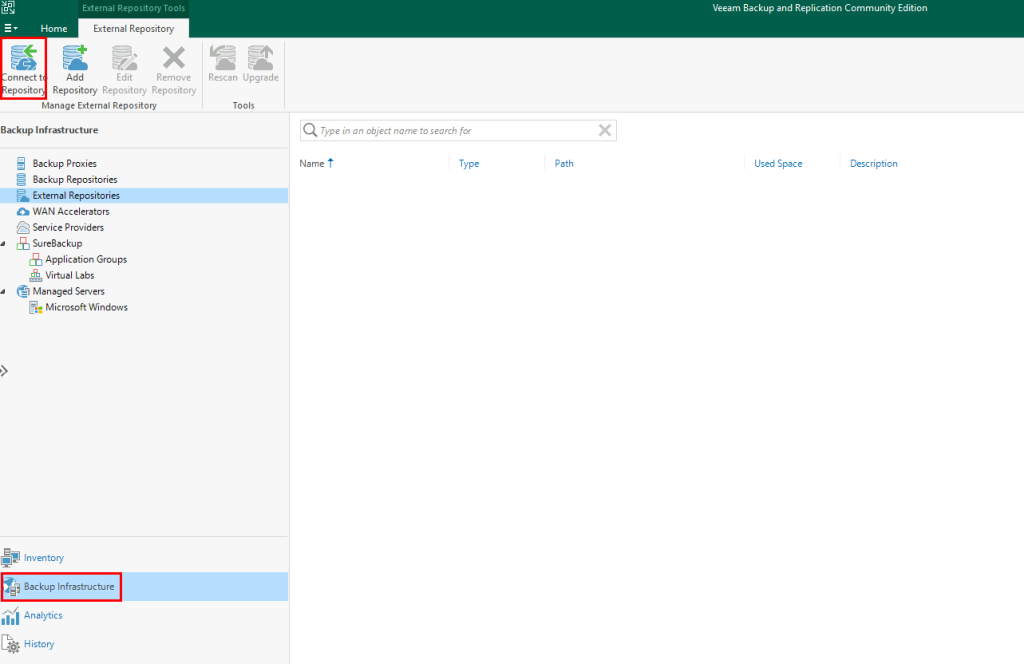

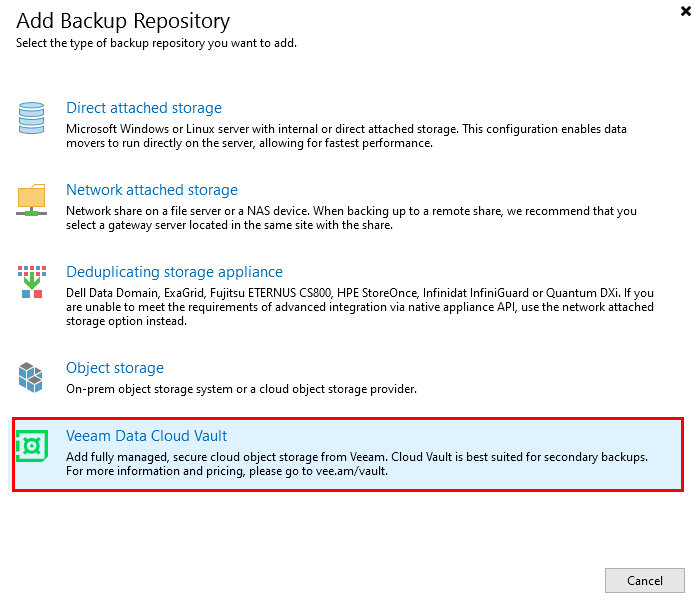

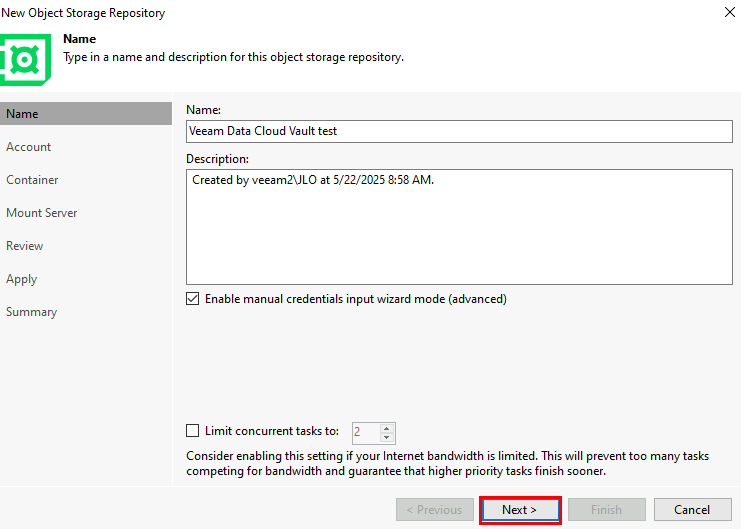

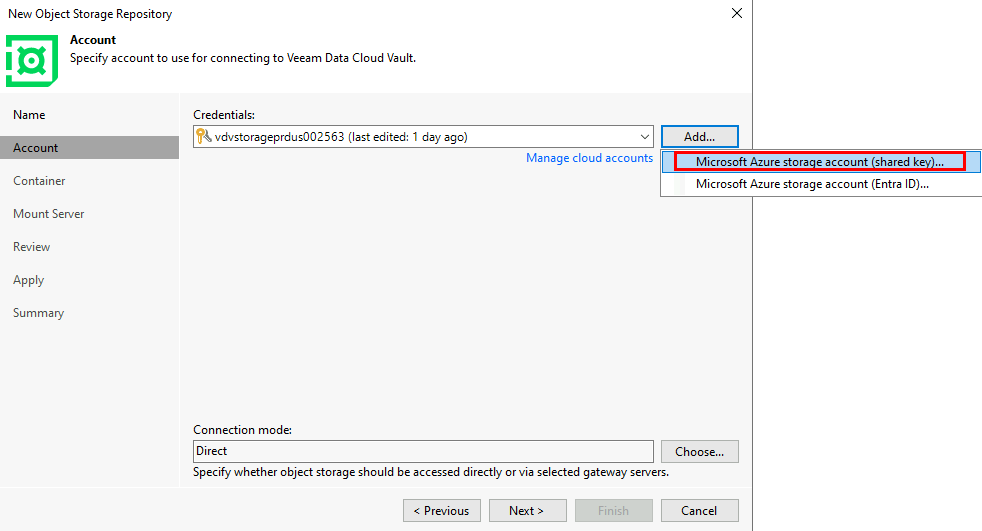

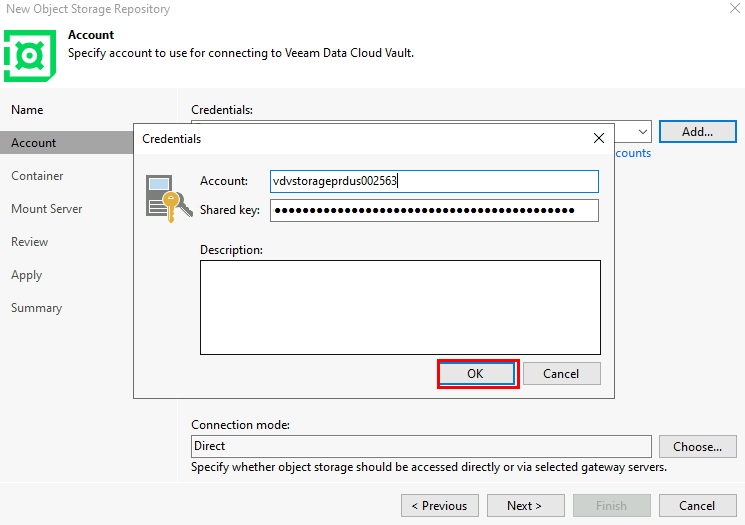

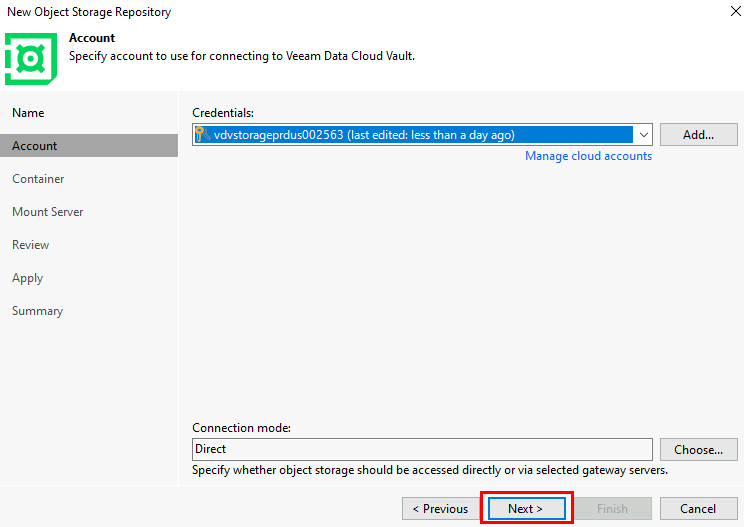

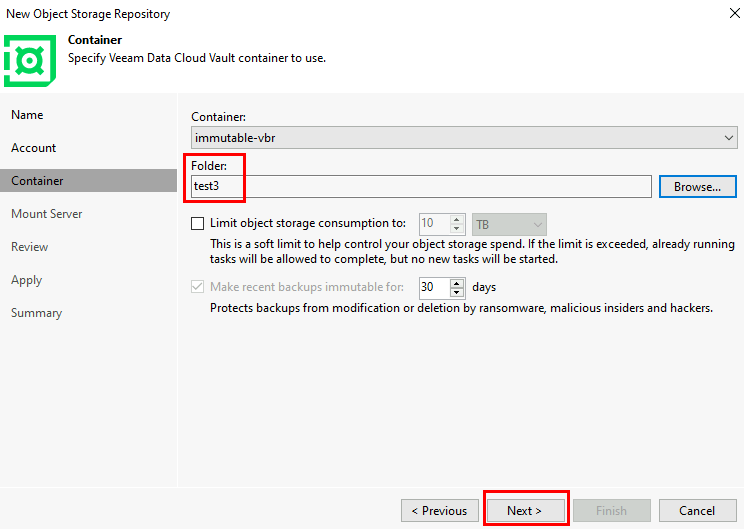

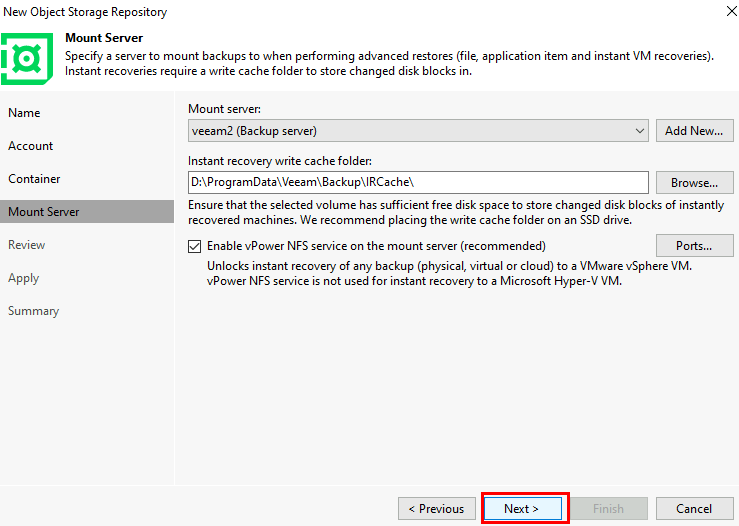

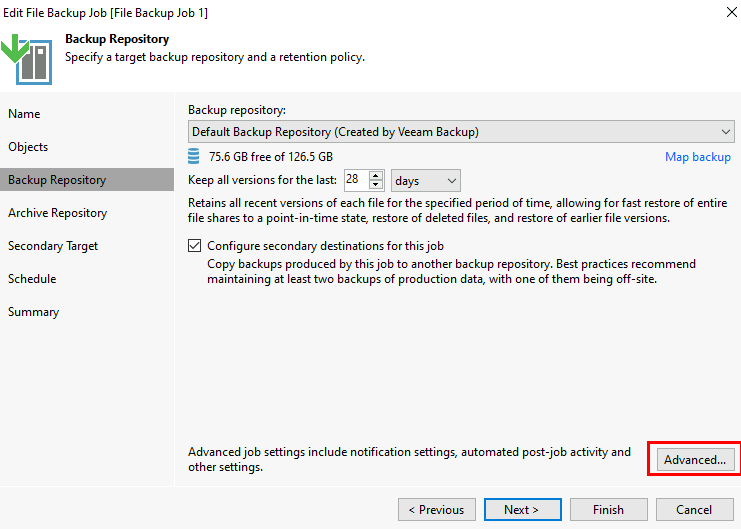

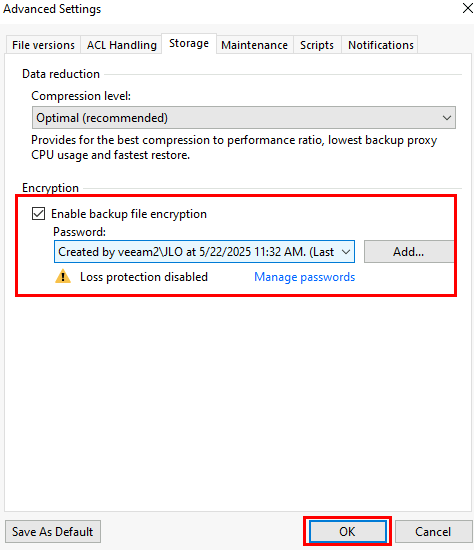

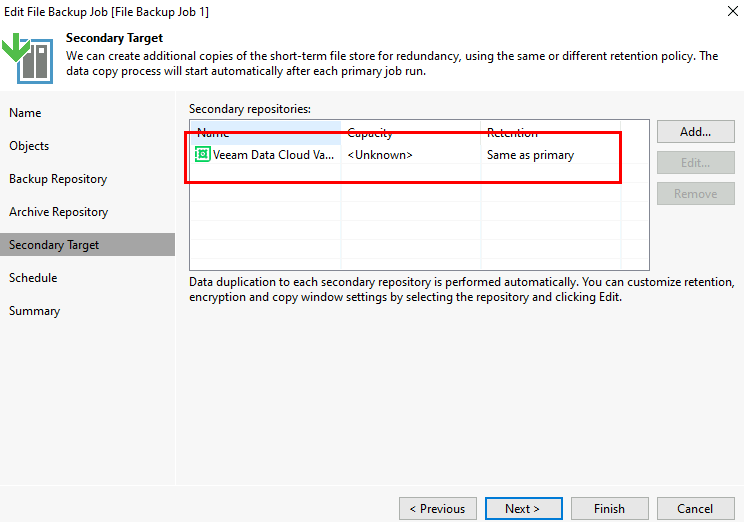

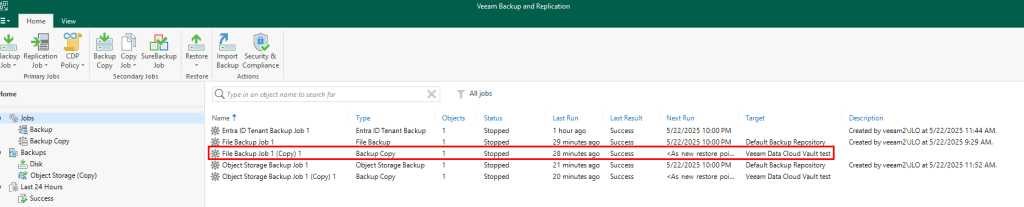

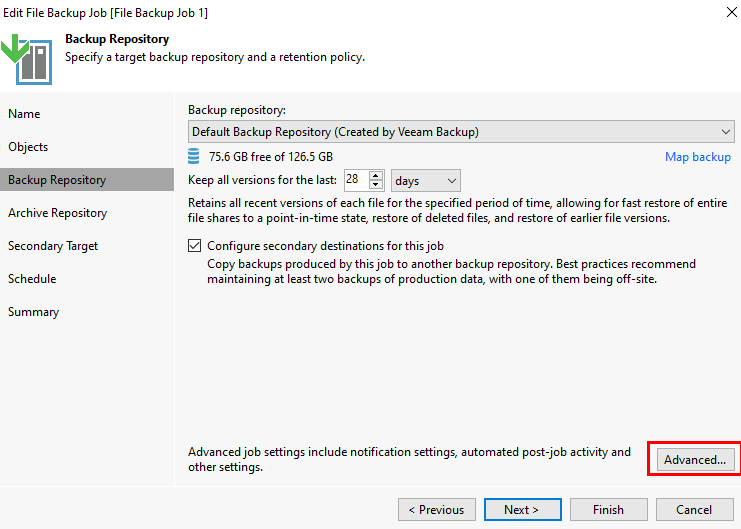

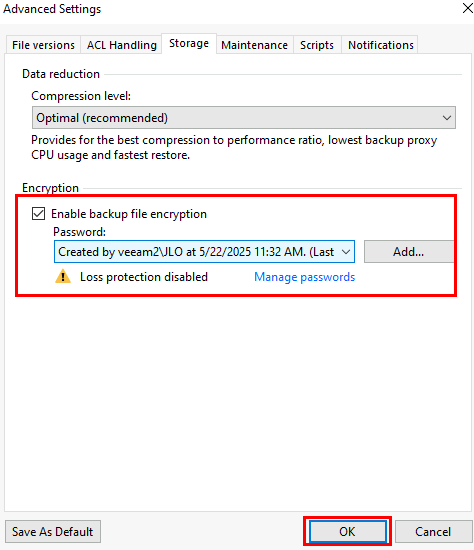

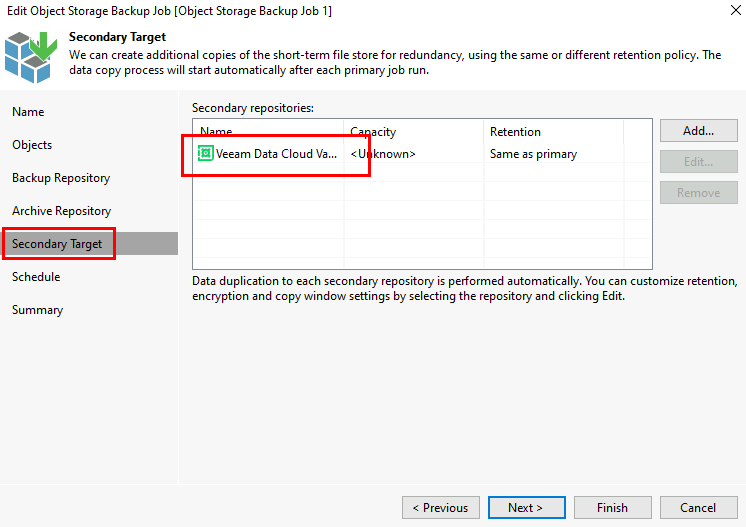

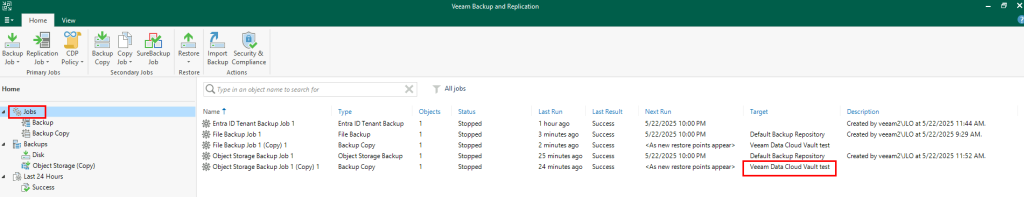

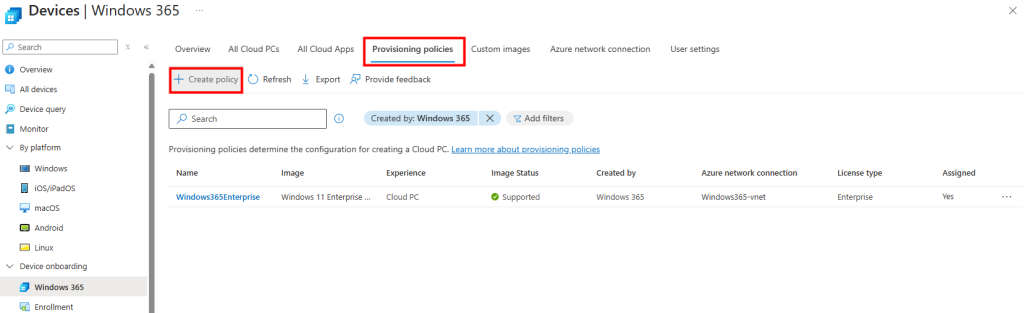

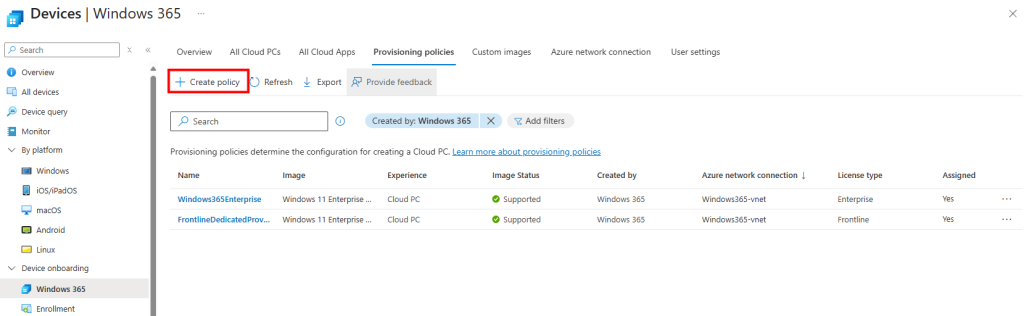

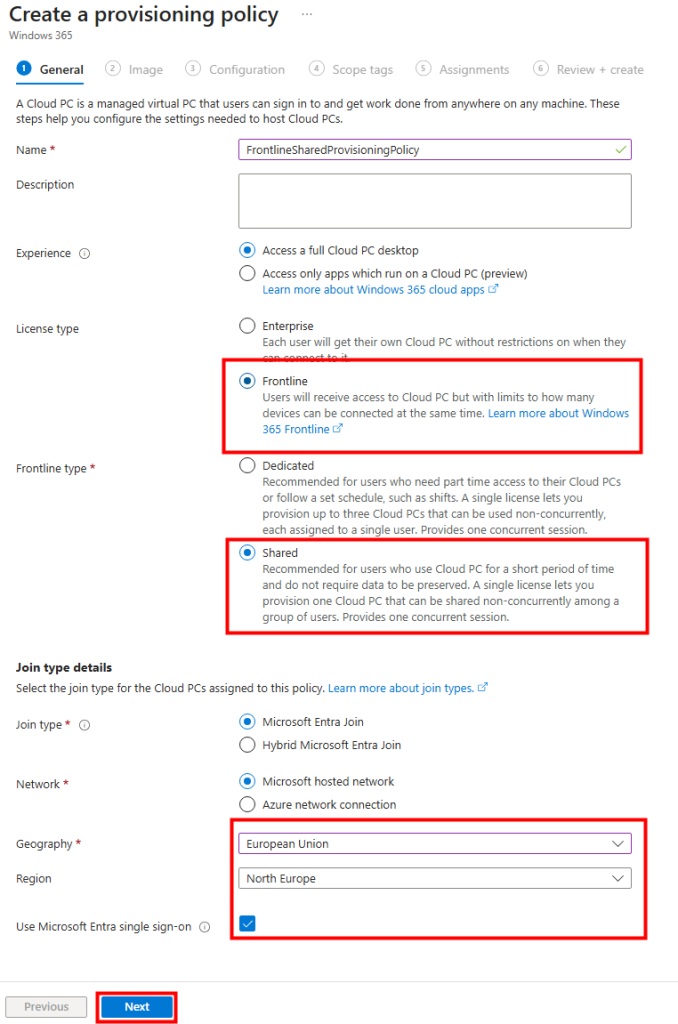

Sur le portail Intune, dans la section Polices de provisionnement de Windows 365, je crée une nouvelle police :

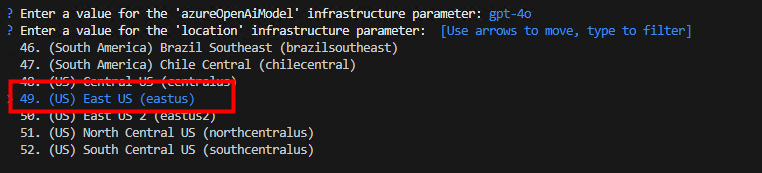

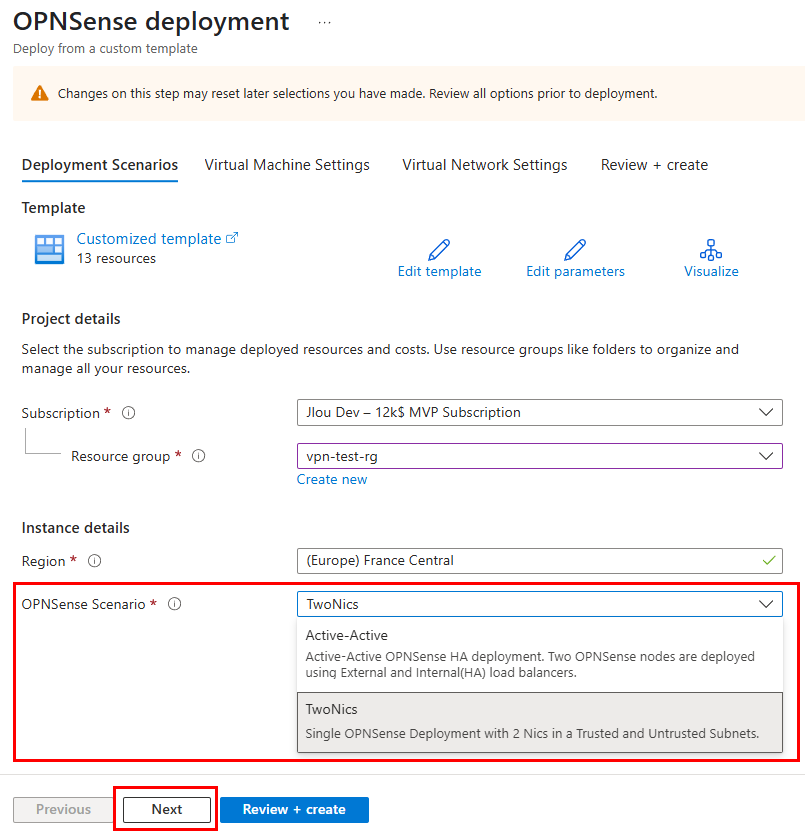

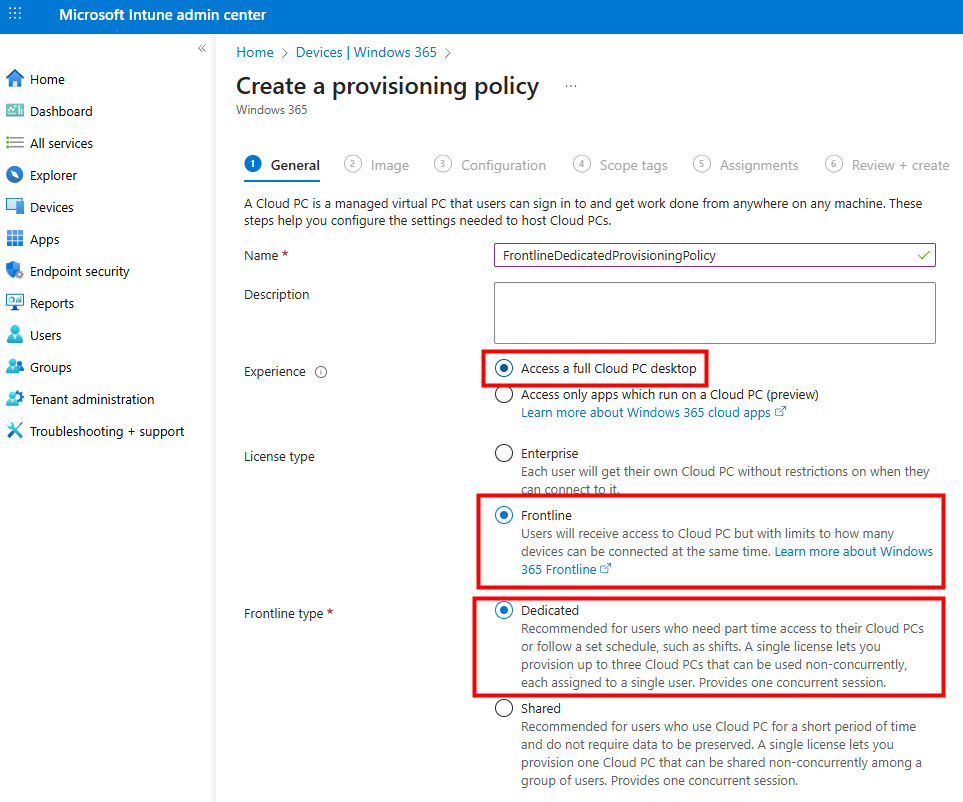

Je nomme ma stratégie, je sélectionne le type Frontline et le mode Dedicated :

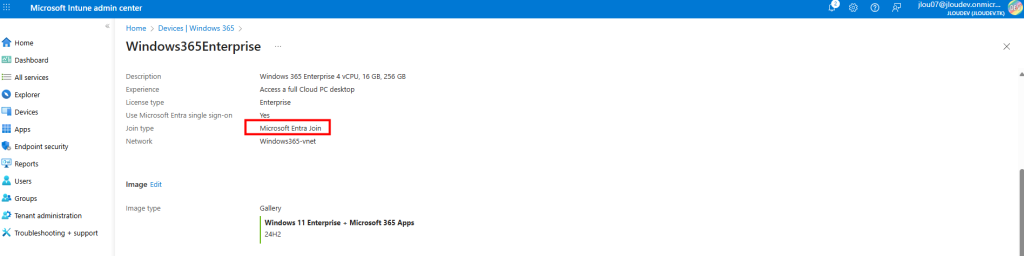

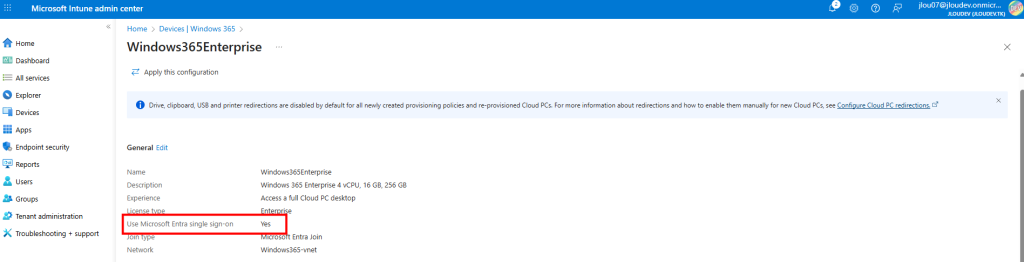

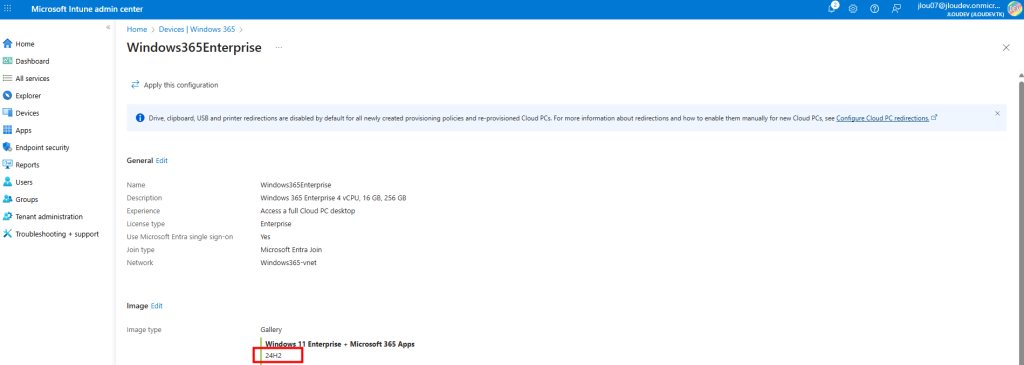

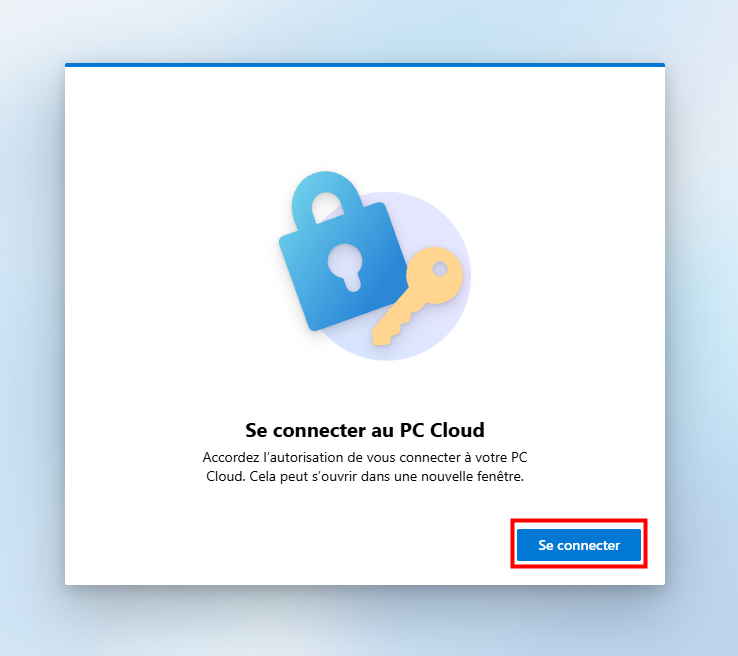

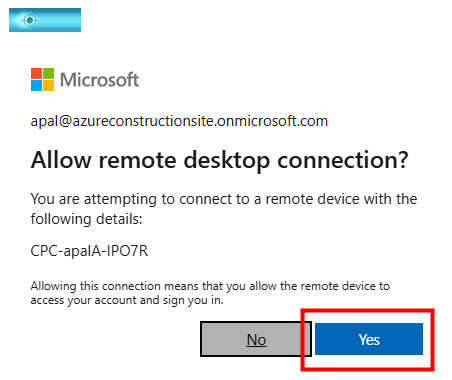

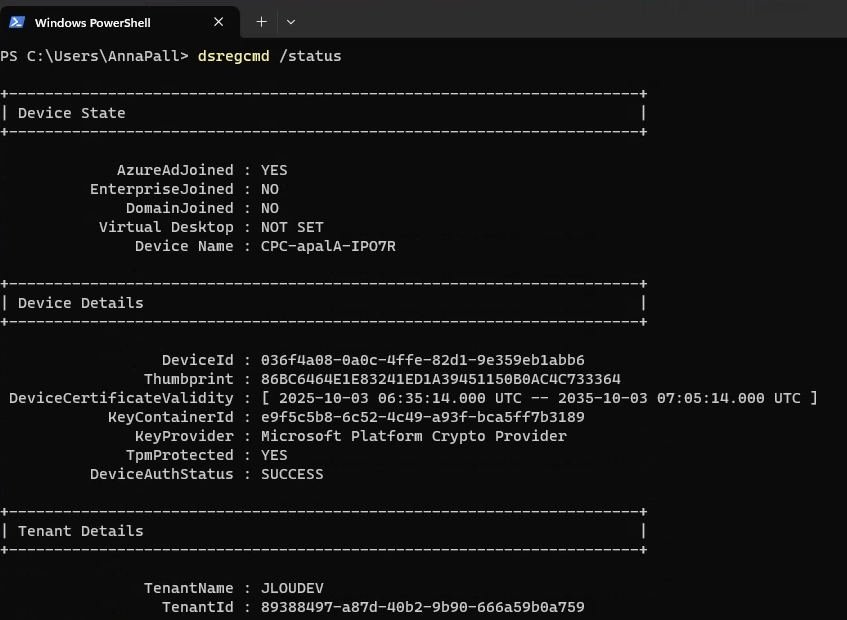

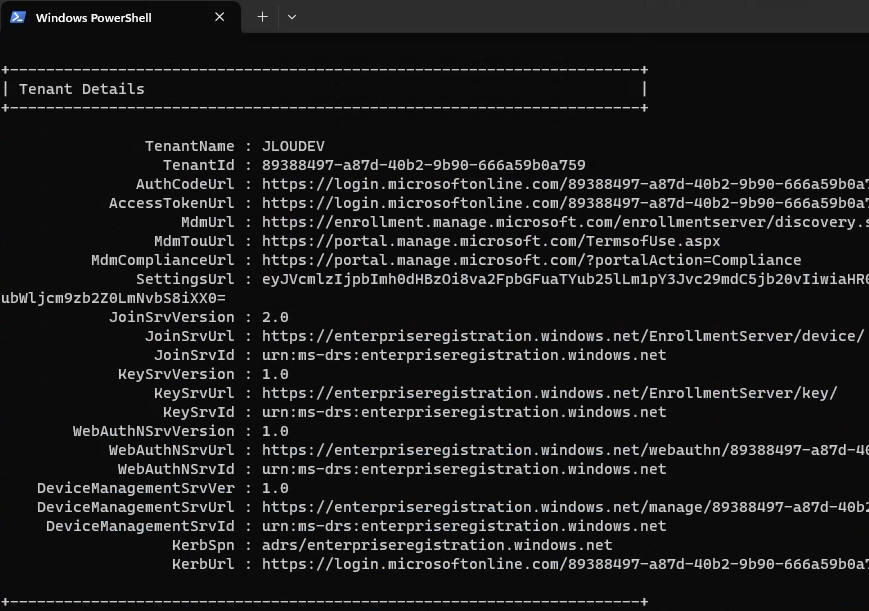

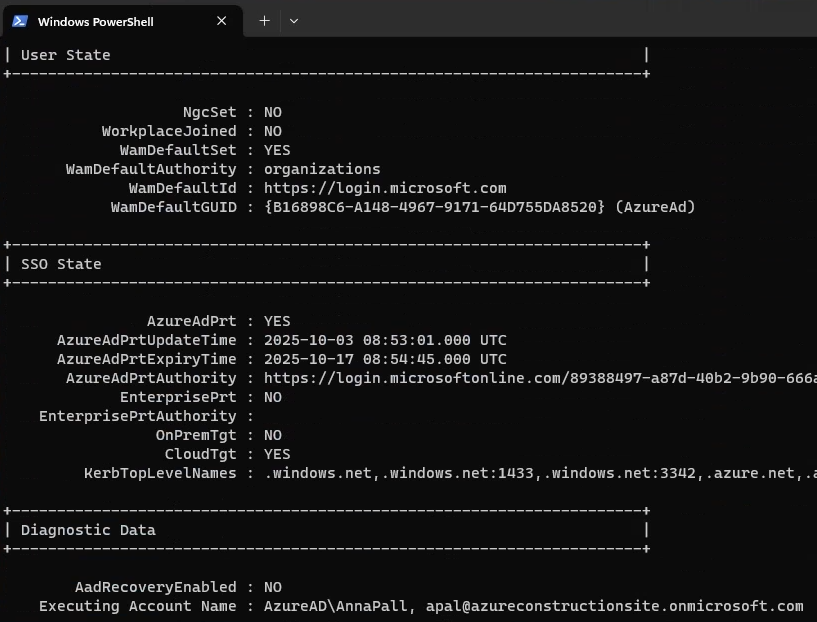

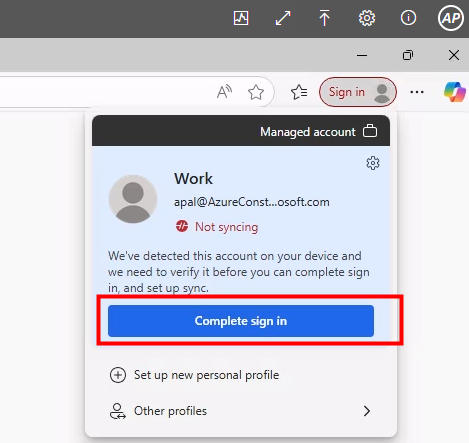

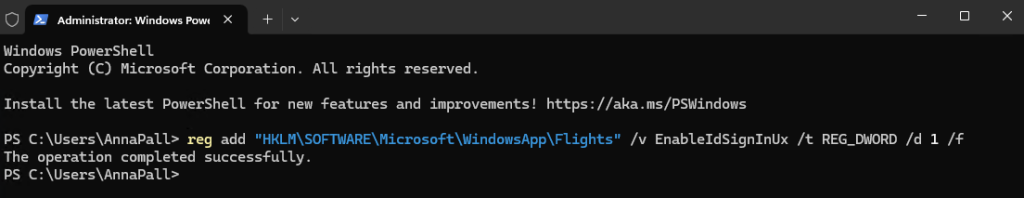

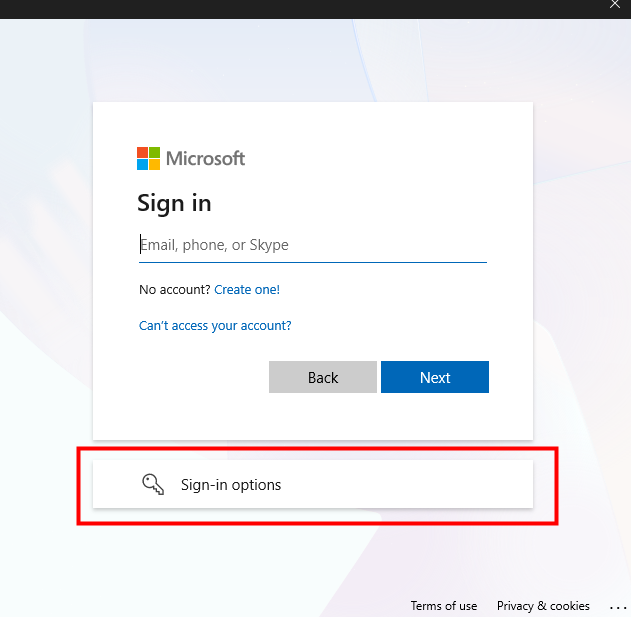

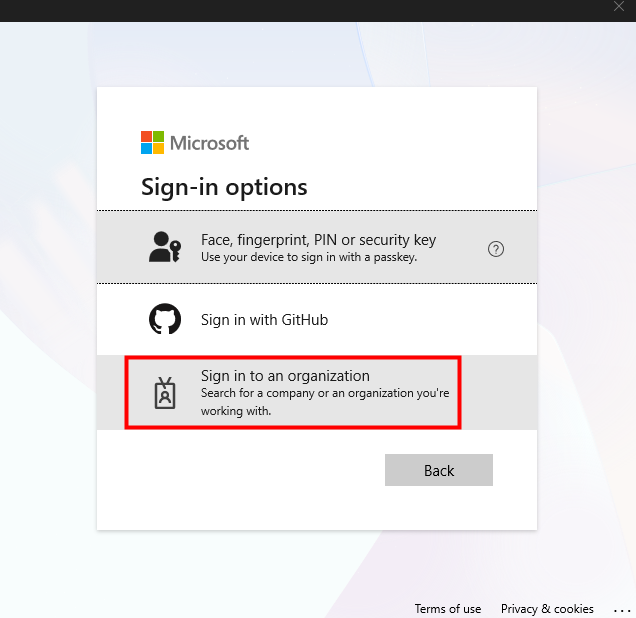

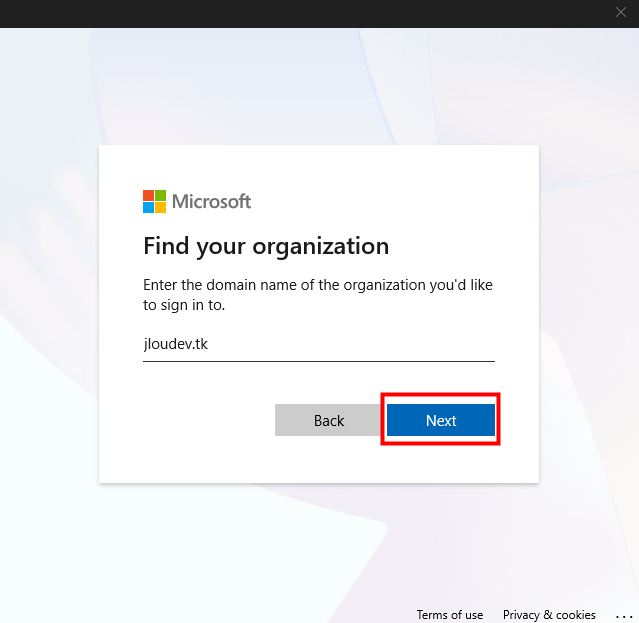

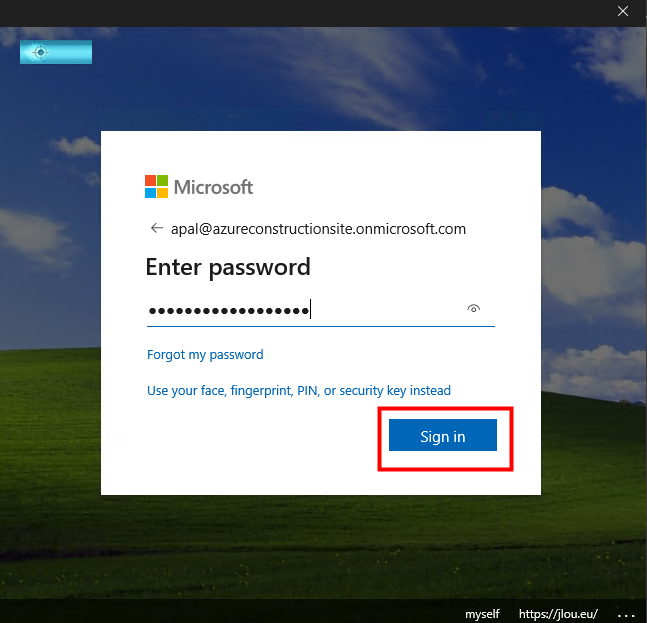

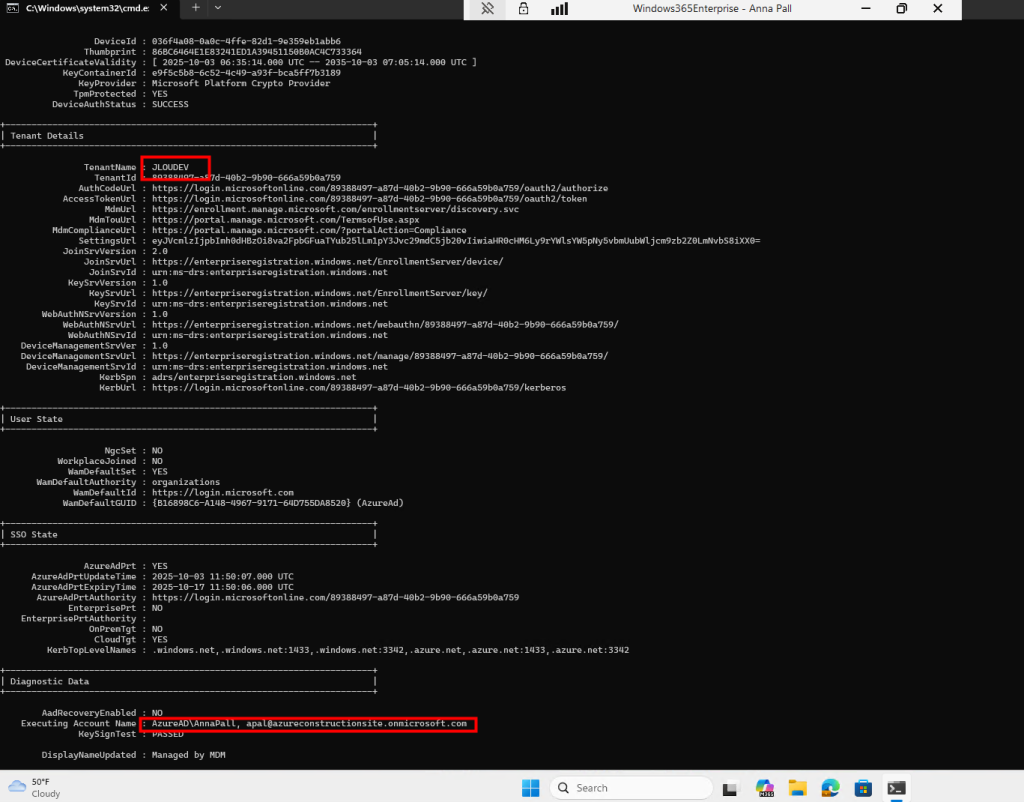

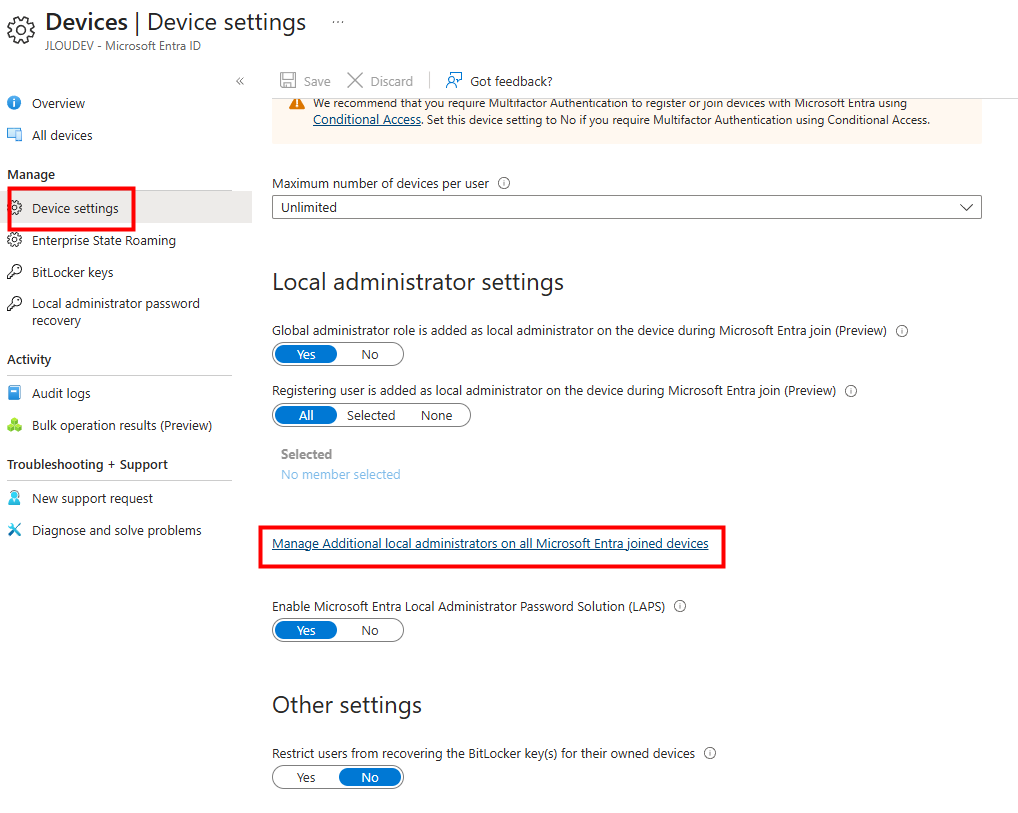

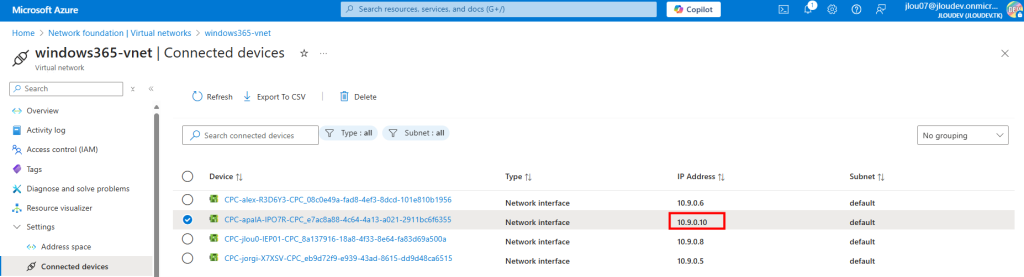

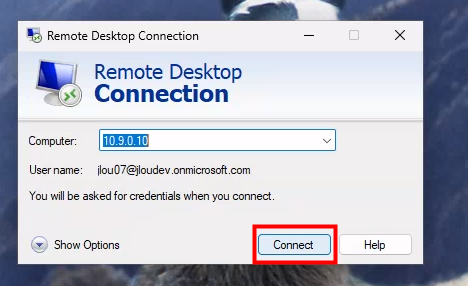

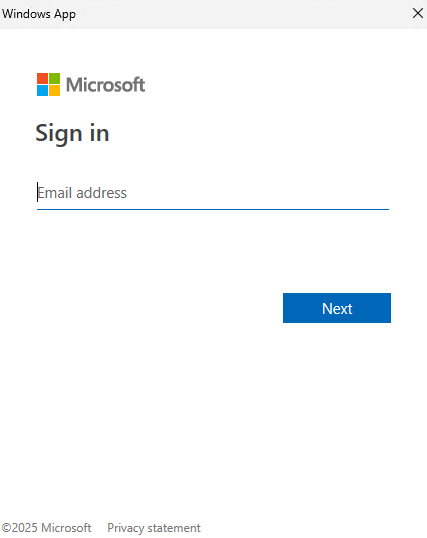

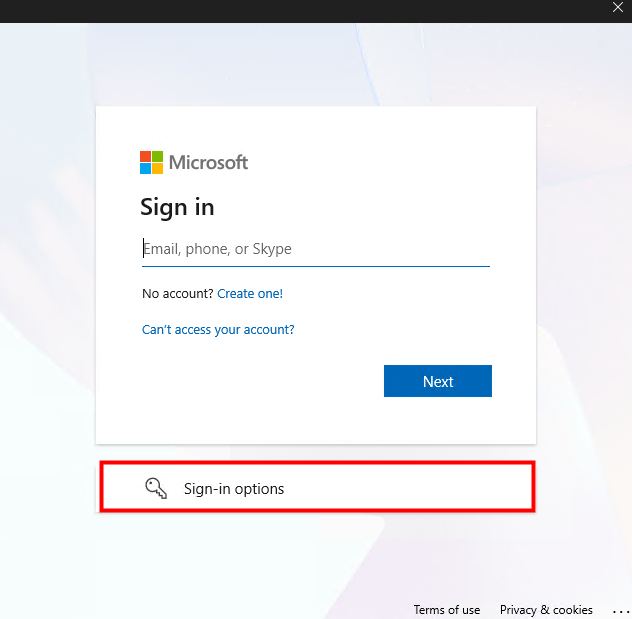

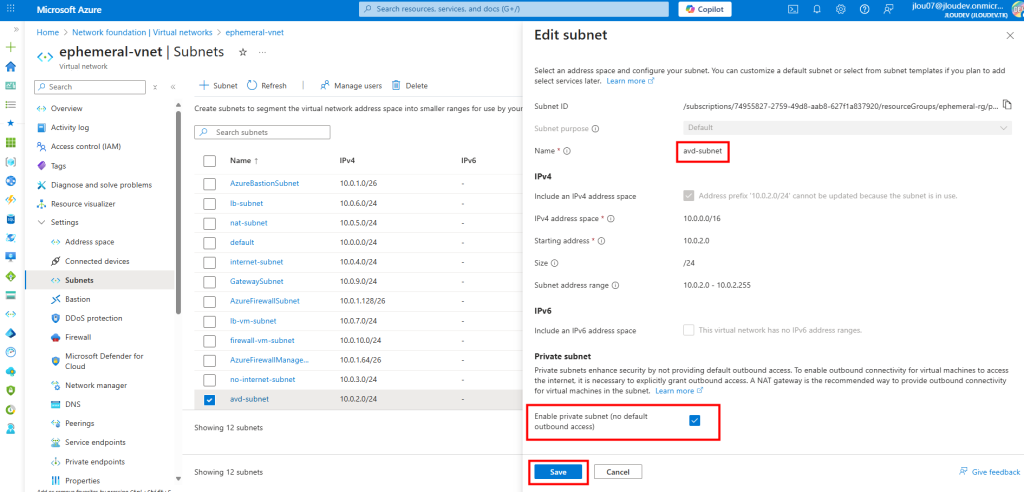

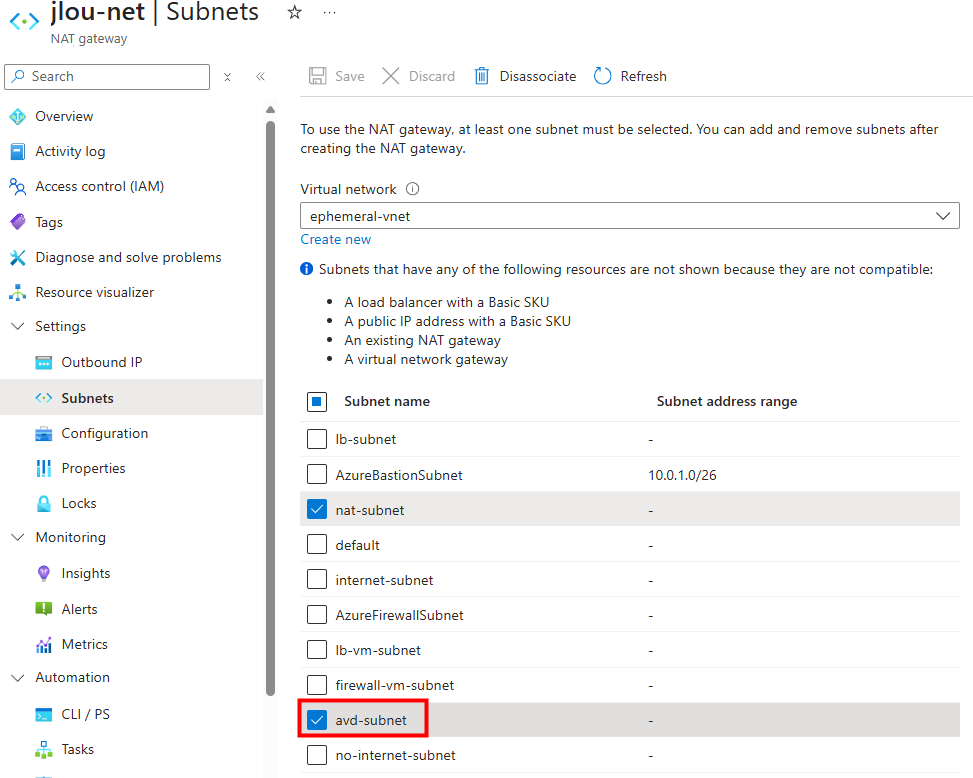

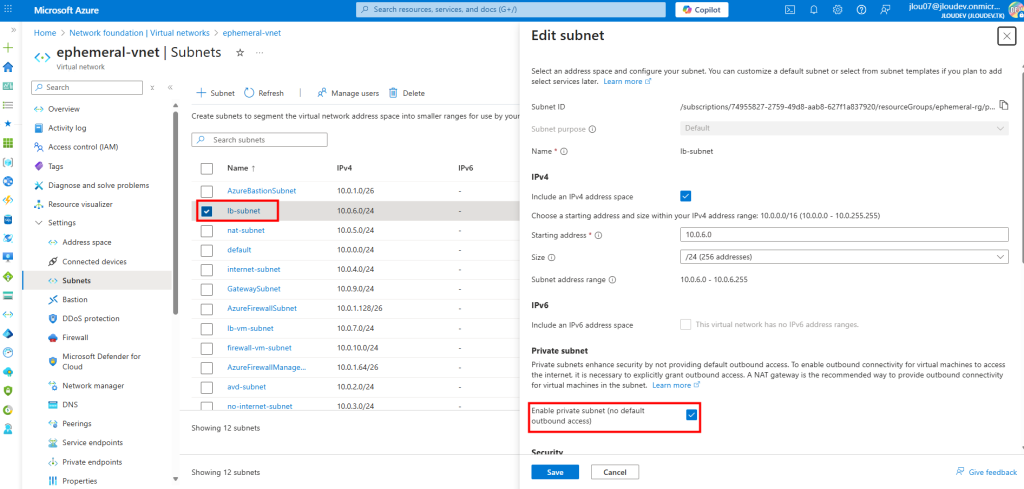

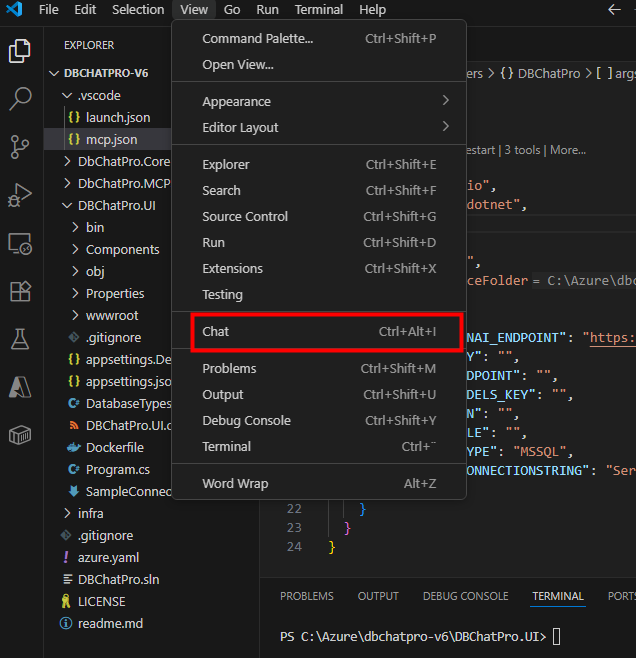

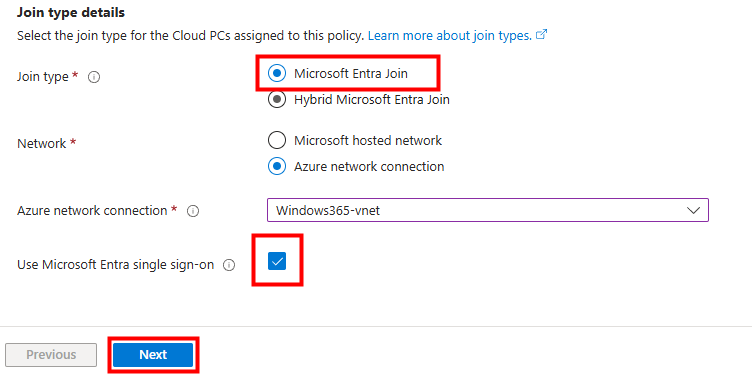

Je choisis la jointure Entra ID et j’active le Single Sign-On (SSO) :

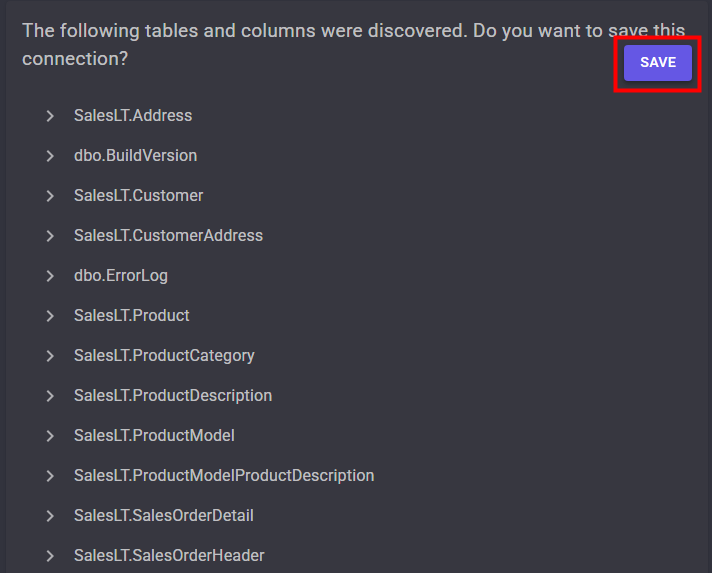

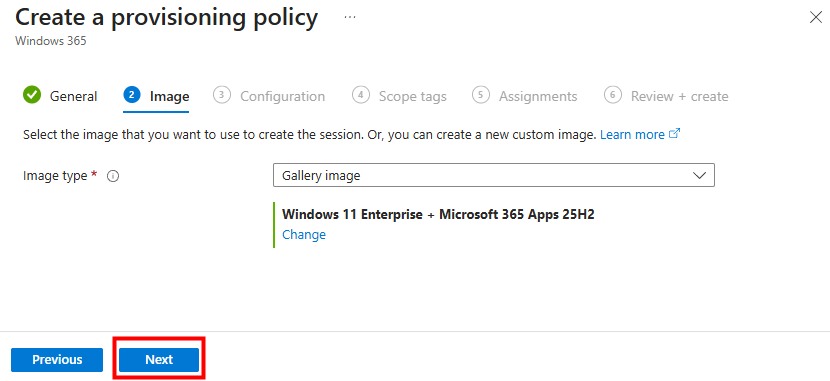

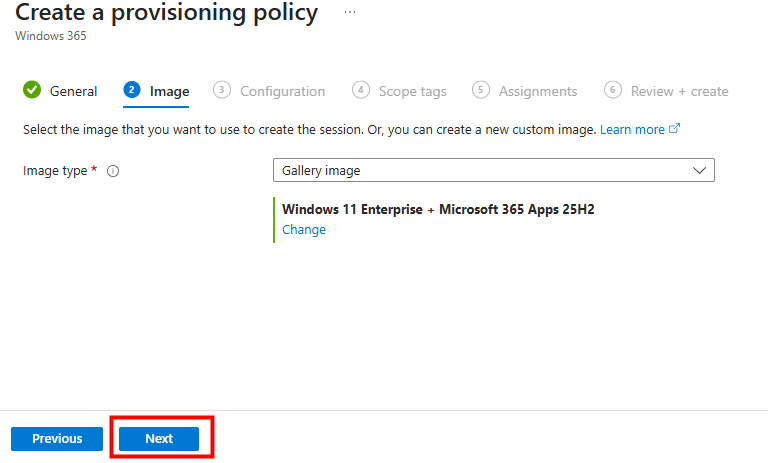

Je sélectionne une image Windows 11 pour mes Cloud PCs :

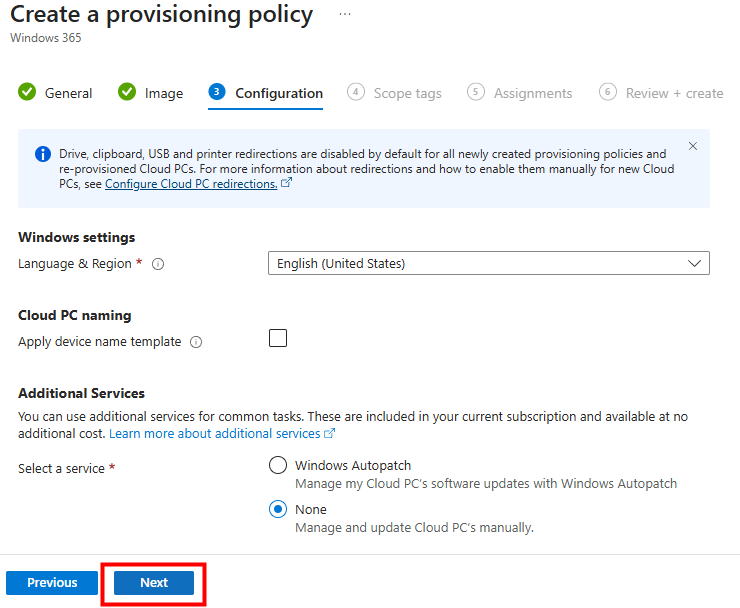

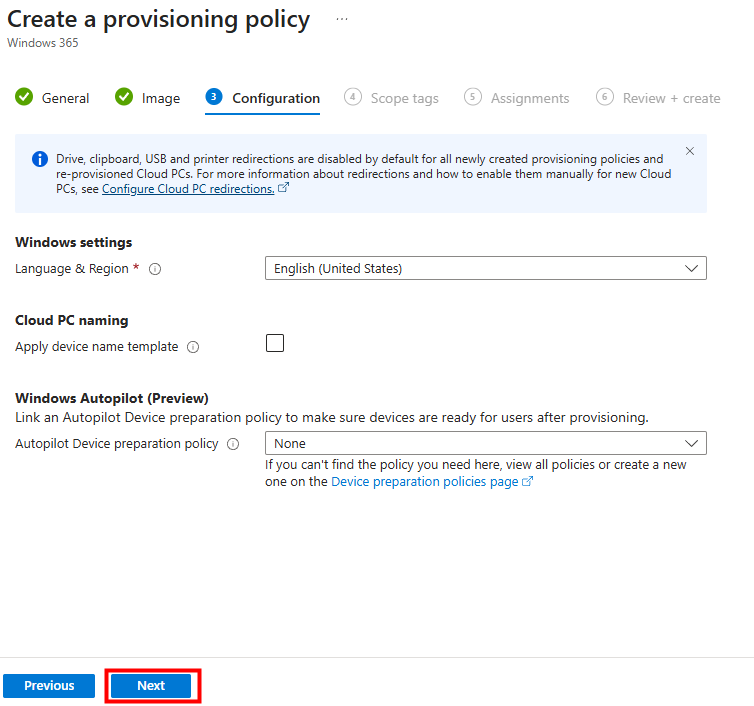

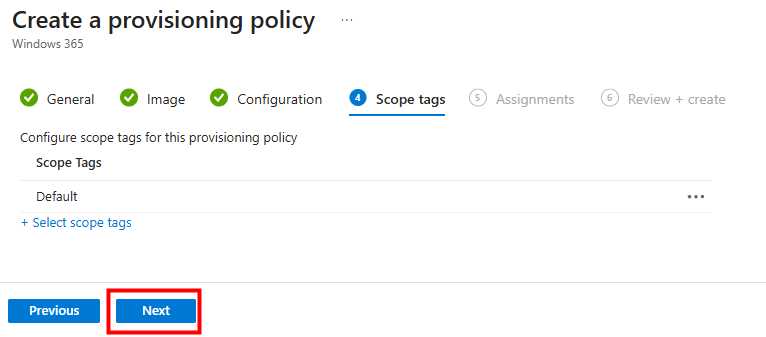

Je clique sur Suivant :

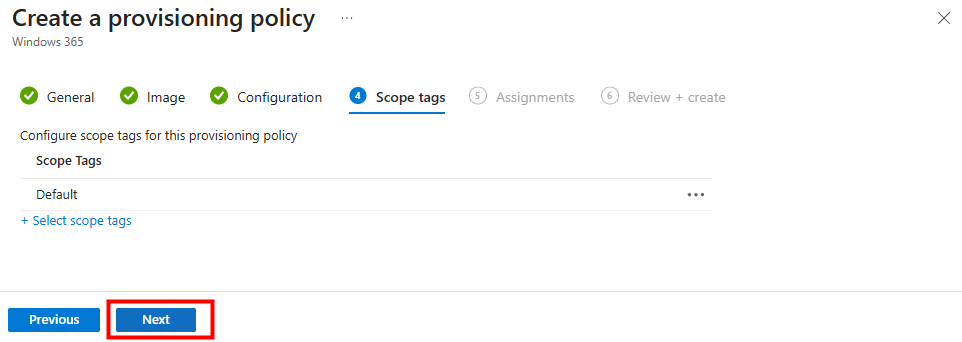

Je clique sur Suivant :

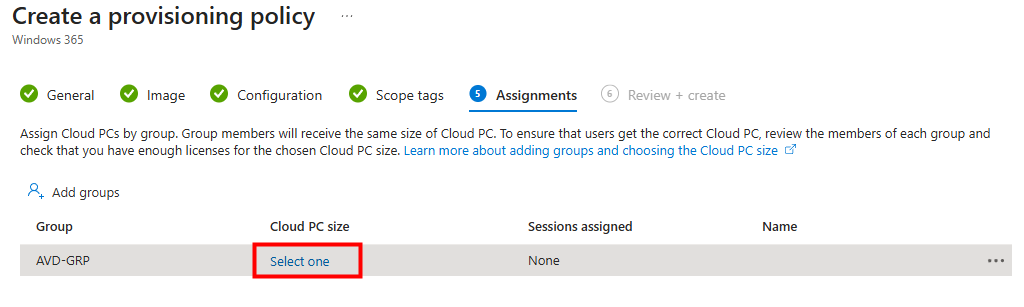

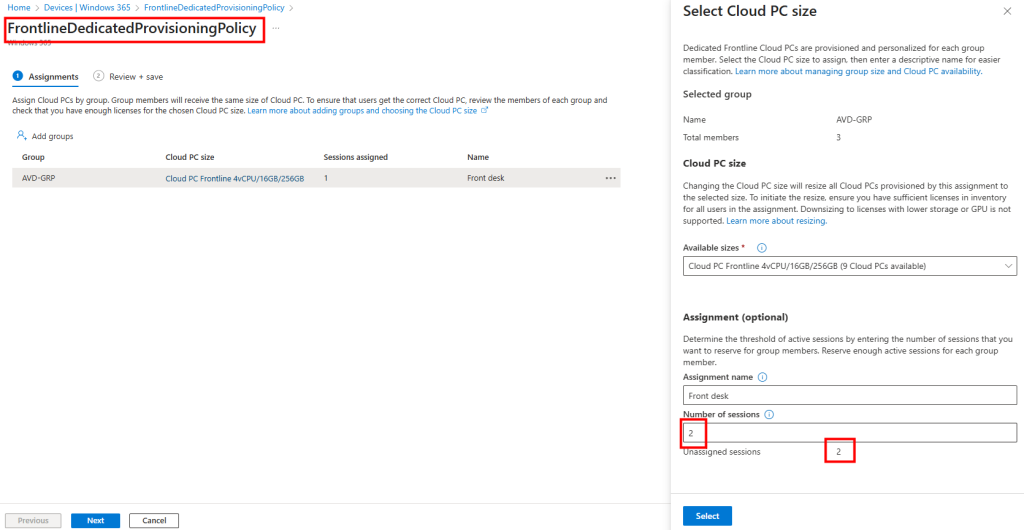

Je clique ici pour attribuer une configuration de Cloud PCs :

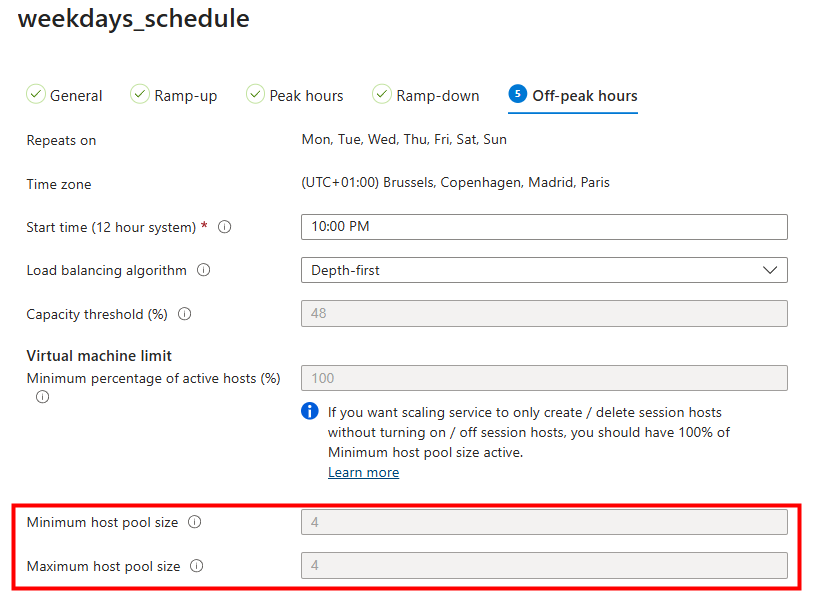

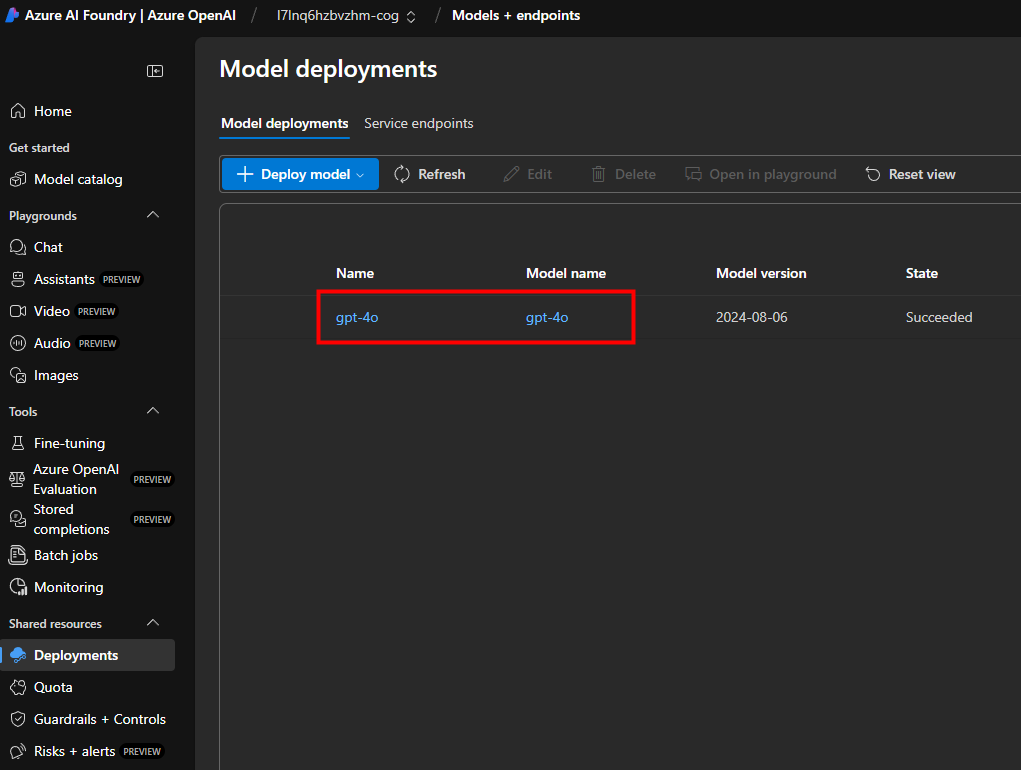

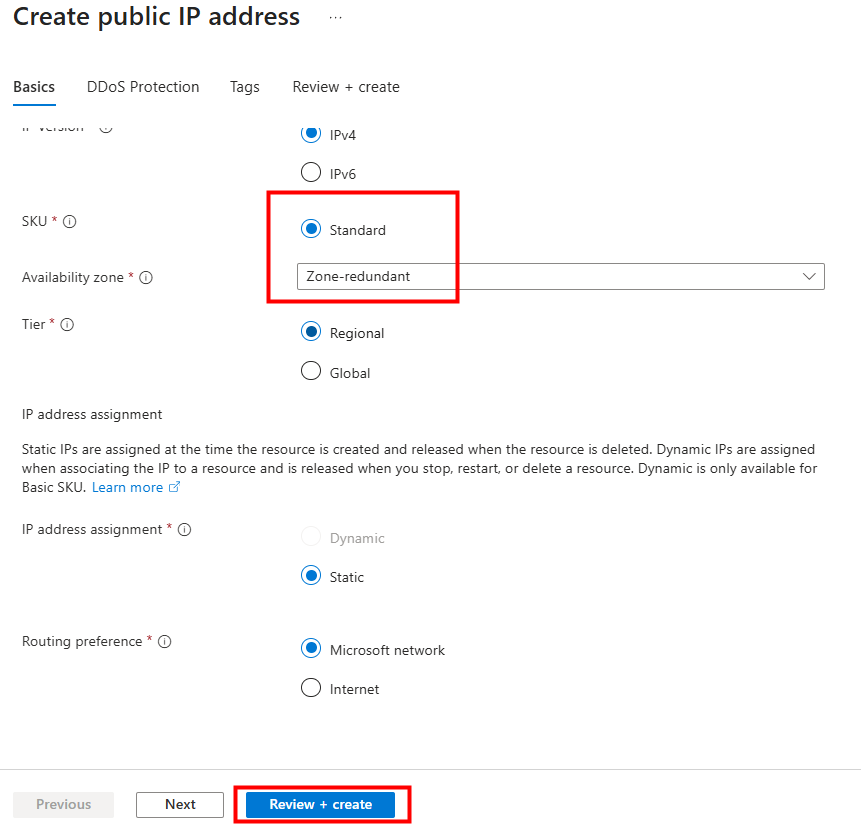

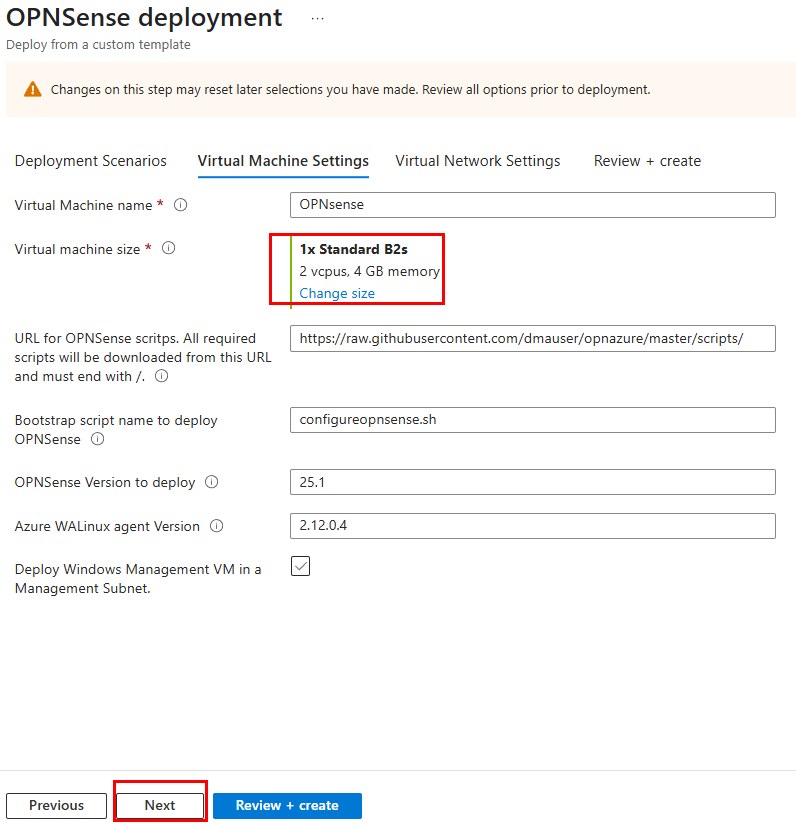

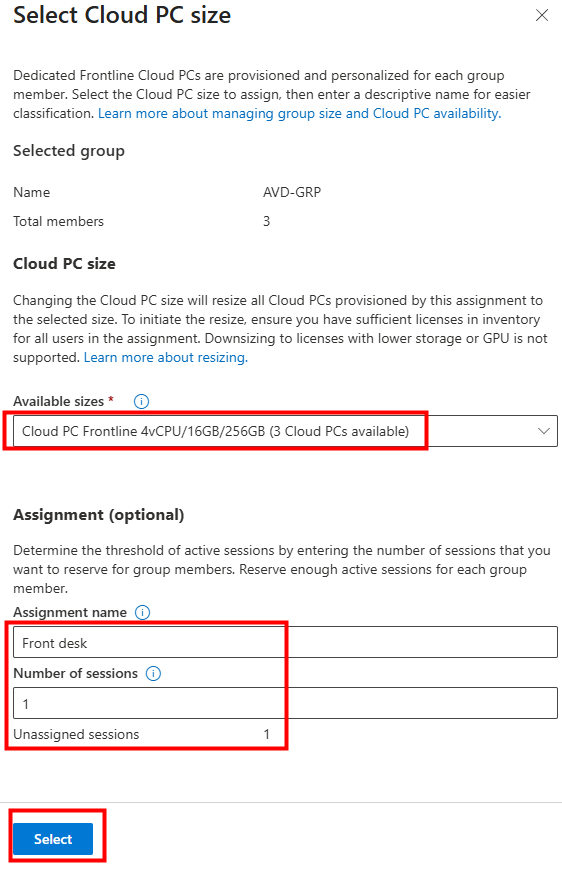

Je choisis la taille des Cloud PCs, ainsi que leur nombre :

Je clique sur Suivant :

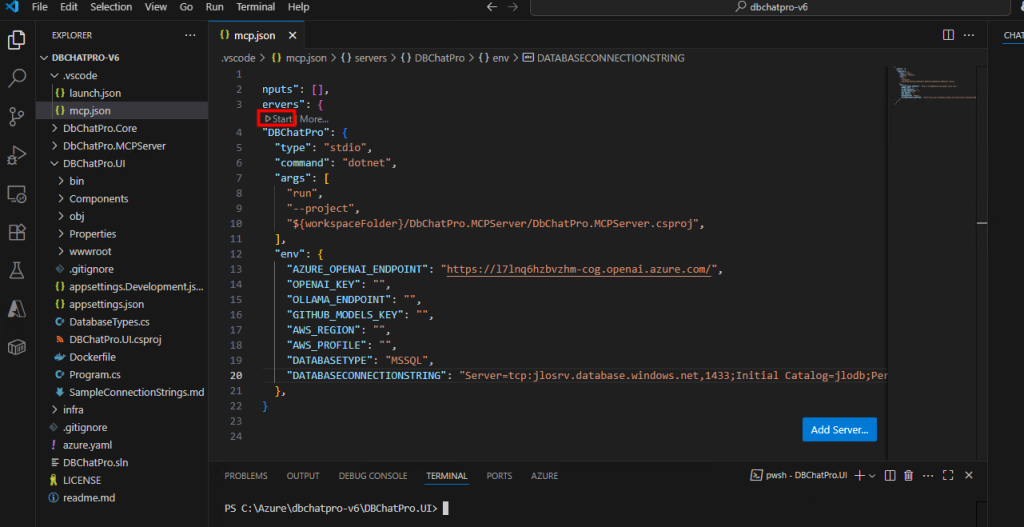

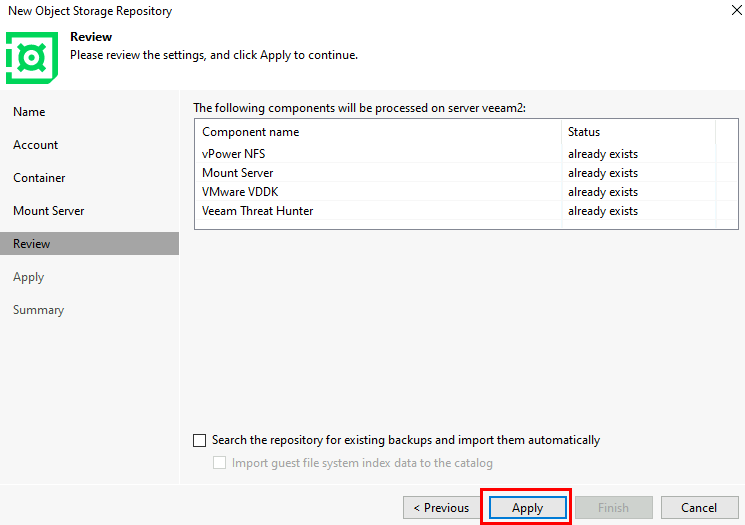

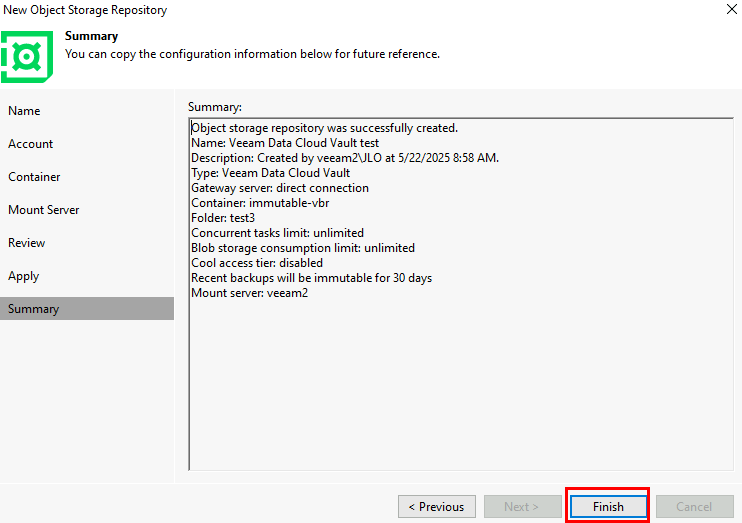

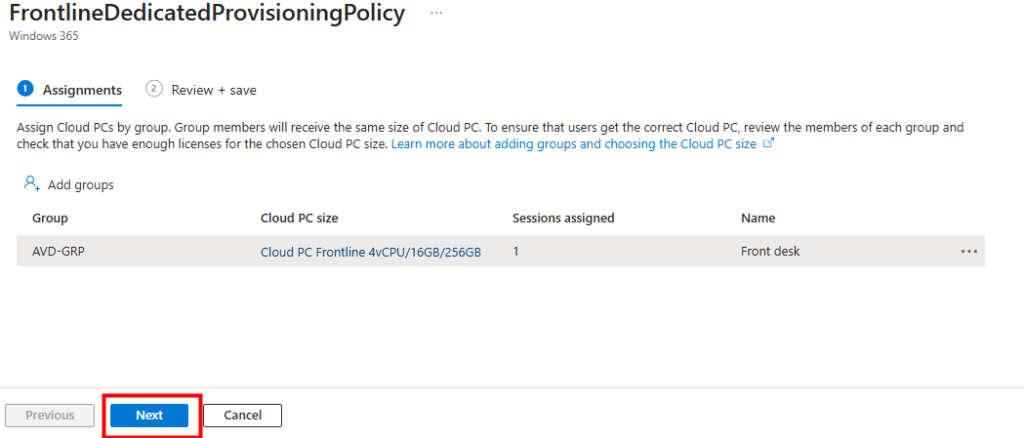

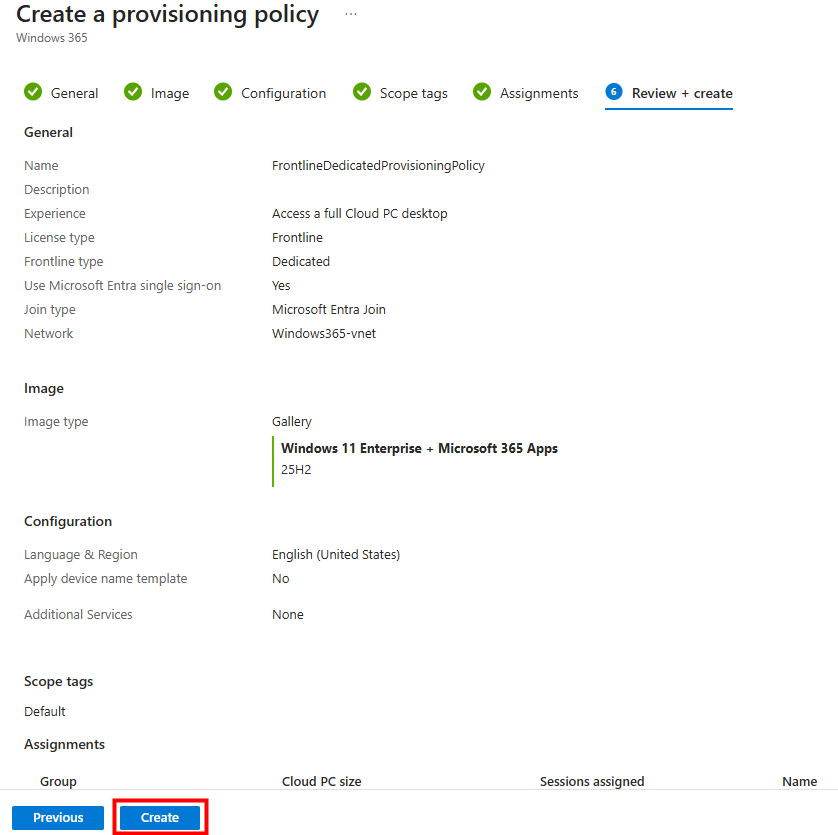

Je clique sur Créer pour valider ma nouvelle police de provisionnement :

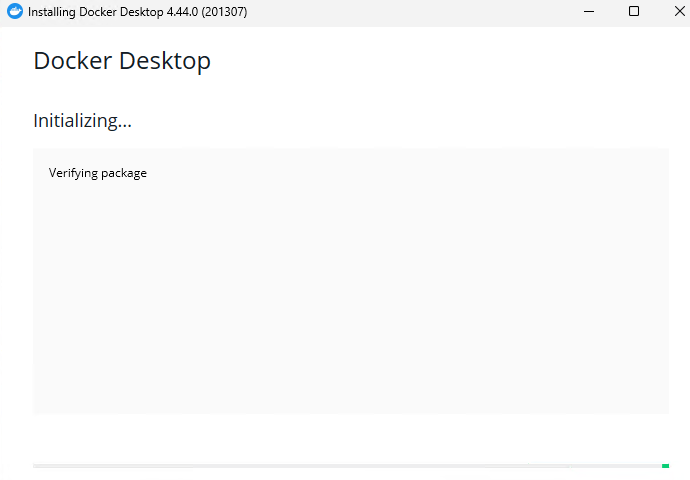

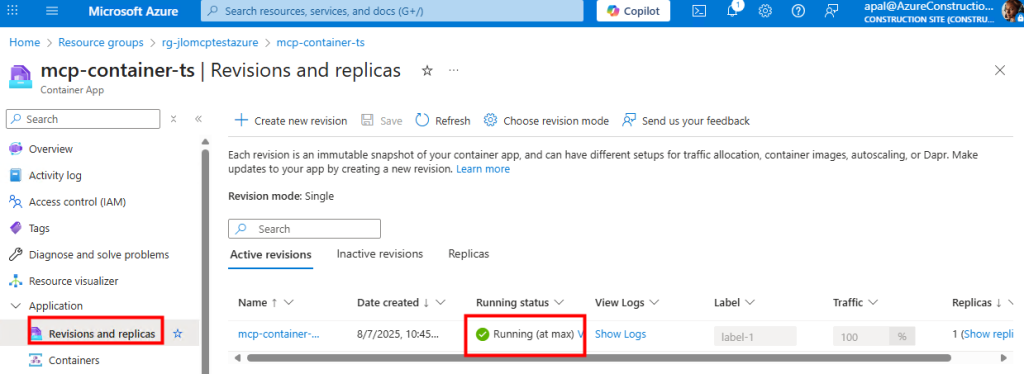

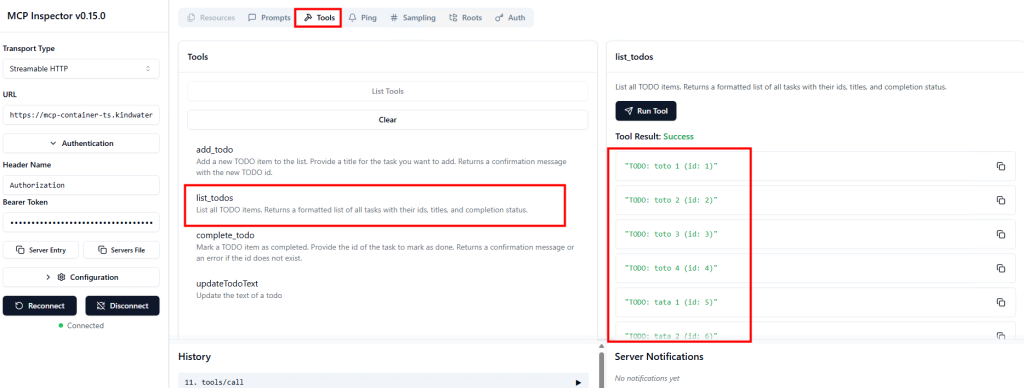

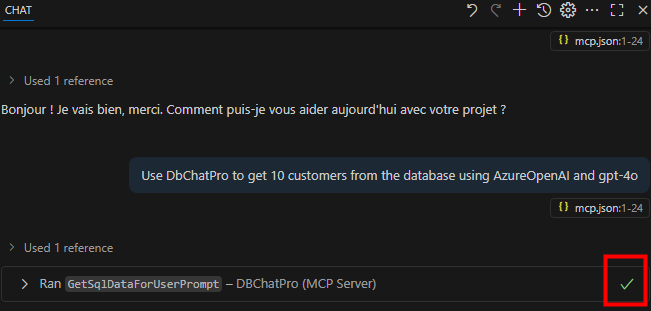

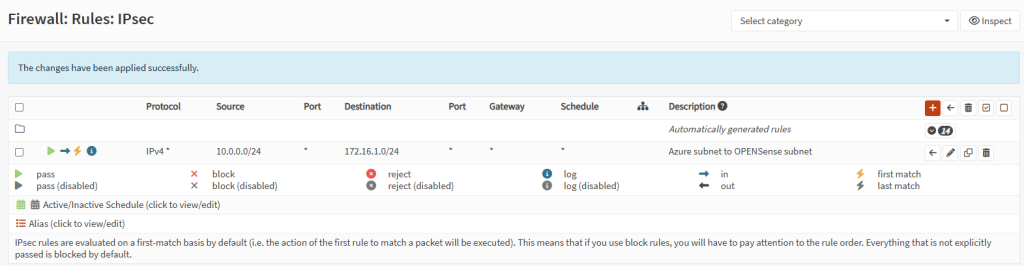

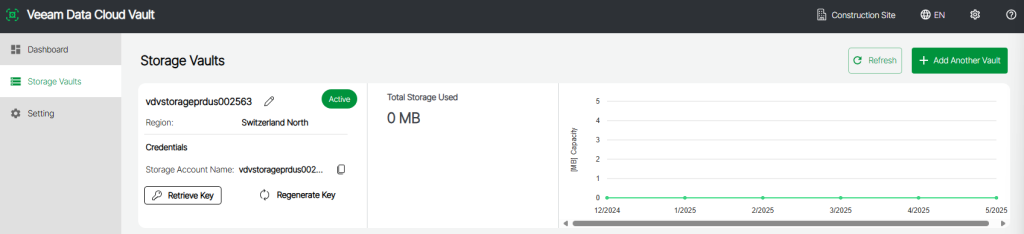

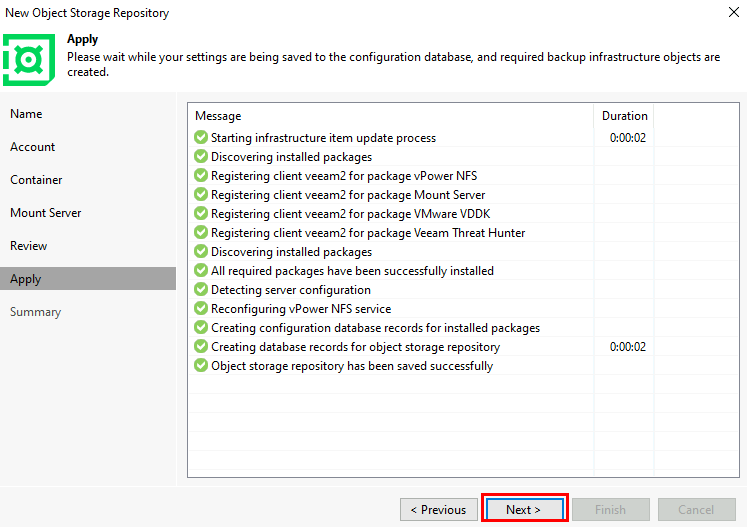

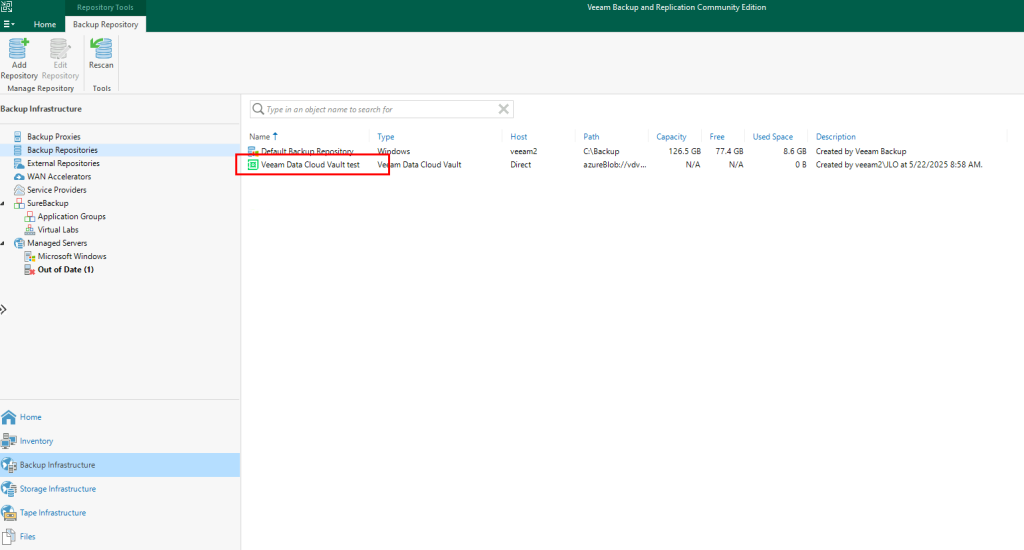

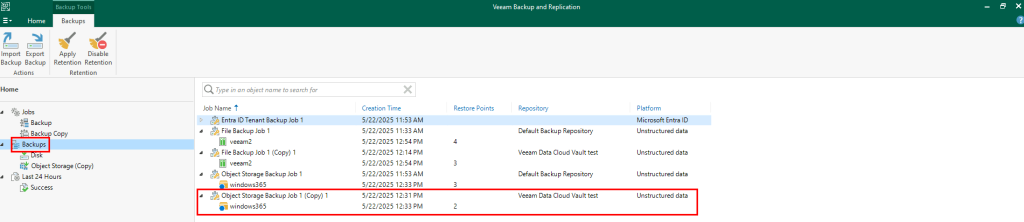

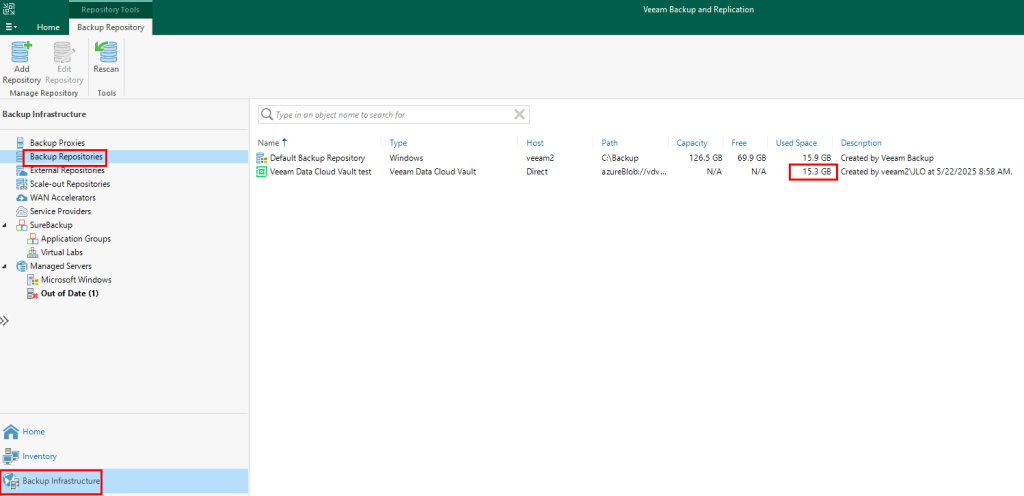

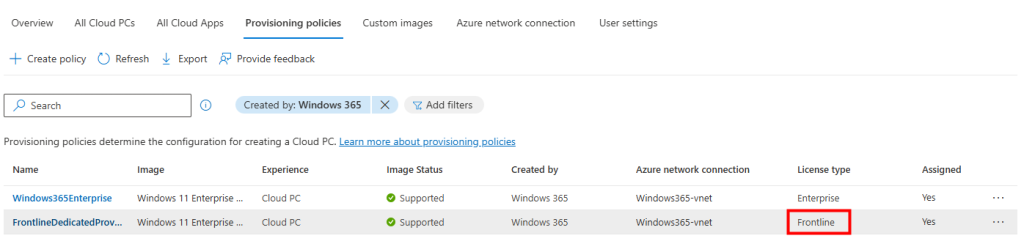

Je constate la création de la police de provisionnement de mes PC Frontline :

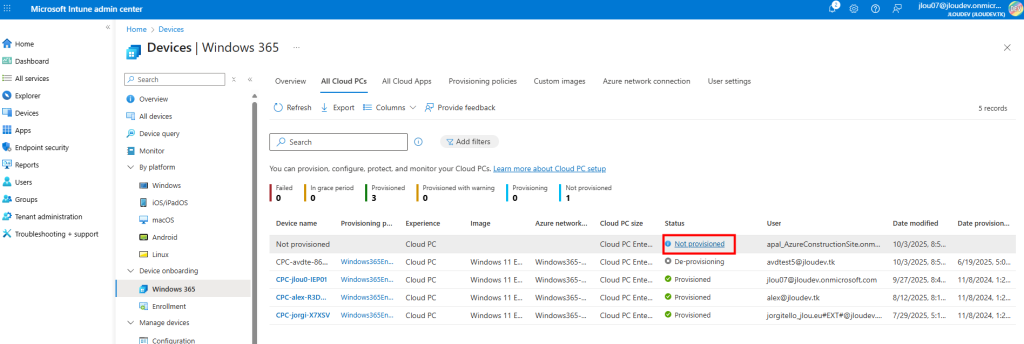

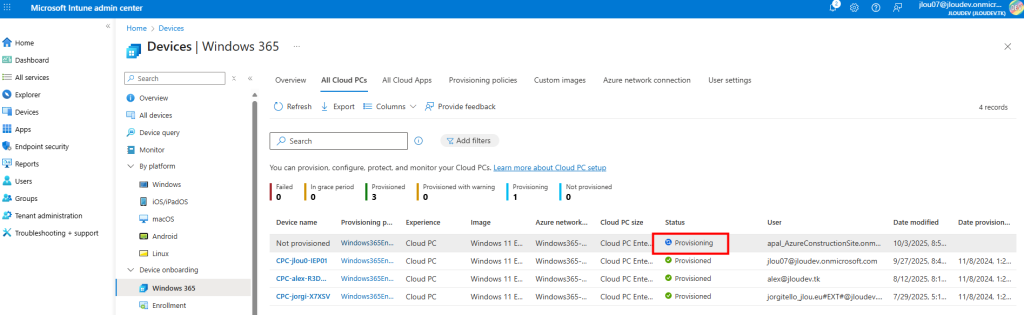

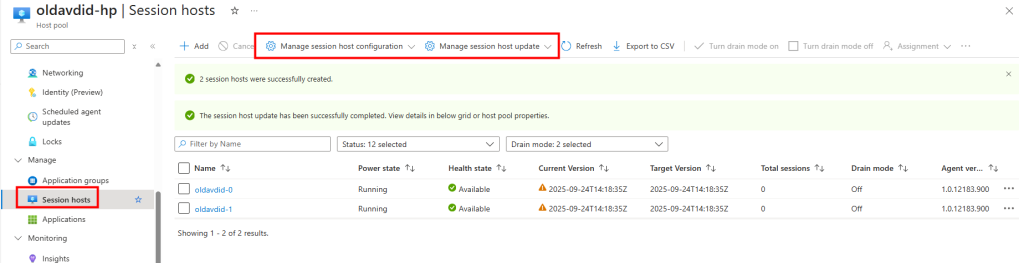

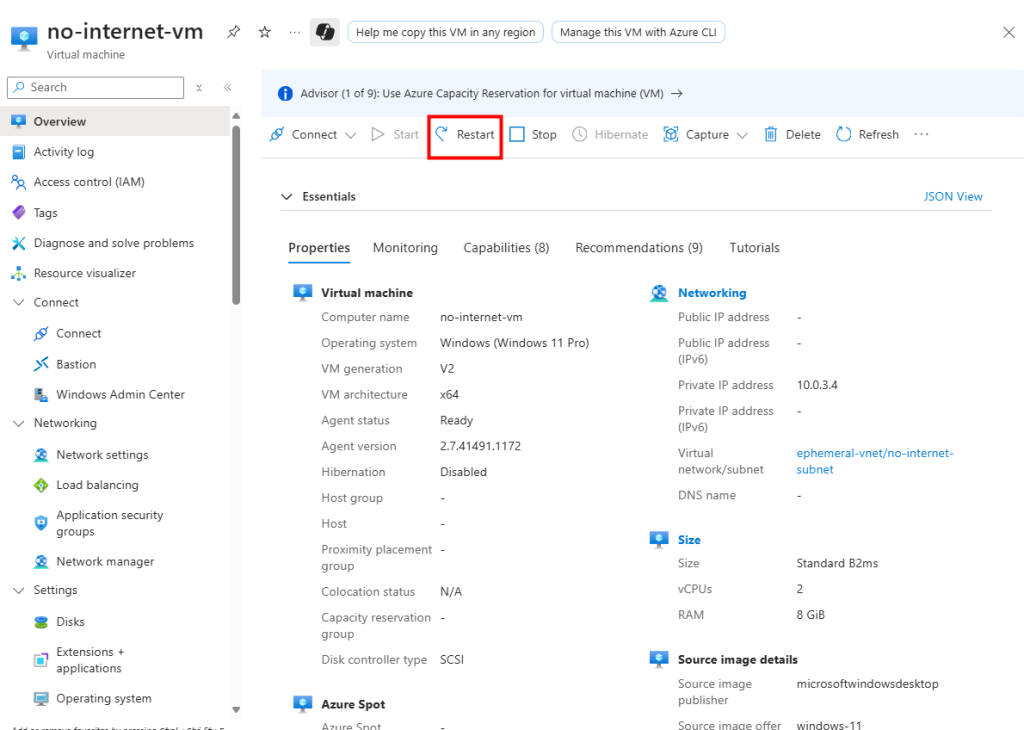

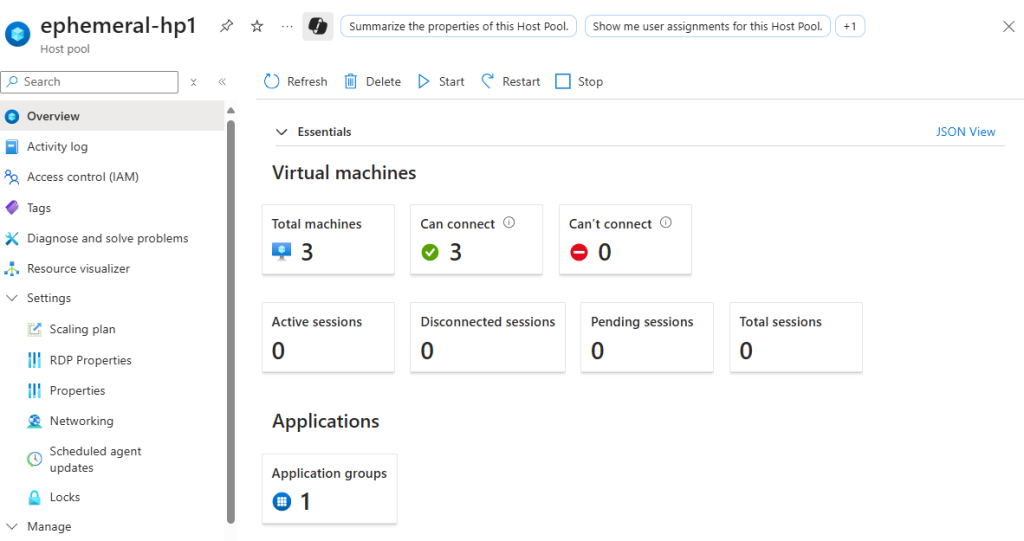

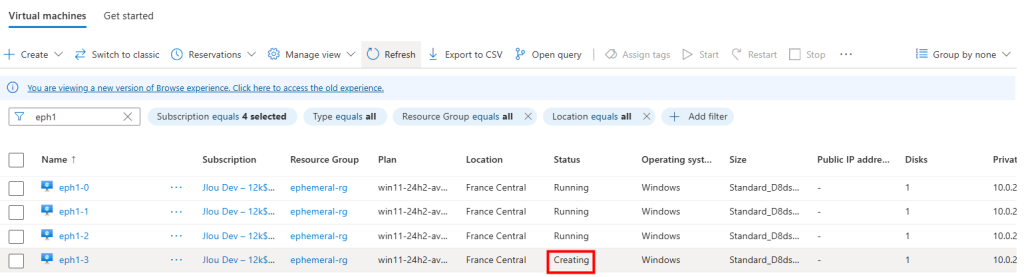

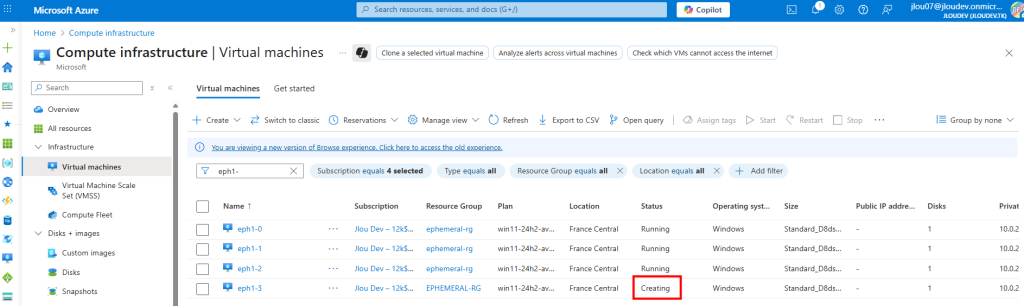

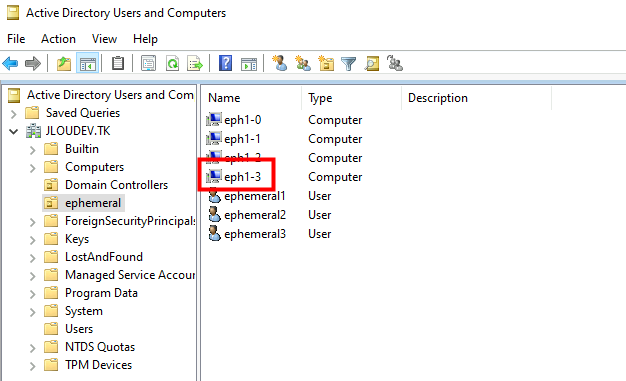

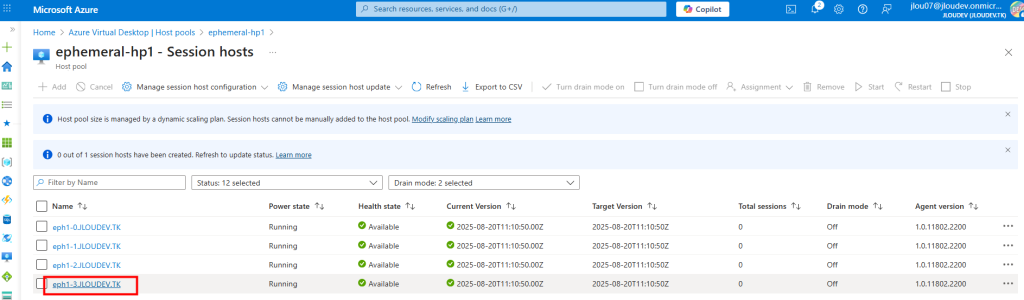

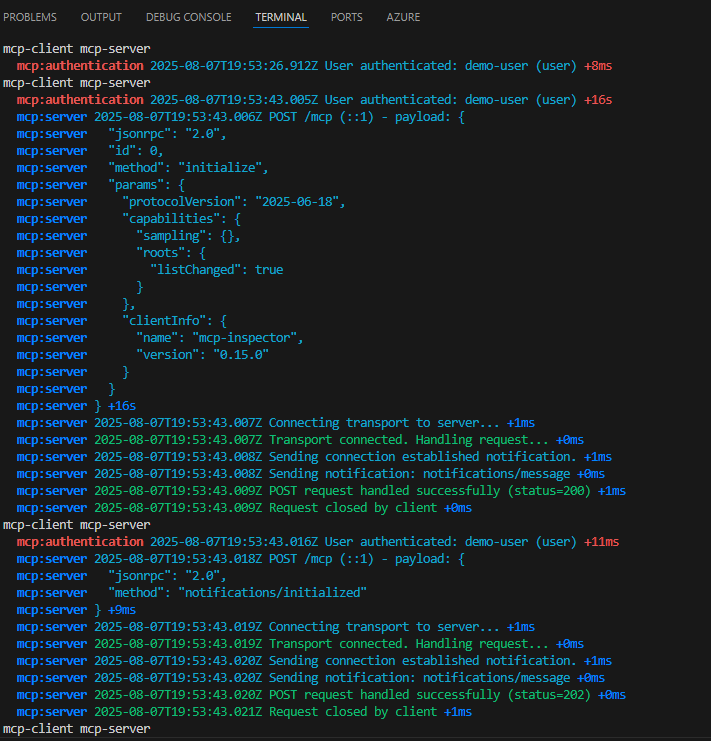

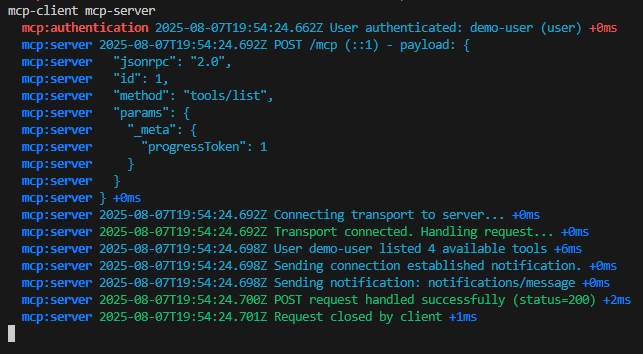

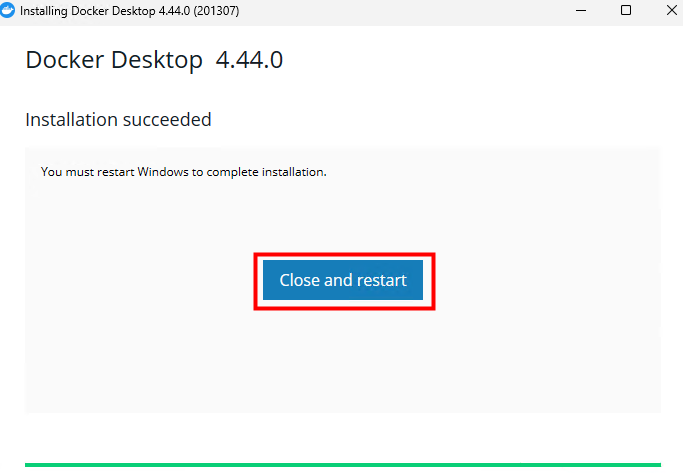

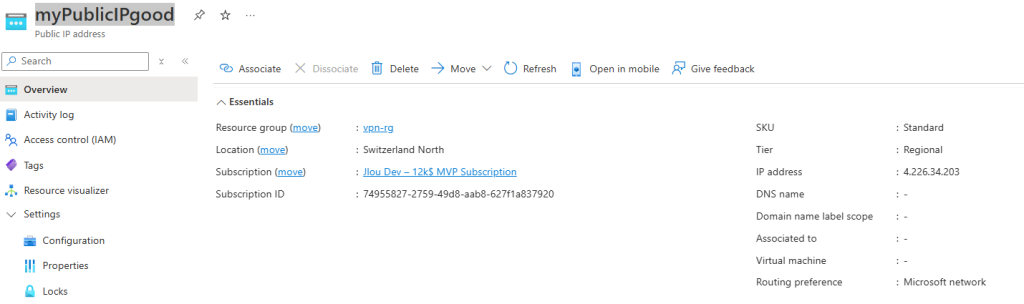

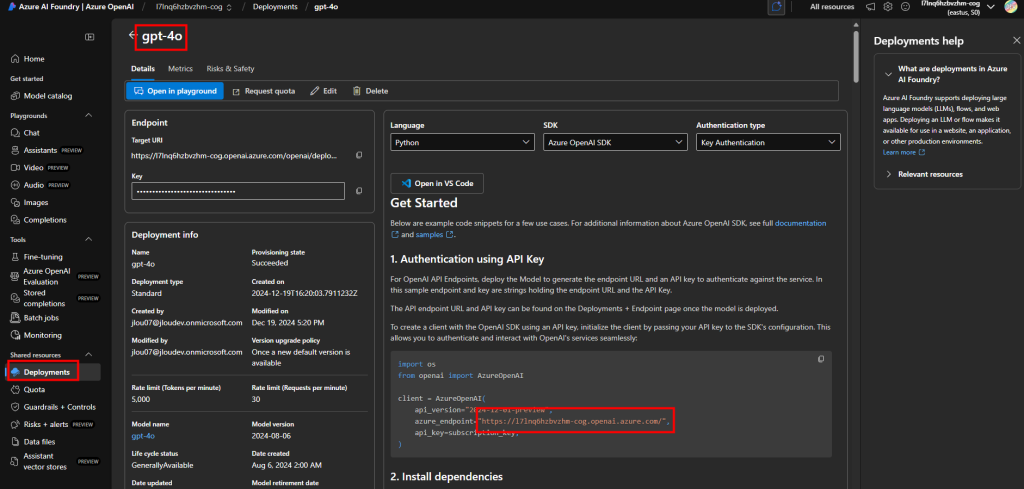

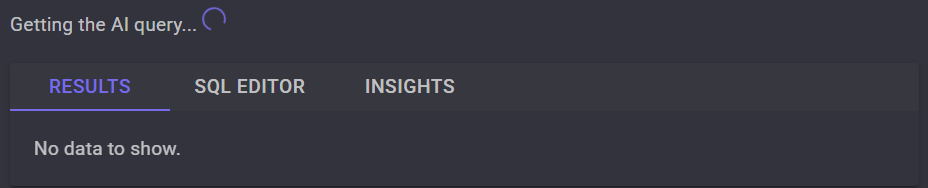

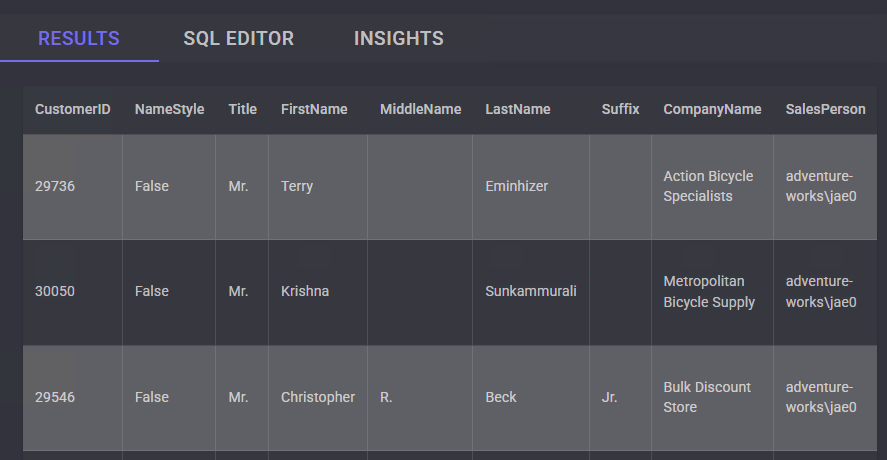

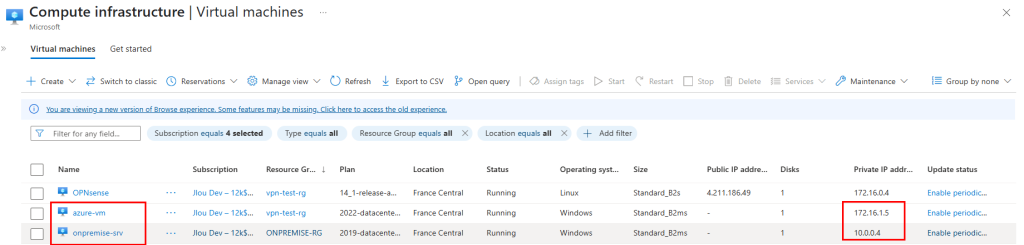

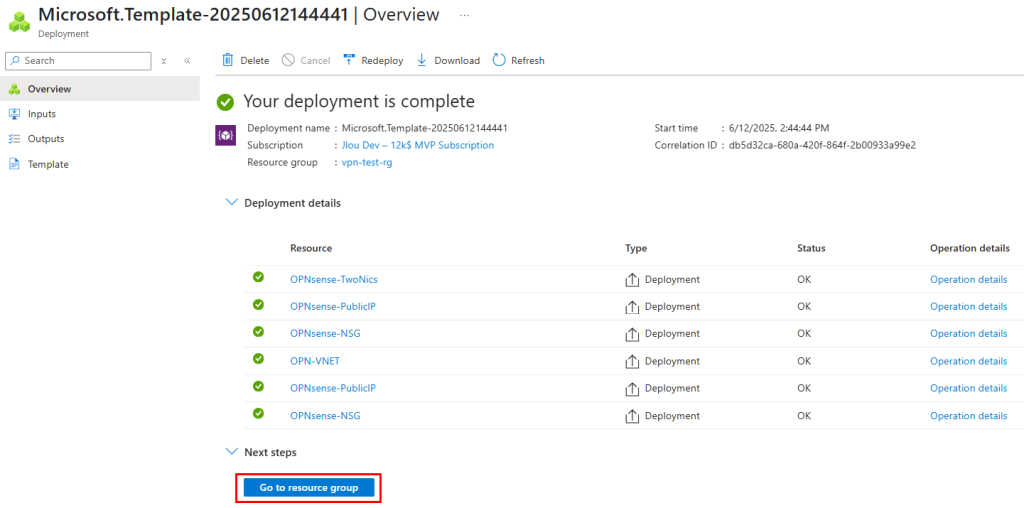

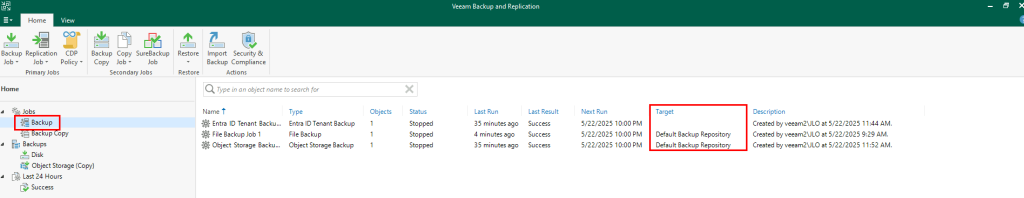

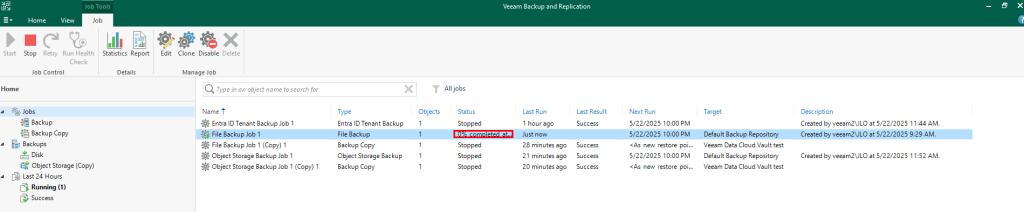

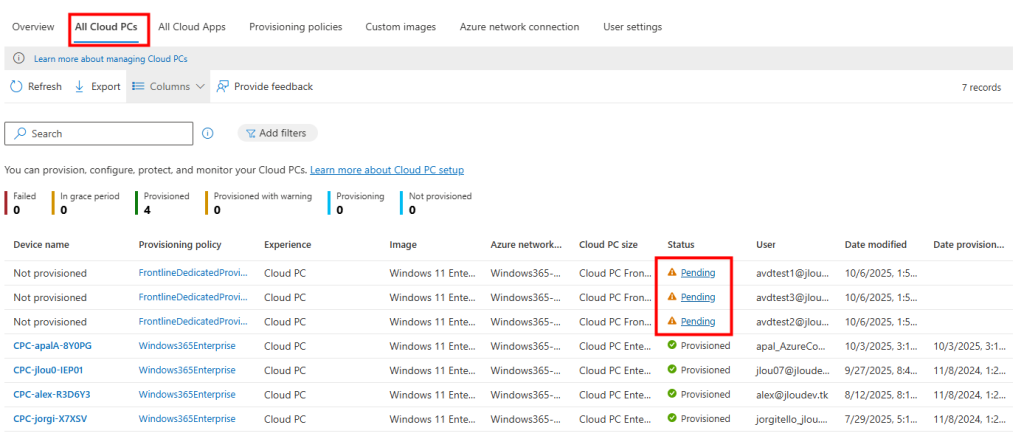

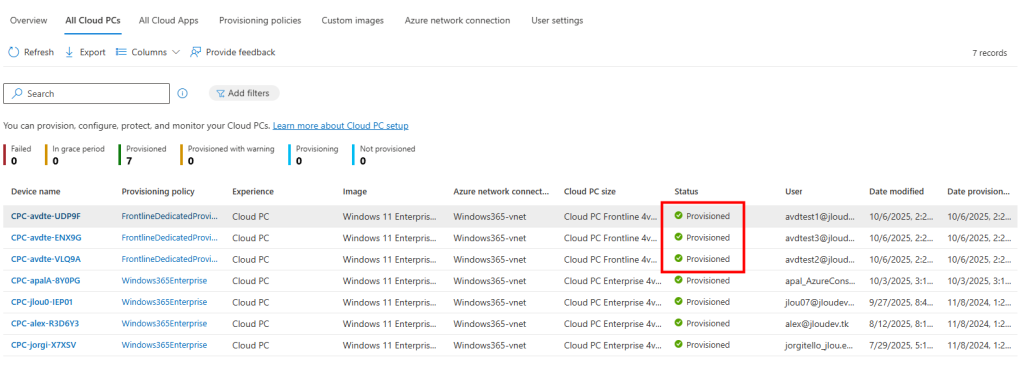

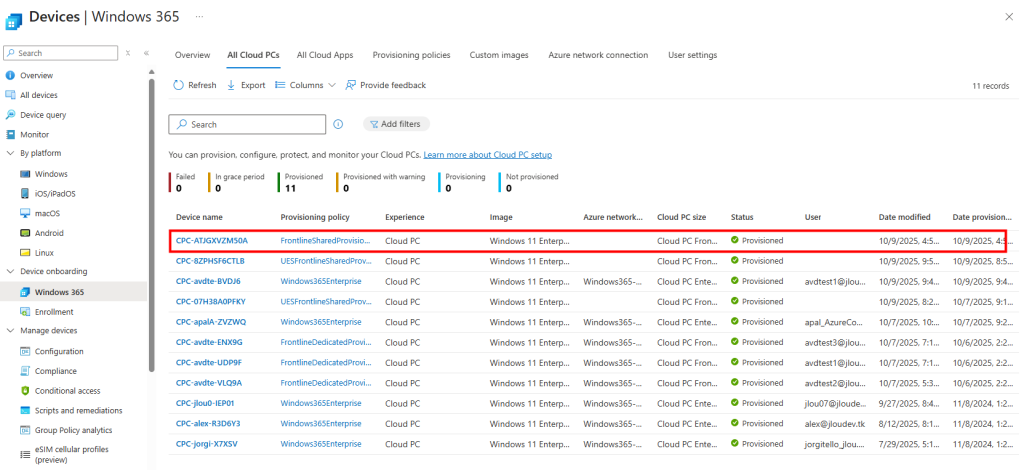

De retour dans la liste des Cloud PCs, je remarque l’apparition de nouveaux Cloud PCs avec le statut Pending :

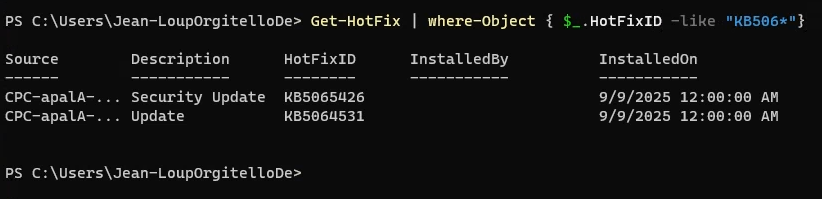

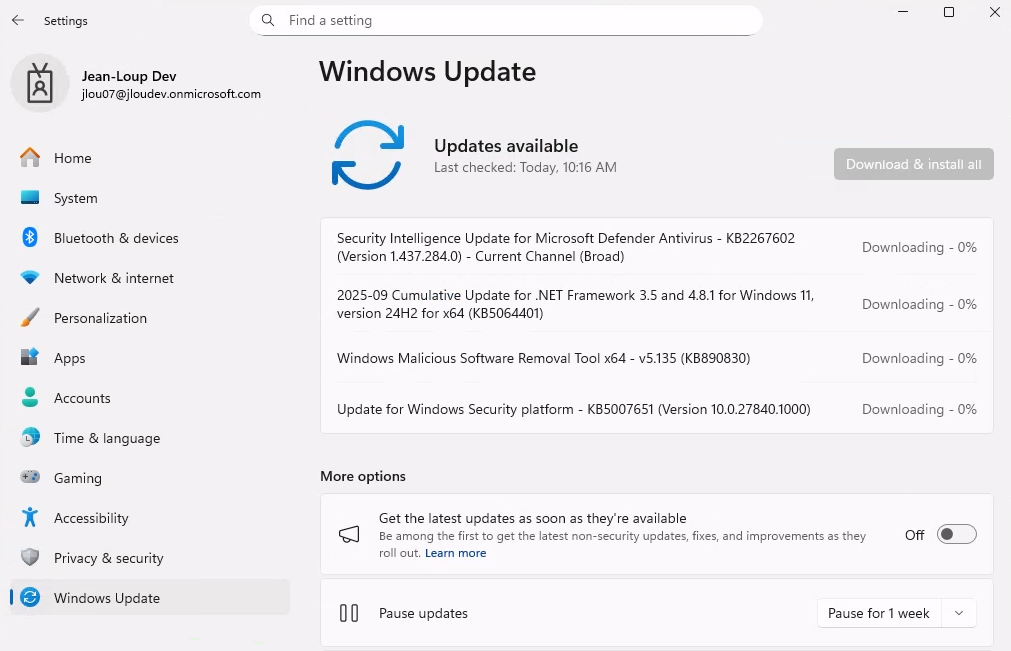

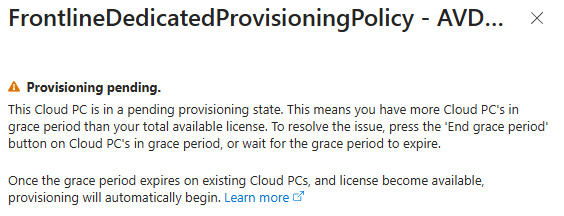

En cliquant sur la mention Pending, j’observe un message indiquant plusieurs raisons possibles expliquant ce statut :

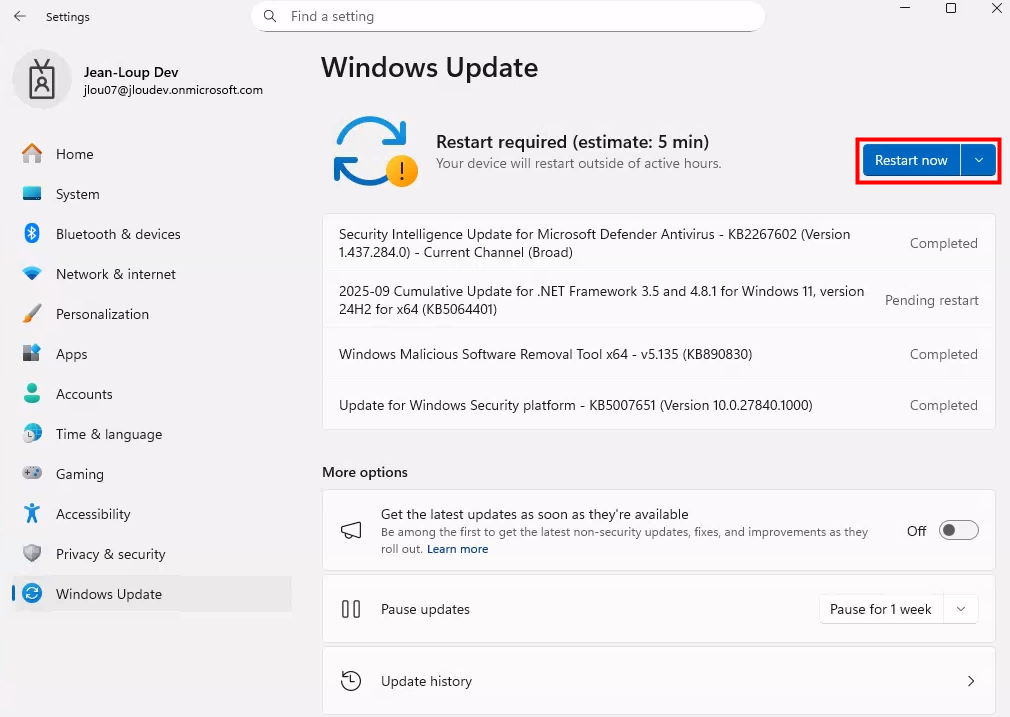

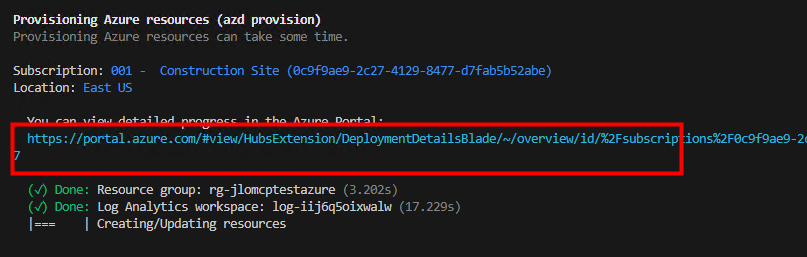

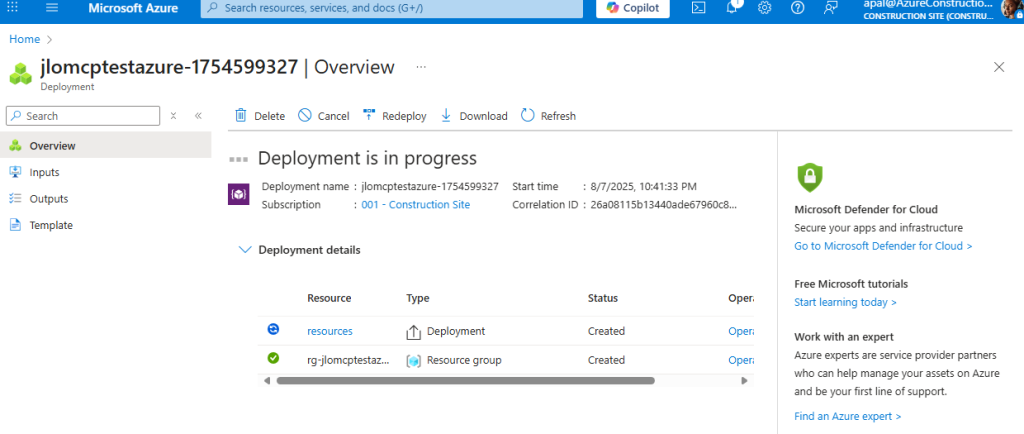

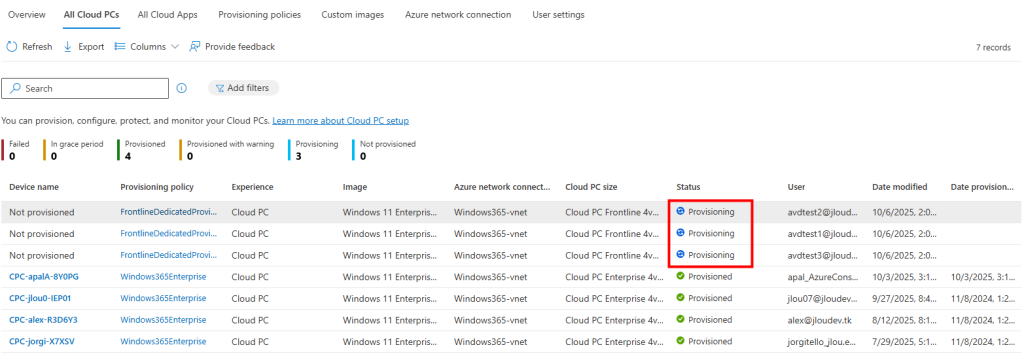

Quelques minutes plus tard, le statut Pending passe à Provisioning pour ces Cloud PCs :

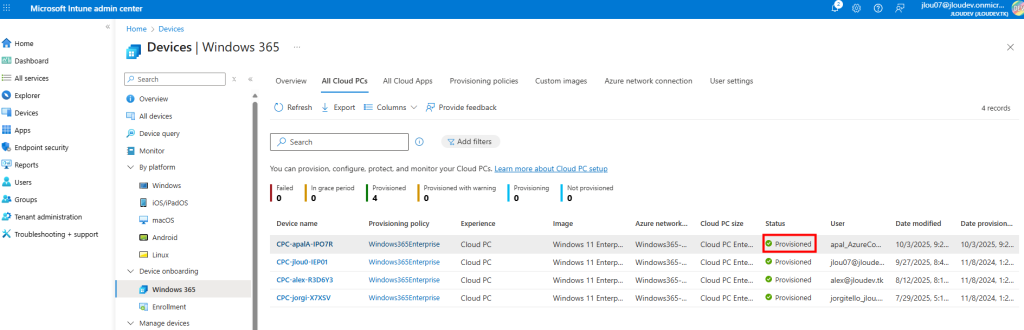

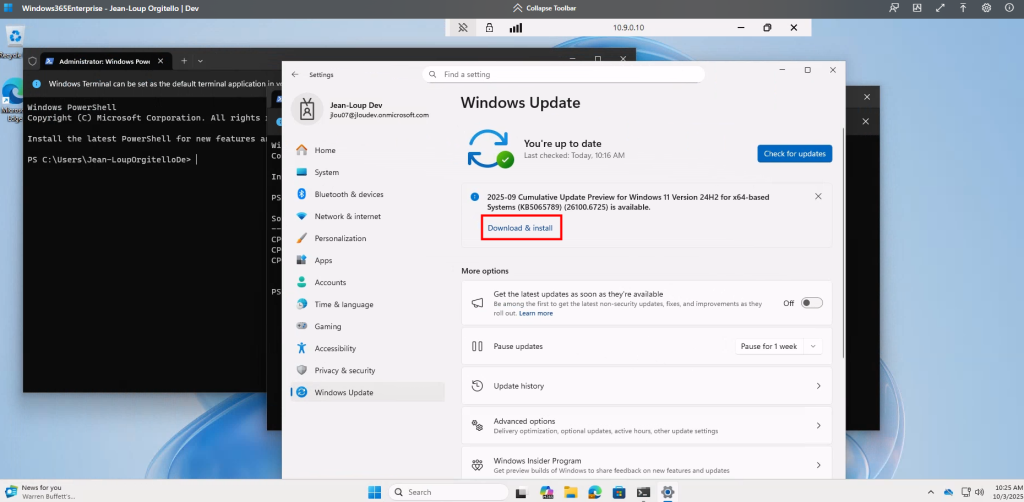

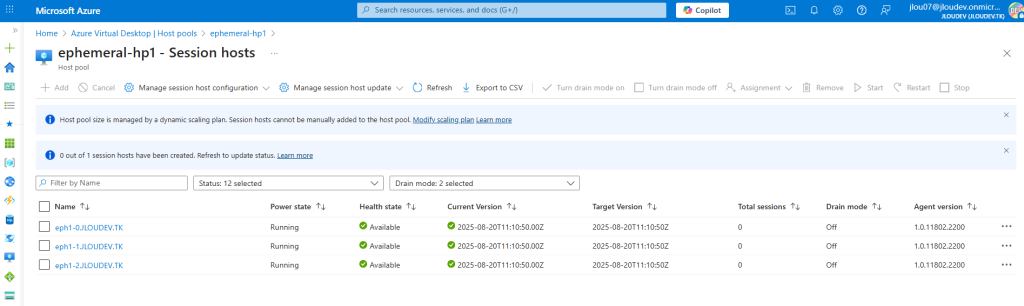

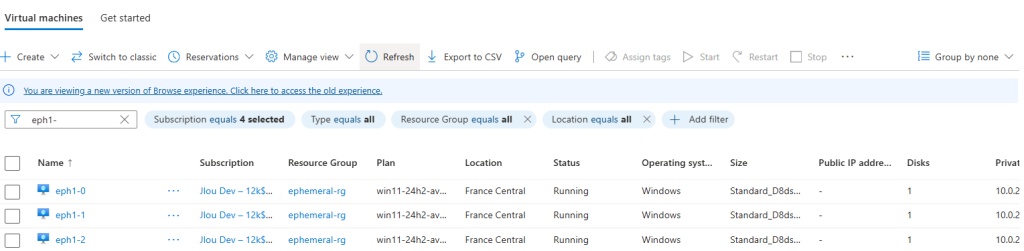

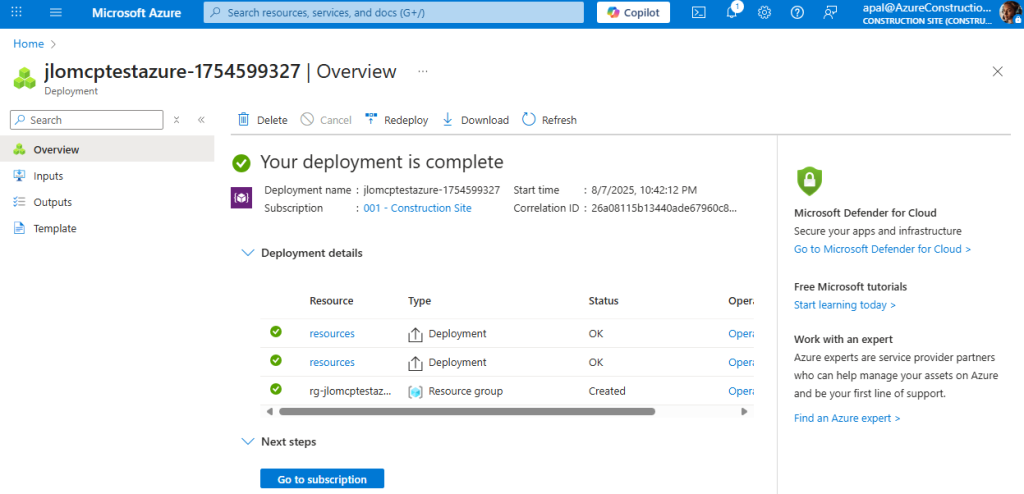

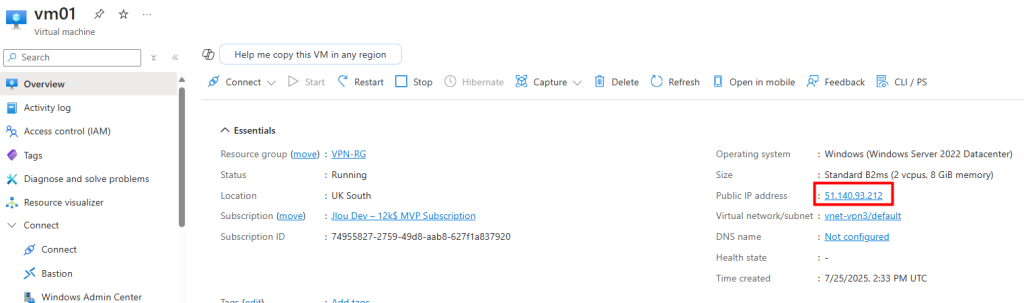

Environ un quart d’heure plus tard, les PC apparaissent en statut Provisioned :

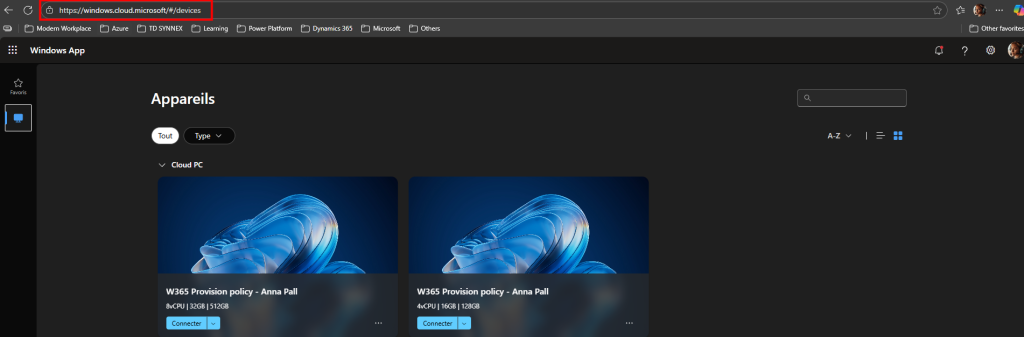

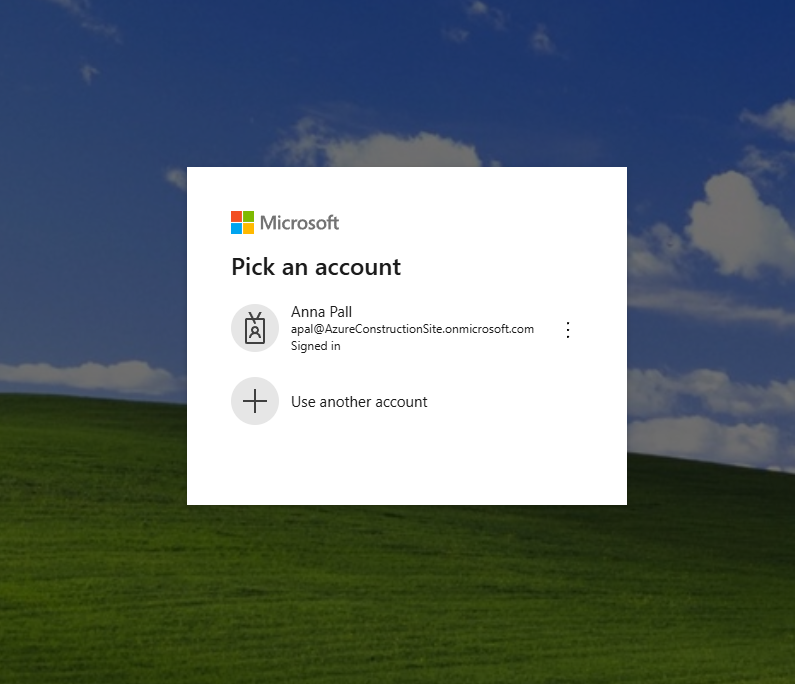

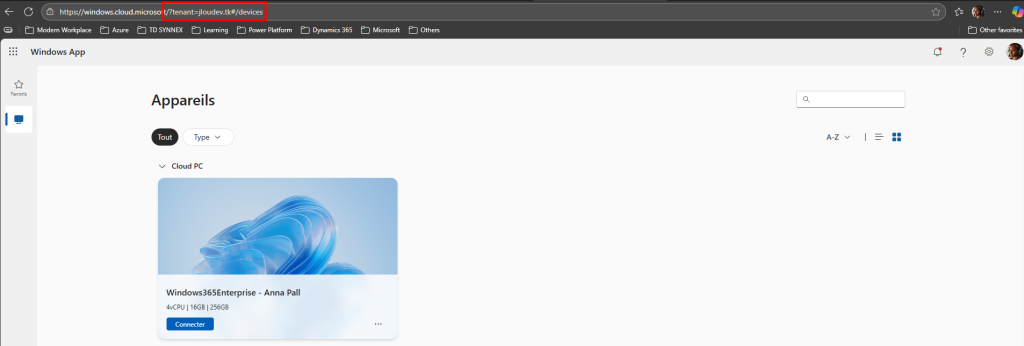

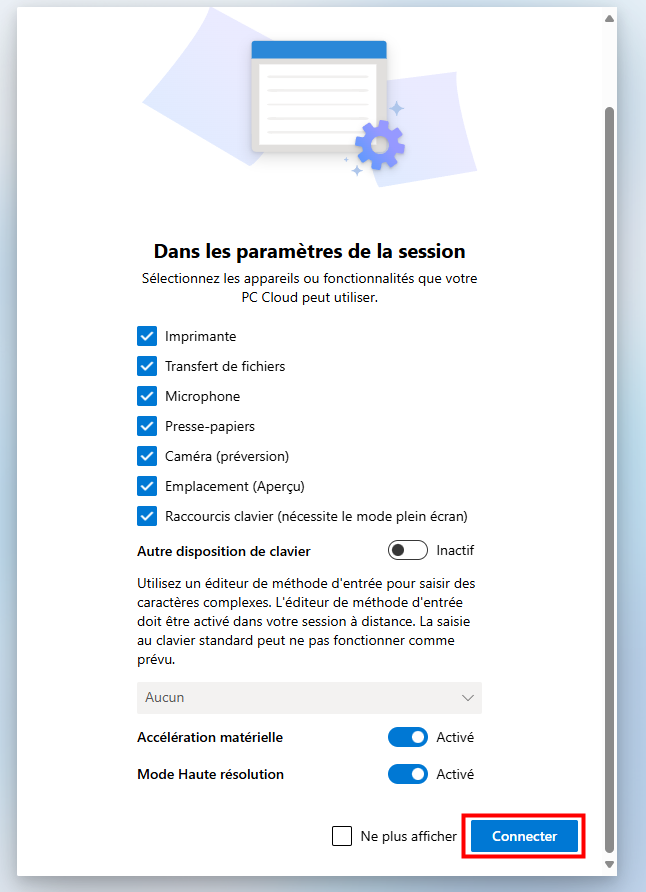

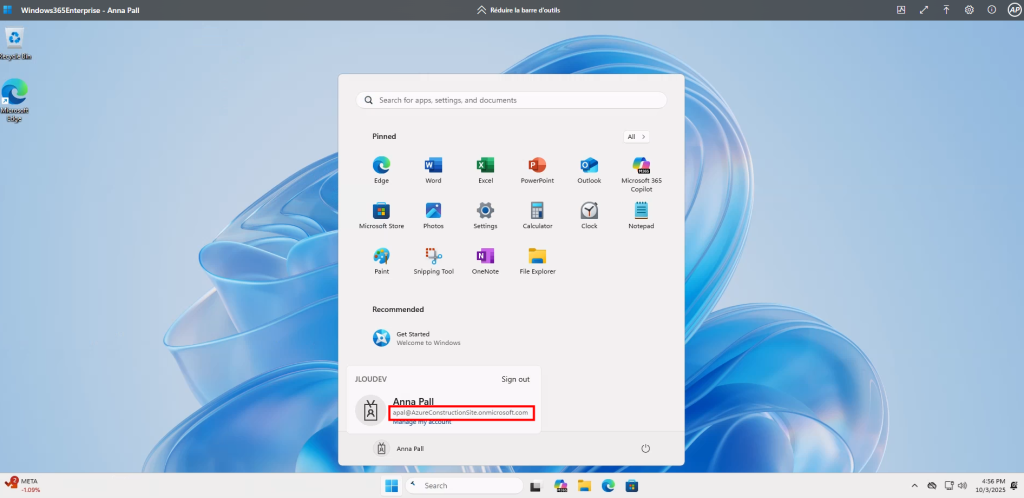

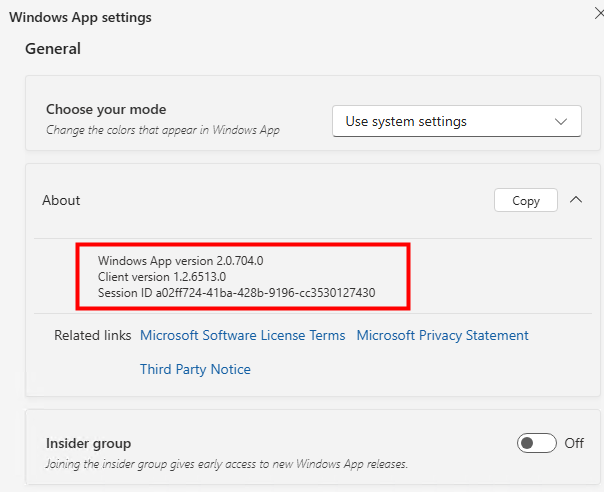

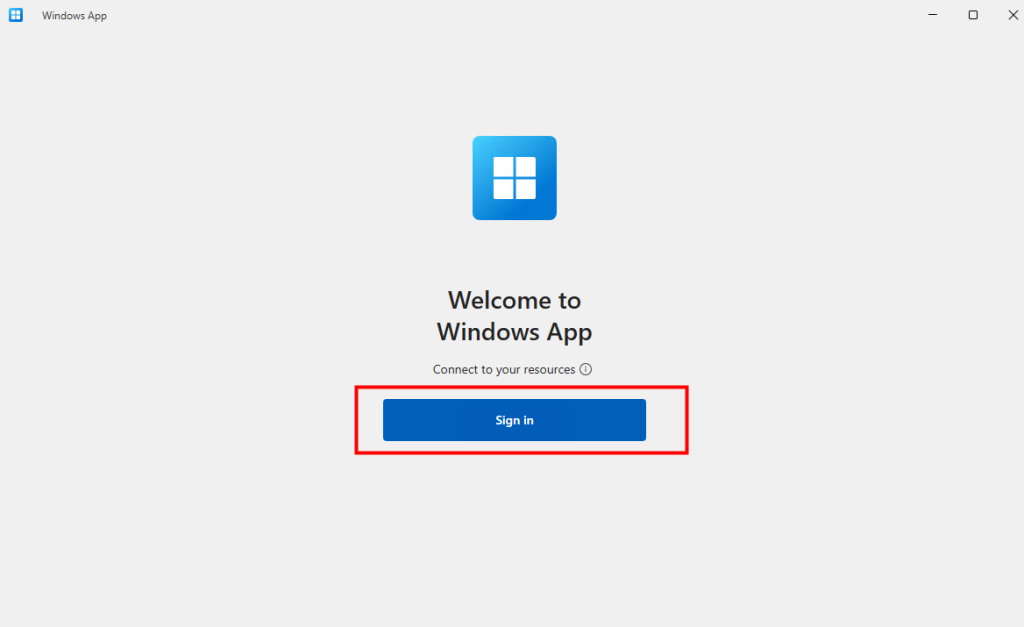

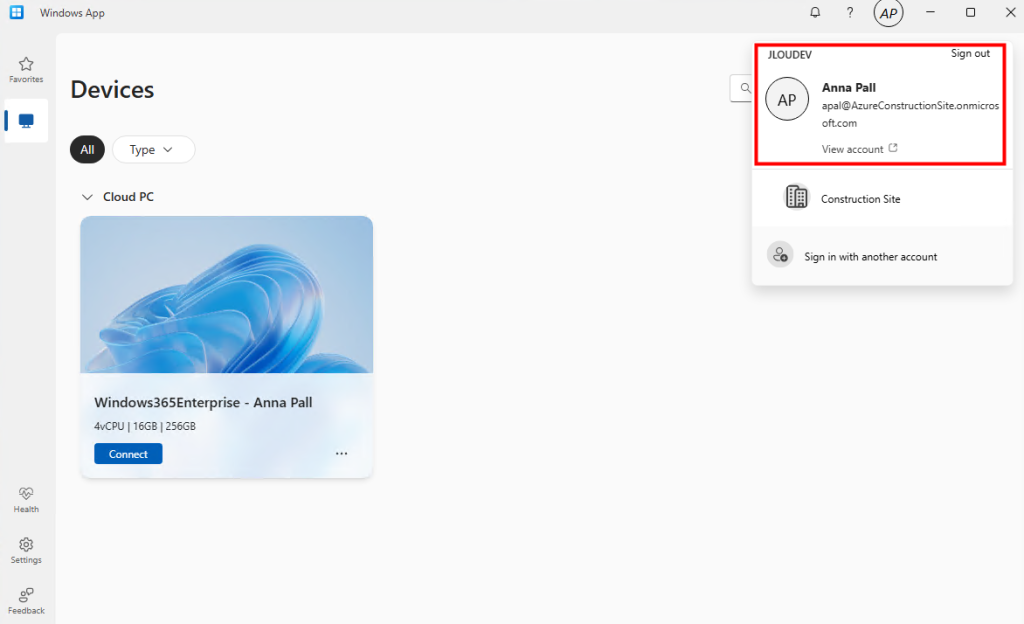

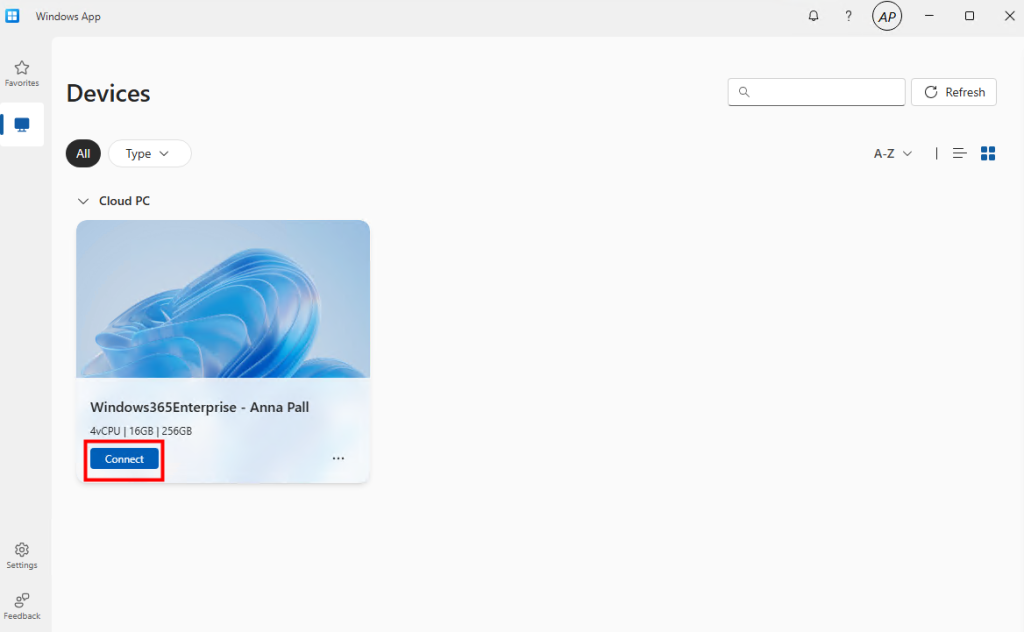

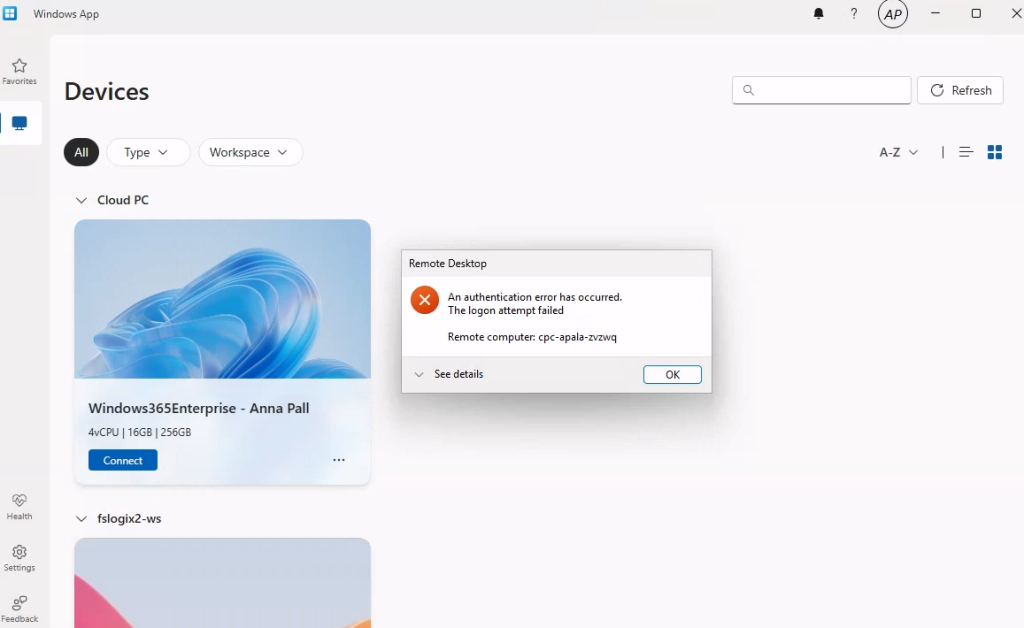

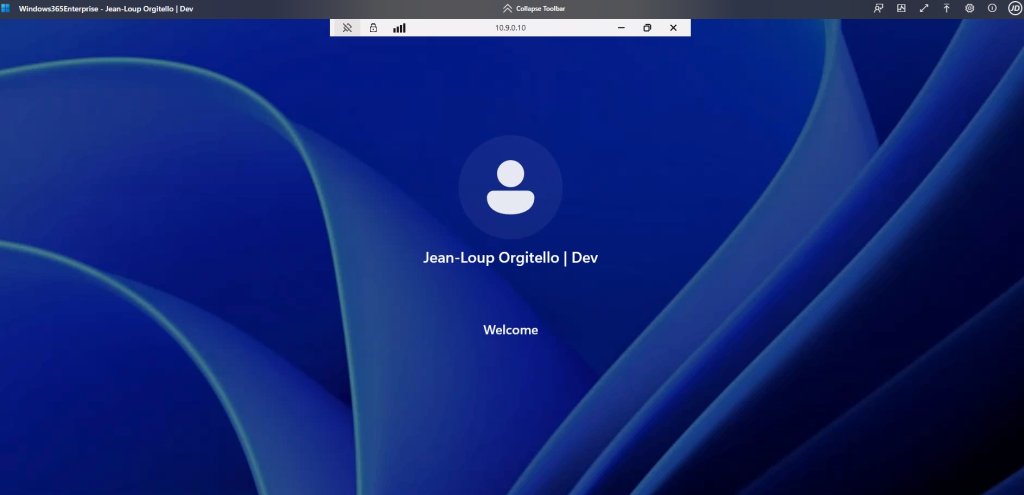

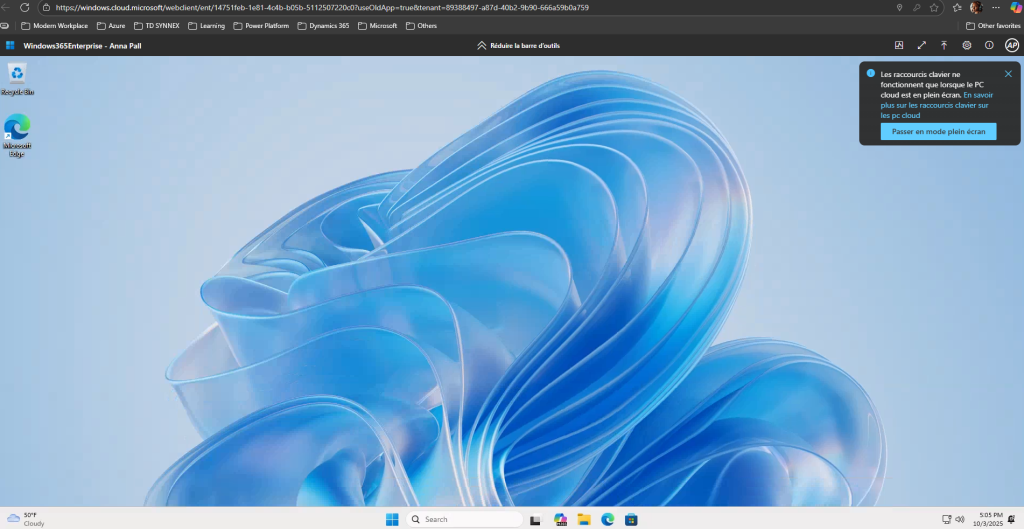

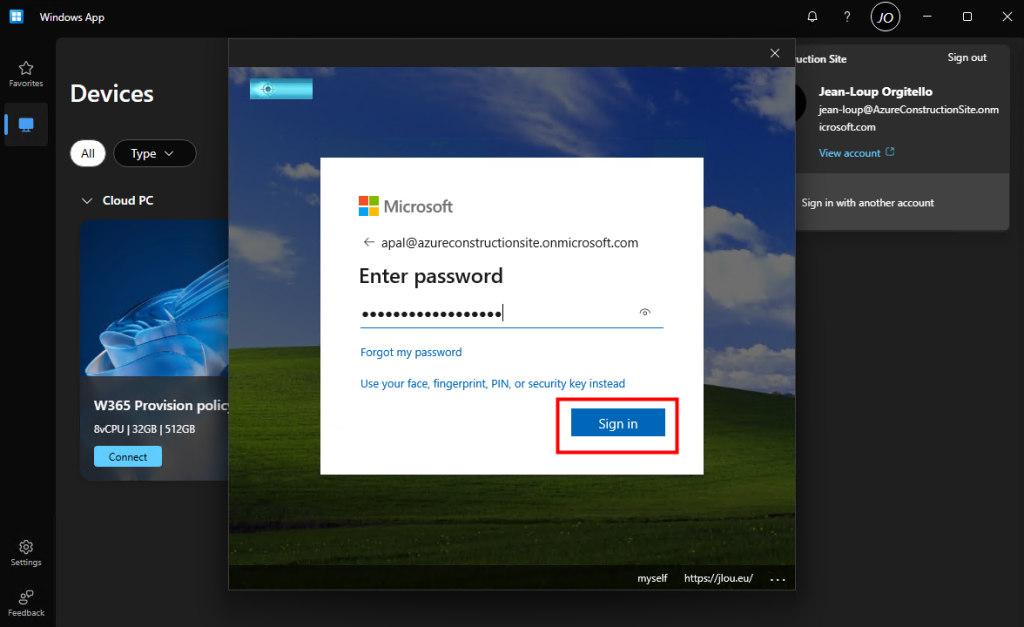

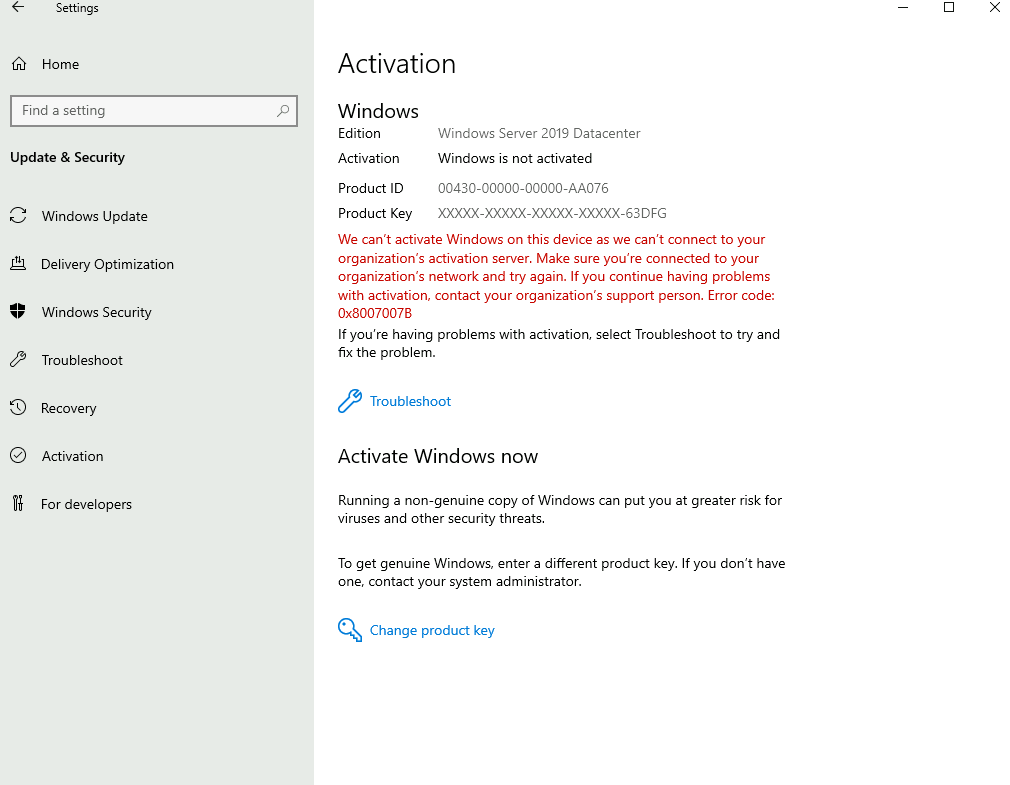

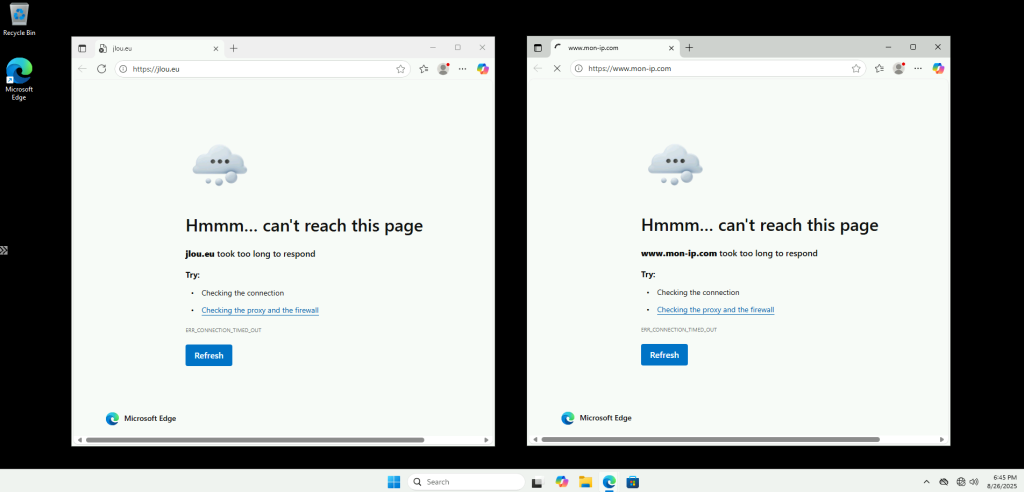

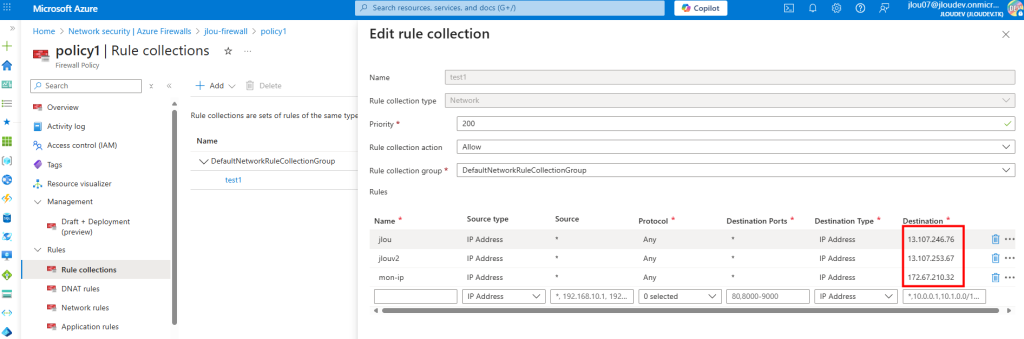

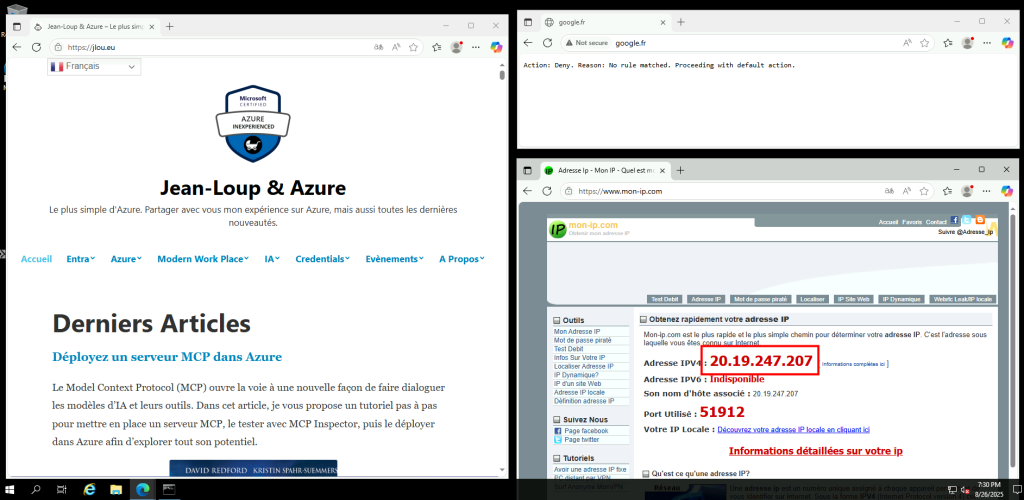

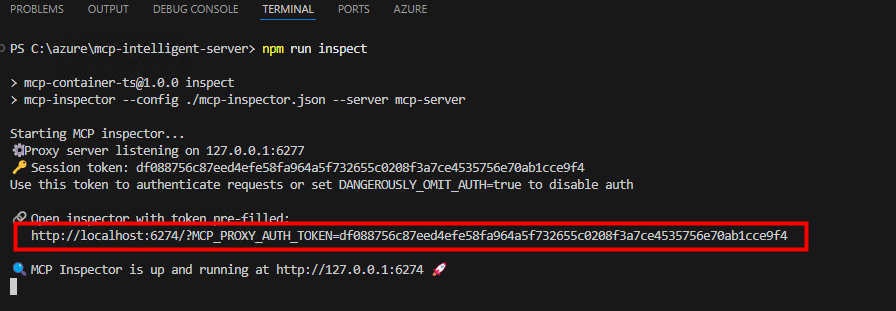

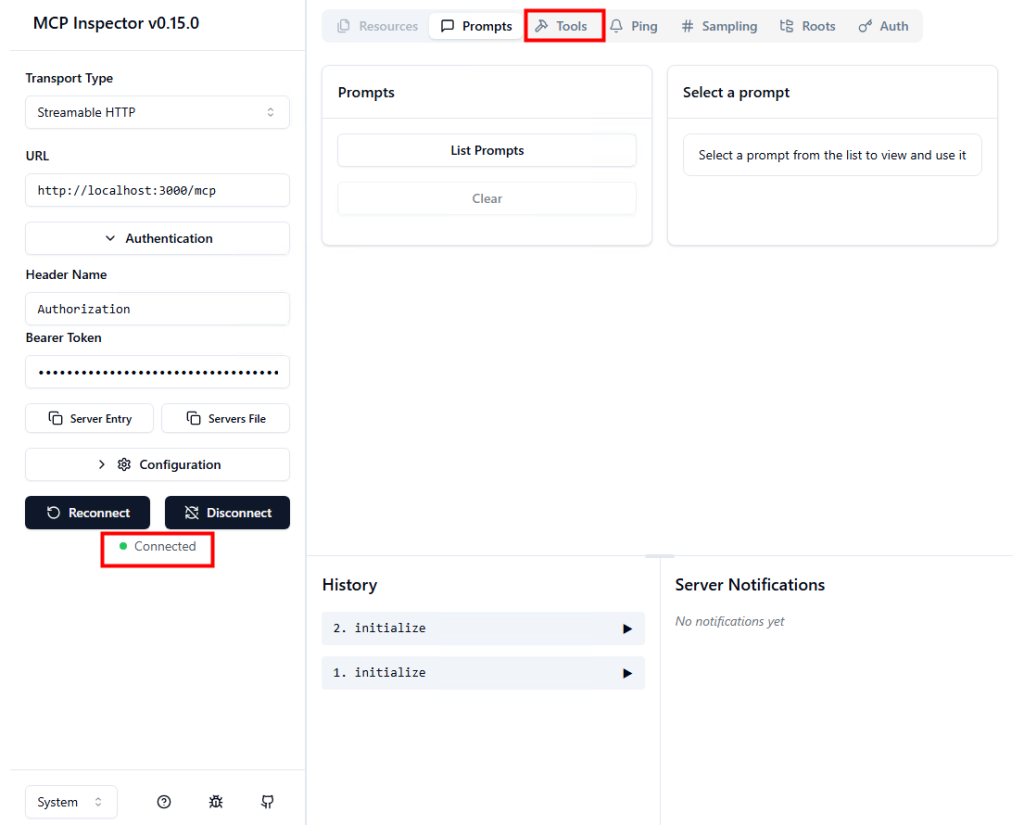

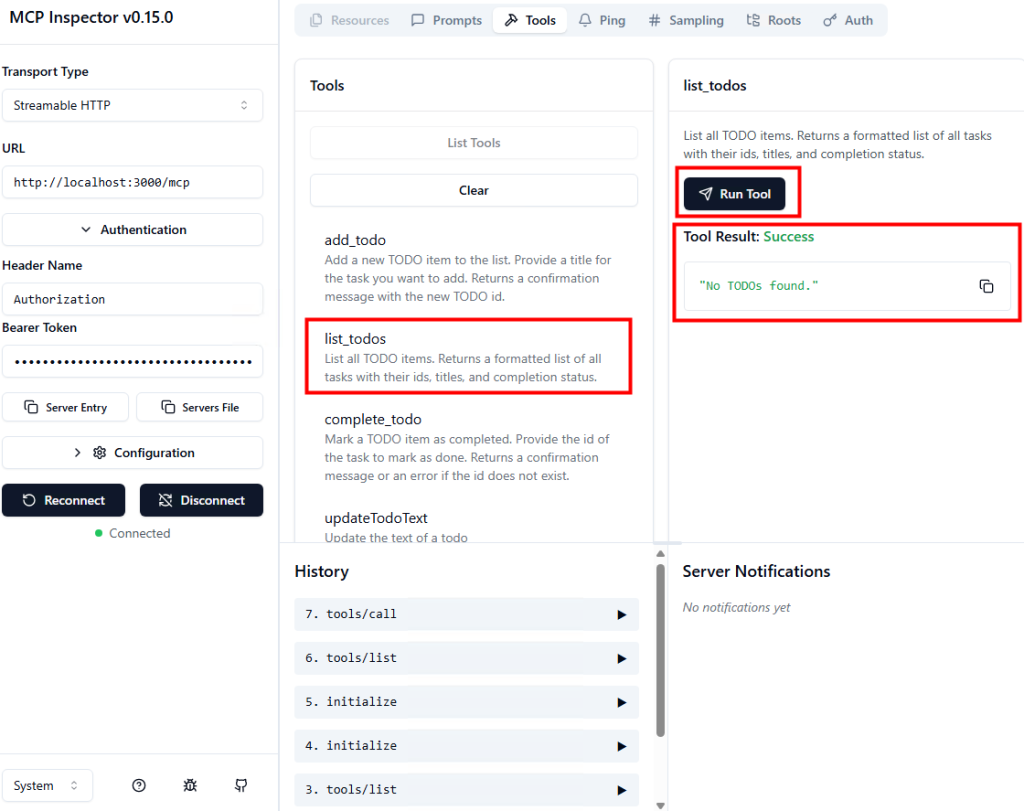

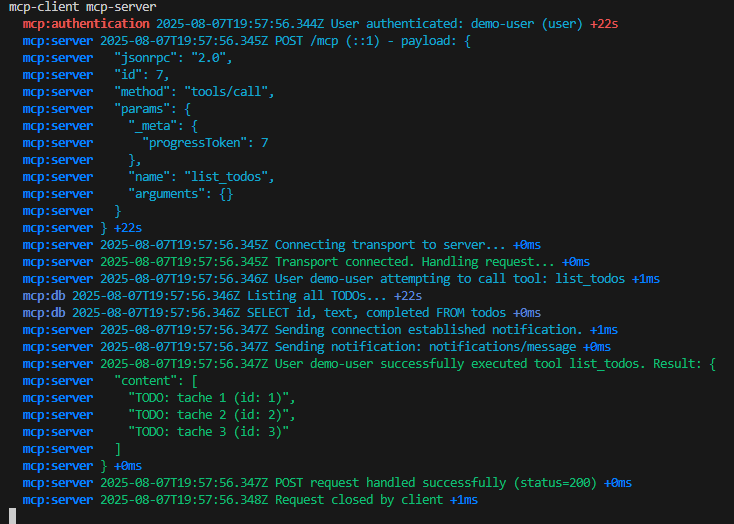

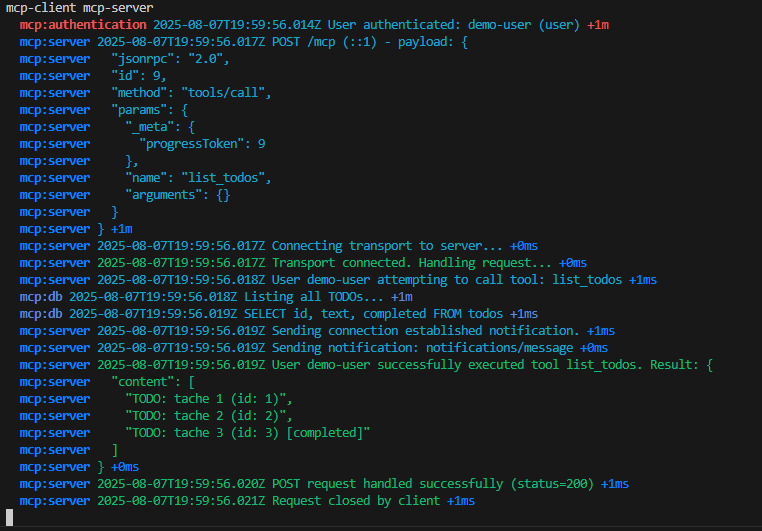

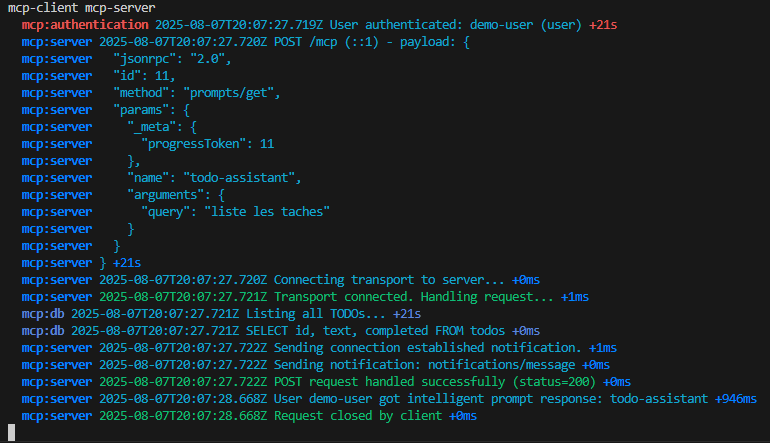

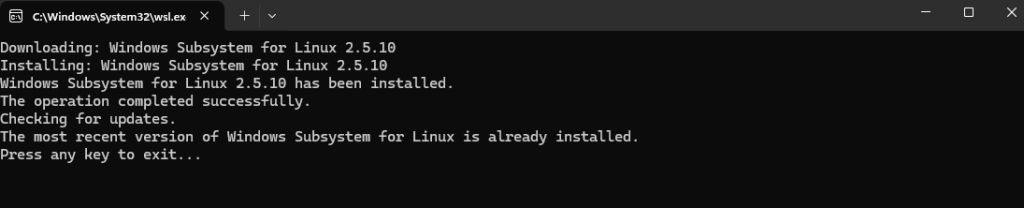

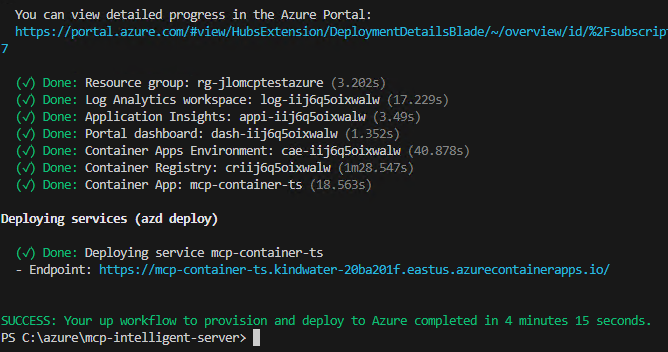

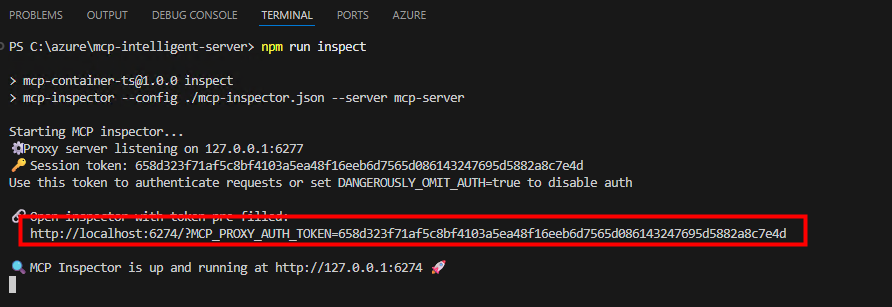

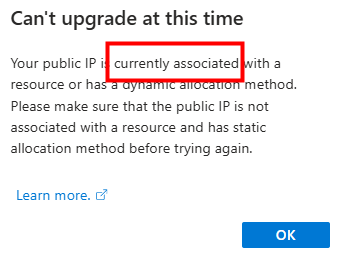

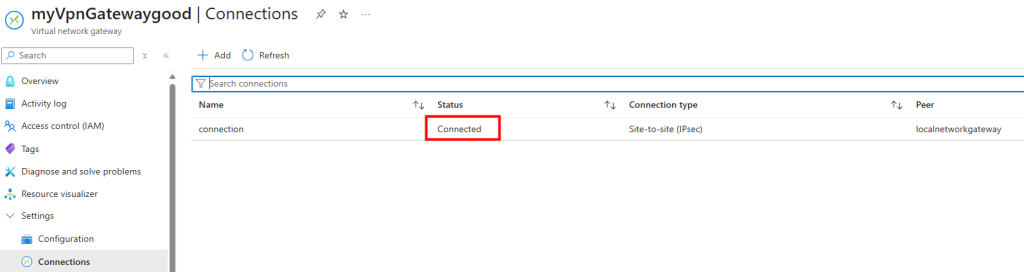

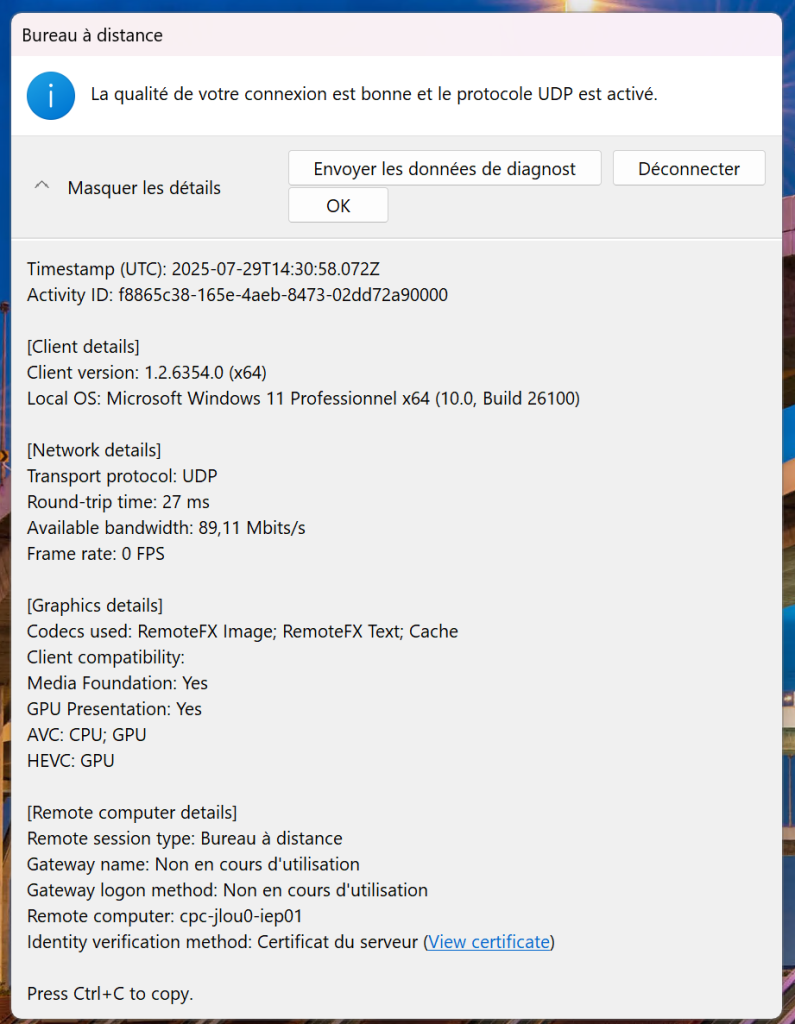

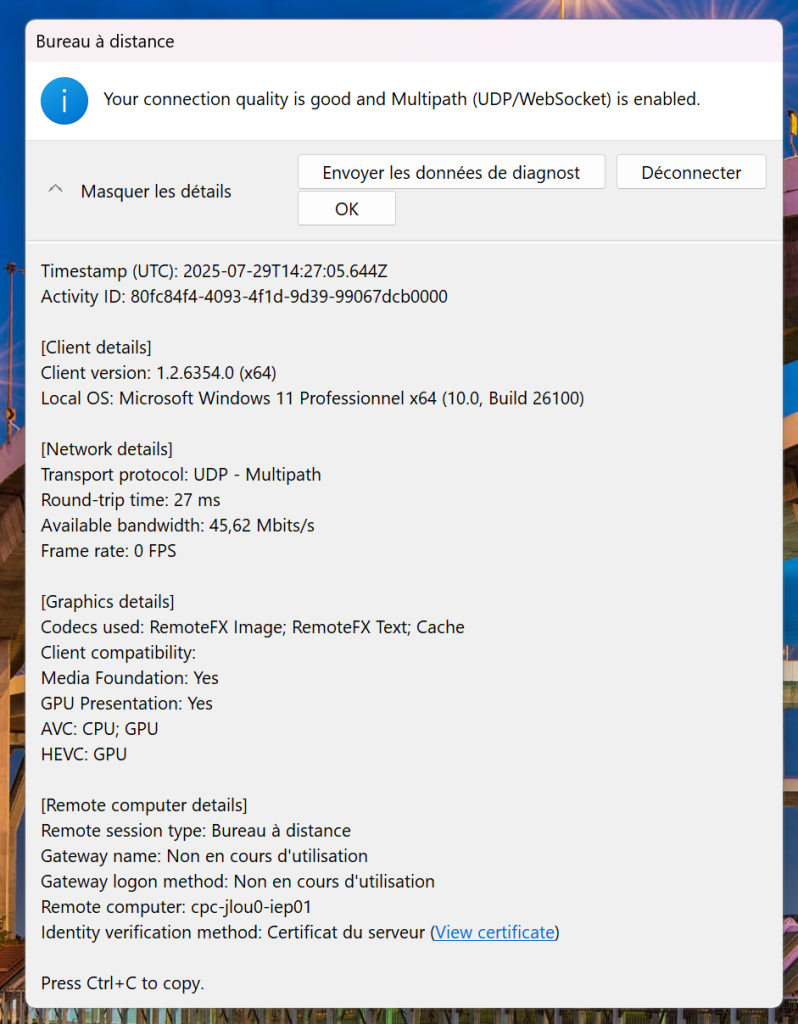

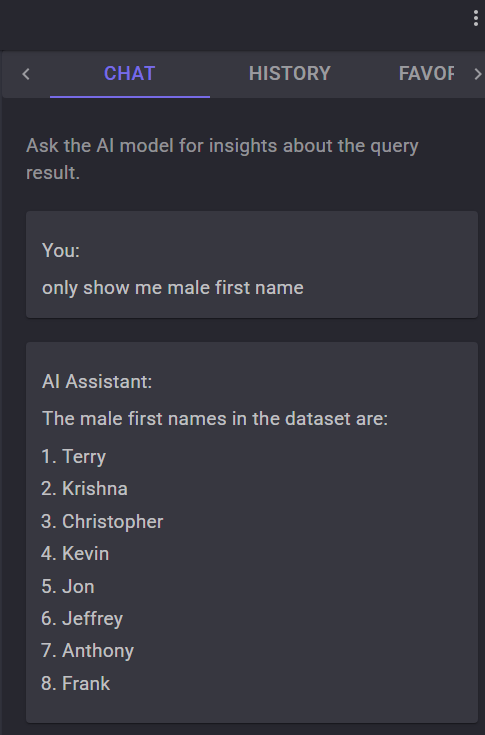

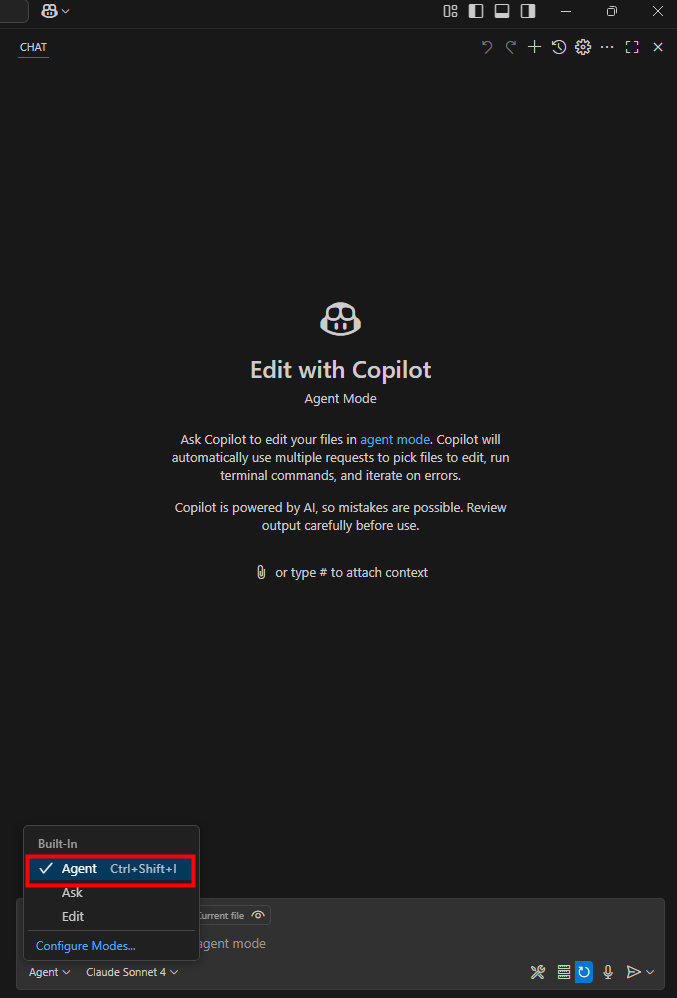

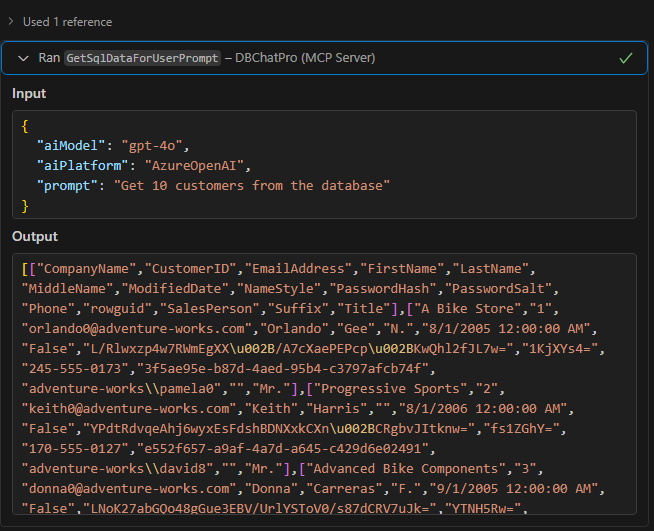

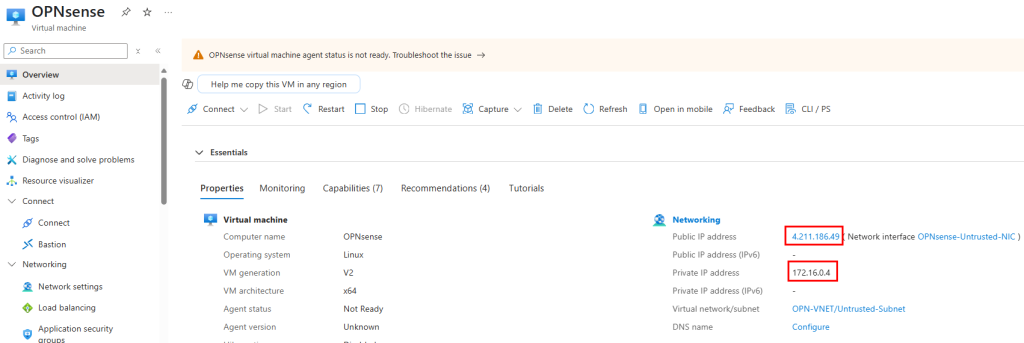

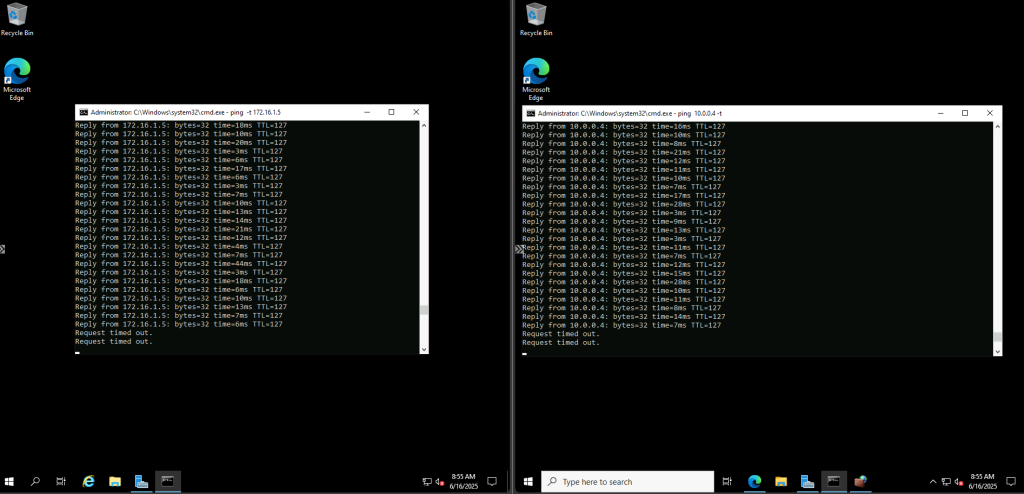

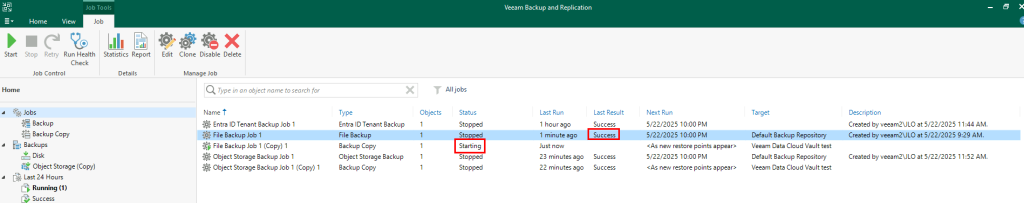

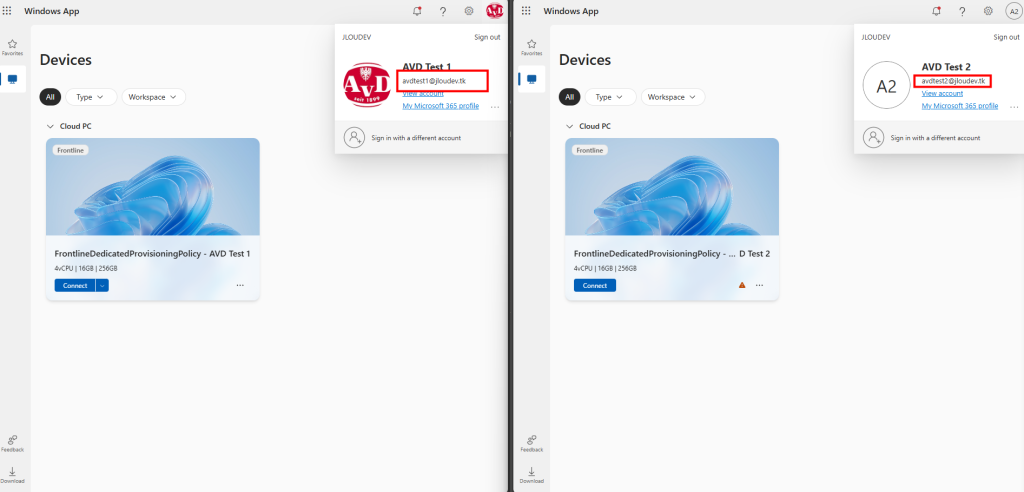

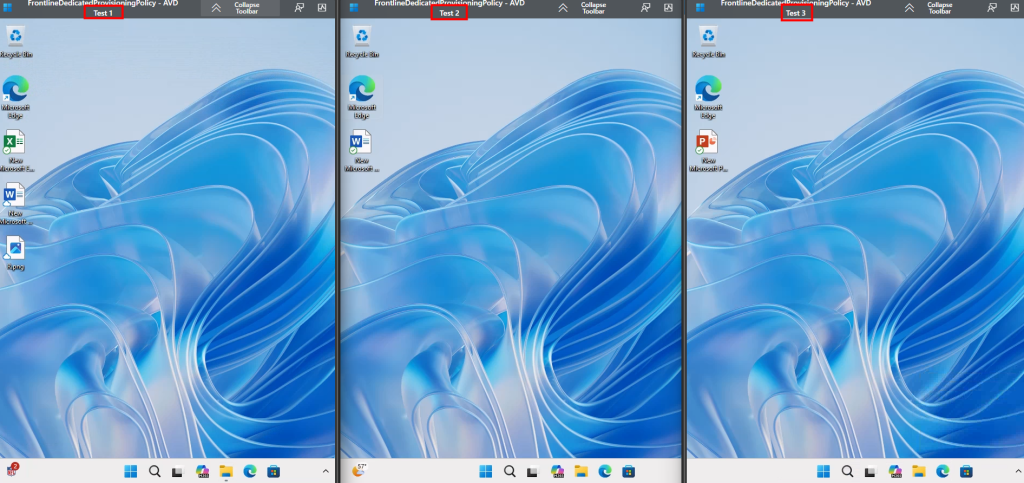

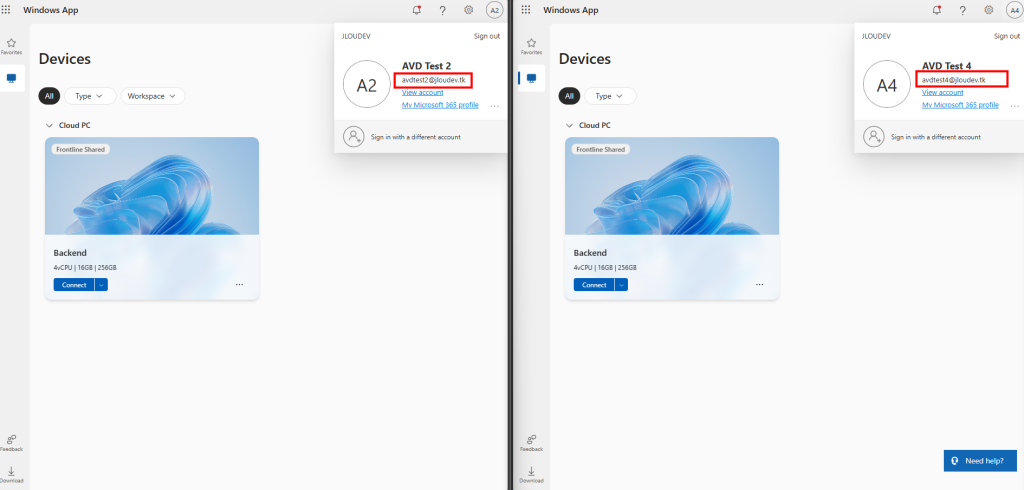

Je me connecte avec deux utilisateurs, en simultané, sur le portail Windows 365 Web :

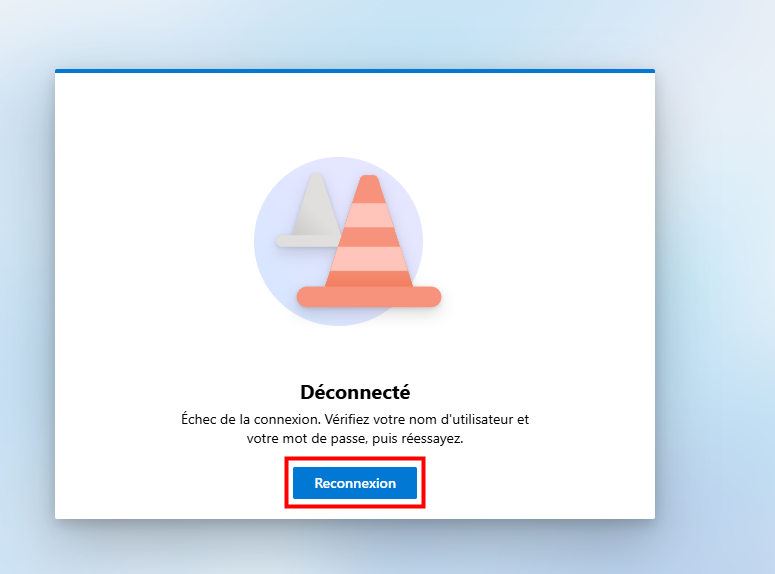

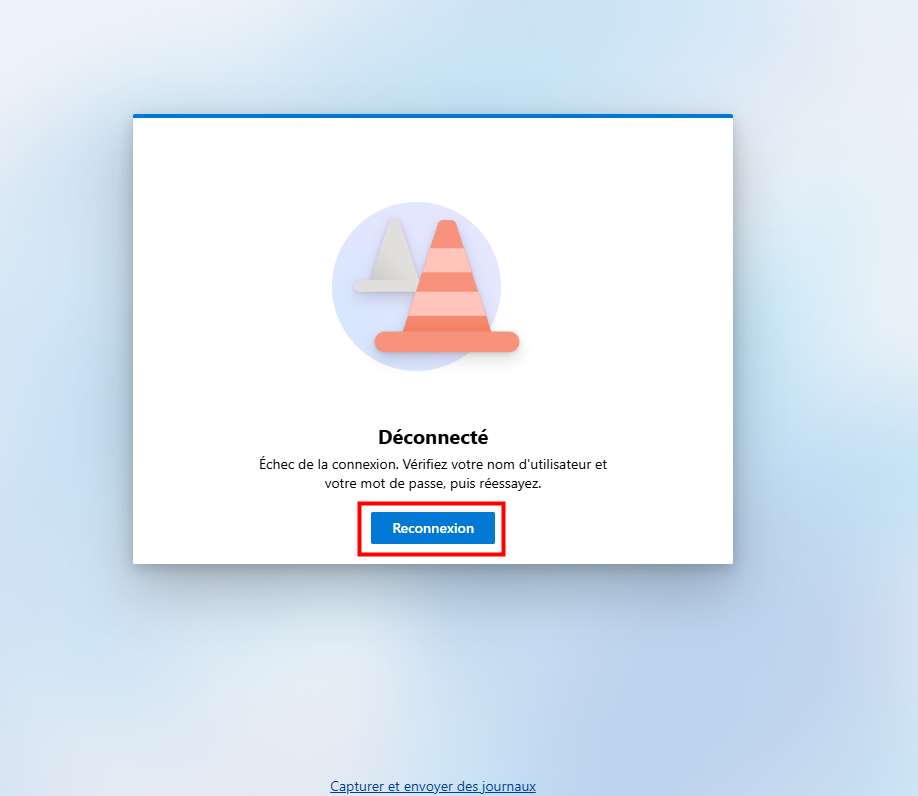

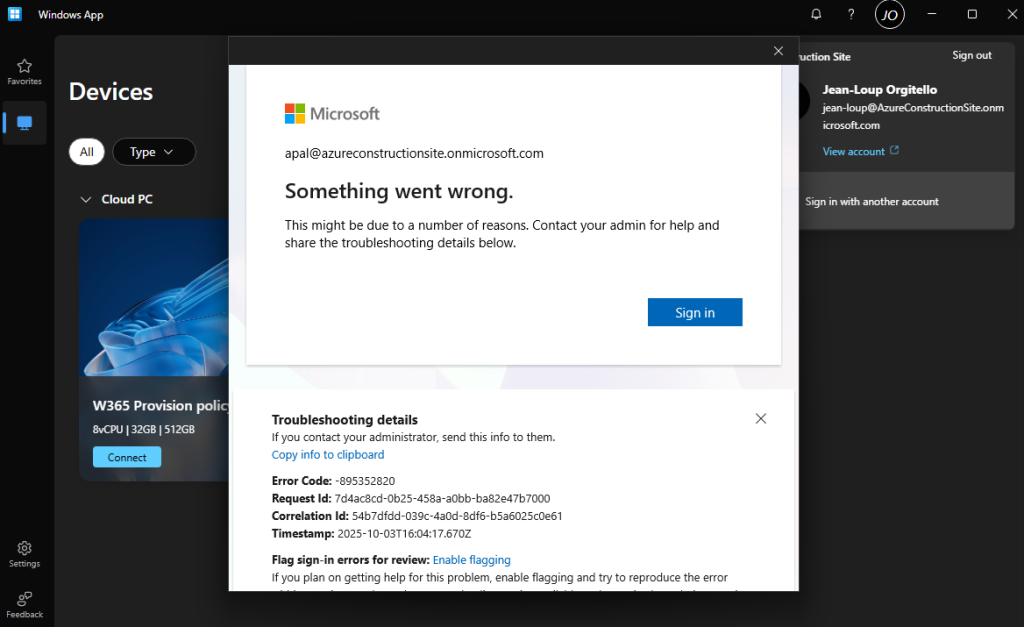

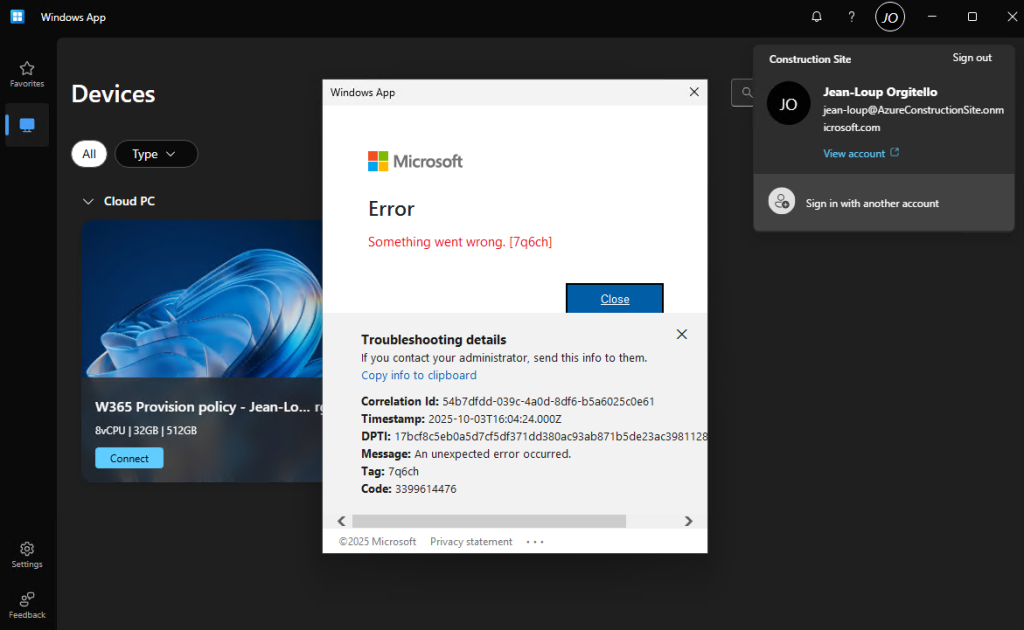

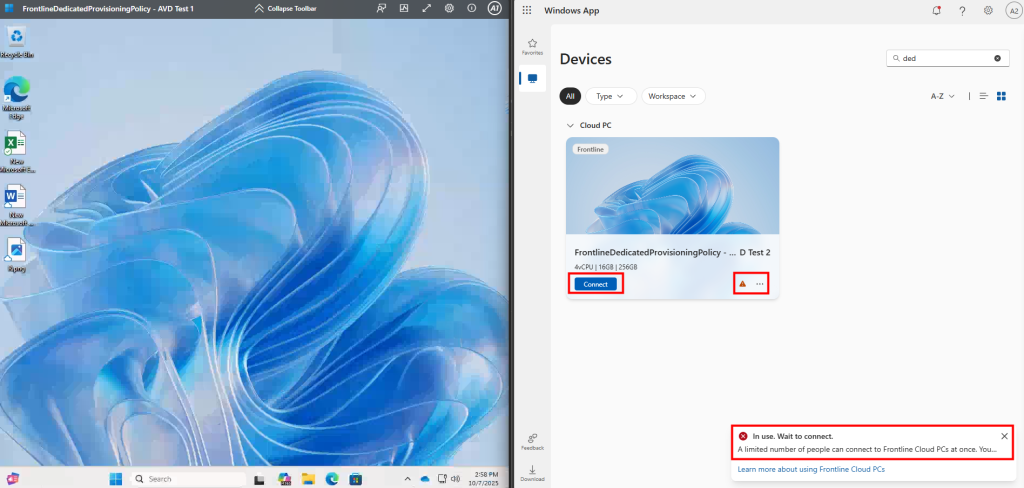

Le premier utilisateur se connecte avec succès à sa session, tandis que le second obtient un message l’informant qu’il ne peut pas accéder au Cloud PC, normal :

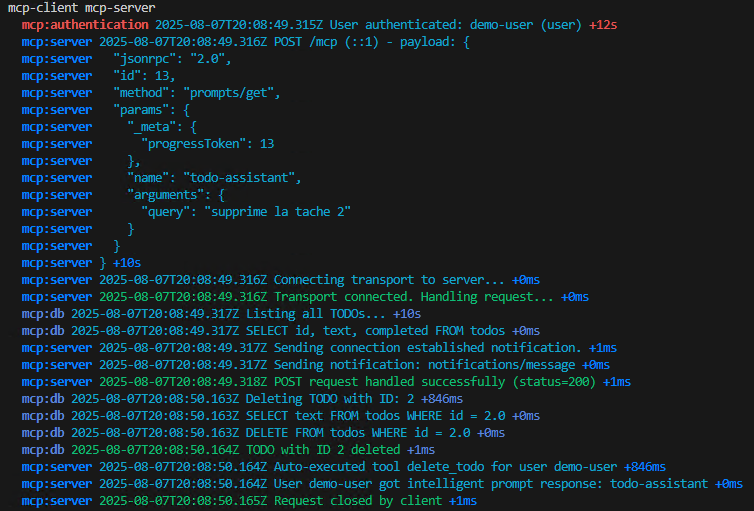

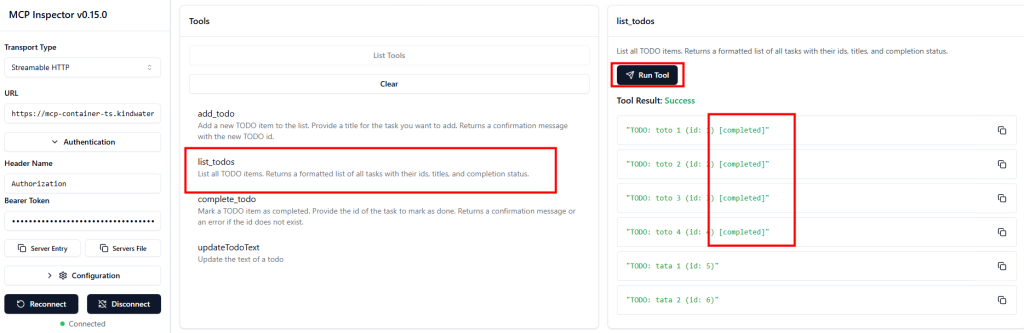

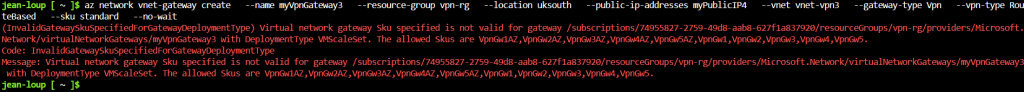

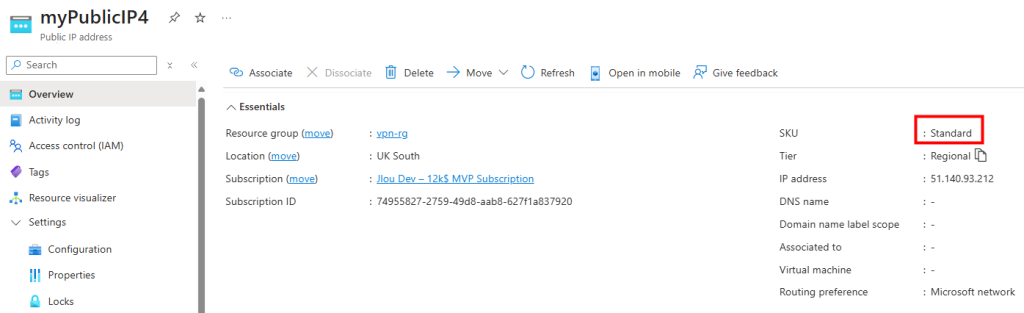

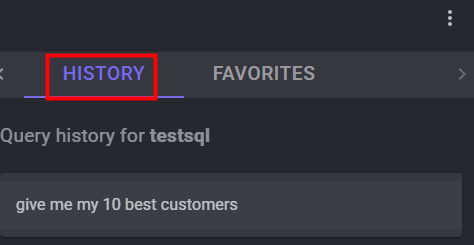

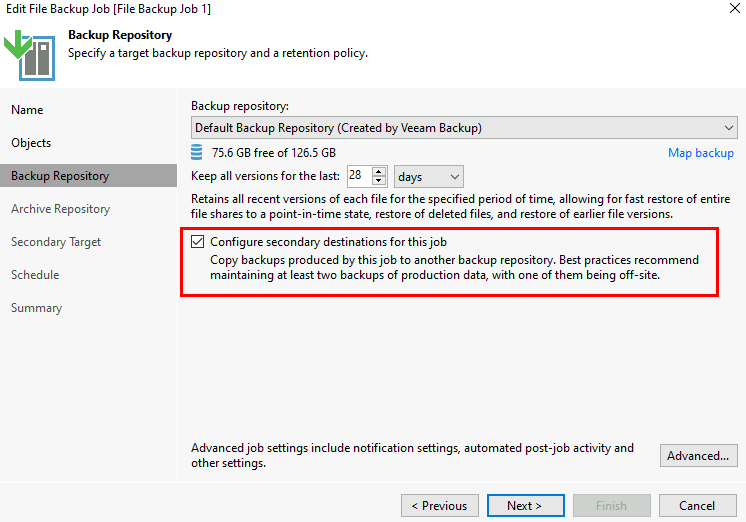

Je retourne sur la police de provisionnement et j’augmente le nombre d’instances Windows 365 à 2 pour cette police Frontline :

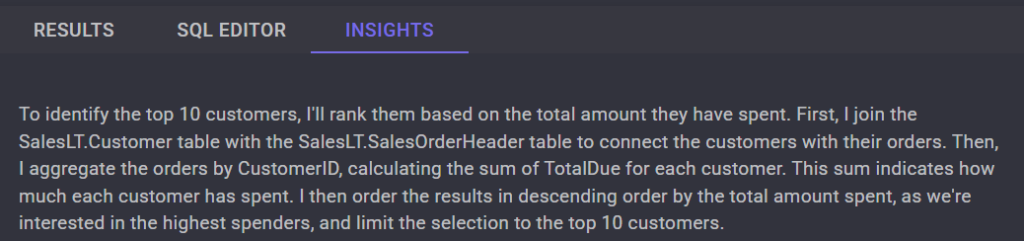

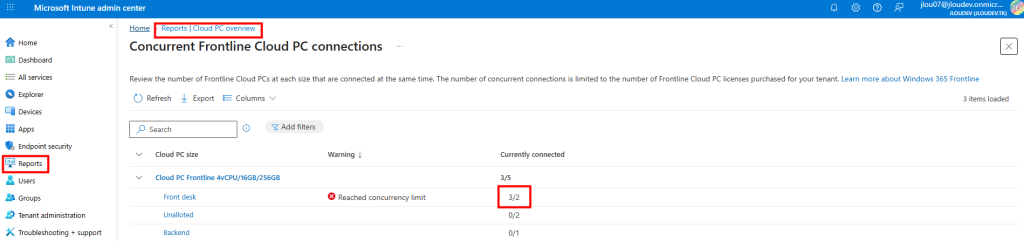

Je parviens cette fois à connecter trois utilisateurs en simultané, bien que la configuration n’autorise initialement que deux sessions :

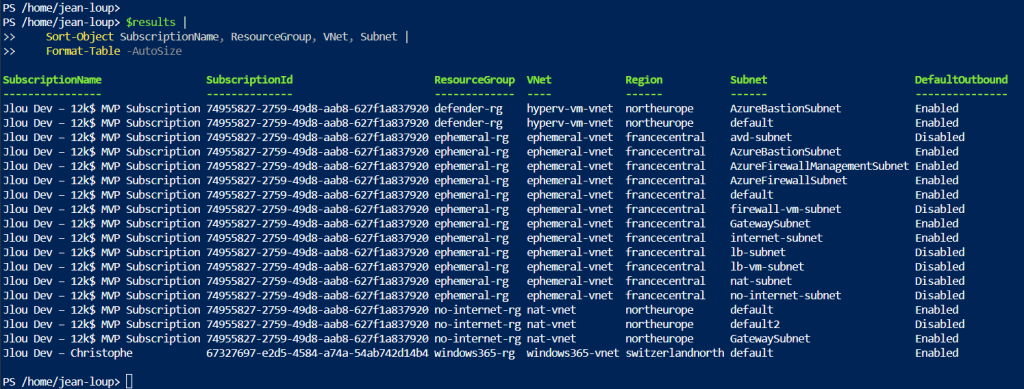

Dans les rapports Intune, on constate que la plateforme signale une surcapacité, mais qu’elle a tout de même permis la connexion grâce à la marge de tolérance (buffering) intégrée :

Voici d’ailleurs quelques règles du concurrency buffer pour Windows 365 Frontline :

- Le concurrency buffer permet de dépasser temporairement la limite maximale de connexions simultanées permises par les licences Frontline dans des cas de transition comme le changement de shift

- Le concurrency buffer ne s’applique pas aux Cloud PCs GPU-enabled ni au mode Frontline Shared.

- Il peut être utilisé jusqu’à 4 fois par jour, pour un maximum d’1 heure à chaque activation. L’heure commence dès le dépassement de la limite de licences.

- Si le buffer est utilisé de façon excessive (par exemple plus d’une heure à quatre reprises dans 24 heures), un blocage temporaire est activé pendant 48 heures, empêchant toute utilisation du buffer.

- Si le tenant subit plus de deux blocages temporaires sur une période de 7 jours, le buffer peut être bloqué de façon permanente. Dans ce cas, il faut ouvrir un ticket auprès du support Intune pour restaurer l’accès.

- Pendant le blocage (temporaire ou permanent), les utilisateurs peuvent toujours se connecter, mais uniquement jusqu’à la limite standard de licences (le buffer n’est plus accessible).

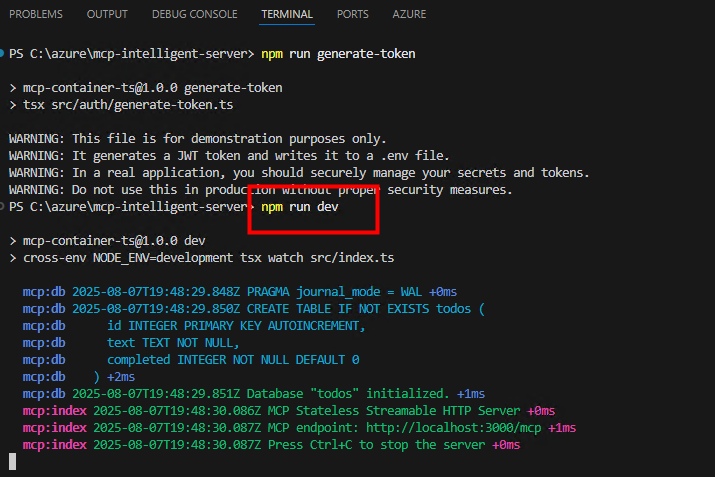

Continuons par par tester les Cloud PCs Frontline partagés à des utilisateurs.

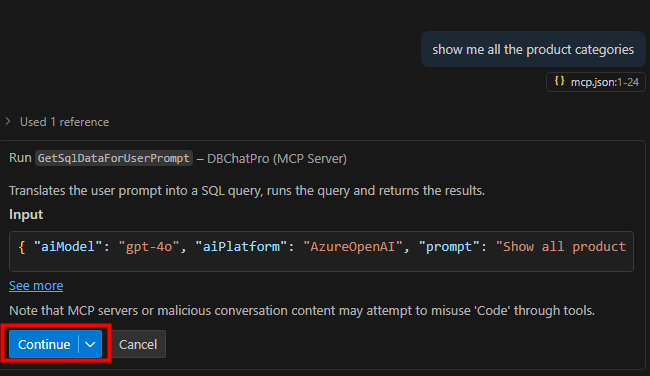

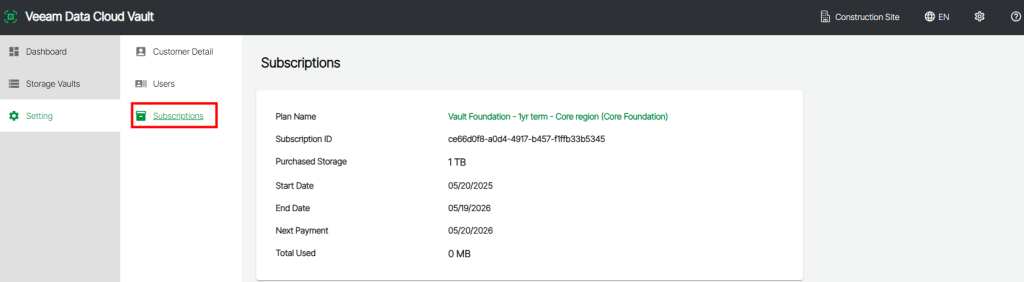

Test II – Test de Windows 365 Frontline Partagé :

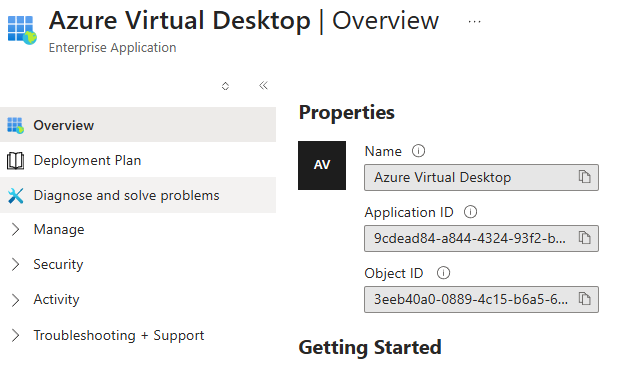

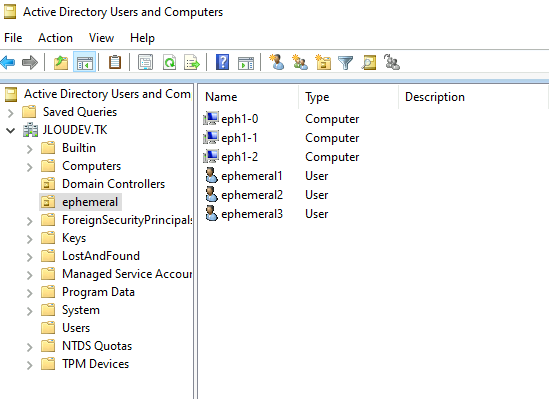

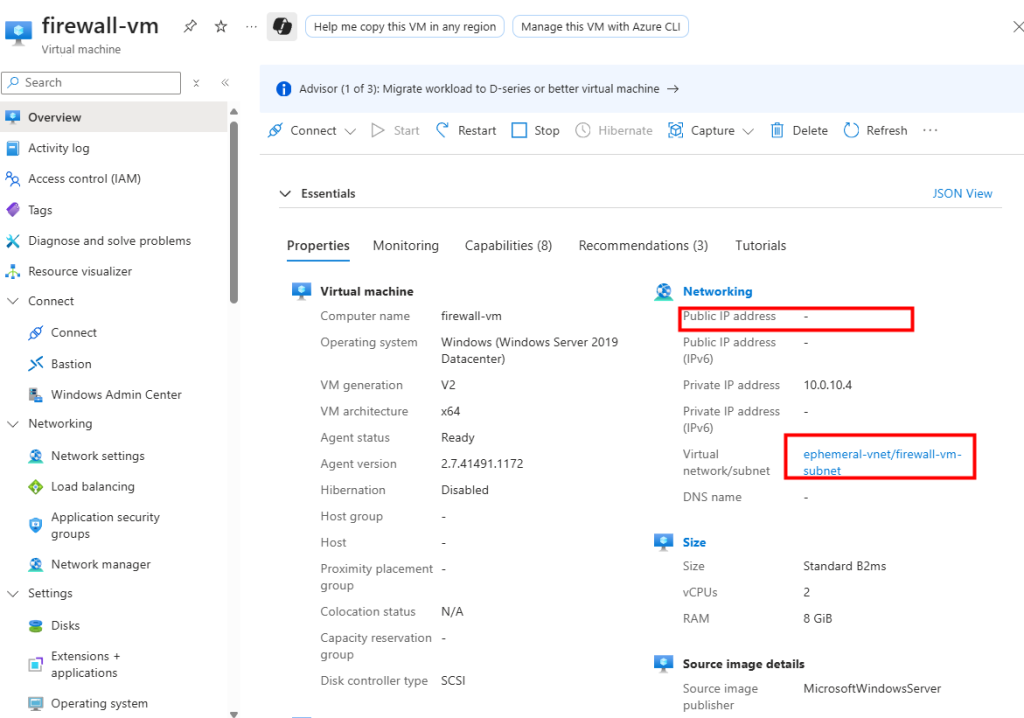

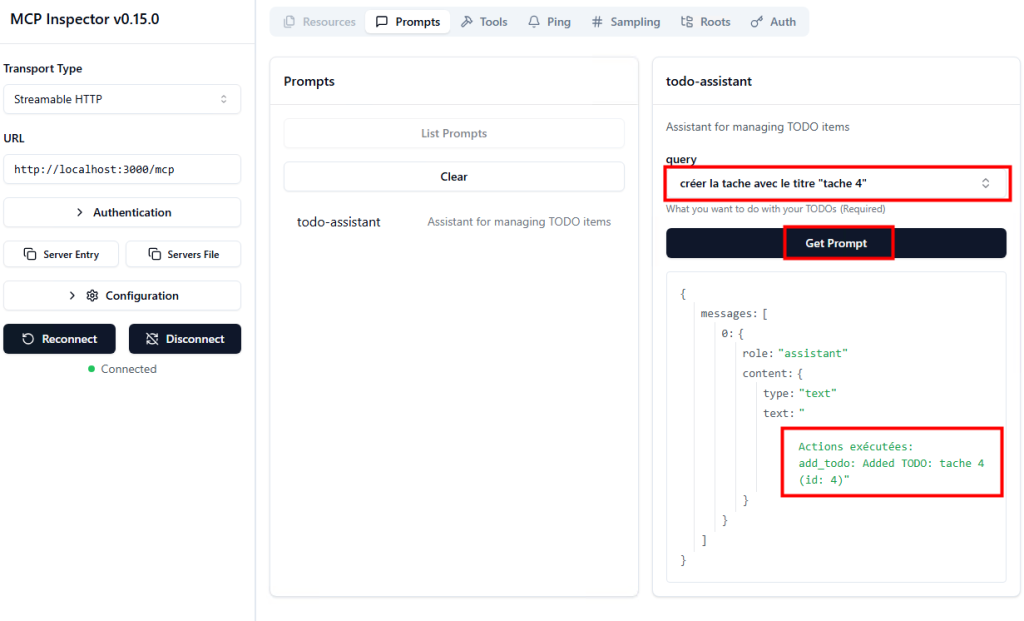

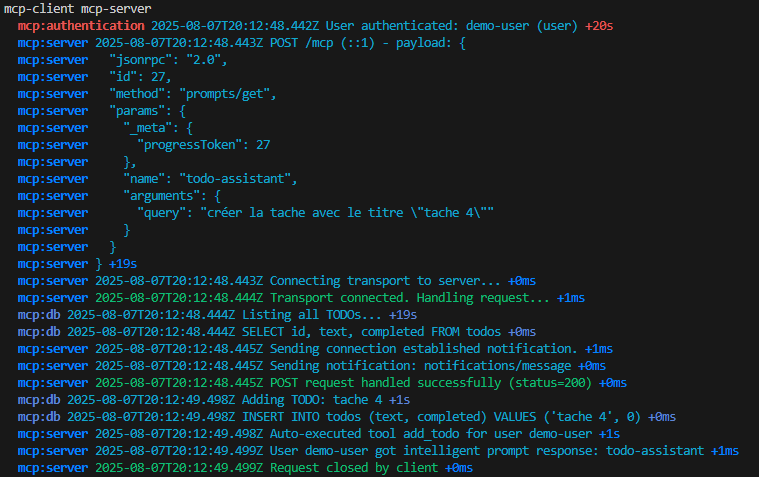

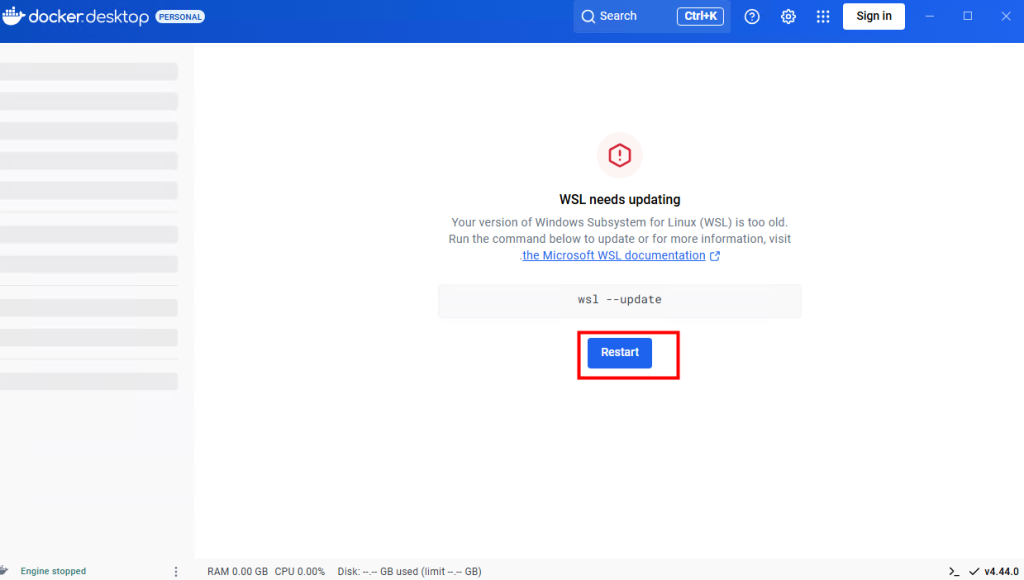

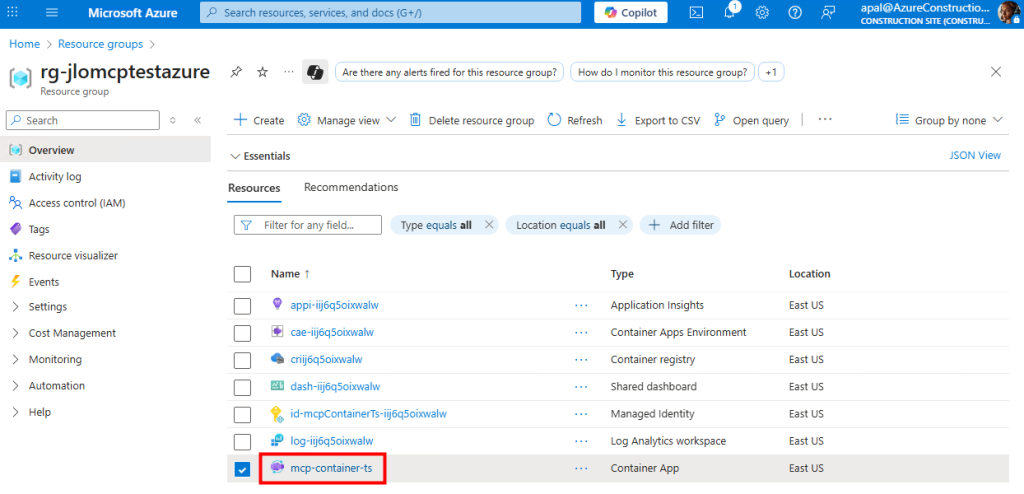

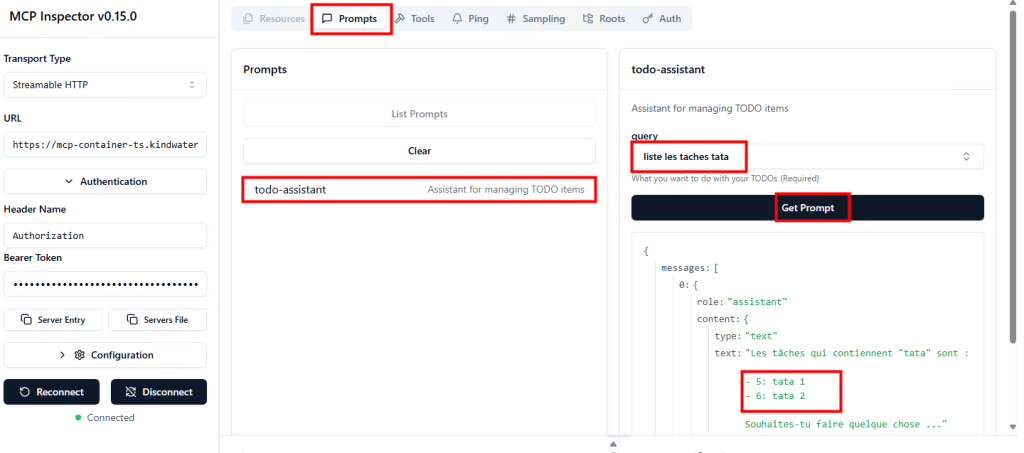

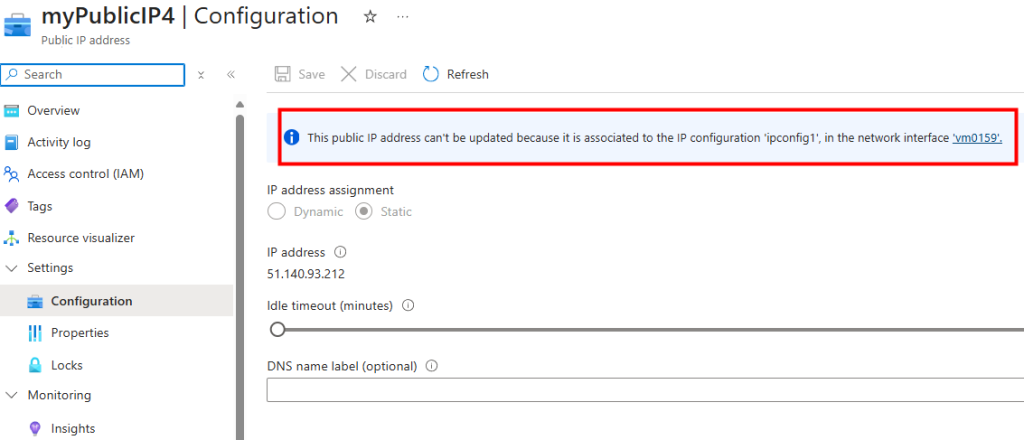

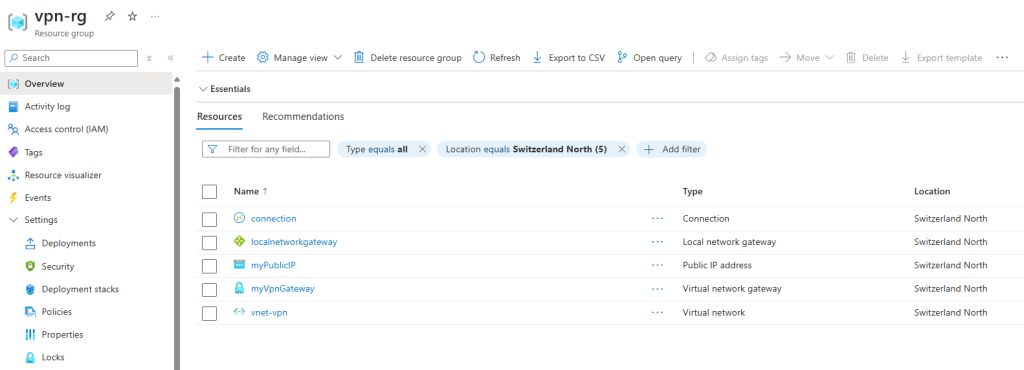

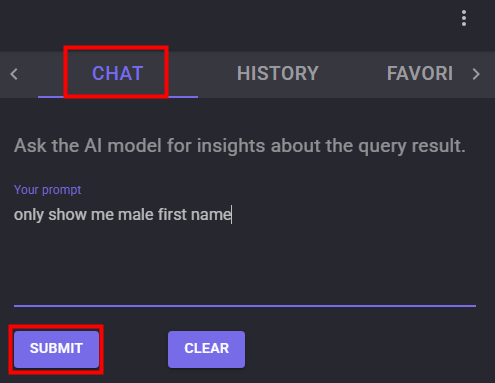

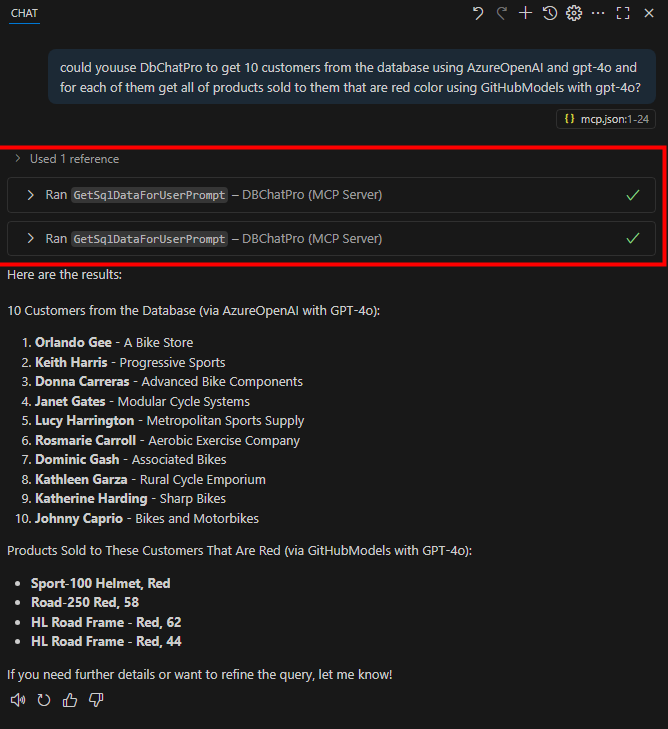

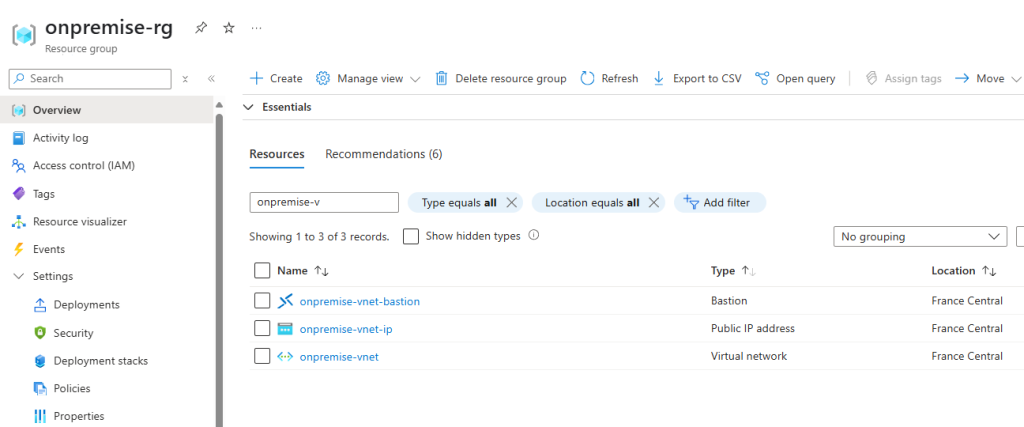

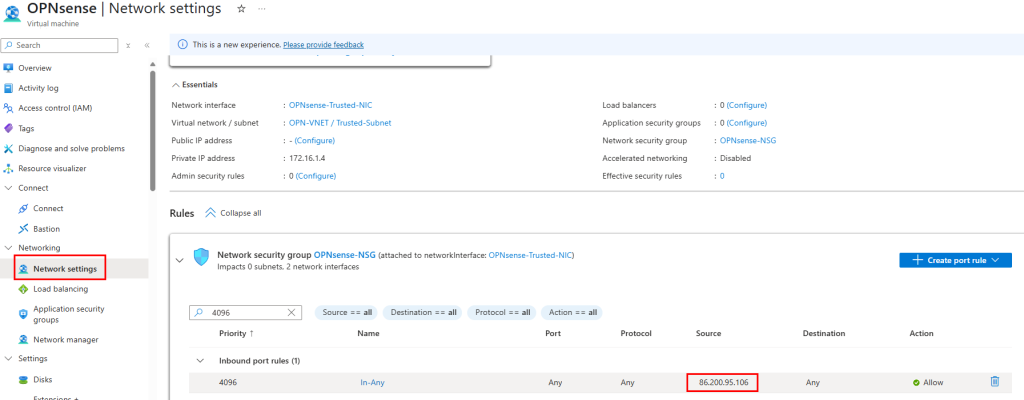

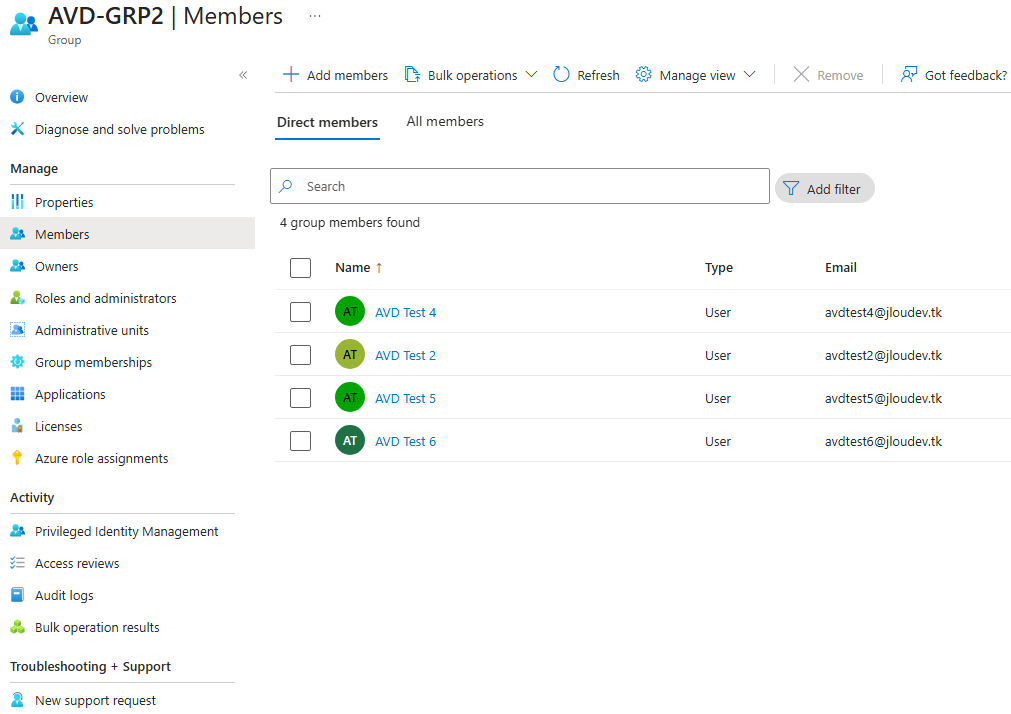

J’ai créé un second groupe dans le portail Entra ID pour mes utilisateurs de test :

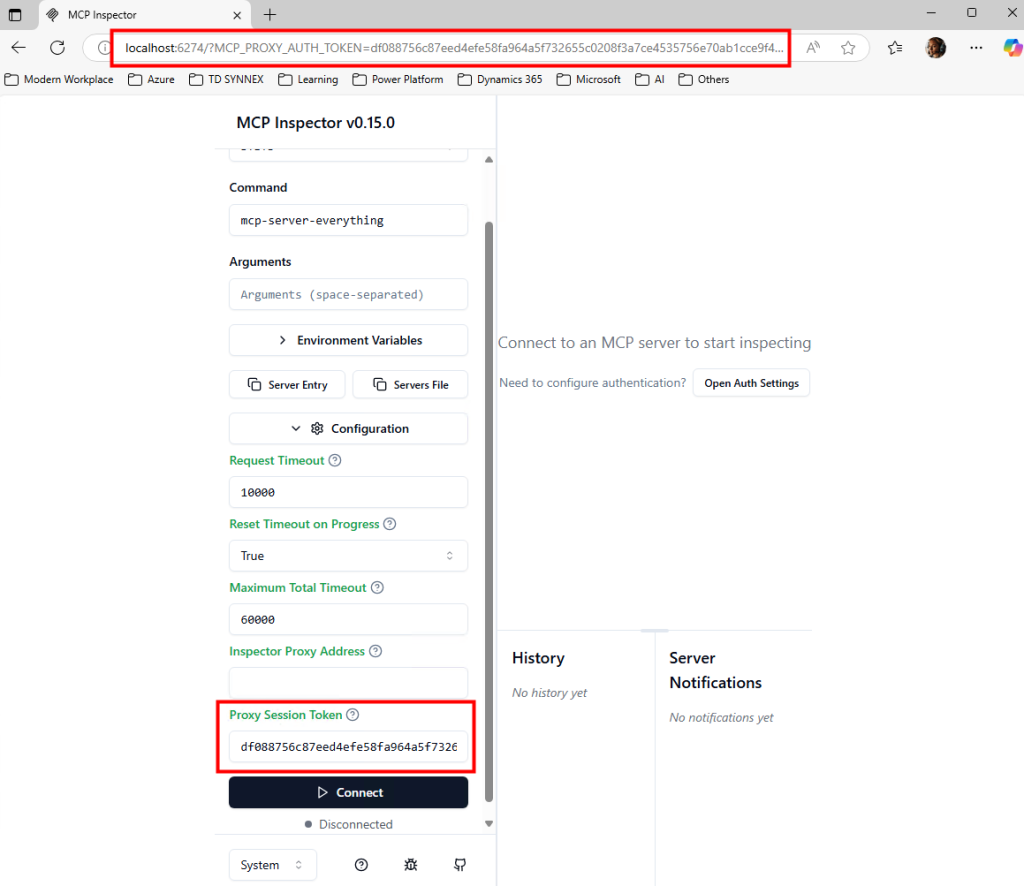

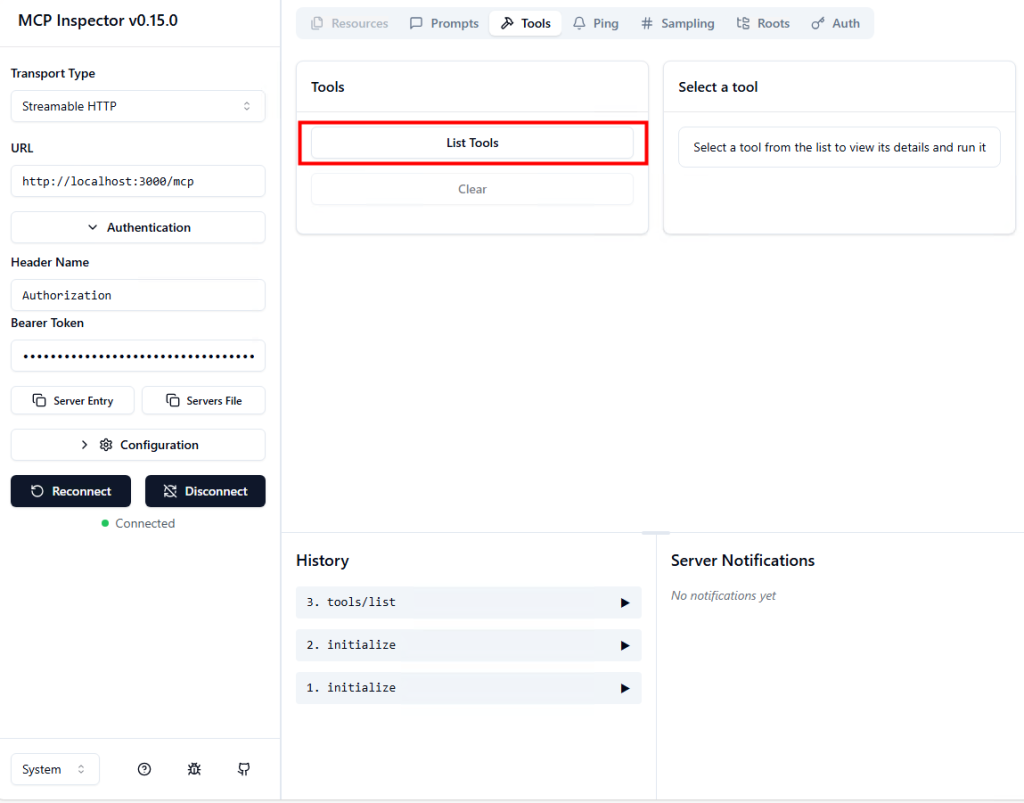

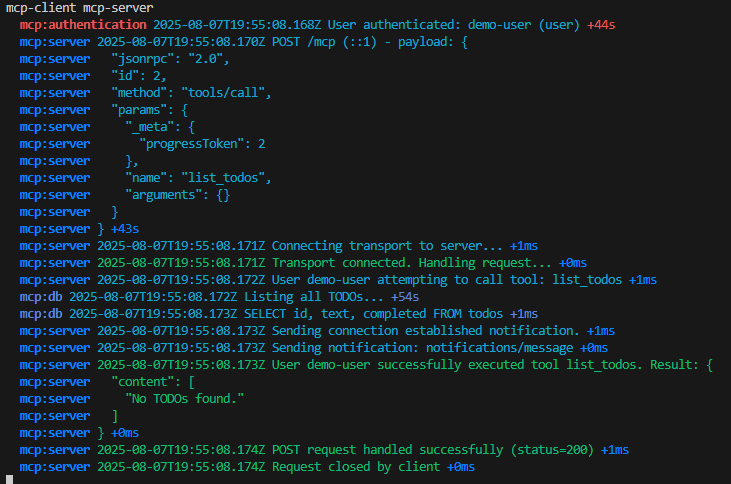

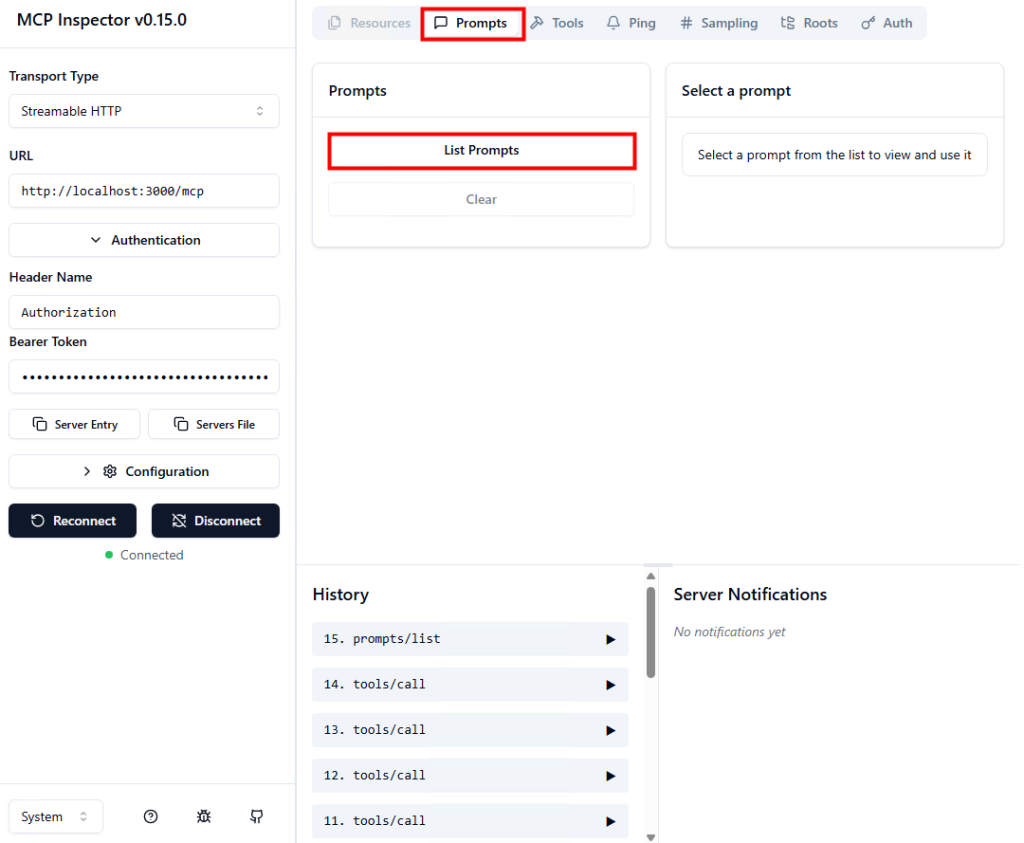

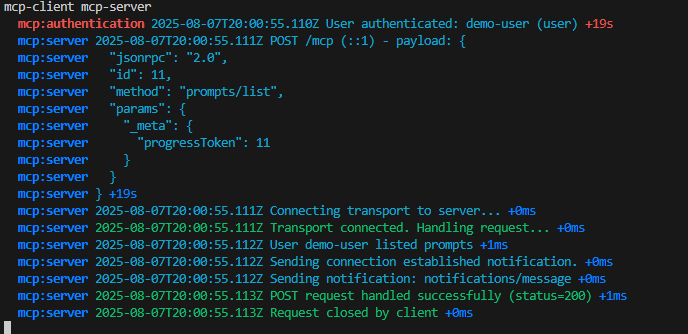

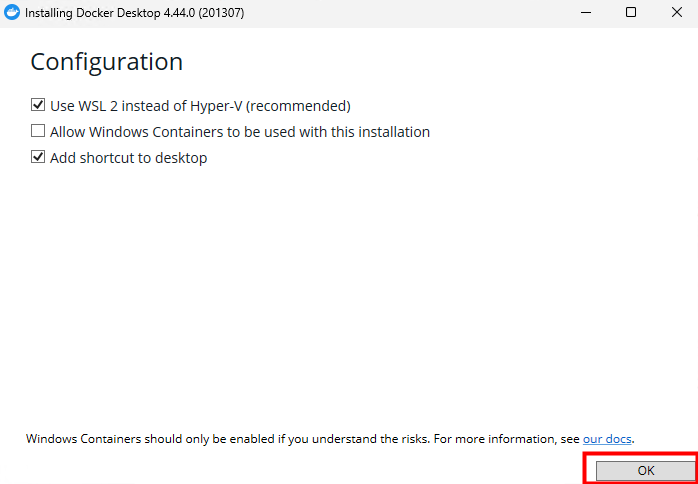

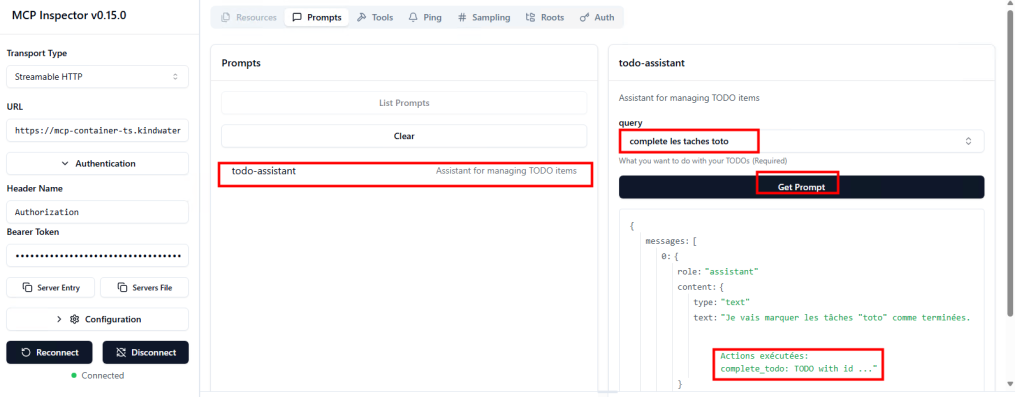

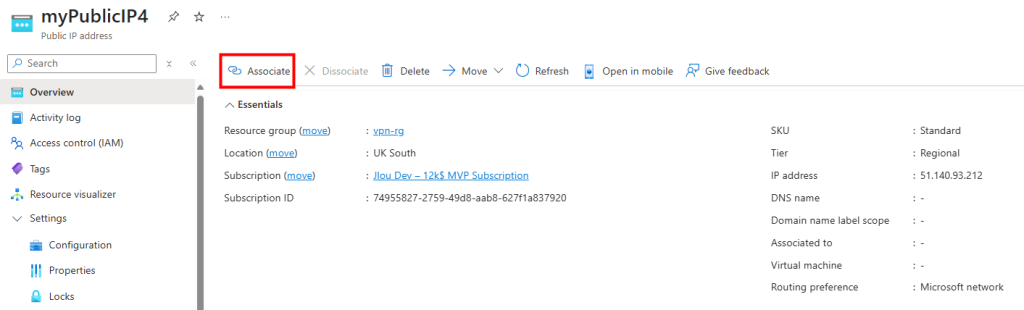

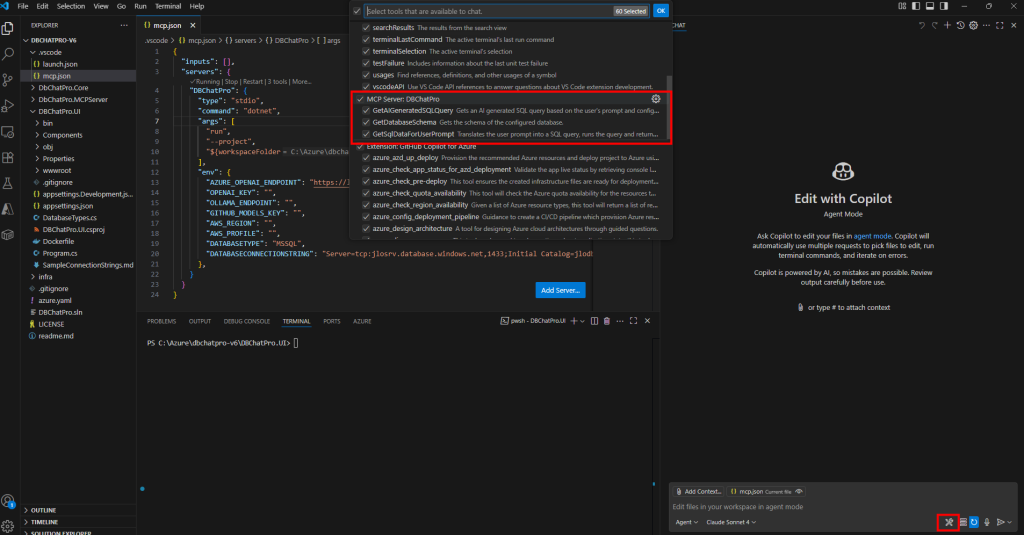

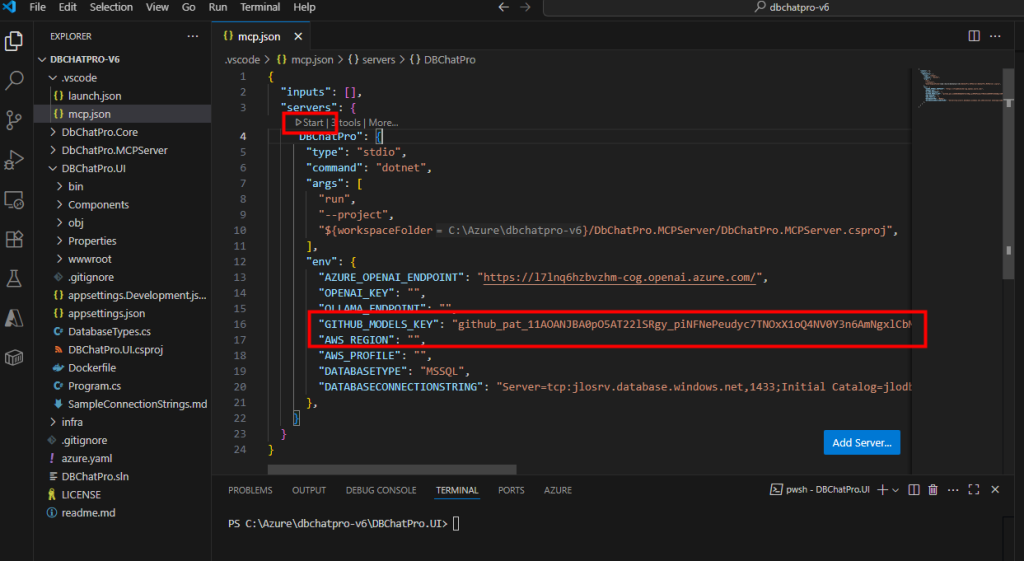

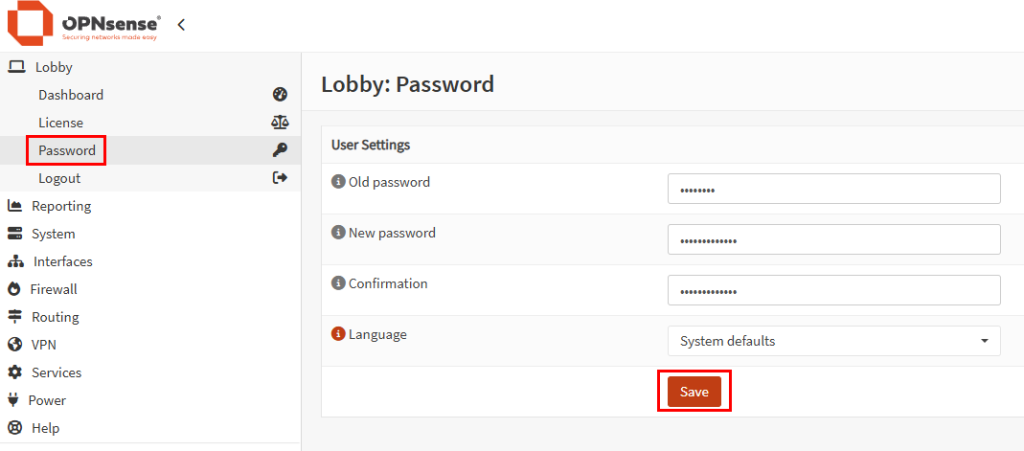

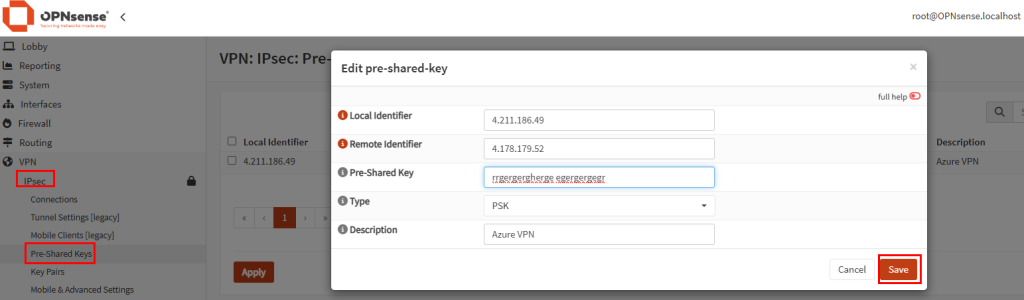

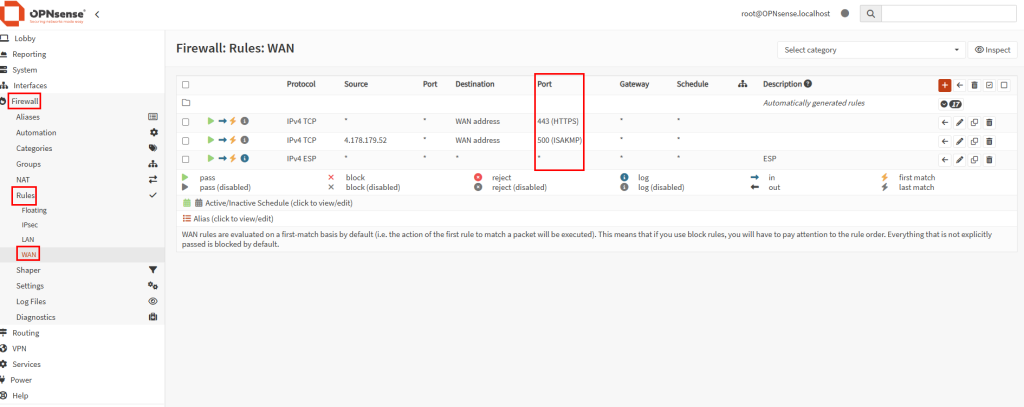

Sur le portail Intune, dans la section Stratégies Windows 365, et je crée une seconde police de provisionnement :

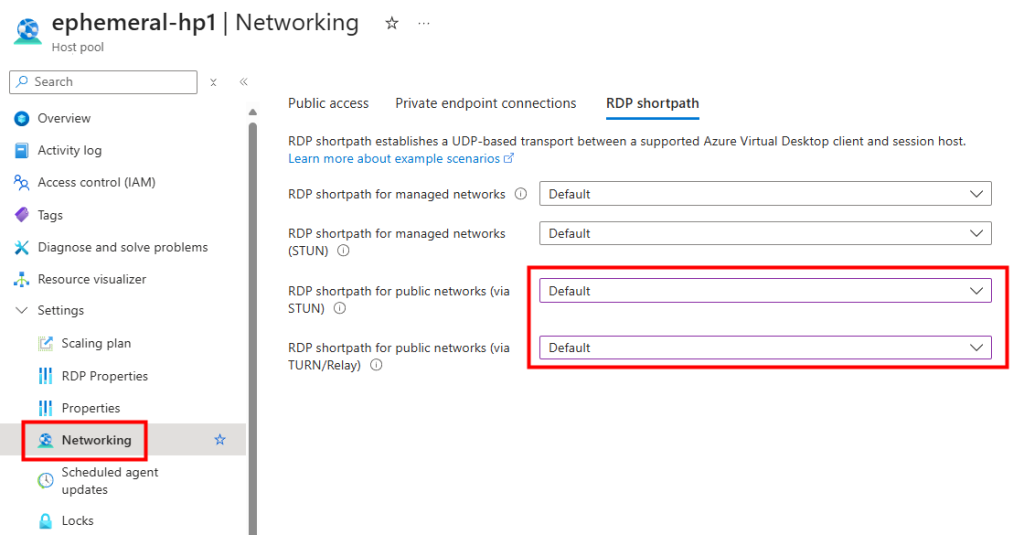

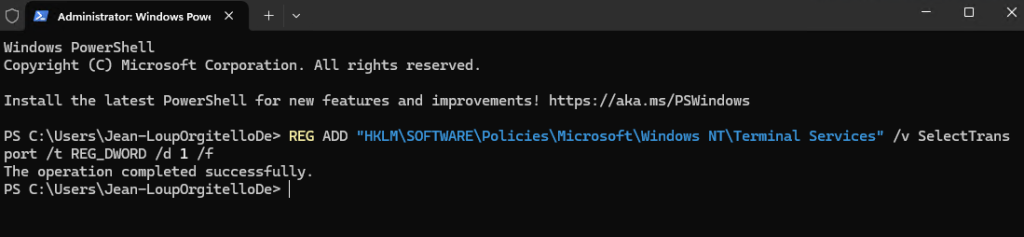

Je nomme ma stratégie, je sélectionne le type Frontline, le mode Shared, je choisis la jointure Entra ID et j’active le SSO :

Je sélectionne une image Windows 11 pour mes Cloud PCs :

Je clique sur Suivant :

Je clique sur Suivant :

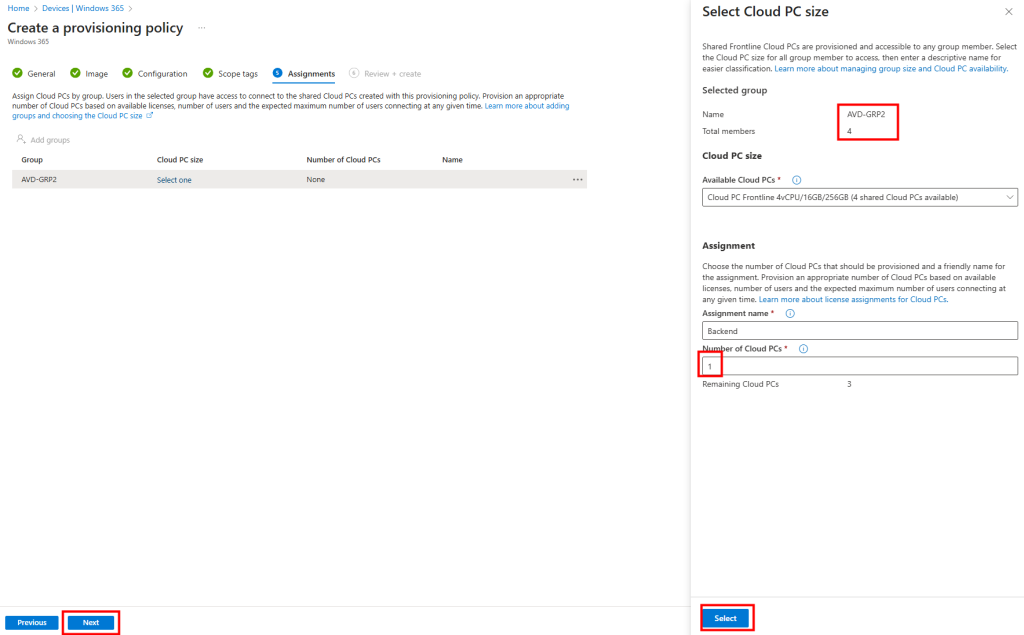

Je choisie la taille des Cloud PCs, ainsi que leur nombre :

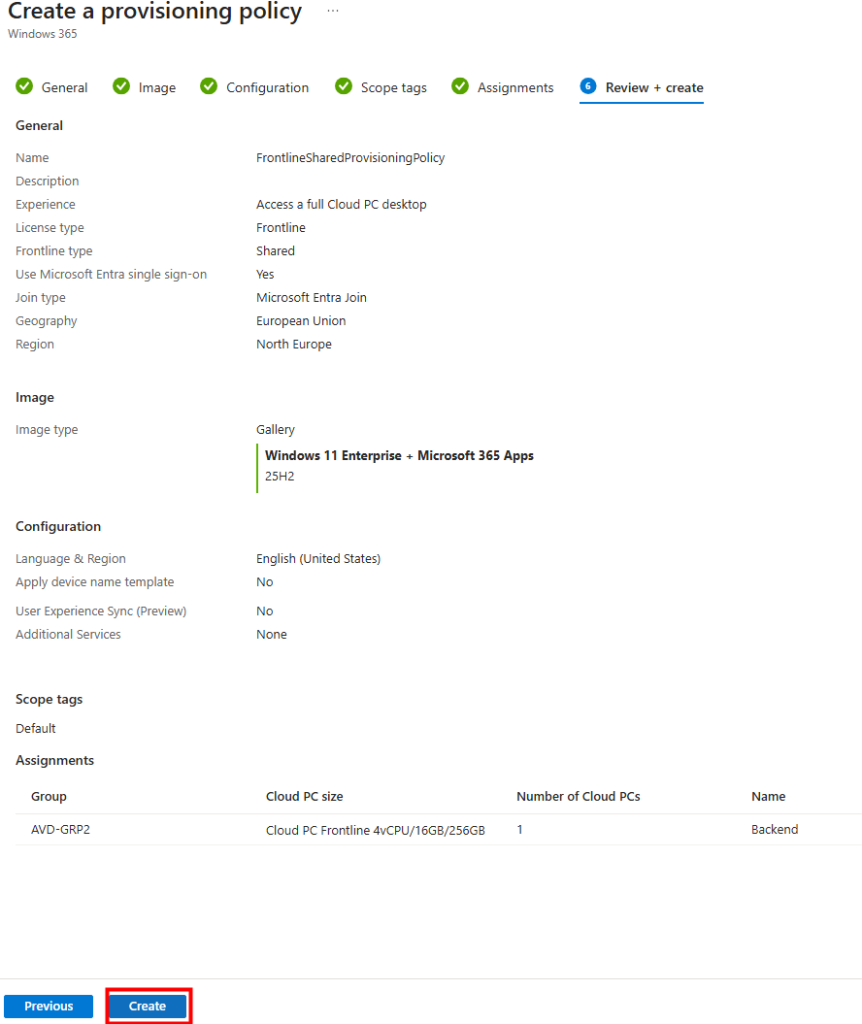

Je clique sur Créer pour valider ma nouvelle police de provisionnement :

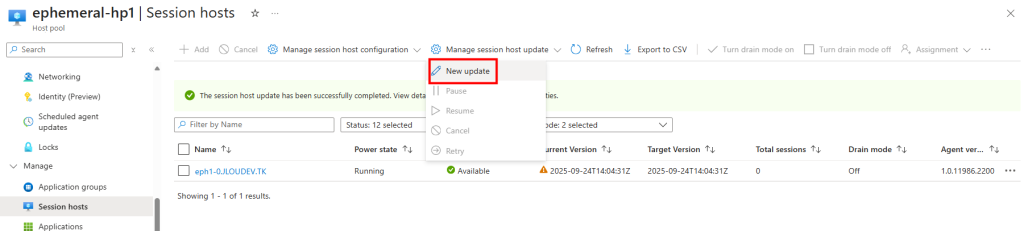

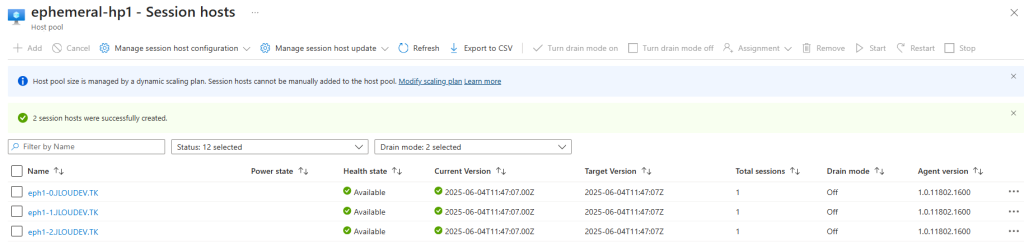

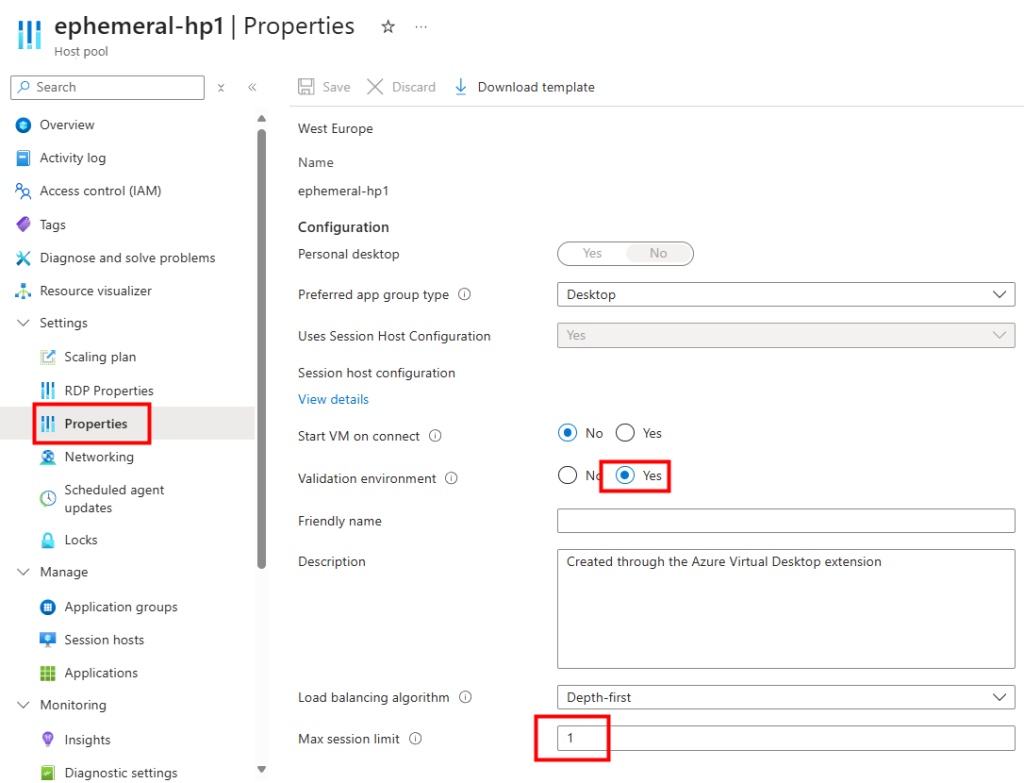

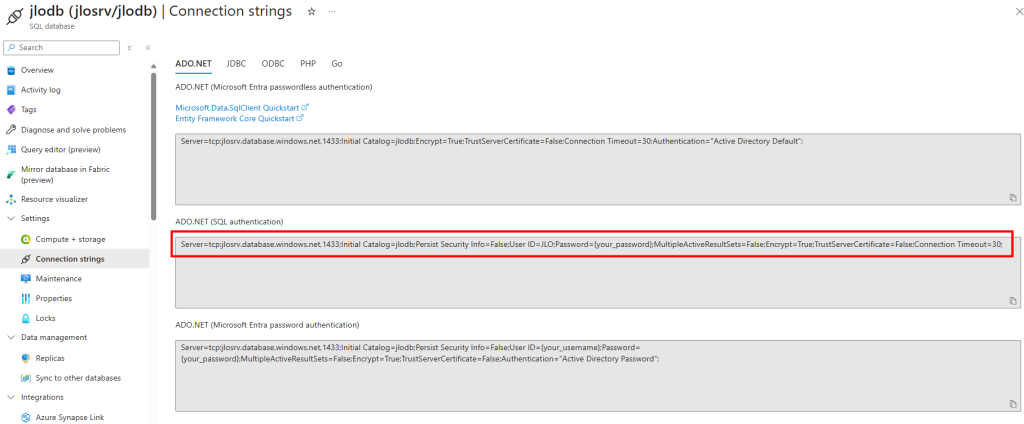

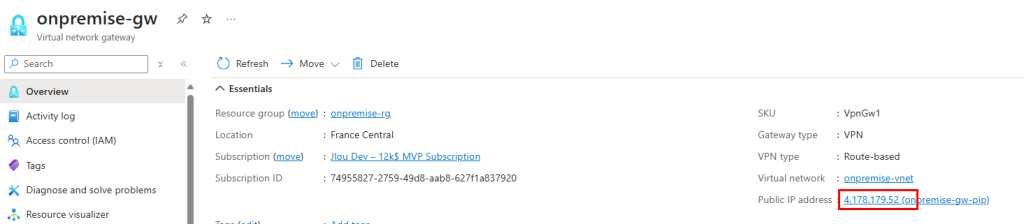

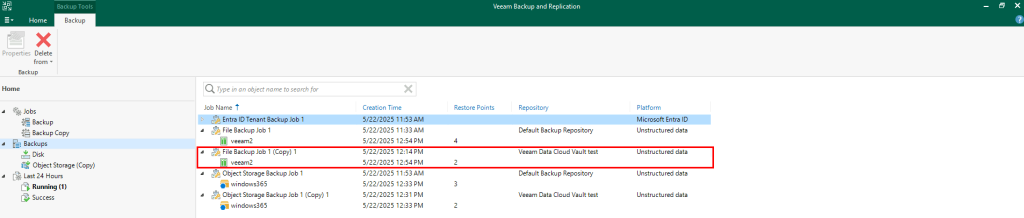

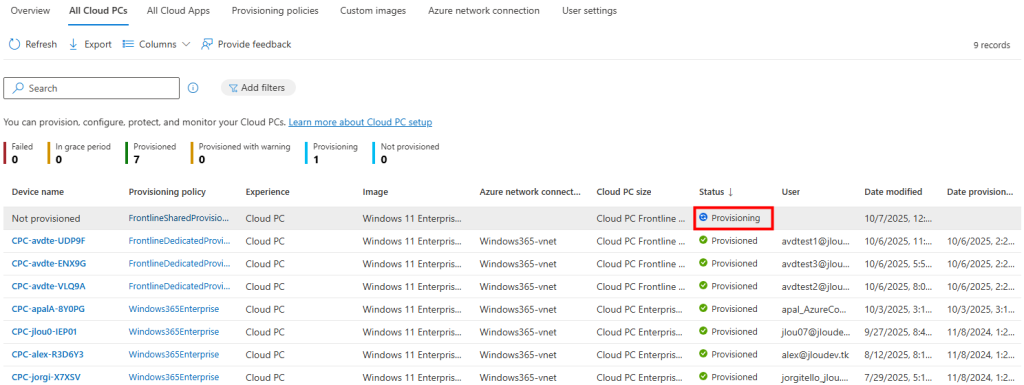

De retour dans la liste des Cloud PCs, je remarque l’apparition du nouveau Cloud PC avec le statut Provisioning :

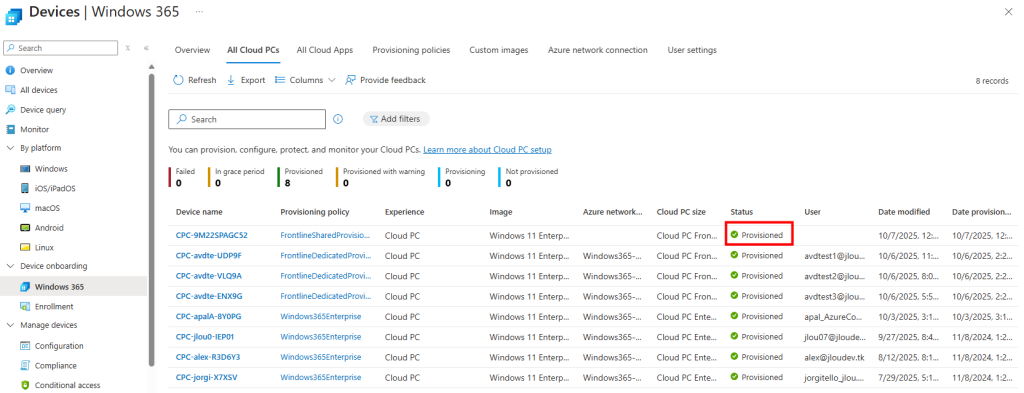

Environ un quart d’heure plus tard, le Cloud PC apparaît en statut Provisionné :

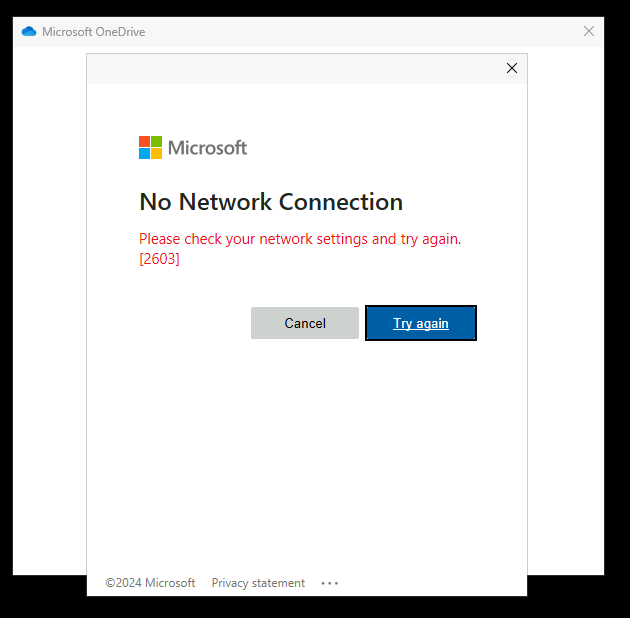

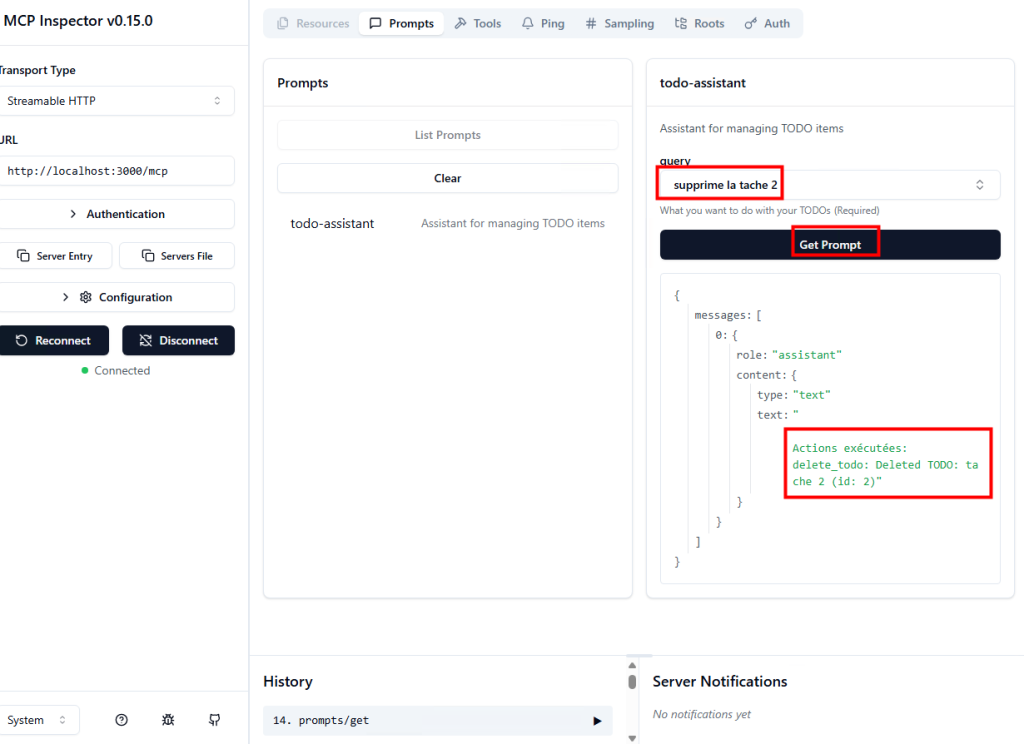

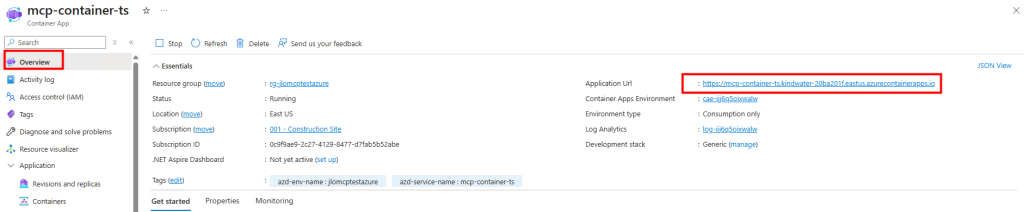

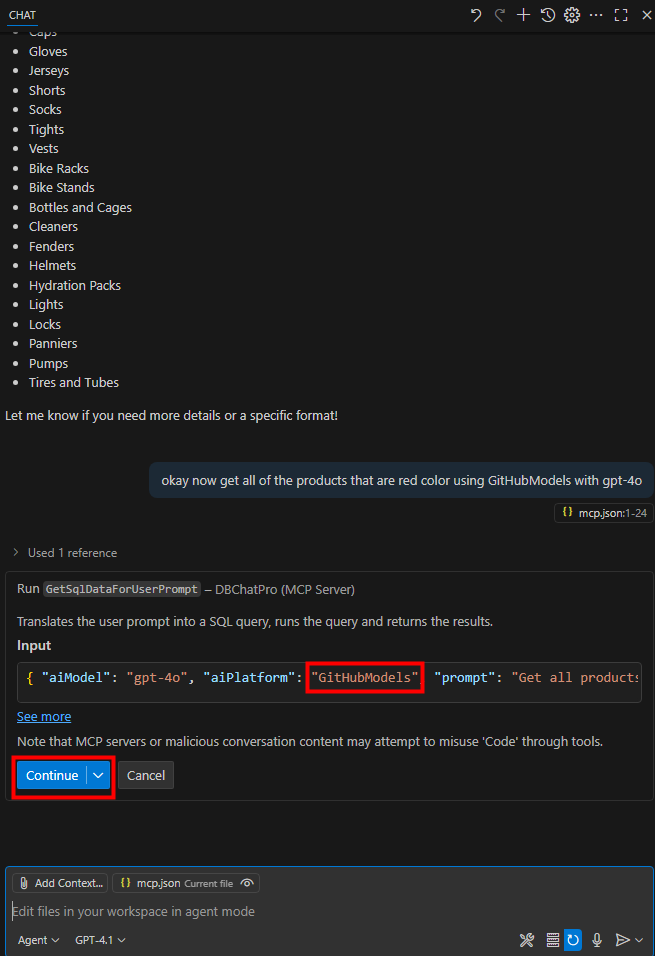

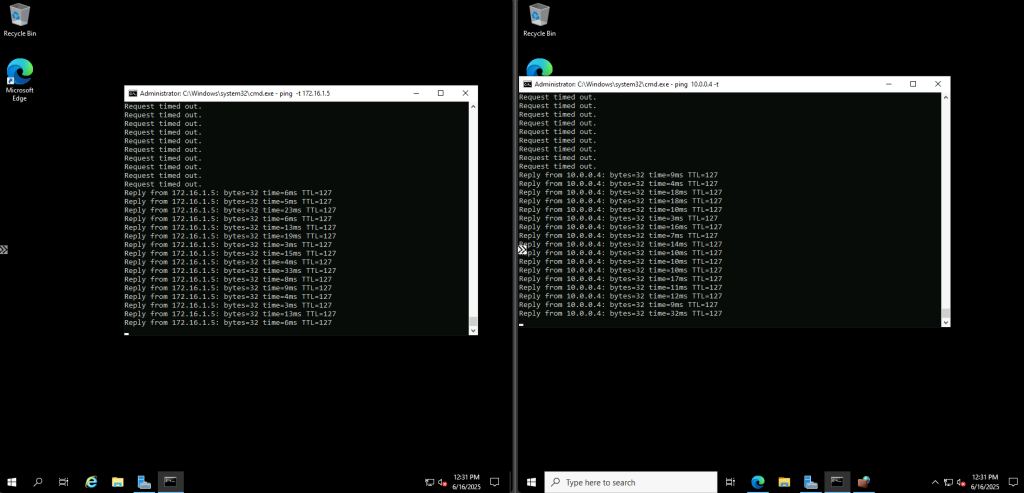

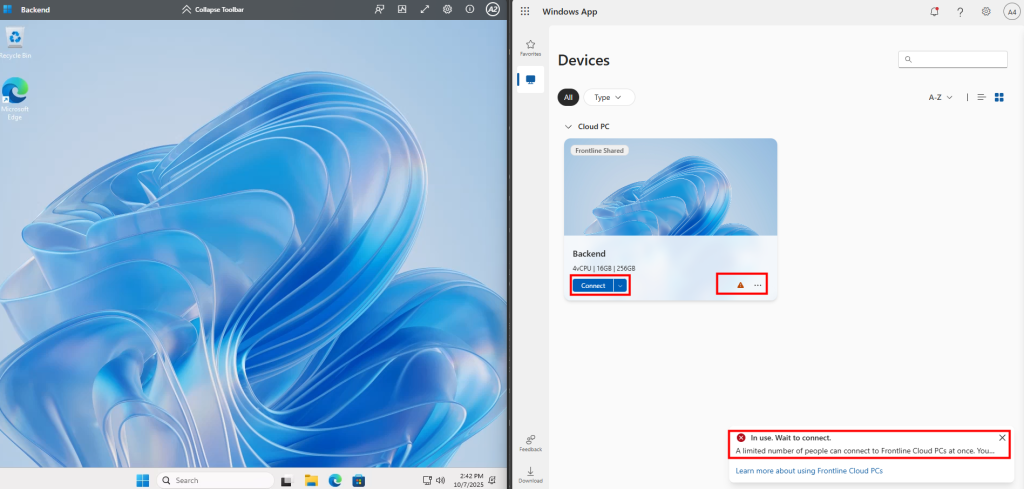

Je me connecte avec deux utilisateurs, en simultané, sur le portail Windows 365 Web :

Le premier utilisateur se connecte avec succès à sa session, tandis que le second obtient un message l’informant qu’il ne peut pas accéder au Cloud PC :

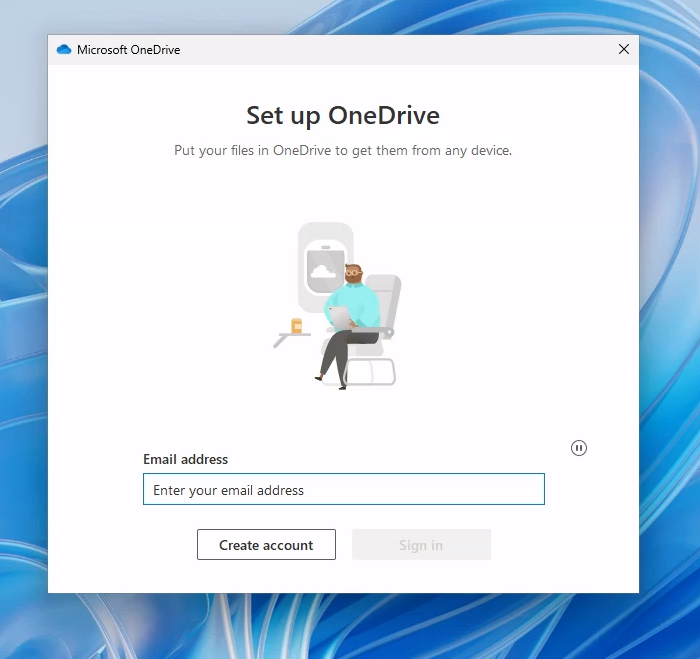

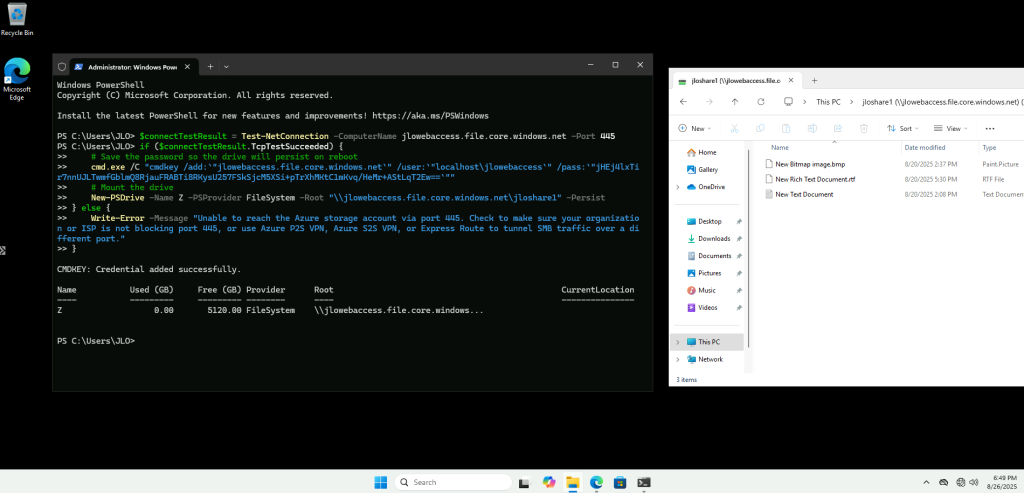

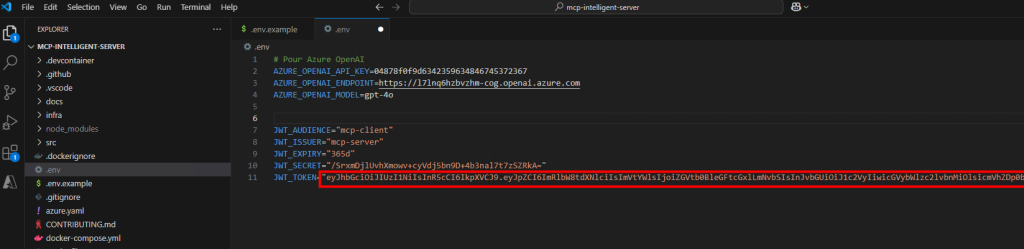

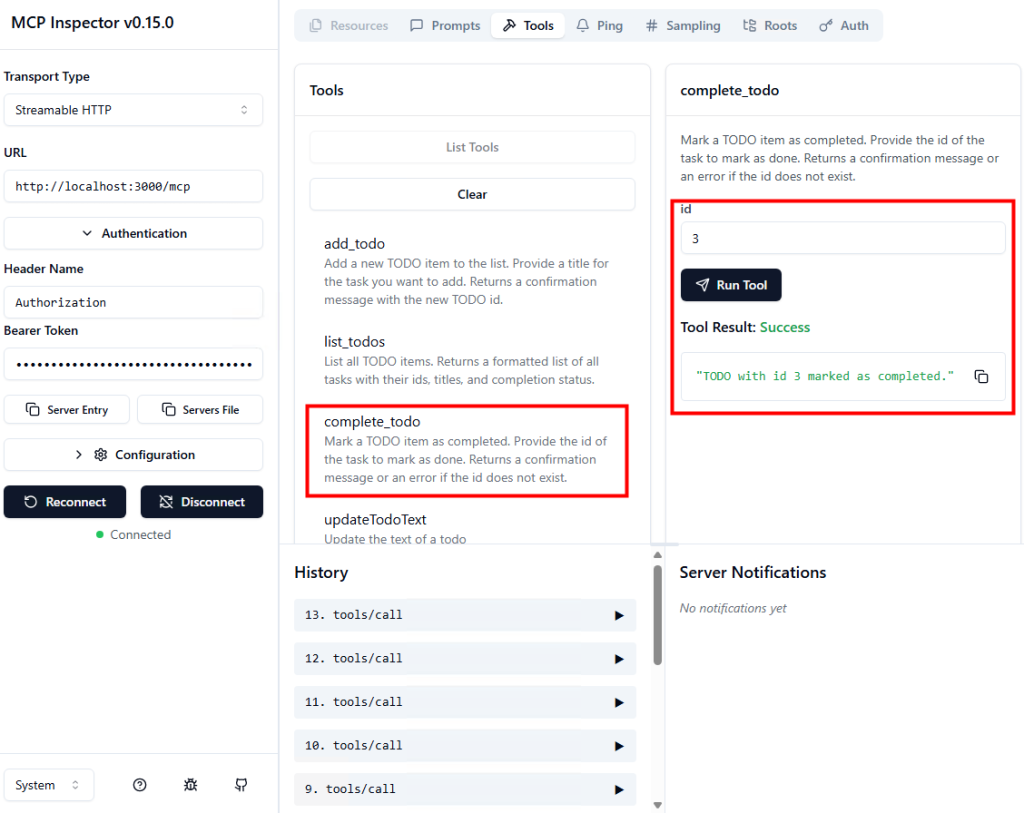

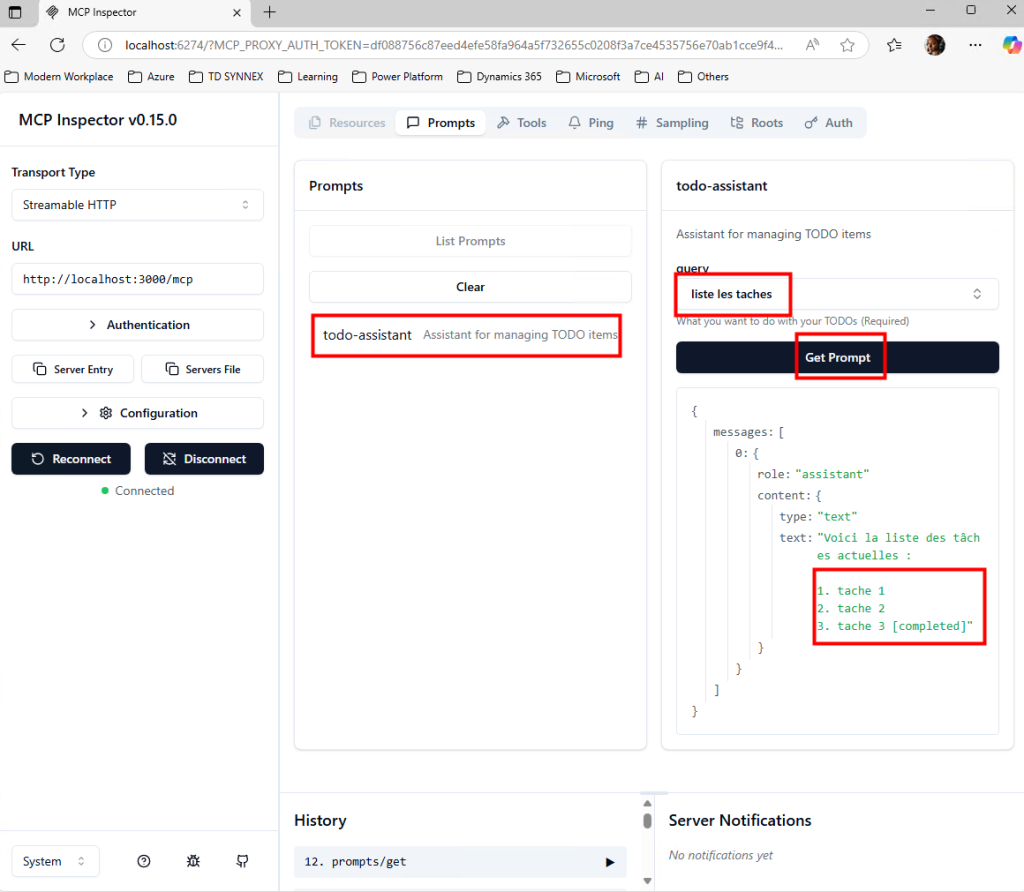

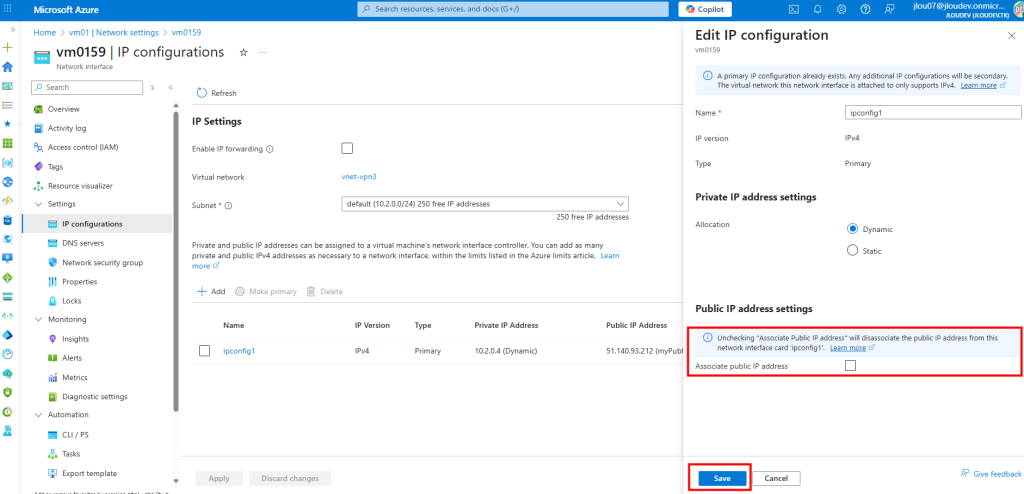

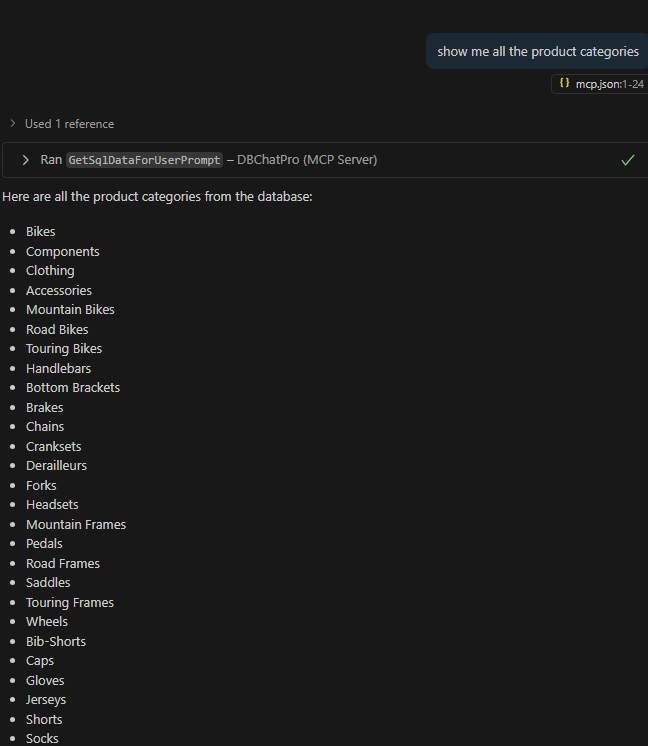

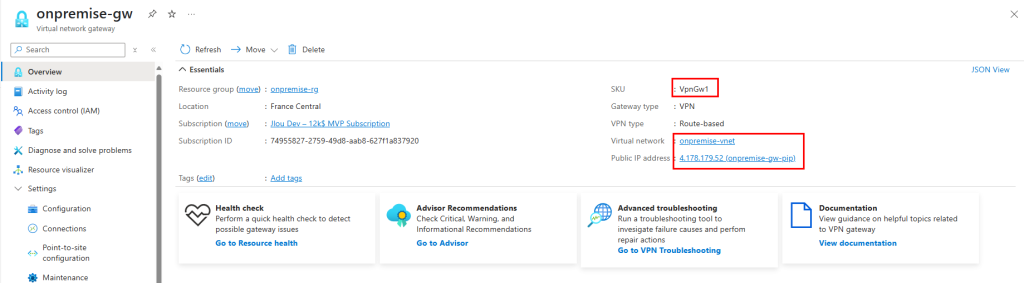

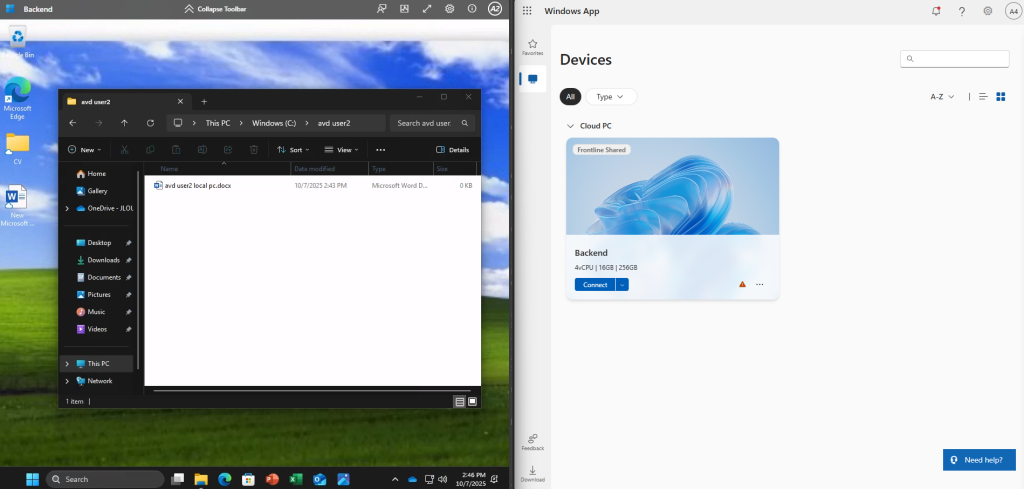

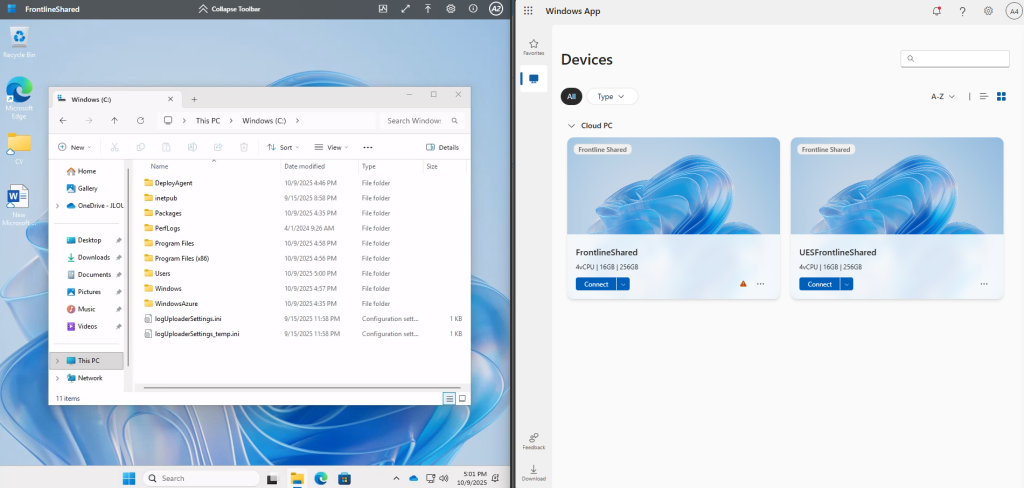

Sur mon premier utilisateur, je personnalise le bureau et le fond d’écran, je crée un dossier sur le disque C avec un fichier, j’ajoute des éléments sur le bureau et je modifie la barre du menu Démarrer :

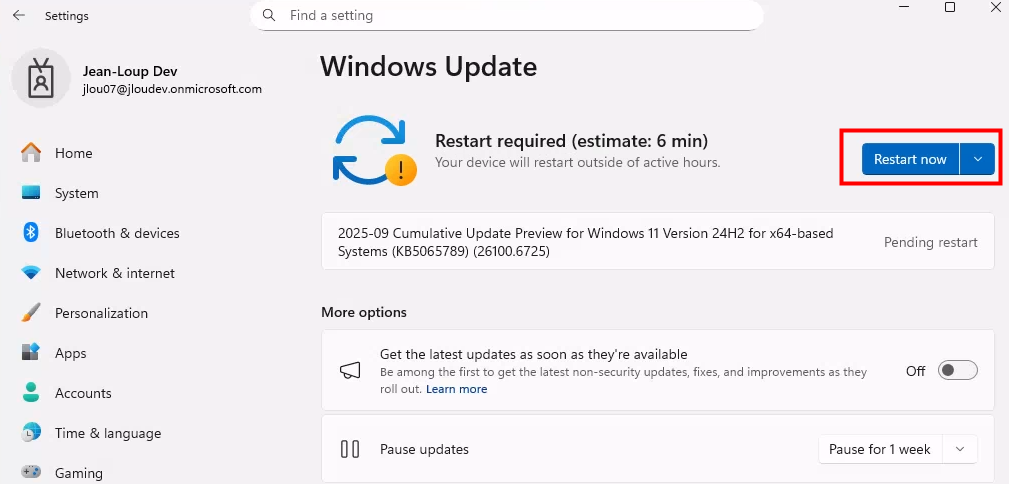

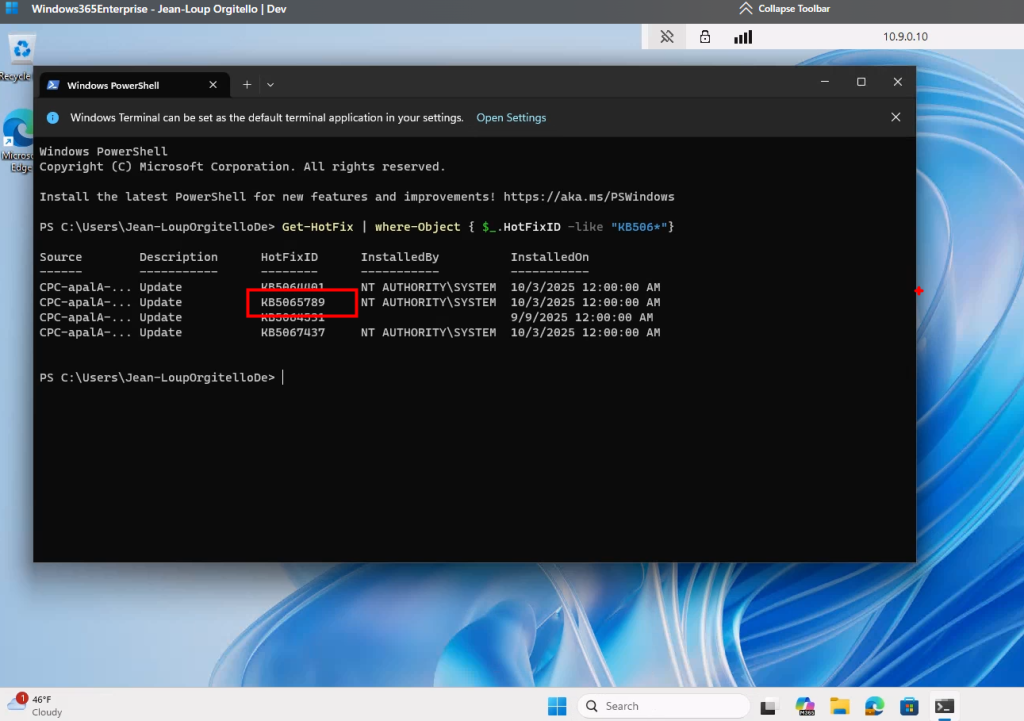

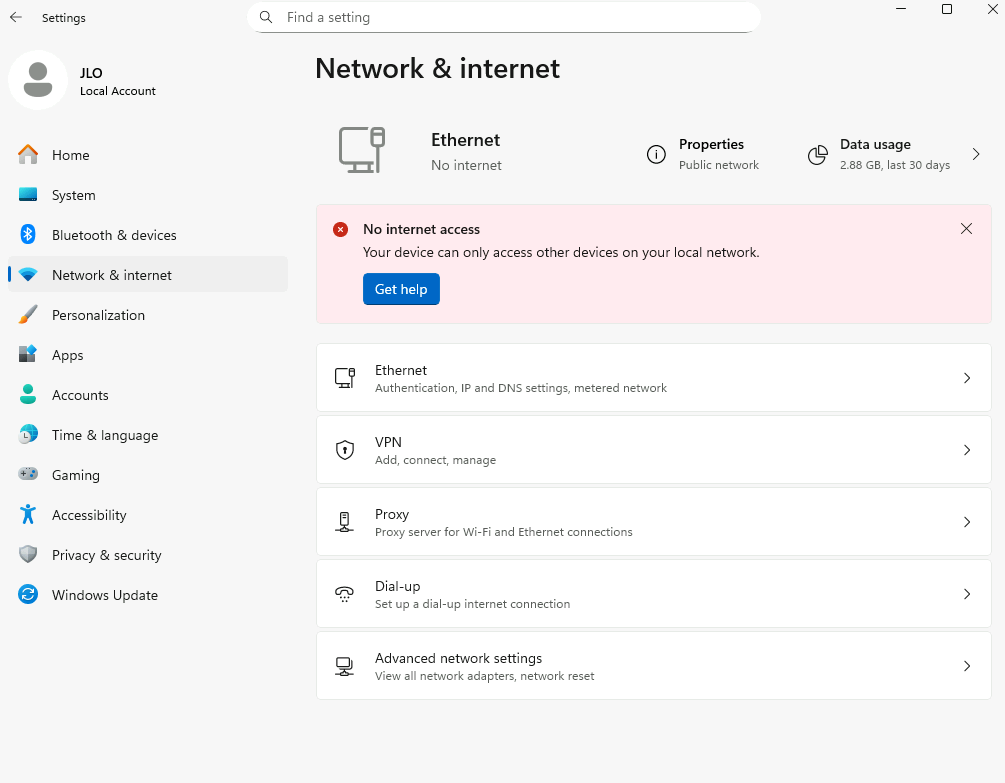

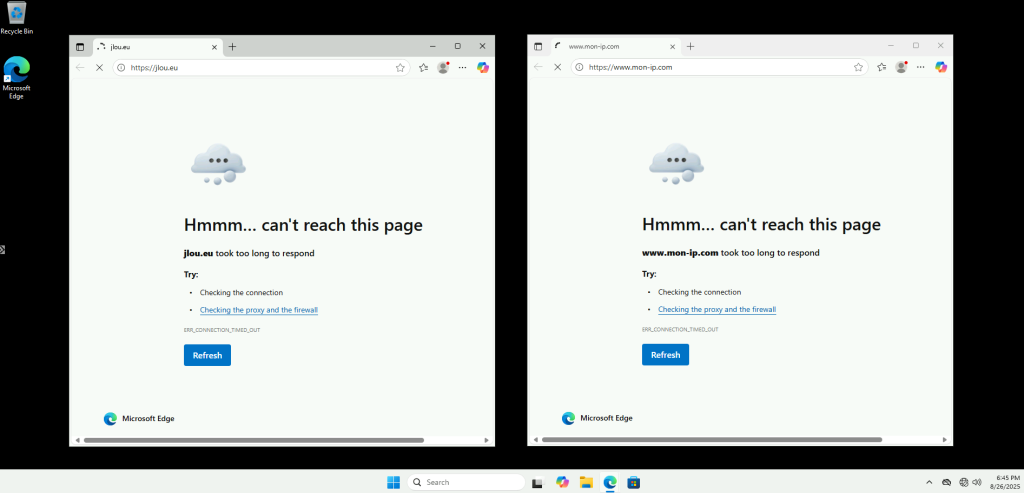

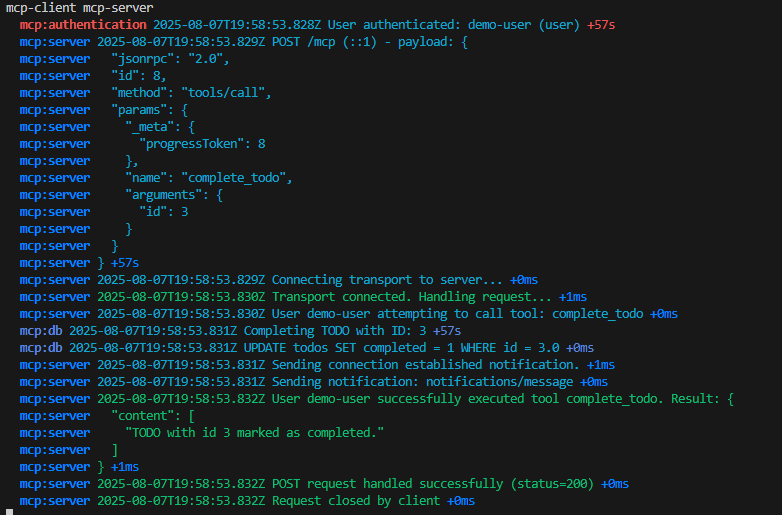

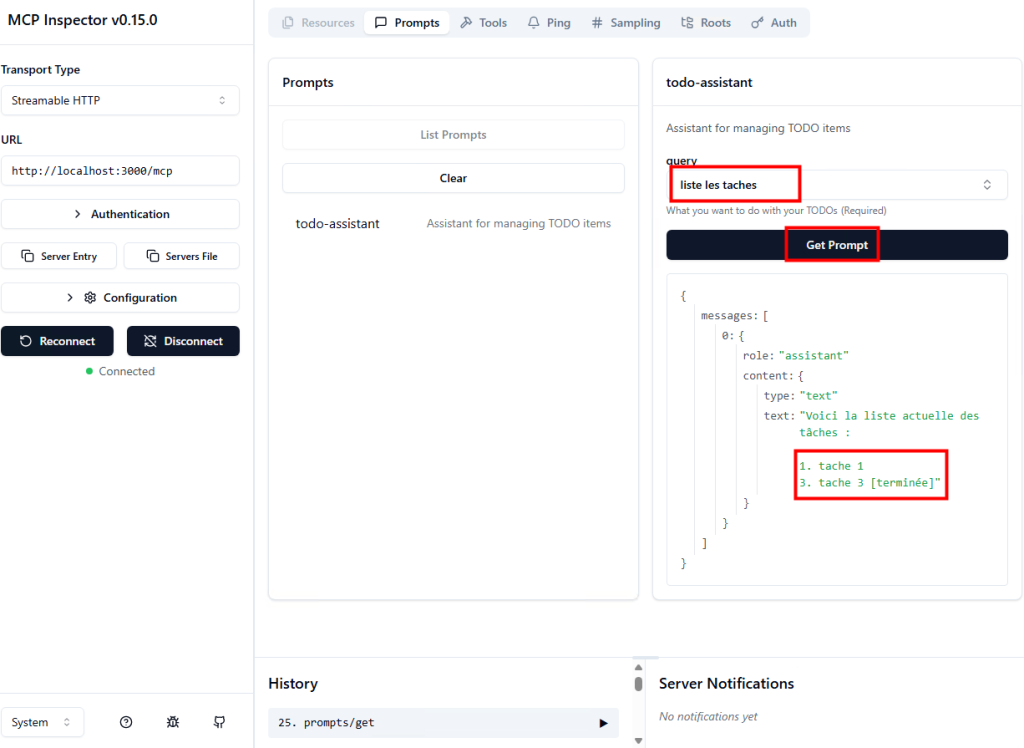

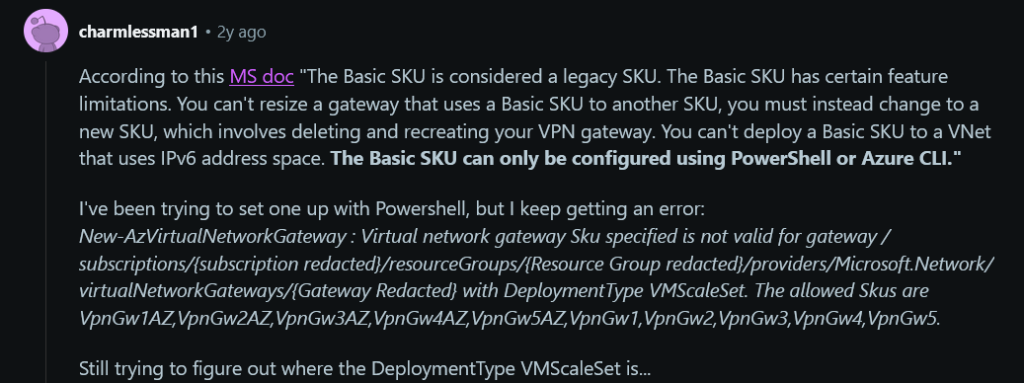

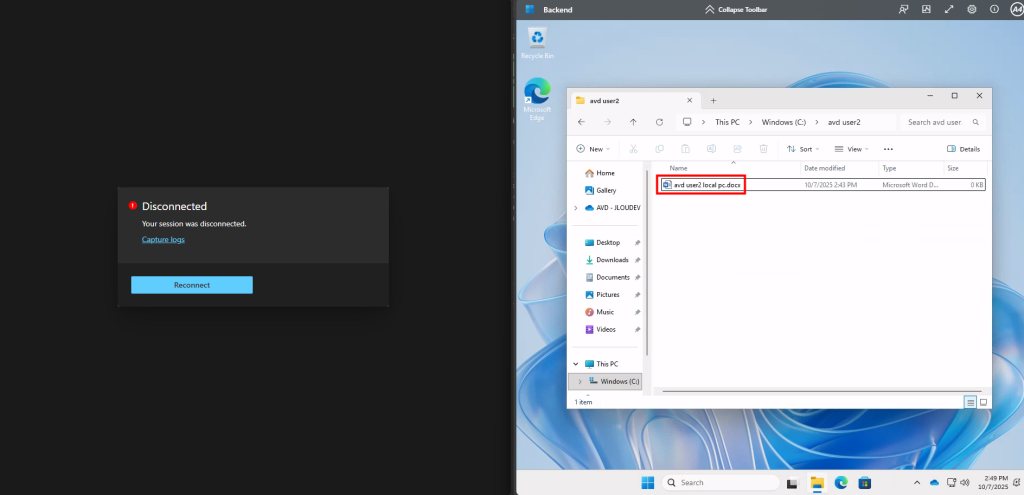

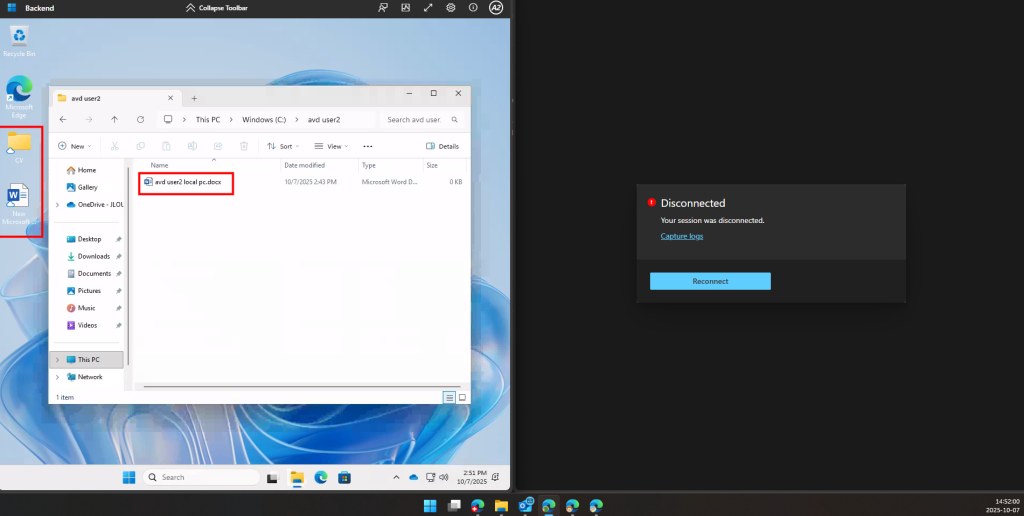

Je déconnecte le premier utilisateur et me connecte avec le second ; je constate alors la présence des fichiers locaux sur le disque C :

J’attends environ une heure, puis je me reconnecte avec le premier utilisateur ; je constate la restauration des éléments issus de OneDrive ainsi que des fichiers locaux, mais l’absence du fond d’écran et des raccourcis de la barre des tâches, non pris en charge par OneDrive :

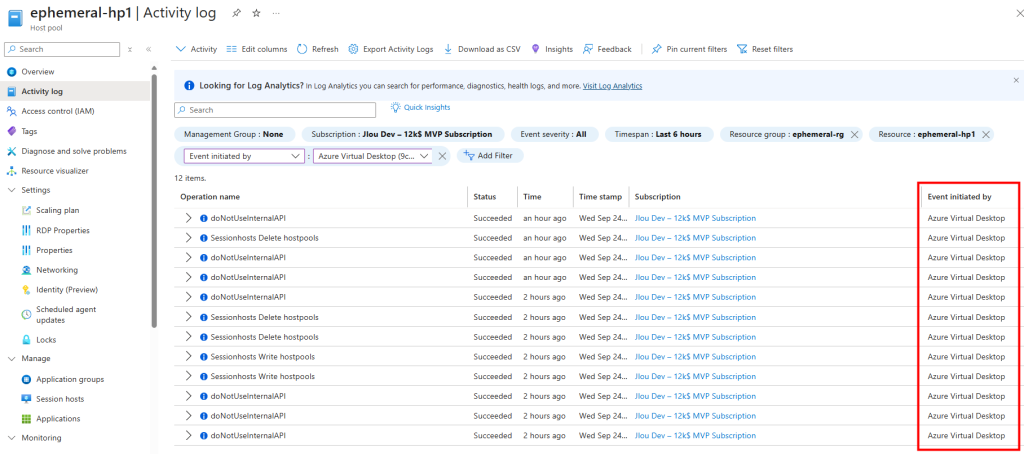

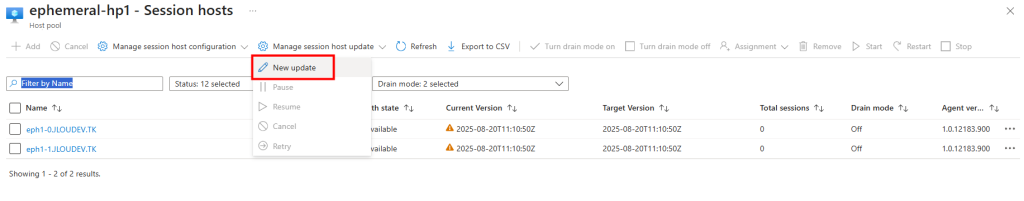

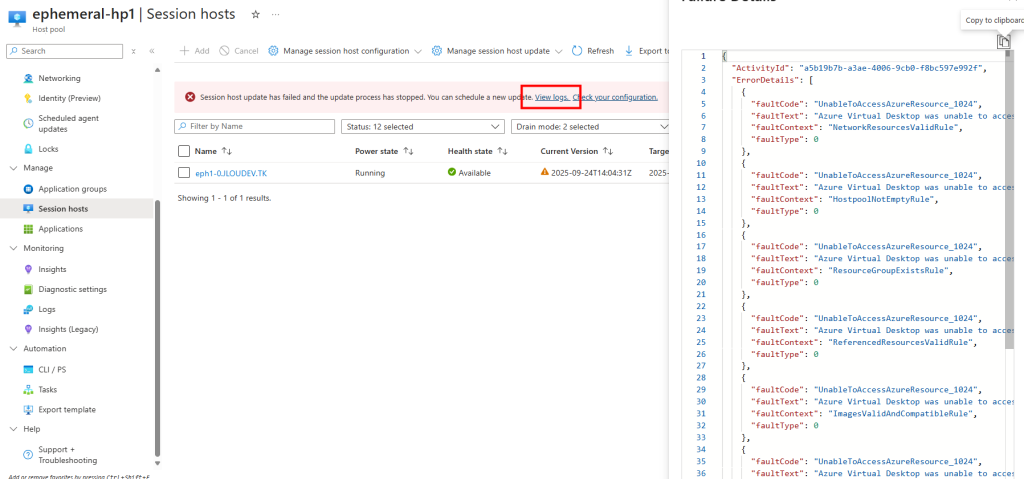

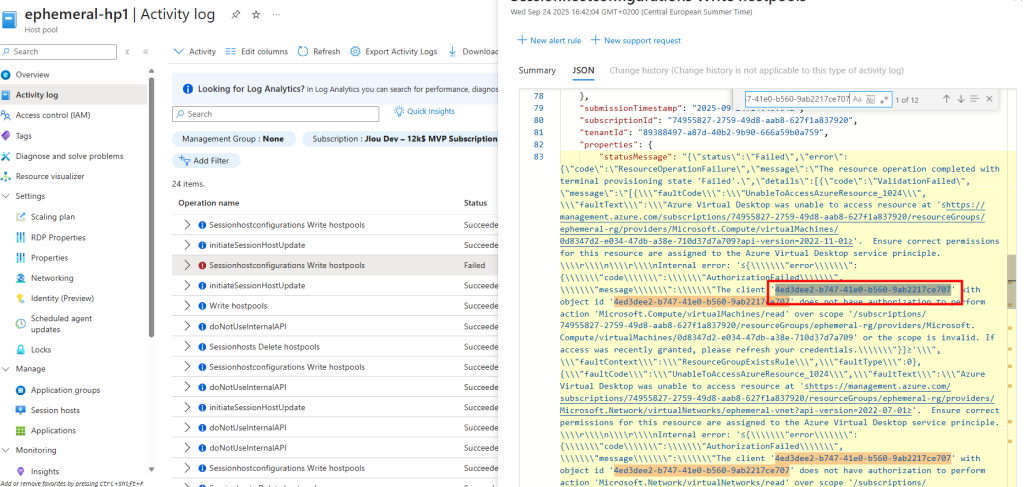

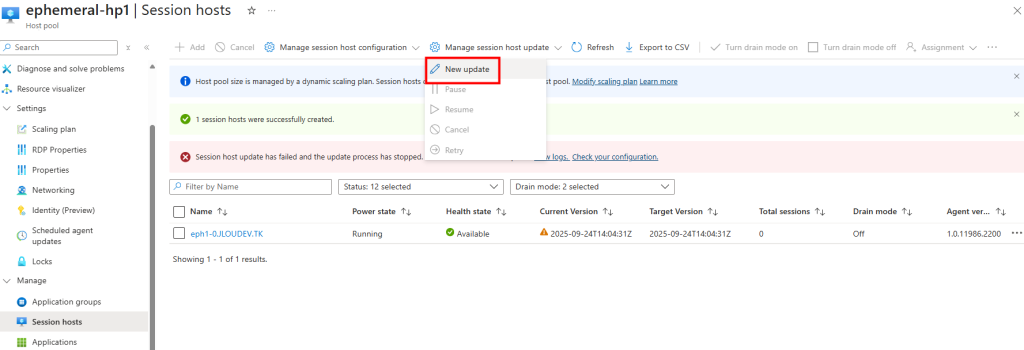

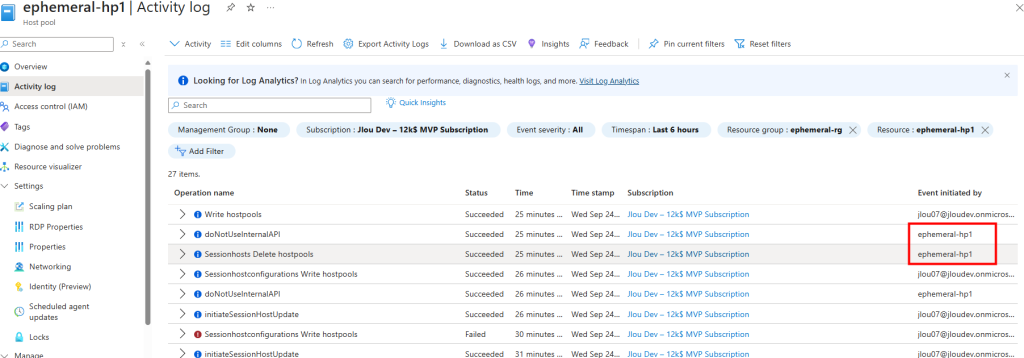

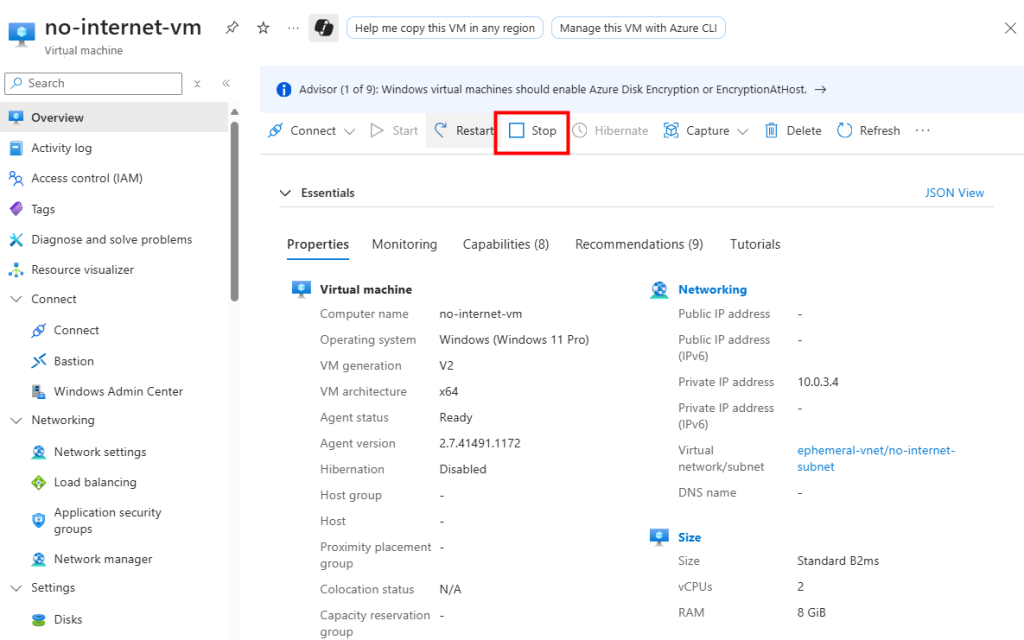

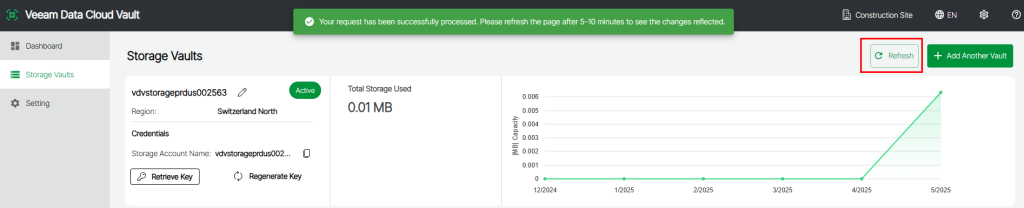

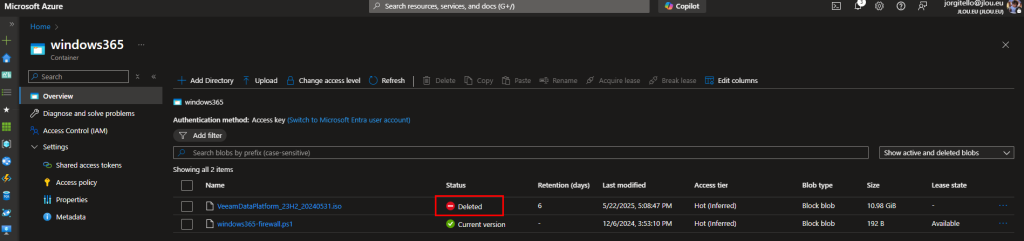

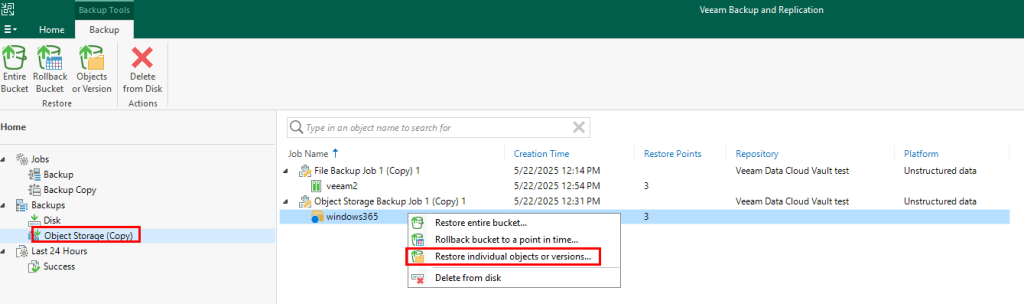

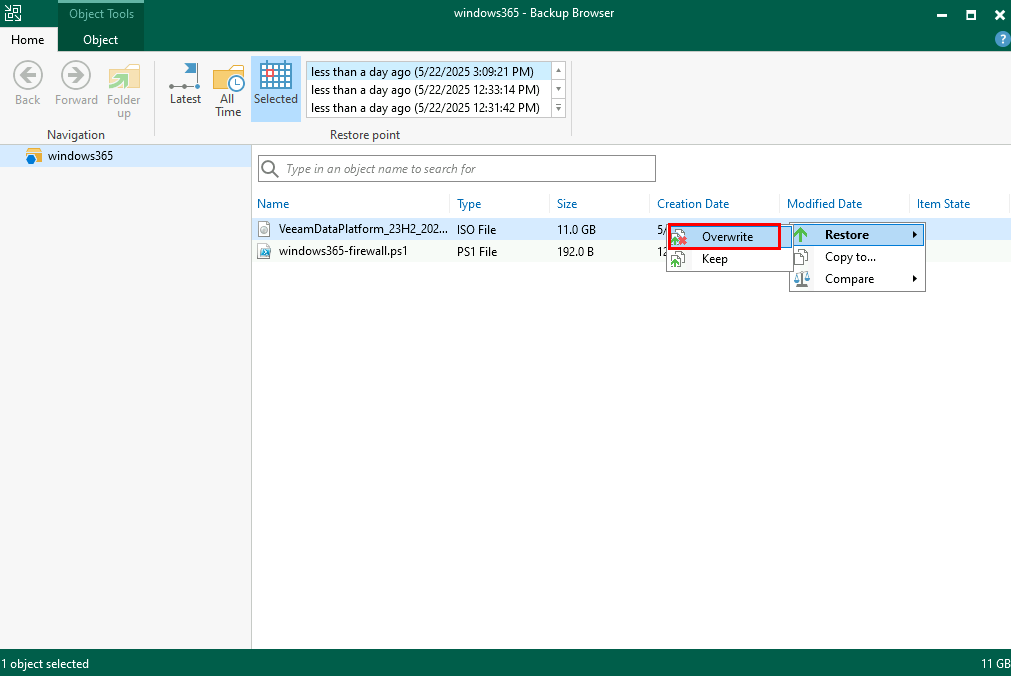

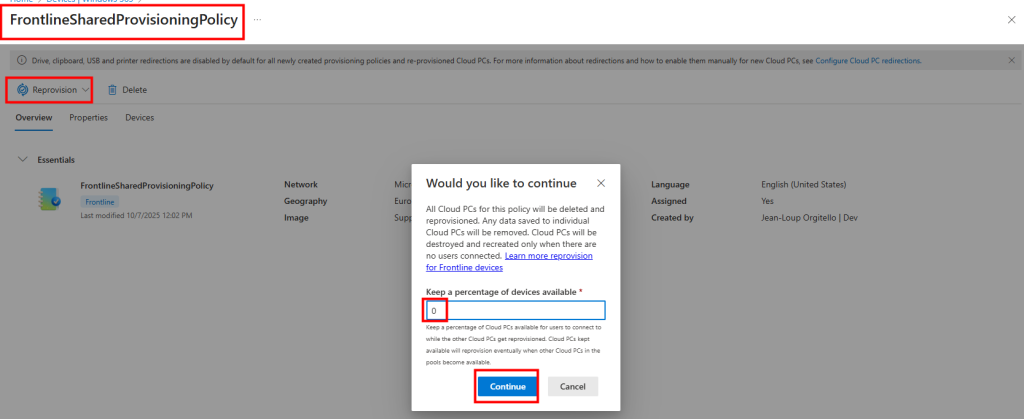

Je lance un reprovisionnement immédiat de ma machine partagée :

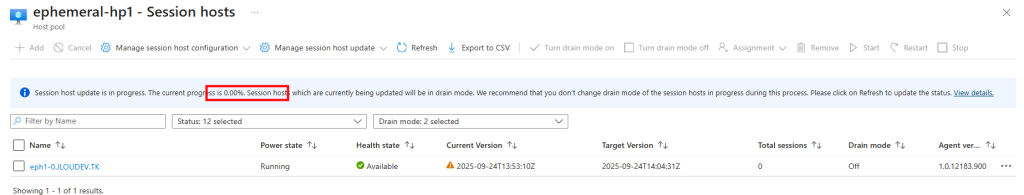

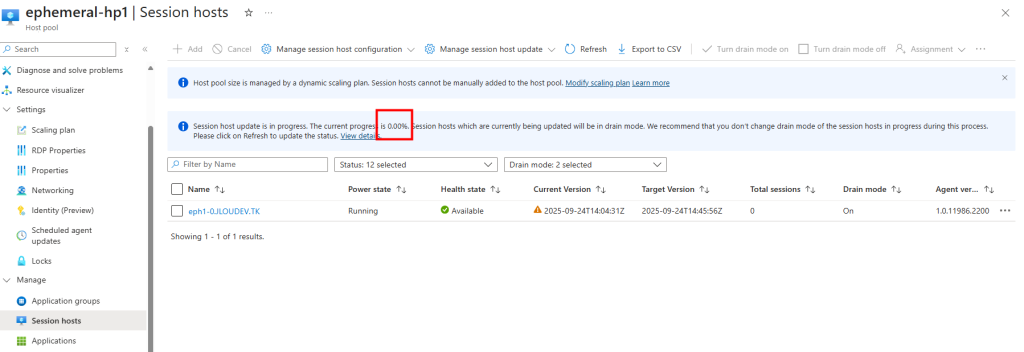

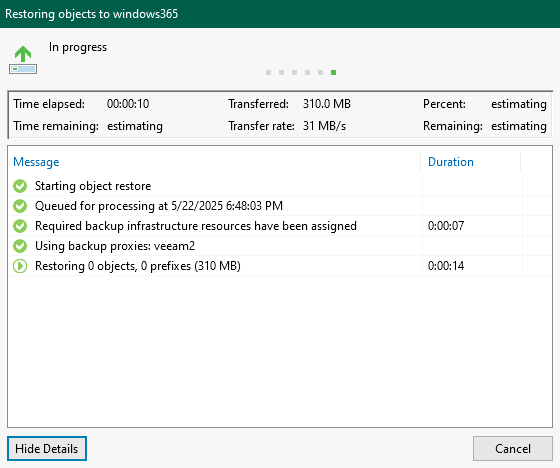

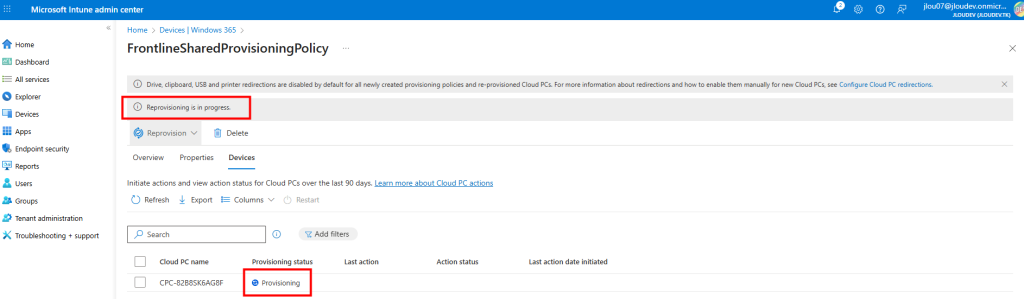

Je constate le démarrage du nouveau processus :

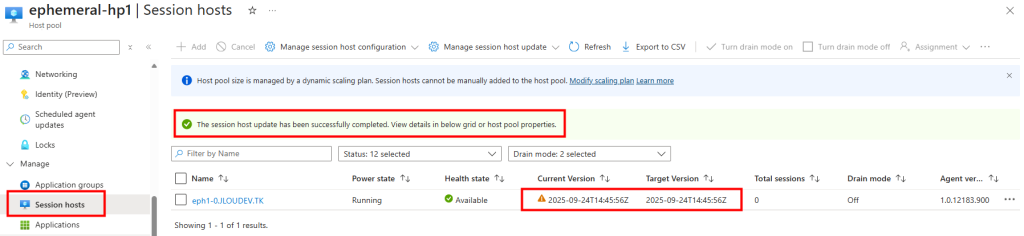

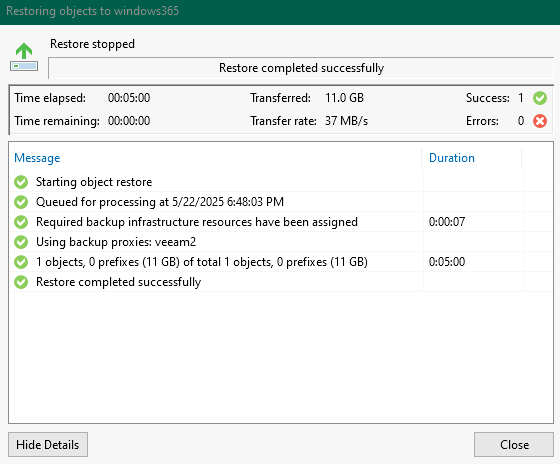

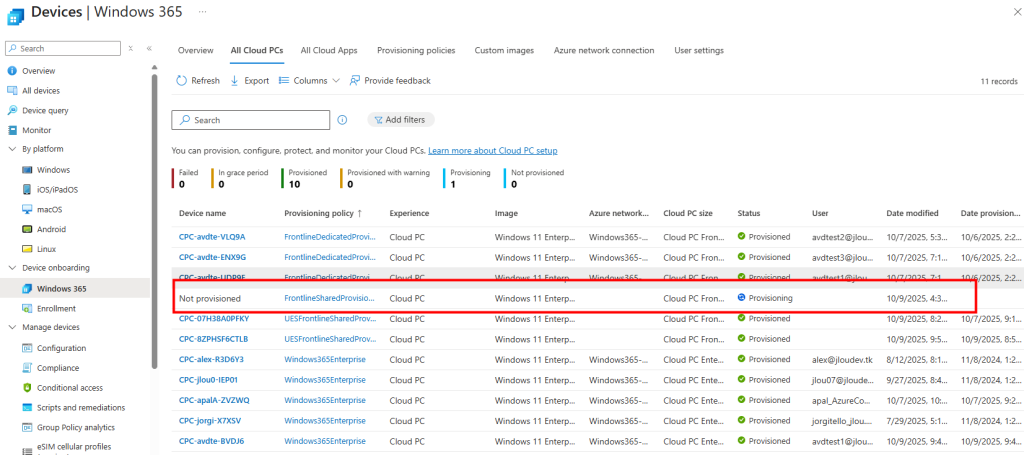

Le provisionnement progresse et la nouvelle machine partagée apparaît dans l’environnement :

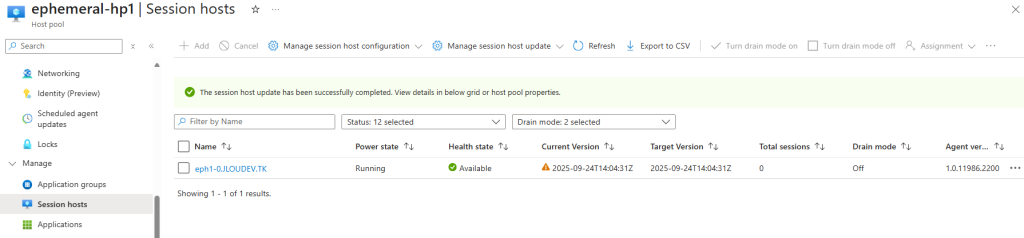

Quelques minutes plus tard, la nouvelle machine partagée est provisionnée :

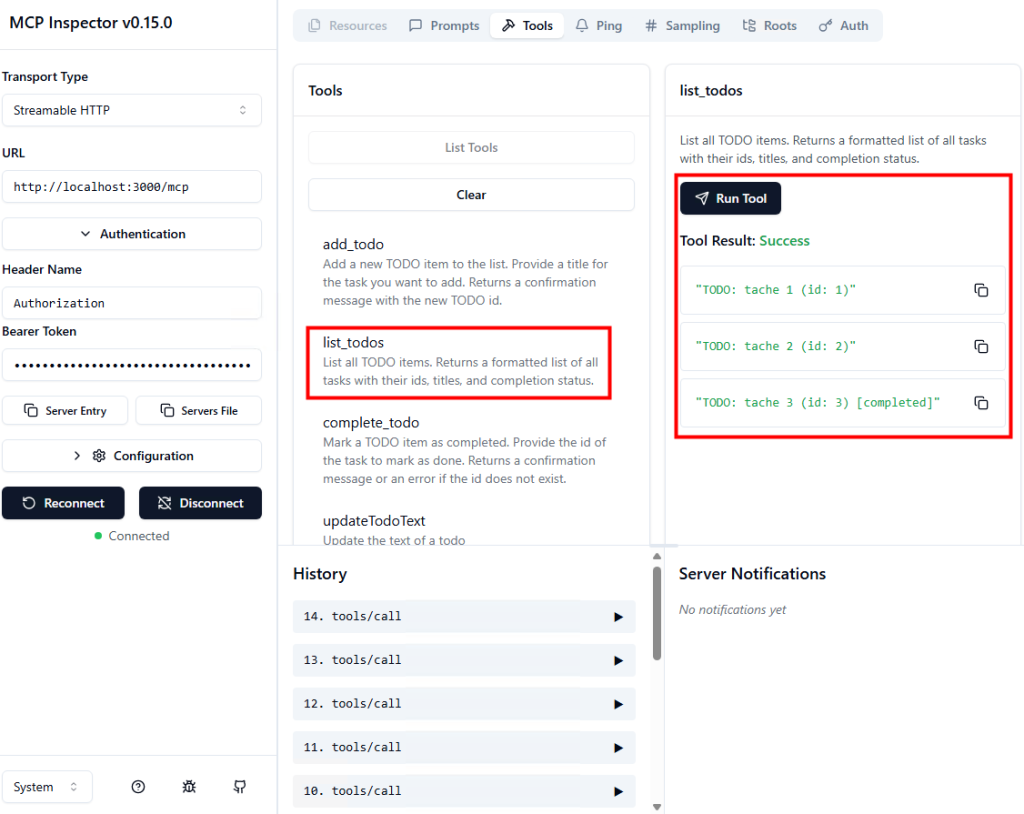

Je me reconnecte avec mes deux utilisateurs, en commençant par le premier, et je constate la disparition des fichiers précédemment présents sur le disque C mais la conservation des données sauvegardées sur OneDrive :

Conclusion

Windows 365 Frontline apporte une vraie flexibilité dans la gestion des postes Cloud, surtout pour les environnements en rotation ou à effectif variable.

Le mode Dedicated reste parfait pour les équipes qui se relaient sur un même poste tout en conservant leur propre environnement, tandis que le mode Shared s’adresse davantage aux scénarios temporaires ou sans persistance.

Ce qu’il faut retenir, c’est que Frontline ne vise pas à remplacer les éditions Business ou Enterprise, mais bien à optimiser les coûts et les licences quand tout le monde n’a pas besoin d’un Cloud PC permanent.

Et comme souvent avec Microsoft 365 et Intune, le meilleur moyen de comprendre… c’est de tester soi-même ! 😉